ChatGPT的训练数据是通过大规模的互联网文本数据集来进行训练的。具体来说,OpenAI使用了一种称为无监督学习的方法,这意味着他们并没有对模型进行针对性的手动标注,而是从互联网上采集了大量的文本数据,以自动学习语言模型的模式和结构。

训练数据的来源包括但不限于以下几个方面:

-

网络文本:OpenAI从互联网上爬取了大量的网页内容,涵盖了各种主题和领域的文本数据。这些数据包括维基百科、新闻文章、博客、论坛、社交媒体帖子等等。通过这种方式,ChatGPT可以获取广泛的知识和信息,以应对各种话题和问题。

-

书籍和文学作品:OpenAI还使用了大量的书籍和文学作品作为训练数据。这些包括小说、非小说类图书、科学论文、历史著作等。通过使用书籍和文学作品,ChatGPT可以学习到更加丰富和复杂的语言表达方式,以及不同领域的知识。

-

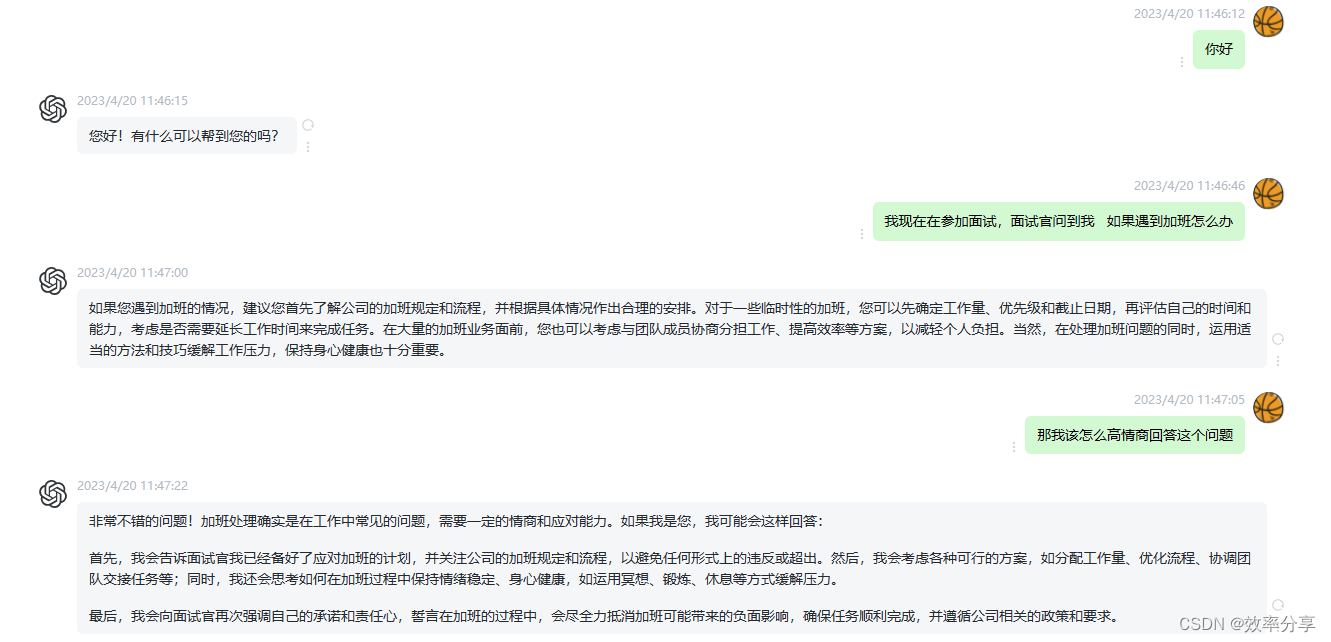

对话和聊天记录:OpenAI还使用了一些对话和聊天记录作为训练数据,以模拟真实对话的场景。这些对话可能来自于在线聊天平台、论坛、社交媒体等。通过使用对话数据,ChatGPT可以学习到自然语言的交互模式和对话的上下文理解能力。

-

网络文本:OpenAI从互联网上爬取了大量的网页内容,涵盖了各种主题和领域的文本数据。这些数据包括维基百科、新闻文章、博客、论坛、社交媒体帖子等等。通过这种方式,ChatGPT可以获取广泛的知识和信息,以应对各种话题和问题。

-

书籍和文学作品:OpenAI还使用了大量的书籍和文学作品作为训练数据。这些包括小说、非小说类图书、科学论文、历史著作等。通过使用书籍和文学作品,ChatGPT可以学习到更加丰富和复杂的语言表达方式,以及不同领域的知识。

-

对话和聊天记录:OpenAI还使用了一些对话和聊天记录作为训练数据,以模拟真实对话的场景。这些对话可能来自于在线聊天平台、论坛、社交媒体等。通过使用对话数据,ChatGPT可以学习到自然语言的交互模式和对话的上下文理解能力。

-

公共领域知识库:OpenAI可能还利用了一些公共领域的知识库作为训练数据,例如Freebase、ConceptNet等。这些知识库包含了大量结构化的知识,如实体关系、事实和属性。通过结合这些知识库,ChatGPT可以获得更多的事实和背景知识,提供更准确和全面的回答。

值得注意的是,具体的训练数据集的规模和内容是不公开的,OpenAI并没有透露具体的数据集细节。此外,为了保护个人隐私和敏感信息,OpenAI在训练过程中也会采取一些去识别化和匿名化的措施,以避免模型在回复中泄露敏感信息。

为了提高模型的性能和质量,OpenAI还对训练数据进行了一些预处理和过滤。他们可能会移除一些低质量的或不可靠的数据源,以减少模型学习到的错误或有害信息的数量。此外,OpenAI还可能对数据进行清洗和归一化处理,以确保数据的一致性和可用性。