1、vit

GitHub - google-research/vision_transformer

是监督学习

CV攻城狮入门VIT(vision transformer)之旅——VIT代码实战篇_秃头小苏的博客-CSDN博客

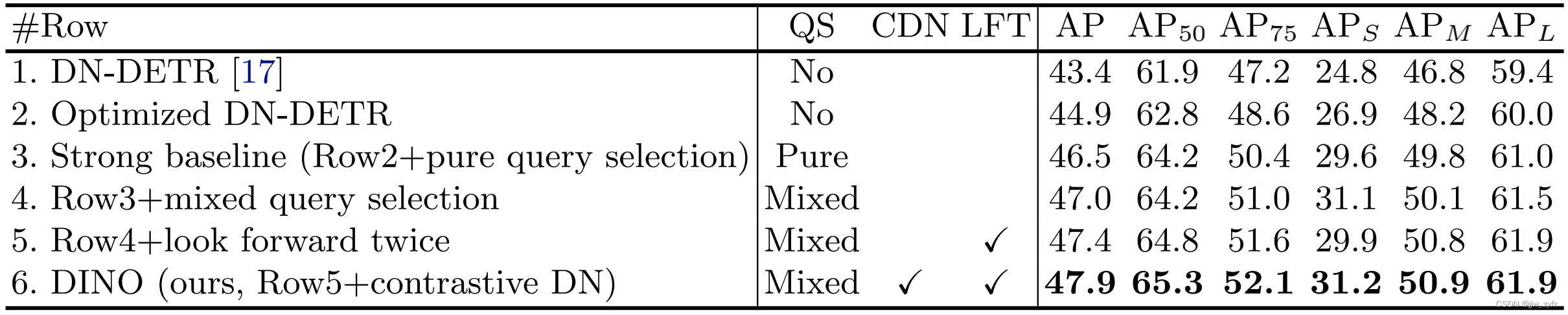

2、DINO

GitHub - facebookresearch/dino: PyTorch code for Vision Transformers training with the Self-Supervised learning method DINO

自监督学习流程

https://zhuanlan.zhihu.com/p/448182903

论文导读:DINO -自监督视觉Transformers|文章|原理|dino_网易订阅

1、CV中的无监督学习方法:MoCo - 知乎

1、Self-Attention 自注意力机制 - 知乎 (zhihu.com)

(192条消息) 计算机视觉中的Transformer_小白学视觉的博客-CSDN博客

(193条消息) transformer通俗理解_追光少年羽的博客-CSDN博客_transformer模型通俗理解

(193条消息) Vision Transformer入门解析_luemeon的博客-CSDN博客

假设,初始输入图像尺寸shape=(b, 3, 256, 256),将其打成patch尺寸shape=(b, 3, 256/32, 256/32),共256x256/32x32=64个patches,每个patch均有32×32×3=3072个像素。输入到线性投影层 (相当于通道数由 3 降维为 1) 得到个数为64、大小(像素数)为(32×32×1)=1024的图像块嵌入,每个图像块嵌入按元素加入位置向量后,尺寸仍为 N×D=64×1024,再concat成一个用于预测分类结果的 1×1024 可学习嵌入向量构成大小为 65×1024 嵌入整体 (长度为64+1=65),输入编码器经过一系列前向处理后,得到尺寸仍为65×1024的输出。

2.bert自监督学习

自监督学习:1、BERT模型 - 知乎