在进行python爬虫时,我们经常会面对一些采用Ajax异步加载数据的网页,这种情况下,我们无法通过直接获取网页源代码来获取需要的数据。本文将介绍如何使用python爬虫抓取Ajax网页。

一、Ajax简介

Ajax全称为Asynchronous JavaScript and XML,即异步JavaScript和XML。它是一种通过JavaScript和XML技术在不刷新整个页面的情况下实现数据交互的Web开发技术。通过Ajax技术,我们可以实现异步加载网页内容,减小了服务器和客户端的负担,提高了用户的交互体验。

二、Ajax网页的抓取原理

对于Ajax网页的抓取,我们需要先了解其基本的抓取原理。一般来说,Ajax的数据请求返回的结果是JSON或XML格式的数据,而不是HTML网页源代码。因此,我们不能像普通网页一样直接获取整个网页源代码。实际上,我们需要模拟Ajax请求,然后从响应数据中提取出我们需要的数据。

以爬取“中国天气网”为例,该网站的天气信息是通过Ajax异步加载获取的。我们可以通过浏览器调试工具打开network选项卡,找到我们需要的天气信息的请求地址,从响应结果中,我们可以找到包含了我们所需的天气信息的JSON数据。

三、代码实现

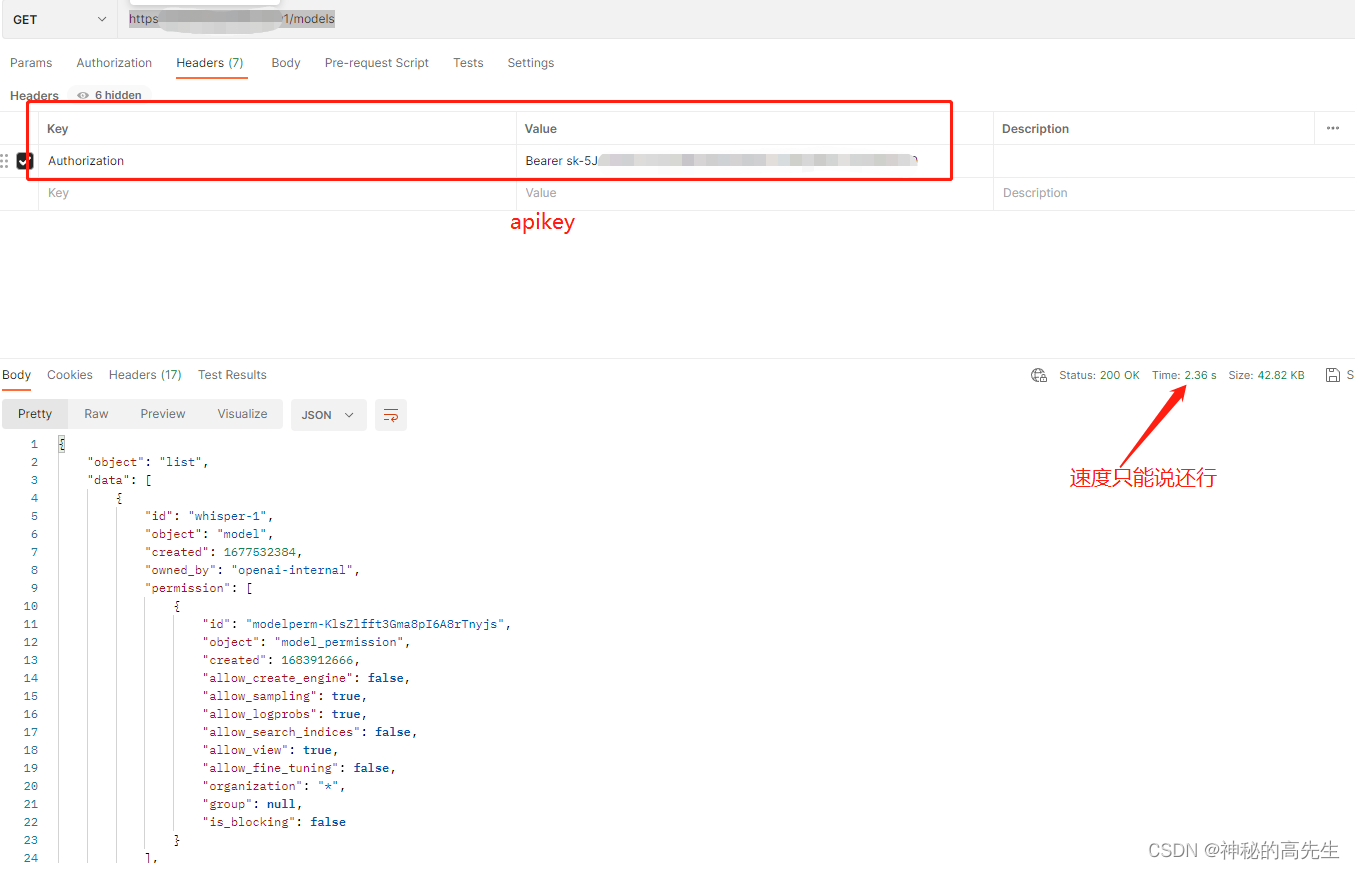

1.分析Ajax请求

在进行Ajax网页的抓取时,我们需要先分析响应JSON数据的请求。我们可以通过浏览器调试工具的network选项卡找到这个请求。在我们需要的数据请求下方,选择Headers选项卡,找到Request URL,这就是我们需要的请求地址。

2.读取响应数据

接下来,我们通过python的requests库模拟Ajax请求,并读取响应数据。代码如下:

import requests

import jsonurl = 'http://www.weather.com.cn/data/sk/101010100.html' # 请求地址

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/80.0.3987.149 Safari/537.36', # 请求头部'Accept-Language': 'zh-CN,zh;q=0.9', # 语言'X-Requested-With': 'XMLHttpRequest' # 表示Ajax请求

}

response = requests.get(url, headers=headers) # 模拟Ajax请求

text = response.content.decode('utf-8') # 读取响应数据

data = json.loads(text) # 解析json数据

print(data)

结果输出:

{‘weatherinfo’: {‘city’: ‘北京’, ‘cityid’: ‘101010100’, ‘temp’: ‘10.6’, ‘WD’: ‘东北风’, ‘WS’: ‘2级’, ‘SD’: ‘26%’, ‘AP’: ‘1004hPa’, ‘njd’: ‘暂无实况’, ‘WSE’: ‘<2’, ‘time’: ‘10:49’, ‘sm’: ‘良’, ‘isRadar’: ‘1’, ‘Radar’: ‘JC_RADAR_AZ9010_JB’}}

3.提取关键信息

根据我们的需求,我们可以从响应数据中提取出需要的信息,再进行处理。例如,获取天气温度数据:

temp = data['weatherinfo']['temp']

print(temp)

结果输出:

10.6

四、防止反爬机制

在进行Ajax网页的抓取时,我们也需要注意防范反爬机制。一般来说,网站会设置请求速度的限制,我们可以通过设置请求头部信息中的Referer和User-Agent来模拟浏览器的请求,很大程度上能够防止反爬机制的检测。

另外,我们还需要注意请求的频率和次数,不要频繁地发送请求,也不要过于频繁地发送相同的请求。可以通过设置时间间隔和随机请求头部信息来降低被反爬的概率。

对于一些需要登录或者验证的Ajax网页,我们还需要模拟登录并保持会话状态,以便获取所需信息。可以使用requests库中的Session类来模拟登录和保持会话状态。

五、总结

本文介绍了通过模拟Ajax请求来抓取Ajax网页的方法。主要是分析Ajax请求地址,读取响应数据,提取关键信息,并注意防范反爬机制。通过这些方法,我们就能够获取到Ajax网页中所需的数据,进一步实现数据分析和应用。