2017年,谷歌团队在论文「Attention Is All You Need」提出了创新模型,其应用于NLP领域架构Transformer模型。从模型发布至今,transformer模型风靡微软、谷歌、Meta等大型科技公司。且目前有模型大一统的趋势,现在transformer 模型不仅风靡整个NLP领域,且随着VIT SWIN等变体模型,成功把transformer 模型应用到计算机视觉任务。而目前最火的ChatGPT,也是基于Transformer开发的。

Transformer 模型是一种用于自然语言处理的深度学习模型,它采用了注意力机制(attention is all you need)来处理输入序列,可以同时处理长序列信息,具有较好的并行性能,逐渐成为自然语言处理领域中的重要模型。虽然 Transformer 架构已成为自然语言处理任务的标准,但其在计算机视觉中的应用仍然有限。在视觉中,注意力要么与卷积网络结合使用,要么用于替换卷积网络的某些组件,同时保持其整体模型结构不变。

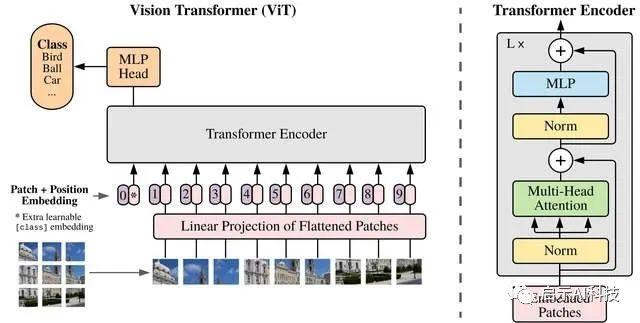

为了把Transformer模型应用到计算机视觉任务上,且保持Transformer模型的整体构建,Google团队发布了VIT模型。Vision Transformer (ViT) 模型在 ImageNet-21k(1400 万张图像,21843 个类别&#