转载请注明作者及出处:https://www.jianshu.com/p/b41f64389c21

[25]——Android 人脸识别了解一下 (上)

在上文中我大致的介绍了官方 Demo 中人脸注册的流程,本文我们接着来看看,在完成了人脸注册之后我们该如何识别出用户的人脸特征,从而通过人脸识别获取用户信息。

人脸识别的全部流程集成在官方 Demo 的 DetecterActivity 文件中。

还是来了解几个概念

- 人脸追踪 FT

- 年龄检测 Age

- 性别检测 Gender

其中人脸追踪 FT 与人脸检测 FD 功能基本一致(甚至代码基本都是相同的),Age 引擎用于识别年龄,Gender 引擎用于识别性别。

识别流程

整体上比人脸注册还要简单,官方提供了很好的封装供我们使用,我们来看看流程。

第一步:

创建两个叠加在一起的 SurfaceView,一个用于显示摄像头的预览信息,一个用于框出摄像头预览中人脸的位置;

//覆盖在相机预览之上的一层surfaceview

mGLSurfaceView = (CameraGLSurfaceView) findViewById(R.id.glsurfaceView);

mGLSurfaceView.setOnTouchListener(this);

//摄像头的surfaceview

mSurfaceView = (CameraSurfaceView) findViewById(R.id.surfaceView);

mSurfaceView.setOnCameraListener(this);

mSurfaceView.setupGLSurafceView(mGLSurfaceView, true, mCameraMirror, mCameraRotate);

mSurfaceView.debug_print_fps(true, false);这里面出现了两个监听器,分别是View.OnTouchListener 、CameraSurfaceView.OnCameraListener,第一个监听器用于设置触摸对焦,第二个监听器就是我们实现人脸识别的最基础一步:设置、获取摄像头的数据;

该接口共有6个方法:

public interface OnCameraListener {/*** setup camera. 设置相机参数* @return the camera*/public Camera setupCamera();/*** reset on surfaceChanged. 在Surfacechanged之后重置* @param format image format.* @param width width* @param height height.*/public void setupChanged(int format, int width, int height);/*** start preview immediately, after surfaceCreated 在surfaceCreated之后是否立即开始预览* @return true or false.*/public boolean startPreviewImmediately();/*** on ui thread. 在预览时刚方法会被调用,该方法的返回值是后两个方法的传入值* @param data image data* @param width width* @param height height* @param format format* @param timestamp time stamp* @return image params.*/public Object onPreview(byte[] data, int width, int height, int format, long timestamp);public void onBeforeRender(CameraFrameData data);public void onAfterRender(CameraFrameData data);

}初始化相机

@Override

public Camera setupCamera() {// TODO Auto-generated method stub//初始化相机��mCamera = Camera.open(mCameraID);try {Camera.Parameters parameters = mCamera.getParameters();parameters.setPreviewSize(mWidth, mHeight);parameters.setPreviewFormat(mFormat);for( Camera.Size size : parameters.getSupportedPreviewSizes()) {Log.d(TAG, "SIZE:" + size.width + "x" + size.height);}for( Integer format : parameters.getSupportedPreviewFormats()) {Log.d(TAG, "FORMAT:" + format);}List<int[]> fps = parameters.getSupportedPreviewFpsRange();for(int[] count : fps) {Log.d(TAG, "T:");for (int data : count) {Log.d(TAG, "V=" + data);}}//parameters.setPreviewFpsRange(15000, 30000);//parameters.setExposureCompensation(parameters.getMaxExposureCompensation());//parameters.setWhiteBalance(Camera.Parameters.WHITE_BALANCE_AUTO);//parameters.setAntibanding(Camera.Parameters.ANTIBANDING_AUTO);//parmeters.setFocusMode(Camera.Parameters.FOCUS_MODE_AUTO);//parameters.setSceneMode(Camera.Parameters.SCENE_MODE_AUTO);//parameters.setColorEffect(Camera.Parameters.EFFECT_NONE);mCamera.setParameters(parameters);} catch (Exception e) {e.printStackTrace();}if (mCamera != null) {mWidth = mCamera.getParameters().getPreviewSize().width;mHeight = mCamera.getParameters().getPreviewSize().height;}return mCamera;

}摄像头开始预览时:

@Override

public Object onPreview(byte[] data, int width, int height, int format, long timestamp) {//获取摄像头的帧数据,该数据为NV21格式 byte数组//调用FT人脸追踪引擎的人脸特征查明方法,结果保存到List<AFT_FSDKFace> resultAFT_FSDKError err = engine.AFT_FSDK_FaceFeatureDetect(data, width, height, AFT_FSDKEngine.CP_PAF_NV21, result);Log.d(TAG, "AFT_FSDK_FaceFeatureDetect =" + err.getCode());Log.d(TAG, "Face=" + result.size());for (AFT_FSDKFace face : result) {Log.d(TAG, "Face:" + face.toString());}if (mImageNV21 == null) {if (!result.isEmpty()) {//追踪到人脸数据,取出当前追踪的人脸,取出当前帧的NV21数据(用于人脸识别)mAFT_FSDKFace = result.get(0).clone();mImageNV21 = data.clone();} else {if (!isPostted) {//隐藏人脸信息的提示mHandler.removeCallbacks(hide);mHandler.postDelayed(hide, 2000);isPostted = true;}}}//copy rects 取出人脸追踪的RectRect[] rects = new Rect[result.size()];for (int i = 0; i < result.size(); i++) {rects[i] = new Rect(result.get(i).getRect());}//clear result.清空原来的人脸追踪结果Listresult.clear();//return the rects for render.return rects;

}渲染之后调用:

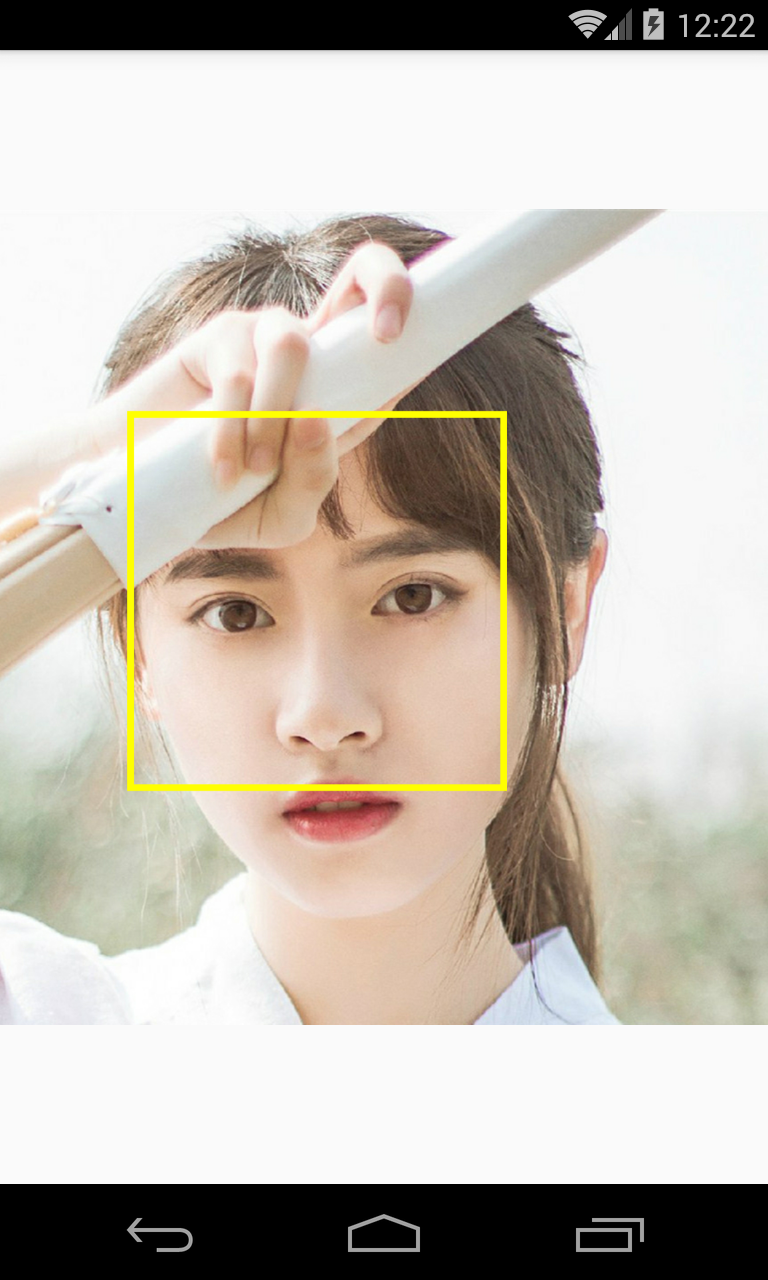

@Overridepublic void onAfterRender(CameraFrameData data) {//在该surfaceview上画方块,这里的data就是上一个方法中的返回值 return rects;mGLSurfaceView.getGLES2Render().draw_rect((Rect[])data.getParams(), Color.GREEN, 2);}第二步:

使用 FR 人脸识别引擎识别人脸信息,如果你已经浏览了上一步的代码,你会发现这一行关键代码:

if (!result.isEmpty()) {//追踪到人脸数据,取出当前追踪的人脸,取出当前帧的NV21数据(用于人脸识别)mAFT_FSDKFace = result.get(0).clone();mImageNV21 = data.clone();} 当 FT 人脸追踪引擎识别出人脸信息时,我们将当前帧的人脸信息集合放在 mAFT_FSDKFace 当前帧的 NV21 格式 byte 数组放在 mImageNV21 中,有了长两个关键数据,联系我们的上一篇文章你大概知道我们可以用他们来做什么了吧?

上次我们已经介绍过

AFR_FSDK_ExtractFRFeature 特征提取接口,我们就不再赘述了。

流程是这样的 提取图片中的人脸 → 与我们已经注册过得特征集合进行特征匹配 → 匹配程度最高的作为最终识别结果

这一过程是放在一个子线程中运行的,代码如下:

//人脸识别线程

class FRAbsLoop extends AbsLoop {AFR_FSDKVersion version = new AFR_FSDKVersion();AFR_FSDKEngine engine = new AFR_FSDKEngine(); //人脸识别引擎AFR_FSDKFace result = new AFR_FSDKFace(); //人脸特征//全部已经保存的人脸特征集合List<FaceDB.FaceRegist> mResgist = ((Application)DetecterActivity.this.getApplicationContext()).mFaceDB.mRegister;List<ASAE_FSDKFace> face1 = new ArrayList<>();//年龄识别结果List<ASGE_FSDKFace> face2 = new ArrayList<>();//性别识别结果@Overridepublic void setup() {AFR_FSDKError error = engine.AFR_FSDK_InitialEngine(FaceDB.appid, FaceDB.fr_key); //初始化人脸识别引擎Log.d(TAG, "AFR_FSDK_InitialEngine = " + error.getCode());error = engine.AFR_FSDK_GetVersion(version);Log.d(TAG, "FR=" + version.toString() + "," + error.getCode()); //(210, 178 - 478, 446), degree = 1 780, 2208 - 1942, 3370}@Overridepublic void loop() {//当人脸追踪FT引擎获取到人脸后,该数据不为nullif (mImageNV21 != null) {final int rotate = mCameraRotate;long time = System.currentTimeMillis();//FR引擎人脸特征提取AFR_FSDKError error = engine.AFR_FSDK_ExtractFRFeature(mImageNV21, mWidth, mHeight, AFR_FSDKEngine.CP_PAF_NV21, mAFT_FSDKFace.getRect(), mAFT_FSDKFace.getDegree(), result);Log.d(TAG, "AFR_FSDK_ExtractFRFeature cost :" + (System.currentTimeMillis() - time) + "ms");Log.d(TAG, "Face=" + result.getFeatureData()[0] + "," + result.getFeatureData()[1] + "," + result.getFeatureData()[2] + "," + error.getCode());//特征匹配结果实例AFR_FSDKMatching score = new AFR_FSDKMatching();float max = 0.0f;String name = null;for (FaceDB.FaceRegist fr : mResgist) {for (AFR_FSDKFace face : fr.mFaceList) {//FT人脸追踪提取出的特征、for循环取出的系统中保存的特征、特征匹配结果error = engine.AFR_FSDK_FacePairMatching(result, face, score);Log.d(TAG, "Score:" + score.getScore() + ", AFR_FSDK_FacePairMatching=" + error.getCode());if (max < score.getScore()) {max = score.getScore();name = fr.mName;} //从整个集合中取出最大匹配结果与姓名}}//age & genderface1.clear();face2.clear();face1.add(new ASAE_FSDKFace(mAFT_FSDKFace.getRect(), mAFT_FSDKFace.getDegree()));face2.add(new ASGE_FSDKFace(mAFT_FSDKFace.getRect(), mAFT_FSDKFace.getDegree()));ASAE_FSDKError error1 = mAgeEngine.ASAE_FSDK_AgeEstimation_Image(mImageNV21, mWidth, mHeight, AFT_FSDKEngine.CP_PAF_NV21, face1, ages);ASGE_FSDKError error2 = mGenderEngine.ASGE_FSDK_GenderEstimation_Image(mImageNV21, mWidth, mHeight, AFT_FSDKEngine.CP_PAF_NV21, face2, genders);Log.d(TAG, "ASAE_FSDK_AgeEstimation_Image:" + error1.getCode() + ",ASGE_FSDK_GenderEstimation_Image:" + error2.getCode());Log.d(TAG, "age:" + ages.get(0).getAge() + ",gender:" + genders.get(0).getGender());final String age = ages.get(0).getAge() == 0 ? "年龄未知" : ages.get(0).getAge() + "岁";final String gender = genders.get(0).getGender() == -1 ? "性别未知" : (genders.get(0).getGender() == 0 ? "男" : "女");//crop 截取该人脸信息byte[] data = mImageNV21;YuvImage yuv = new YuvImage(data, ImageFormat.NV21, mWidth, mHeight, null);ExtByteArrayOutputStream ops = new ExtByteArrayOutputStream();//传入要截取的Rect范围yuv.compressToJpeg(mAFT_FSDKFace.getRect(), 80, ops);final Bitmap bmp = BitmapFactory.decodeByteArray(ops.getByteArray(), 0, ops.getByteArray().length);try {ops.close();} catch (IOException e) {e.printStackTrace();}if (max > 0.6f) {//fr success.置信度大于0.6final float max_score = max;Log.d(TAG, "fit Score:" + max + ", NAME:" + name);final String mNameShow = name;mHandler.removeCallbacks(hide);mHandler.post(new Runnable() {@Overridepublic void run() {mTextView.setAlpha(1.0f);mTextView.setText(mNameShow);mTextView.setTextColor(Color.RED);mTextView1.setVisibility(View.VISIBLE);mTextView1.setText("置信度:" + (float)((int)(max_score * 1000)) / 1000.0);mTextView1.setTextColor(Color.RED);mImageView.setRotation(rotate);if (mCameraMirror) {mImageView.setScaleY(-1);}mImageView.setImageAlpha(255);mImageView.setImageBitmap(bmp);}});} else {final String mNameShow = "未识别";DetecterActivity.this.runOnUiThread(new Runnable() {@Overridepublic void run() {mTextView.setAlpha(1.0f);mTextView1.setVisibility(View.VISIBLE);mTextView1.setText( gender + "," + age);mTextView1.setTextColor(Color.RED);mTextView.setText(mNameShow);mTextView.setTextColor(Color.RED);mImageView.setImageAlpha(255);mImageView.setRotation(rotate);if (mCameraMirror) {mImageView.setScaleY(-1);}mImageView.setImageBitmap(bmp);}});}mImageNV21 = null;}}@Overridepublic void over() {AFR_FSDKError error = engine.AFR_FSDK_UninitialEngine();Log.d(TAG, "AFR_FSDK_UninitialEngine : " + error.getCode());}

}这段代码还是很简单的,关键部分我都已经加了注释,相比大家看了也都能理解。

这里在废话几句:FD与FT引擎功能大致相同,完成的都是从一个 NV21 格式的图片 byte 数组中检测识别出人脸的位置 Rect 与角度信息。在获得这个信息后,我们调用FR人脸识别引擎识别出特征值信息,然后使用AFR_FSDK_FacePairMatching特征值匹配方法,一一的与我们程序中原来存储的人脸特征进行匹配,取出其中匹配值最高的那组特征值,获取该特征值的注册名。

到这里整个人脸识别的流程我们就都已经清晰的掌握了,如果没有看明白,就下载我加过注释的源码,再仔细看看代码是如何实现的。

本文有可能是这次文章的最后一篇了,但我标题上写的是中,下一片文章可能会介绍下我在实际使用虹软人脸识别 SDK 中遇到的问题以及解决方法(目前还没投入到项目中使用)。如果没有遇到问题的话,本文就此全文终。