爬虫指的是一种自动化程序,它可以模拟人类的行为,在万维网上抓取大量数据或者进行信息搜集。具体来说,爬虫通常借助网络协议和工具,例如HTTP或HTTPS协议、脚本语言(如Python、JavaScript)等,通过编写程序来访问特定网站或者页面,自动化地抓取、解析、存储和分析页面数据。

爬虫可以用于多种目的,例如:

搜索引擎

搜索引擎使用爬虫通过抓取Web页面收集数据并建立索引,以便快速提供相关结果。

数据分析

企业和研究机构使用爬虫来收集数据以支持决策,并进行各种分析操作,例如文本情感分析、机器学习、数据挖掘等。

监控和测试

爬虫还可用于监控网站状态、识别异常情况、测试网站性能等。

需要注意的是,虽然爬虫技术在多个领域中都有广泛应用,但是也应当遵循一定的道德规范和法律法规。遵守网络爬虫的伦理道德准则、版权归属、私隐和安全等,才能保证正当、合法使用该技术。

写爬虫需要注意什么

1、消息伦理与法律

在编写爬虫的过程中,需要遵守消息伦理和各项法律规定,防止侵权引起法律纠纷。在国外使用本地网络爬取数据时,也需要尊重相关法律规定,并且必须确保你所提取的内容不会涉及隐私或安全等问题。

2、网站协议和服务条款

需要仔细研究目标网站的协议及服务条款,确保你所进行的抓取操作完全合法。

3、模拟人类行为

爬虫需要设置合理的发送请求频率、添加延迟机制等,以模拟人类用户的行为特征,避免被服务器识别成自动程序并被屏蔽或加入黑名单。

4、数据解析和抓取

在进行数据解析和抓取时,考虑到 HTML 和 CSS 的灵活性,有些字段可能需要特殊处理。还应着眼于页面中的 cookie、动态元素(如 AJAX)、图片信息和视频等多媒体材料。

5、需要代理

一些网站可能对 IP 访问加以限制,或爬取数据可能涉及一定的风险,因此很有可能需要使用代理池来实现。

总之,编写爬虫是一项复杂而且需谨慎对待的任务。要确保你的爬虫在合法、有效和可靠的范围内行事,避免抓取不必要的内容,遵守协议和法律条款,并且建立自己的程序时需考虑网站反爬机制的存在。

爬虫如何使用代理ip

使用代理IP是爬虫绕过网站限制的一种常用方式。可以使用requests库来发起HTTP/HTTPS请求并设置代理。下面是一个简单的Python示例,演示如何使用代理IP进行网络请求:

import requests# Create a dictionary with the headers to simulate a browser agent

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3'}# Make the request using the URL, headers and proxy

url = 'https://www.example.com/'

proxy = {'http': 'http://[YOUR PROXY IP ADDRESS]:[PORT]','https': 'http://[YOUR PROXY IP ADDRESS]:[PORT]'}

response = requests.get(url, headers=headers, proxies=proxy)# Print the response status code and content

print(response.status_code)

print(response.content)

在这个示例中,我们创建了一个包含代理IP的字典,并将其作为参数传递给requests.get()方法。在实际应用中,需要将[YOUR PROXY IP ADDRESS]和[PORT]替换为实际的代理IP地址和端口号。此外,也可以使用一个代理池来随机选择合适的代理IP。

需要注意的是,使用代理IP还有一些潜在的问题。例如,代理不稳定或被服务器禁止访问等问题会导致访问失败,因此需要使用代理池、设置超时时间等方法以提高稳定性和可靠性。同时,也应该遵守代理服务提供商的使用规定和法律法规,否则可能会导致被禁止或面临法律风险。

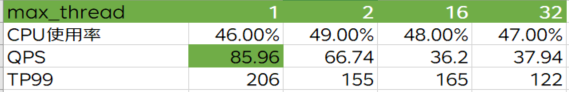

多线程爬虫使用代理ip

以下是一个简单的Python多线程爬虫使用代理IP的示例,使用requests和threading库:

import requests

import threading

from queue import Queueclass MyThread(threading.Thread):def __init__(self, queue):threading.Thread.__init__(self)self.queue = queuedef run(self):while True:# Fetch URL from queueurl = self.queue.get()# Set up headers and proxiesheaders = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.3029.110 Safari/537.3'}proxy = {'http': 'http://[YOUR PROXY IP ADDRESS]:[PORT]','https': 'https://[YOUR PROXY IP ADDRESS]:[PORT]'}# Make request with URL, headers and proxyresponse = requests.get(url, headers=headers, proxies=proxy)print(f"{url} : {response.status_code}")# Mark the task as done in the queueself.queue.task_done()# URLs to crawl

# 提取代理地址(http://jshk.com.cn/mb/reg.asp?kefu=xjy)

urls = ["http://www.example.com/page/1","http://www.example.com/page/2","http://www.example.com/page/3",# ...

]# Create a queue for URLS

queue = Queue()# Create threads and distribute URLs among them

num_threads = 5

for i in range(num_threads):t = MyThread(queue)t.daemon = Truet.start()for url in urls:queue.put(url)# Wait for all tasks to complete

queue.join()

需要将 [YOUR PROXY IP ADDRESS] 和 [PORT] 替换为实际的代理IP地址和端口号。该示例使用了队列来存储URL,创建了5个线程并将它们分配到每个URL上进行访问。再对下载量多的网站处理时,这种方式可以提高效率。

需要注意的是,使用代理IP要仔细选择合适的代理IP服务商,以获得一个稳定,有效和安全的代理IP。在使用代理IP时,还应遵循相应的道德规范和法律法规,防止被禁止访问或面临法律风险。