文章目录

- 1. Transfer Learning

- 1.1 Head-to-tail knowledge transfer

- (1) FTL

- ①##### ②##### ③

- (2) LEAP

- (3) OFA

- (4) RSG

- (5) M2m

- (6) GIST

- (7) MetaModelNet

- 1.2 Model pre-training

- (1) DSTL

- (2) SSP

- (3) Conceptual 12M

- 1.3 Knowledge distillation

- (1) LST

- (2) LFME

- (3) RIDE

- (4) SSD

- (5) DiVE

- 1.4 Self-training

- (1) CReST

- (2) DARS

- (3) MosaicOS

- 2. Data Augmentation

- 2.1 transfer-based augmentation

- 2.2 conventional (non-transfer) augmentation

- (1) MiSLAS

- (2) Remix

- (3) FASA

- (4) MetaSAug

- 3. Discussions

信息增强 \mathbb{信息增强} 信息增强类方法在模型训练中引入额外的信息,以提升不平衡学习中模型的性能。该类型的方法有两种:迁移学习和数据增强。

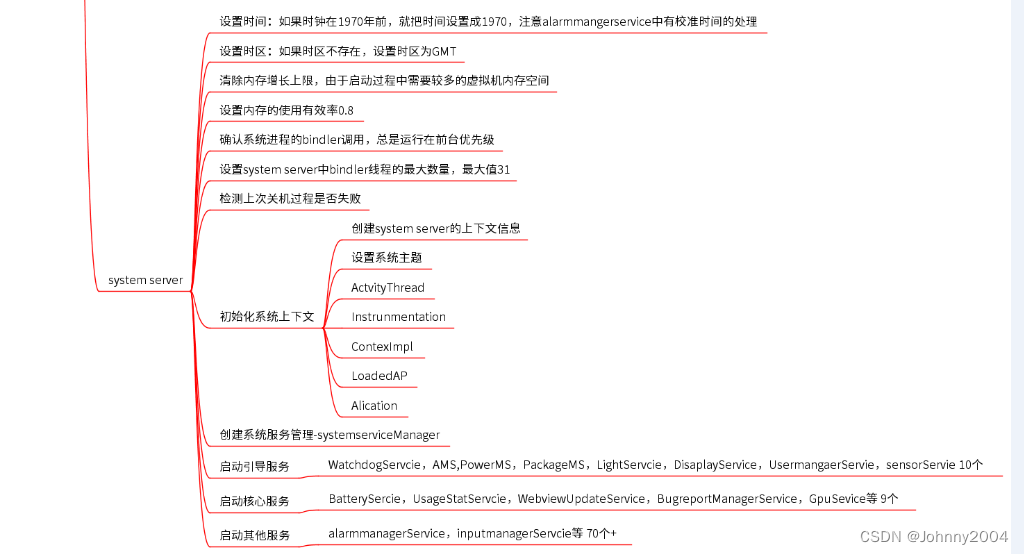

1. Transfer Learning

迁移学习 迁移学习 迁移学习试图从源域(如数据集、任务或类别)迁移知识,以增强目标域上的模型训练。在深度不平衡学习中,主要有四种迁移学习方案,即从头部类到尾部类的知识迁移、模型预训练、知识蒸馏和self-training 自训练。

1.1 Head-to-tail knowledge transfer

从头部到尾部的知识迁移旨在迁移头部类的知识,以增强模型在尾部类上的预测能力。

(1) FTL

Feature Transfer Learning FTL 特征转移学习Paper解读研究发现,尾部类样本的类内方差比头部类样本小得多,导致特征空间和决策边界有偏差。为解决该问题,FTL利用头部类的类内方差知识来指导尾部类样本的特征增强,从而使尾部类特征具有更高的类内方差,从而获得更好的尾部类性能。

①##### ②##### ③

(2) LEAP

A Learnable Embedding Augmentation Perspective LEAP 可学习的嵌入增强视角3.2.1.1 & 3.3.1.4 Paper解读为每个类构建了“特征云”,并试图通过在特征空间中增加具有一定干扰的尾部类样本,迁移头部类特征云的知识,以增强尾部类特征云的类内变化。最终,不同类间的类内特征方差的失真得到了缓解。

(3) OFA

Online feature augmentation OFA 在线特征增强3.2.1.1 $ 3.3.3 Paper解读提出使用类激活映射[132]将样本特征解耦为特定类特征不确定类特征。在此基础上,OFA通过将尾类样本的类特定特征与头类样本的类不可知特征相结合来增强尾类。然后,利用所有增强的和原始的特征,用重平衡采样器对模型分类器进行微调,从而获得更好的长尾学习性能。

(4) RSG

A new rare-class sample generator RSG 稀有类样本生成器Paper解读也观察到长尾问题中尾类的特征空间比头类小得多。为了解决这个问题,RSG建议生成新的尾类样本来扩大尾类的特征空间,并“推远”决策边界。为此,RSG动态估计每个类的一组特征中心,并使用头类样本特征与最近的类内特征中心之间的特征位移来增强每个尾样本特征。为了进一步最大化特征位移距离,增加生成的尾类样本特征的多样性,RSG引入了一个最大化的向量损失,强制特征位移方向与样本特征方向为“共线性”。

(5) M2m

除了特征级的头尾转移,major-tominor translation M2m major-tominor翻译Paper解读提出通过基于摄动的优化将头部类样本转换为尾部类样本来增加尾部类,这在本质上类似于对抗性攻击。翻译后的尾类样本将用于构建一个更均衡的训练集用于模型训练。

利用一个优化阶段,使得多数类的样本被修改成少数类样本,再加入原有数据集,达到均衡数据集的目的.

- 用少数类过采样策略训练一个分类器 g g g ,当然这个 g g g 在测试集上的表现是过拟合的(前文说过了)。我们需要的是个分类器 f f f ,使得在测试集上有正常的表现。

- 选择一个多数类样本 x 0 x_0 x0 ,增加一个扰动 δ \delta δ,得到新样本 x ∗ = x 0 + δ x^*=x_0+\delta x∗=x0+δ 。

- x 0 x_0 x0的label(记作 k 0 k_0 k0 )是多数类的,增加了扰动之后,用 g g g 去判断是否转化为了少数类的label(记作 k k k )。

- 具体的优化方程是: x ∗ = a r g m i n x : = x 0 + δ ( L ( g ; x , k ) + λ ⋅ f k 0 ( x ) ) x^*=argmin_{x:=x_0+\delta}(L(g;x,k)+\lambda ·f_{k_0}(x)) x∗=argminx:=x0+δ(L(g;x,k)+λ⋅fk0(x)) ,损失函数 L L L 还是交叉熵,可以看到是让 x x x 这个样本在 g g g 这个分类器中,得到标签 k k k 的交叉熵损失最小。再加上一个正则项,这一项让新的分类器 f f f 对原来的样本标签 k 0 k_0 k0 有更低的自信度。

- 对于一个样本 x 0 x_0 x0 ,我们希望找到一个 δ \delta δ ,使得该样本的在分类器 g g g 的预测标签从 k 0 k_0 k0 转化为 k k k 。

- 这样新得到的样本 x ∗ x^* x∗ 就可以加入原始数据集,作为少数类的样本之一。

- 重复,就可以丰富原始训练集,得到一个均衡的新数据集。

(6) GIST

a Geometric Structure Transfer Network GIST 几何结构转移网络3.1.1 & 3.3.2 Paper解读提出在分类器级别进行头尾转移。GIST利用头部类相对较大的分类器几何信息来增强尾部类的分类器权重,从而获得更好的尾部类性能。

(7) MetaModelNet

MetaModelNetPaper解读提出学习一种元网络,将少镜头模型参数映射到多镜头模型参数,其中少镜头模型在少量样本上训练,而多镜头模型在大量样本上训练。具体来说,元网络在头部类上进行训练,其中多镜头模型直接在头部类训练集上进行训练,而少镜头模型则在这些类的样本子集上进行训练。然后,将在头部类上学习到的元网络用于映射在尾部类上训练的少镜头模型,以获得更好的尾部类性能。

1.2 Model pre-training

模型预训练是一种广泛应用的深度模型训练范式。

(1) DSTL

Domain-specific transfer learning DSTL 特定域迁移学习Paper解读首先使用所有的不平衡样本对模型进行预训练,然后在更平衡的训练子集上微调模型。通过这种方式,DSTL将学习到的特征慢慢地迁移到尾部类,从而在所有类别之间获得更平衡的性能。

(2) SSP

此外,SSP 自监督预训练3.2.1.2 & 3.3.1.4 Paper解读提出先使用自监督学习 (如对比学习或旋转预测)进行模型预训练,然后对长尾数据进行标准训练。实验结果表明SSP的有效性,其中尾部类表现出更大的性能增益。这种方案也被用于处理带噪声标签的长尾数据[140]。

(3) Conceptual 12M

最近,一种新的视觉和语言预训练数据集Conceptual 12MPaper解读被提出,并已被证明对下游长尾识别有效。

1.3 Knowledge distillation

知识蒸馏是基于训练好的教师模型的输出来指导学生模型的训练,最近的一些研究探索了不平衡学习中的知识蒸馏。

(1) LST

LSTPaper解读提出一种类别增量学习策略来处理不平衡实例分割任务,其中知识蒸馏用于克服增量学习过程中的灾难性遗忘。

(2) LFME

LFME 多专家学习3.2.1.3 & 3.3.4 Paper解读将整个不平衡数据集划分成几个不平衡程度较轻的子集,并使用不同的样本子集训练多个专家。基于这些专家,LFME以从易到难的课程实例选择方式,使用自适应知识蒸馏来训练统一的学生模型。

(3) RIDE

RIDE 路由多样化分布感知专家3.2.1.3 & 3.3.4 Paper解读遵循多专家框架,通过使用更少的专家模型来训练学生网络,从而减少多专家模型的参数。

(4) SSD

最近,SSD 自我监督蒸馏Paper解读开发了一种新的自我蒸馏方案来增强解耦训练。具体来说,SSD首先通过解耦训练方案(第3.3.3节)训练基于监督和自监督信息的校准模型,然后使用校准模型为所有样本生成软标签。然后,利用生成的软标签和原长尾硬标签提取新的学生模型,然后进入新的分类器微调阶段。

(5) DiVE

此外,DiVE 蒸馏虚拟实例Paper显示了使用类平衡模型作为教师在长尾学习中知识蒸馏的有效性。

1.4 Self-training

自训练旨在从少量标记样本和大量未标记样本中学习性能良好的模型。具体来说,它首先使用标记样本来训练监督模型,然后使用该模型为未标记数据生成伪标签。之后,使用标记样本和伪标记样本重新训练模型。通过这种方式,自训练可以利用大量未标记样本中的知识来提高不平衡学习的性能。

然而,这样的范例不能直接用于处理长尾问题,因为标记和未标记的数据集都可能遵循长尾类分布。在这种情况下,在标记样本上训练的模型可能会偏向于头部类,并且倾向于为未标记样本生成更多的头部类伪标签,从而导致类失衡的倾斜程度更大。到目前为止,如何加强自我训练来解决长尾半监督学习仍然是一个有待研究的重要问题。Self-supervised Learning VS Self-training

(1) CReST

CReST 类再平衡自训练Paper解读研究了长尾分类中的自训练,发现监督模型对尾类的精度高得惊人。基于这一发现,CReST提出在每次迭代中选择更多的尾类样本进行在线伪标记,使重新训练的模型在尾类上获得更好的性能。

(2) DARS

DARS 分布对齐和随机抽样Paper解读增强了处理长尾半监督语义分割的自训练。为了解决标记样本和未标记样本之间类不平衡的潜在不一致性问题,DARS将标记训练数据的标签频率视为真实的类分布,并强制生成的伪标签的标签频率与标记样本的标签频率一致。同时,DARS采用抽样策略,严格控制每个类中伪标签的数量。这样,生成的伪标签将与真实标签更加一致,从而提高模型的性能。

(3) MosaicOS

MosaicOSPaper解读采用了额外的以对象为中心的图像(用于图像分类)来增强长尾对象检测。具体来说,它首先使用原始检测数据集中标记的以场景为中心的图像对模型进行预训练,然后使用预训练的模型为以对象为中心的图像生成伪边界框,例如ImageNet-1K[39]。在此之后,MosaicOS分两个阶段对预训练模型进行微调,即首先对伪标记的以对象为中心的图像进行微调,然后对原始标记的以场景为中心的图像进行微调。这样,MosaicOS缓解了数据差异的负面影响,有效地提高了长尾学习性能。

2. Data Augmentation

数据增强 数据增强 数据增强用于增强模型训练数据集的大小和质量 。在不平衡学习中,有两种数据增强方法,即基于迁移的增强和常规(非迁移)增强

2.1 transfer-based augmentation

基于迁移的增强,见1.1:从头到尾的知识转移

2.2 conventional (non-transfer) augmentation

常规非迁移增强,通过改进或设计数据增强方法来解决不平衡问题。

(1) MiSLAS

MiSLAS3.2.2.2 & 3.3.1.4 & 3.3.3 Paper解读研究不平衡学习中的数据mixup发现:(1) 数据mixup有助于纠正模型的over-confidence;(2) 在解耦训练方案中,mixup对表征学习有积极影响,但对分类器学习有消极或可忽略的影响。基于这些观察,MiSLAS提出在解耦方案中使用mixup来增强表征学习。

(2) Remix

此外,RemixPaper解读也利用数据mixup进行长尾学习,并引入了一种重平衡的混合方法来专门增强尾部类。

(3) FASA

FASAPaper提出了基于高斯先验(其均值和方差从先前观察的样本中估计)生成分类特征。此外,FASA利用平衡验证集上的模型分类损失来调整不同类别的特征抽样率,使未充分表示的尾部类别能够得到更多的扩充。

(4) MetaSAug

MetaSAug 元语义增强Paper提出用ISDA 隐式语义数据增强的变体来增强尾类。具体来说,ISDA通过估计样本特征的类条件统计量(即协方差矩阵)来获得语义方向,并通过翻译样本特征和不同的语义有意义的方向来生成多样化的增强样本。然而,尾类样本的不足使得估计尾类的协方差矩阵无效。为了解决这个问题,MetaSAug探索了元学习,以指导每个类平衡损失[16]的协方差矩阵的学习。这样可以更准确地估计尾类的协方差矩阵,从而生成的尾类特征具有更大的信息量。

3. Discussions

由于引入了额外的知识,基于迁移学习的方法在不牺牲头部类性能的情况下提高了尾部类性能。考虑到缺乏足够的尾部类样本是不平衡学习的关键问题之一,这种方法值得进一步探索。

数据增强是一种相对基础的技术,这使得这种方法在现实世界的应用中比其他方法更实用。然而,简单地使用现有的类别不可知增强技术来改进不平衡学习是不利的,因为考虑到头部类有更多的样本并且将被扩充更多,它们可能会进一步增加不平衡。如何更好地为长尾学习进行数据增强仍是一个悬而未决的问题。