安装Spark

任务描述

本关任务:完成Spark安装。

相关知识

Apache Spark 是一个新兴的大数据处理通用引擎,提供了分布式的内存抽象。Spark 最大的特点就是快,可比 Hadoop MapReduce 的处理速度快 100 倍。本节将详细说明 Spark 的安装。

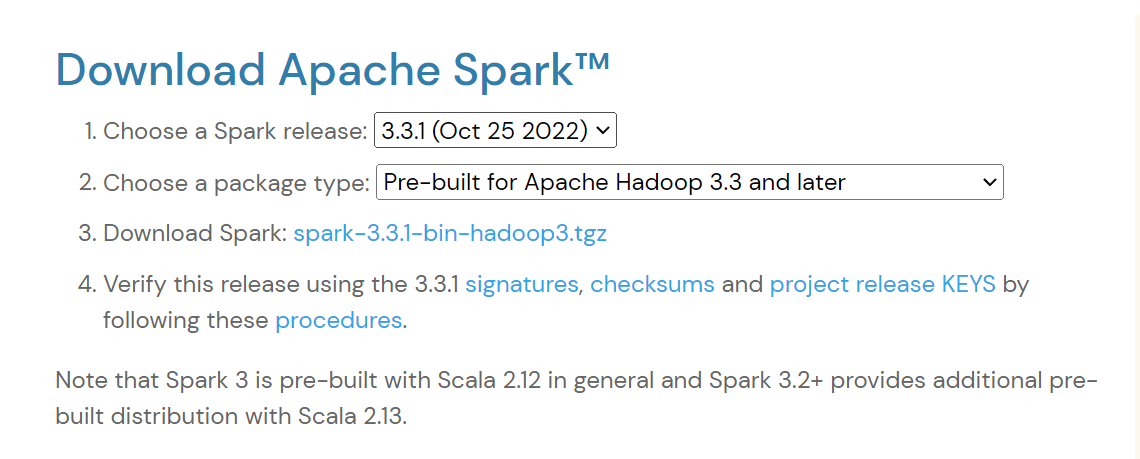

下载Spark

首先需要下载Spark安装文件。访问Spark官方下载地址,Downloads | Apache Spark 按照如图所示的下载。

可以提示点击进行下载。

解压Spark

本实验中Spark采用Local模式进行安装,也就是在单机上运行Spark,因此,在安装Hadoop时,需要按照伪分布式模式进行安装。在单台机器上按照“Hadoop(伪分布式)+Spark(Local模式)”这种方式进行Hadoop和Spark组合环境的搭建,可以较好满足入门级Spark学习的需求。打开终端,输入下述命令:

tar -zvxf /data/bigfiles/spark-3.3.1-bin-without-hadoop.tgz -C /usr/local/cd /usr/localmv ./spark-3.3.1-bin-without-hadoop/ ./sparkchown -R root:root ./spark # 此处的 hadoop 为你的用户名

配置Spark

安装后,还需要修改Spark的配置文件spark-env.sh:

cd /usr/local/sparkcp ./conf/spark-env.sh.template ./conf/spark-env.sh

配置完成后就可以直接使用,不需要像Hadoop运行启动命令。通过运行Spark自带的示例,验证Spark是否安装成功。

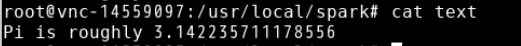

cd /usr/local/sparkbin/run-example SparkPi > textcat text

过滤后的运行结果如图所示,可以得到π的近似值:

编程要求

在右侧命令行中配置好Scala环境后点击评测即可。 提示:平台已经将解压包下载并放在/data/bigfile/目录下了,不需要再从网络下载。

开始你的任务吧,祝你成功!