文章目录

- 一、Redis高可用

- 1.持久化

- 2.主从复制

- 3.哨兵

- 4.Cluster集群

- 二、主从复制

- 1.概念

- 2.作用

- 3.主从复制流程

- 4.配置主从复制

- 三、哨兵模式

- 1.功能

- 2.作用

- 3.组成

- 4.故障转移机制

- 7.故障模拟

- 8.恢复故障节点

- 四、Cluster群集

- 1.简介

- 2.作用

- (1)数据分区

- (2)高可用

- 3.数据分片原理

- 4.Redis集群的主从复制模型

- 5.搭建 redis cluster 集群

一、Redis高可用

在web服务器中,高可用是指服务器可以正常访问的时间,衡量的标准是在多长时间内可以提供正常服务。(99.9%、99.99%、99.999%等等)

高可用的计算公式是1-(宕机时间)/(宕机时间+运行时间)有点类似与网络传输的参数误码率,我们用9的个数表示可用性

2个9:99%=1%365=3.6524h=87.6h

4个9:99.99%=0.01%36524*60=52.56min

5个9:99.999%=0.001%*365=5.265min

11个9:几乎一年宕机时间只有几分钟

但是在Redis语境中,高可用的含义似乎要宽泛一些,除了保证提供正常服务(如主从分离、快速容灾技术),还需要考虑数据容量的扩展、数据安全不会丢失等。

在Redis中,实现高可用的技术主要包括持久化、主从复制、哨兵和Cluster集群。

1.持久化

持久化是最简单的高可用方法(有时甚至不被归为高可用的手段),主要作用是数据备份,即将数据存储在硬盘,保证数据不会因进程退出而天失。

2.主从复制

主从复制是高可用Redis的基础,哨兵和集群都是在主从复制基础上实现高可用的。主从复制主要实现了数据的多机备份,以及对于读操作的负载均衡和简单的故障恢复。

缺陷:故障恢复无法自动化;写操作无法负载均衡;存储能力受到单机的限制。

3.哨兵

在主从复制的基础上,哨兵实现了主节点自动化的故障恢复,但无法对从节点自动故障转移,在读写分离场景下,从节点故障会导致读服务不可用。

缺陷:写操作无法负载均衡;存储能力受到单机的限制;需要对从节点额外做监控。

4.Cluster集群

通过集群,Redis解决了写操作无法负载均衡,以及存储能力受到单机限制的问题,实现了较为完善的高可用方案。

缺陷:成本和资源需求打。

二、主从复制

1.概念

主从复制,是指将一台Redis服务器的数据,复制到其他的Redis服务器。前者称为主节点Master,后者称为从节点Slave;

数据的复制是单向的,只能由主节点到从节点

默认情况下,每台Redis服务器都是主节点,且一个主节点可以有多个从节点(或没有从节点),但一个从节点只能有一个主节点。

2.作用

(1)数据冗余:主从复制实现了数据的热备份,是持久化之外的一种数据冗余方式。

(2)故障恢复:当主节点出现问题时,可以由从节点提供服务,实现快速的故障恢复;实际上是一种服务的冗余。

(3)负载均衡:在主从复制的基础上,配合读写分离,可以由主节点提供写服务,由从节点提供读服务(即写Redis数据时应用连接主节点,读Redis数据时应用连接从节点),分担服务器负载;尤其是在写少读多的场景下,通过多个从节点分担读负载,可以大大提高Redis服务器的并发量。

(4)高可用基石:除了上述作用以外,主从复制还是哨兵和集群能够实施的基础,因此说主从复制是Redis高可用的基础。

3.主从复制流程

(1)若启动一个slave机器进程,则它会向Master机器发送一个"sync command"命令,请求同步连接。

(2)无论是第一次连接还是重新连接,Master机器都会启动一个后台进程,将数据快照保存到数据文件中(执行rdb操作),同时Master还会记录修改数据的所有命令并缓存在数据文件中。

(3)后台进程完成缓存操作之后,Master机器就会向slave机器发送数据文件,Slave端机器将数据文件保存到硬盘上,然后将其加载到内存中,接着Master机器就会将修改数据的所有操作一并发送给slave端机器。若slave出现故障导致宕机,则恢复正常后会自动重新连接。

(4)Master机器收到slave端机器的连接后,将其完整的数据文件发送给Slave端机器,如果Mater同时收到多个slave发来的同步请求,则Master会在后台启动一个进程以保存数据文件,然后将其发送给所有的slave端机器,确保所有的slave端机器都正常。

4.配置主从复制

主节点:192.168.116.40

从节点:192.168.116.50

从节点:192.168.116.60

主、从节点配置文件修改

vim /etc/redis/6379.conf#70行,每台添加本机的地址

bind 127.0.0.1 192.168.116.40#700行,开启AOF

appendonly yes

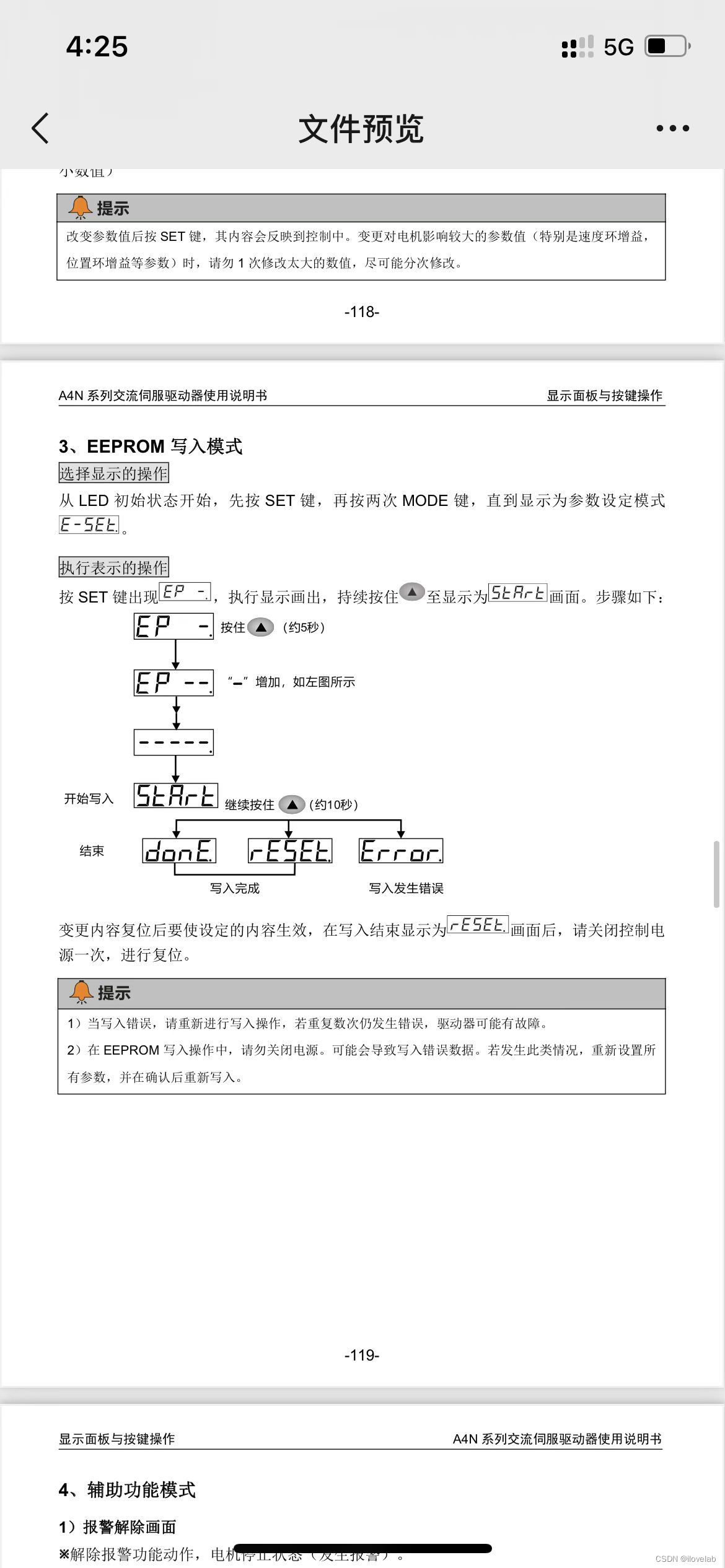

从节点添加

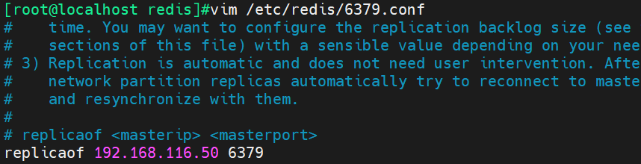

vim /etc/redis/6379.conf#288行,指定master

replicaof 192.168.116.40 6379

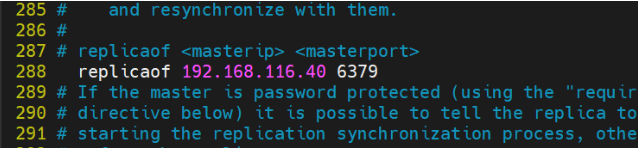

查看日志发现,主从已经进行RDB数据完全同步

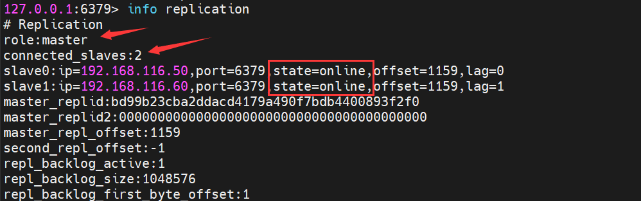

执行 info replication 可以查看同步信息

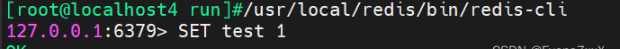

主添加数据,测试aof同步

查看从节点是否有这个数据(都有则同步成功)

三、哨兵模式

1.功能

在主从复制的基础上,哨兵引入了主节点的自动故障转移。

2.作用

监控:哨兵会不断地检查主节点和从节点是否运作正常。

自动故障转移:当主节点不能正常工作时,哨兵会开始自动故障转移操作,它会将失效主节点的其中一个从节点升级为新的主节点,并让其它从节点改为复制新的主节点。

通知:哨兵可以将故障转移的结果发送给客户端。

3.组成

哨兵节点:哨兵系统由一个或多个哨兵节点组成,哨兵节点是特殊的redis节点,不存储数据。

数据节点:主节点和从节点都是数据节点。

4.故障转移机制

(1)由哨兵节点定期监控发现主节点是否出现了故障,每个哨兵节点每隔1秒会向主节点、从节点及其它哨兵节点发送一次ping命令做一次心跳检测。如果主节点在一定时间范围内不回复或者是回复一个错误消息,那么这个哨兵就会主观认为这个主节点下线了(单方面的);当超过半数哨兵节点认为该主节点主观下线了,这样就客观下线了。

(2)当主节点出现故障,此时哨兵节点会通过Raft算法(选举算法)实现选举机制共同选举出一个哨兵节点为leader,来负责处理主节点的故障转移和通知。所以整个运行哨兵的集群的数量不得少于3个节点。

(3)由leader哨兵节点执行故障转移,过程如下

将某一个从节点升级为新的主节点,让其它从节点指向新的主节点;若原主节点恢复也变成从节点,并指向新的主节点;通知客户端主节点己经更换。

需要特别注意的是,客观下线是主节点才有的概念;如果从节点和哨兵节点发生故障,被哨兵主观下线后,不会再有后续的客观下线和故障转移操作。

5.主节点选举依据

- 过滤掉不健康的(已下线的)没有回复哨兵ping响应的从节点。

- 选择配置文件中从节点优先级配置最高的。(replica-priority,默认值为100)

- 选择复制偏移量最大,也就是复制最完整的从节点。

6.配置哨兵模式

首先需要做好主从复制,上一部分已经完成。

复制并修改哨兵配置文件

cp /opt/redis-5.0.7/sentinel.conf /etc/redis/

cd /etc/redis/

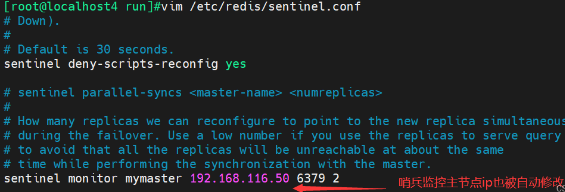

vim sentinel.conf

#关闭保护模式

protected-mode no

#默认端口

port 26379

#打开后台运行

daemonize yes

#指定哨兵的pid和日志文件

pidfile "/var/run/redis-sentinel.pid"

logfile "/var/log/sentinel.log"

#指定redis数据文件

dir "/var/lib/redis/6379"

#指定哨兵模式主节点(2代表最少两个哨兵主观认为主宕机,才是客观宕机)

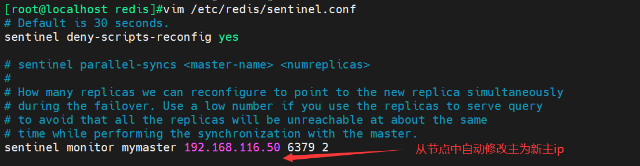

sentinel monitor mymaster 192.168.116.40 6379 2

#判定服务器down掉的时间周期,默认30000毫秒(30秒)

sentinel down-after-milliseconds mymaster 10000

#同一个sentinel对同一个master两次故障恢复之间的间隔时间(180秒)

sentinel failover-timeout mymaster 180000

修改好的文件复制给从节点,并重启服务

#在主节点的/etc/redis/下执行远程传输

scp sentinel.conf 192.168.116.50:`pwd`

scp sentinel.conf 192.168.116.60:`pwd`#从节点重启服务加载配置

service redis restart

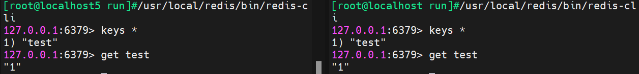

启动哨兵模式

#主从都执行

/usr/local/redis/bin/redis-sentinel sentinel.conf

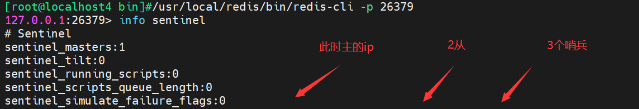

查看哨兵模式信息

7.故障模拟

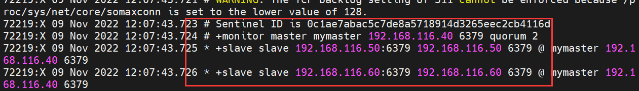

首先跟踪哨兵日志,此时显示主从是正常的

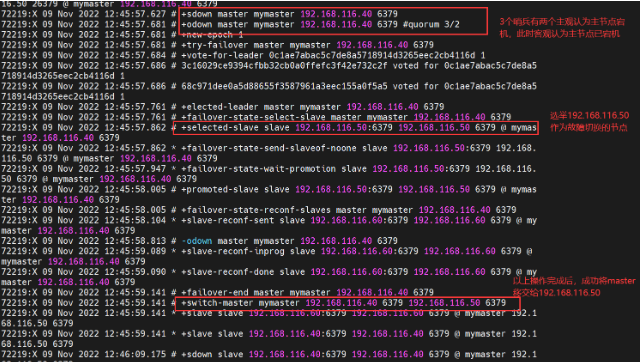

关闭主节点redis服务,查看是否完成故障切换

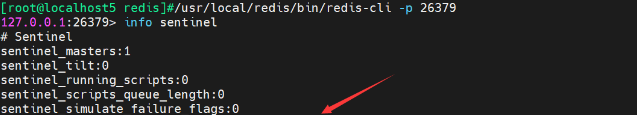

查看新主节点中的信息

查看从节点配置文件

8.恢复故障节点

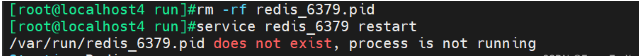

恢复原来宕机的主节点,看他是否能加入到从节点中

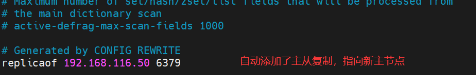

查看配置文件

恢复成功!

四、Cluster群集

1.简介

集群,即Redis Cluster,是Redis 3.0开始引入的分布式存储方案。

集群由多组节点(Node)组成,Redis的数据分布在这些节点中。集群中的节点分为主节点和从节点:只有主节点负责读写请求和集群信息的维护;从节点只进行主节点数据和状态信息的复制。

2.作用

(1)数据分区

数据分区是集群最核心的功能。集群将数据分散到多个节点,一方面突破了Redis单机内存大小的限制,存储容量大大增加,另一方面每个主节点都可以对外提供读服务和写服务,大大提高了集群的响应能力。Redis单机内存大小受限问题,在介绍持久化和主从复制时都有提及,例如,如果单机内存太大,bgsave和bgrewriteaof的forks操作可能导致主进程阻塞,主从环境下主机切换时可能导致从节点长时间无法提供服务,全量复制阶段主节点的复制缓中区可能溢出。

(2)高可用

集群支持主从复制和主节点的自动故障转移(与哨兵类似),当任一节点发生故障时,集群仍然可以对外提供服务。

3.数据分片原理

Redis集群引入了哈希槽的概念,Redis集群有16384个哈希槽(编号0-16383)集群的每个节点负责一部分哈希槽。

以3个节点组成的集群为例

节点A包含0~5460号哈希槽

节点B包含5461~10922号哈希槽

节点C包含10923~16383号哈希槽

每个Key通过CRC16算法生成一个值,用这个值对16384取余得到的数,在哪个节点的哈希槽区间,来决定放在哪个节点的哈希糟中,然后直接自动跳转到这个对应的节

点上进行存取操作。

4.Redis集群的主从复制模型

例如集群中具有A、B、C三个节点,如果节点B失效了,整个集群就会因缺少5461-10922这个范围的槽而不可以用。

所以为每个节点添加一个从节点A1、B1、C1,整个集群便有三个Master节点和三个slave节点组成,在节点B失效后,集群选举B1为的主节点继续服务;当B和B1都失败后,集群将不可用。

5.搭建 redis cluster 集群

一般一个群集需要3对一主一从,为了演示方便,这里使用一台主机redis的6001-6004端口,模拟6台不同的redis实例。

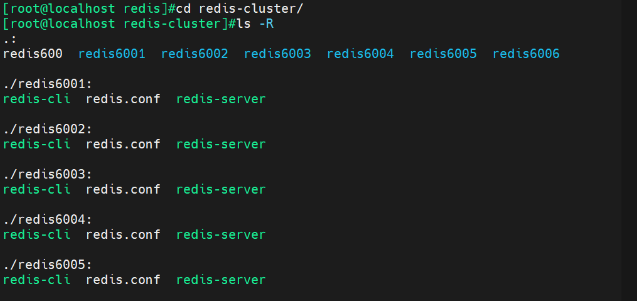

创建每个redis节点的目录,复制需要的文件

mkdir -p redis-cluster/redis600{1..6}#批量复制所需文件到6个目录下

cd /opt/redis-5.0.7/

for i in {1..6};do cp /opt/redis-5.0.7/redis.conf /etredis600$i;cp /opt/redis-5.0.7/src/redis-server /opt/redis-5.0.7/src/redis-cli /etredis600$i;done

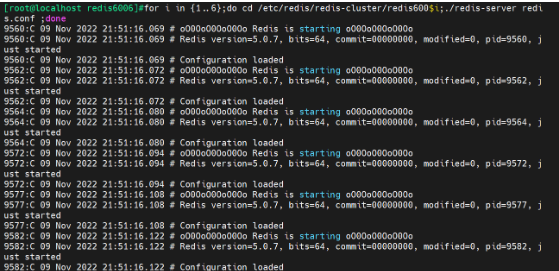

修改6个实例的配置文件,之后全部开启

#先修改一个,再复制给其他的,修改端口和文件名序号即可

cd /etc/redis/redis-cluster/redis6001

vim redis.conf

#修改以下字段,其他可自行修改

bind 0.0.0.0 #为实验方便监听所有

protected-mode no #关闭保护模式

port 6001 #监听端口(每台需要不一样6001-6002)

daemonize yes #打开后台运行

appendonly yes #打开aof

cluster-enabled yes #开启集群模式

cluster-config-file nodes-6001.conf #集群节点配置文件名(每台需要不一样6001-6002)

cluster-node-timeout 15000 #集群故障监听超时时间#开启所有

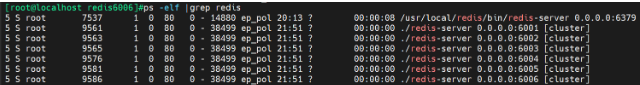

for i in {1..6};do cd /etc/redis/redis-cluster/redis600$i;./redis-server redis.conf;done #开启cluster模式

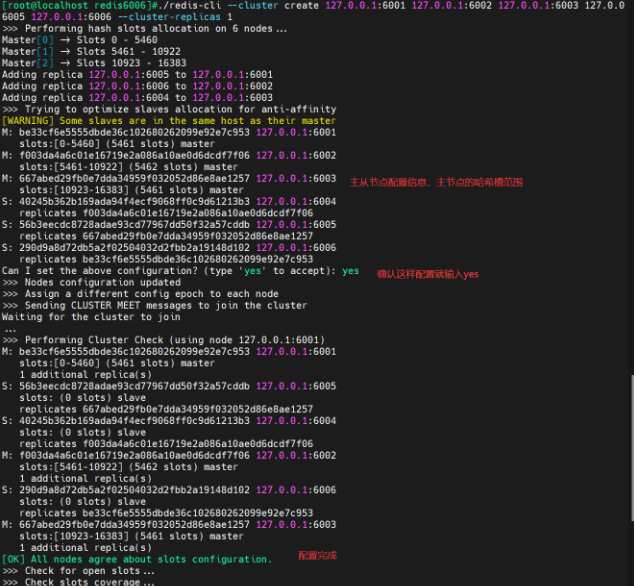

./redis-cli --cluster create 127.0.0.1:6001 127.0.0.1:6002 127.0.0.1:6003 127.0.0.1:6004 127.0.0.6005 127.0.0.1:6006 --cluster-replicas 1

#结尾的选项1,代表每个主有1个从节点

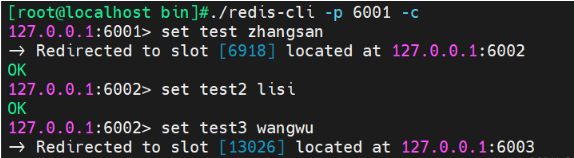

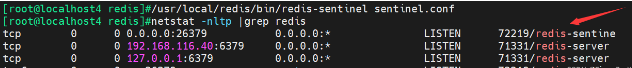

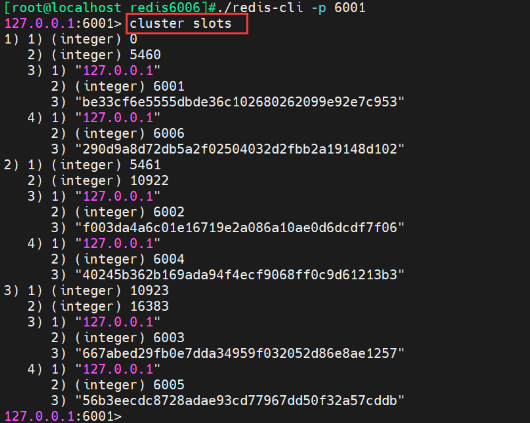

可以在数据库中使用 cluster slots 查看集群信息

测试插入数据(登入时加上-c选项,否则无法自动切换节点)