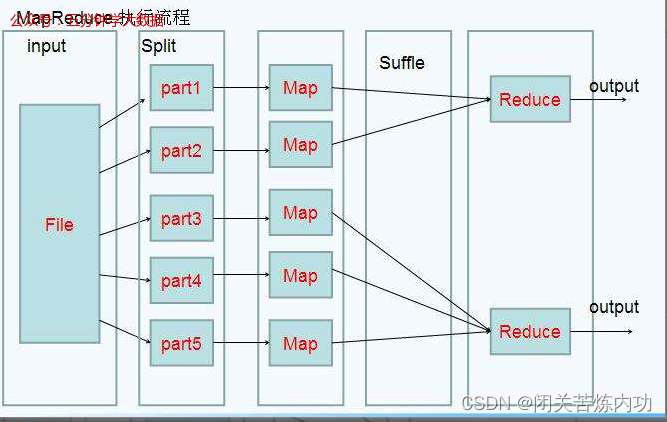

一、在我们提交完MR程序之后,MR程序会先后经历map,reduce阶段,下面我们详细的来解析一下各个阶段

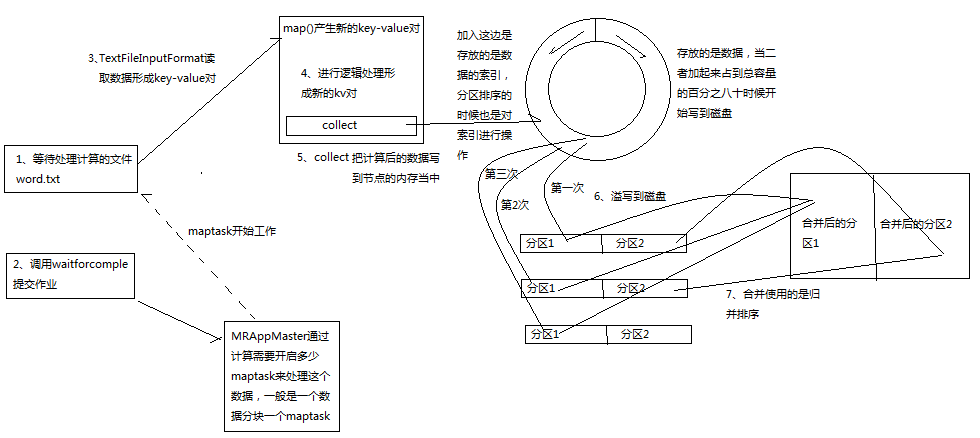

1、map阶段,在这个阶段主要分如下的几个步骤read,map,collect,溢写,combine阶段

(1)、在read阶段,maptask会调用用户自定义的RecordReader方法,在splitInput中解析出一个个的key-value对

(2)、在map阶段,maptask会接受由前面读取来的数据,然后按照所需的逻辑对数据进行加工处理,形成新的key-value对

(3)、在collect阶段,map在数据处理完成之后会调用OutputCollector.collect()方法把数据写入环形缓冲区中,这个环形缓冲区被分为了两部分,一半是用来存储数据的索引,一半是用来存储数据,在分区中首先是按照分区号进行排序,在分区里面在按照key进行排序,在环形缓冲区中默认的采用的是哈希分区,如果想自定义分区可以重写一个类继承partition在重新分区方法即可。

(4)、溢写阶段,当环形缓冲区中的数据到达整个缓冲区的百分之八十的时候(环形缓冲区默认大小是100M),就会把数据写入本地的临时文件,但是为了提高性能在这儿可以调用combiner首先把数据合并之后再把数据写入零时文件,在环形缓冲区上的数据读写方法时索引存储数据和存储索引占到总大小的百分之八十多的时候,双方在结束的位置同时向开始的位置读取数据,这样循环往复。

(5)、合并阶段,在前面产生的所有的临时文件,maptask采用轮转的方式进行合并,并且在合并之后的分区中进行排序,这样这个map就会产生一个数据的输出文件。

(6)如下图所示

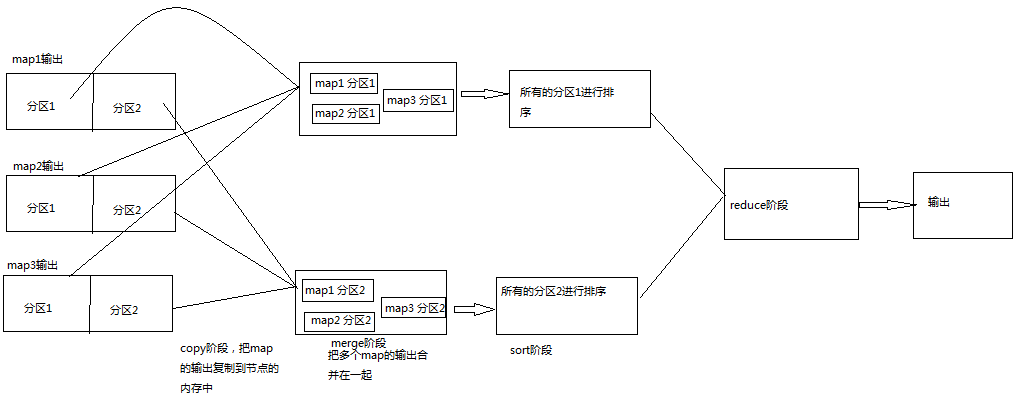

2、reduce阶段主要包括如下的阶段,cpoy阶段,merge阶段,sort阶段,reduce阶段

(1)、copy阶段主要是reducer阶段从远程的map的输出去拷贝数据到本地的内存中,同一个reducer的节点会把不同的map的输出的同一个分区拷贝到本地。

(2)、merge阶段,在开始拷贝数据的时候。reduceTask会启动两个后台线程,合并内存中的数据和磁盘中的数据,防止使用过多的内存和磁盘。

(3)、sort阶段,由于在reduce的数据是按照key进行聚合排序的,但是在map的输出的时候就已经进行排序,所以在这儿只需要简单的归并排序即可

(4)、reduce阶段 ,把已经按照key聚合的数据输出给reducer按照我们的义务逻辑进行处理。

(5)、具体如下图所示