展开全部

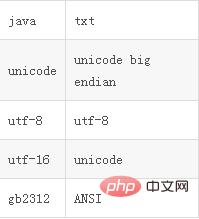

1、r语言62616964757a686964616fe59b9ee7ad9431333431376533读取txt文件的方法:首先根据下图图片中的命令代码进行输入

2、然后这样就可以读取txt文件了,结果图如下:

3、R读取csv文件的方法:在读取csv文件时,分割符为“,”;可以根据下方的代码进行编辑。

read.csv(file, header = TRUE, sep = ",", quote = "\"",

dec = ".", fill = TRUE, comment.char = "", ...)

4、如果想要读取Excel表格数据的话,可以使用下方的方法来实现。

xls2csv(xls, sheet=1, verbose=FALSE, blank.lines.skip=TRUE, ..., perl="perl")

xls2tab(xls, sheet=1, verbose=FALSE, blank.lines.skip=TRUE, ..., perl="perl")

xls2tsv(xls, sheet=1, verbose=FALSE, blank.lines.skip=TRUE, ..., perl="perl")

xls2sep(xls, sheet=1, verbose=FALSE, blank.lines.skip=TRUE, ...,

method=c("csv","tsv","tab"), perl="perl")