环境建议:使用谷歌云GCP,国内的云环境实在是太慢了哦。github慢,pip 慢,下载模型也慢。

1.下载环境

!git clone https://github.com/Facico/Chinese-Vicuna

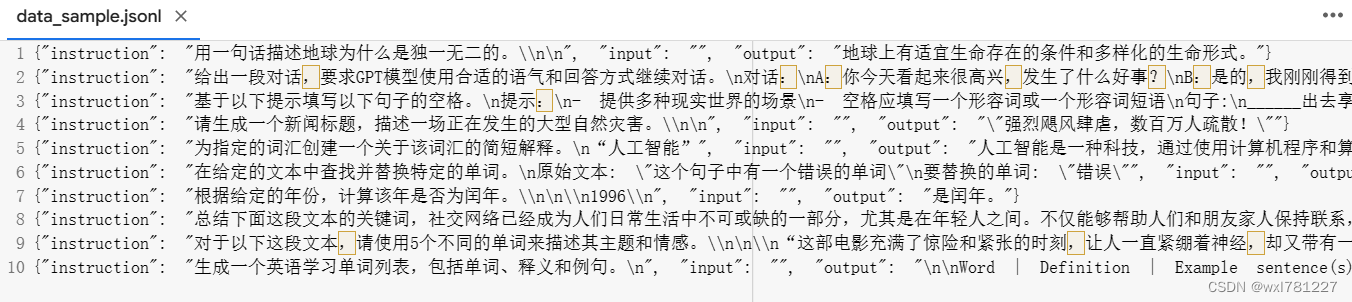

!pip install -r ./Chinese-Vicuna/requirements.txt2. 准备数据 json/jsonl格式

3. 微调

!python ./Chinese-Vicuna/finetune.py --data_path /content/Chinese-Vicuna/sample/instruct/data_sample.jsonl --test_size 54.生成web界面

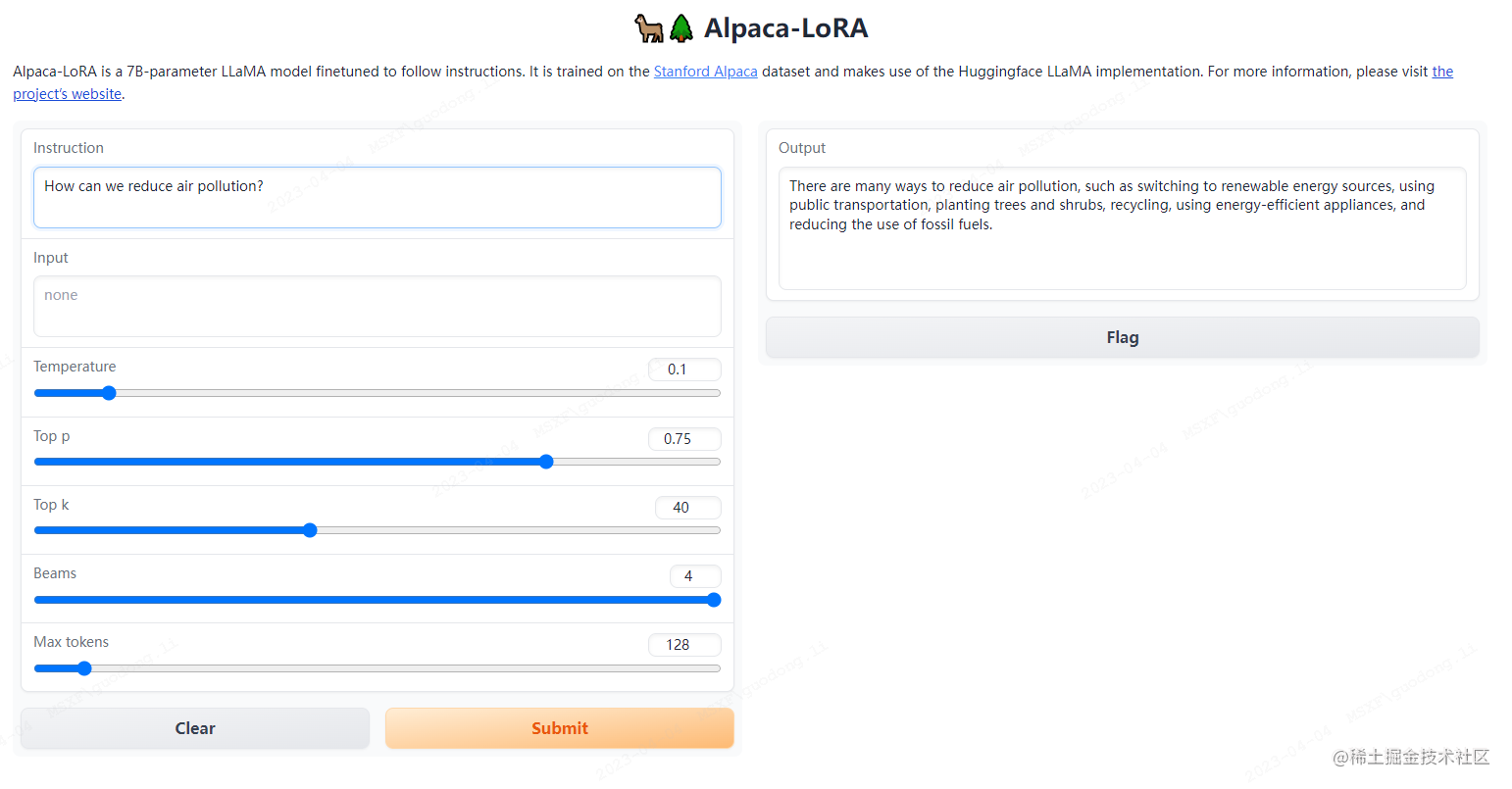

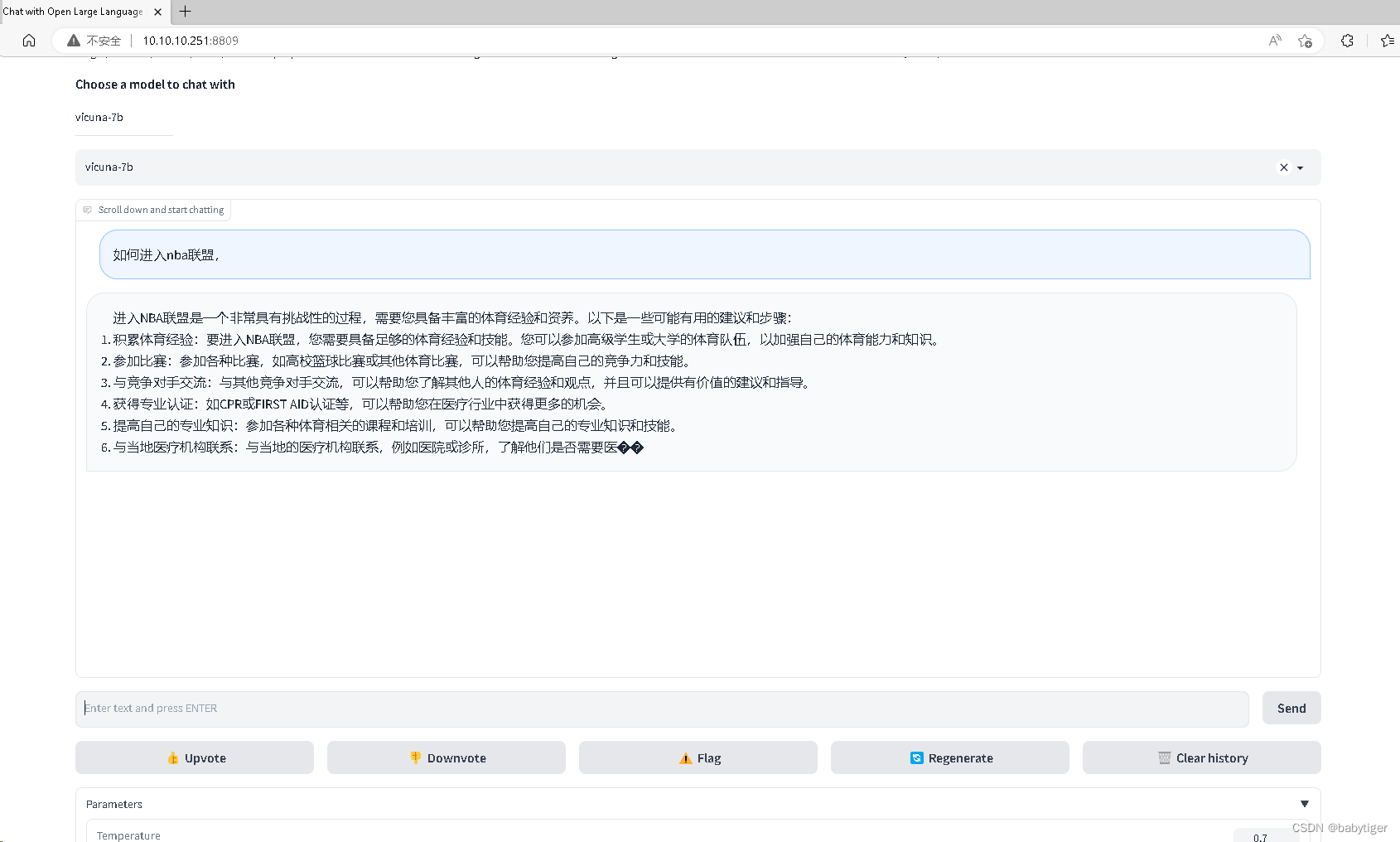

!python ./Chinese-Vicuna/generate.py --model_path decapoda-research/llama-7b-hf --lora_path /content/lora-Vicuna --use_local 05.运行界面