背景

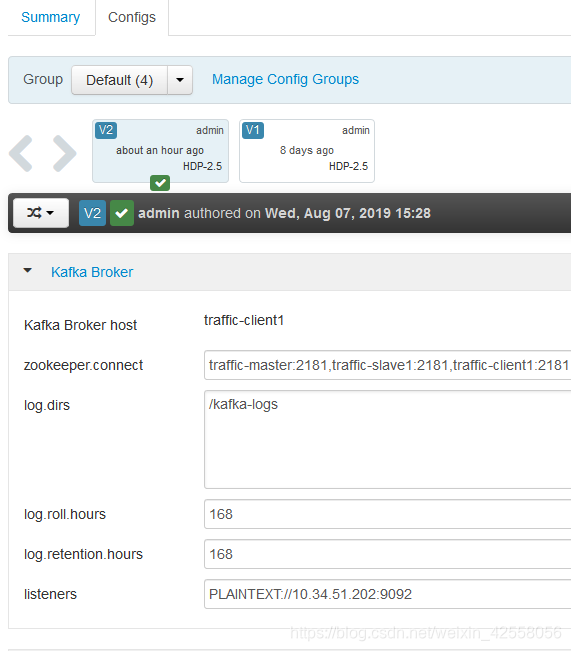

由于新增一个对接渠道,系统要对Kafka的消息进行消费,由于对接方目前没有环境,所以自己本地开发,并且使用环境中的一台kafka作为开发使用,本地自己设置producer和consumer,分别作为生产者和消费者。

producer

consumer

问题

同样的topic和groupid,但是在使用的过程中,在producer提供消息的时候,出现了Failed to update metadata after 60000 ms.

网上搜索多数都是要求更改kafka的配置文件中的信息,但是此kafka服务器是共有的,其他程序也是在完美运行中,因此不会是配置问题。

尝试

调整生产者和消费者代码,用新的bean方式,最终还是不行。

调整生产者和消费者的配置,保障唯一性,还是一样的问题。

解决

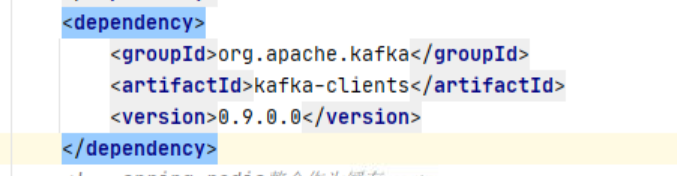

由于kafka维护在其他项目组人员下面,且有其他项目组使用,查看其他项目组的代码,发现kafka的版本是0.9.0,我们项目中没有对kafka单独引入依赖,默认集成在org.springframework,默认是1.2.0。。。。由于我们是client客户端,所以需要单独配置一下pom。更改版本为0.9.0即可。

困扰一下午的问题得以解决。。。。