提示:文章写完后,目录可以自动生成,如何生成可参考右边的帮助文档

文章目录

- 一、Deep Neural Decision Forests

- 二、Deep Forest

- 阅读参考

关于决策树随机森林与深度学习,以两篇论文为切入,作简要分析。

作者的研究动机,和经典的Decision Tree的关系,方法的Limits或适用的场景(给出自己的分析)。希望得到纠正和补充。

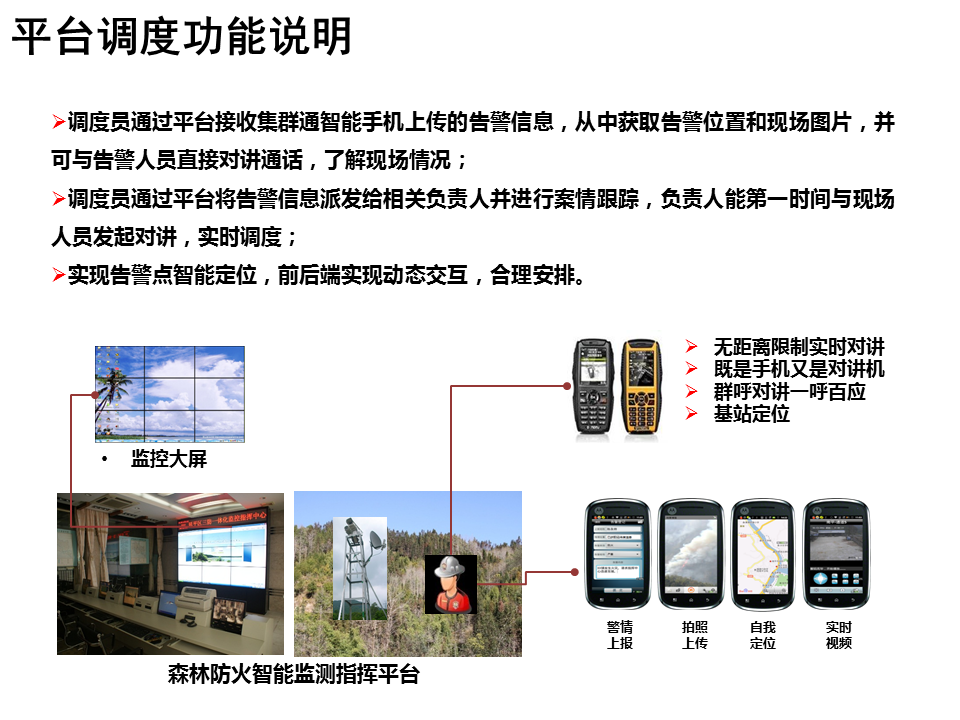

一、Deep Neural Decision Forests

***研究动机:***一些学者对随机森林中表示学习的早期形式进行尝试,但它们的预测精度仍然低于最先进的水平。传统模型的拟合能力非常强,但是需要人工提取一些非常强力的特征,而CNN又以其超强的图片特征提取能力而著称。卷积神经网络提供特征,决策树(森林)提供分类。传统方法与深度学习结合进行端到端的训练,随机森林作为深度神经网络最后一层的分类器(代替了原来的Softmax层)。

***关系:***在传统的决策树中,分裂节点是二值的,即它决定了经过这个节点以后是向左分支走还是向右分支走,并且这个结果是一旦决定就不可更改的。这就导致网络有可能在当前node是最优的(根据info-gain的原则)但是最后的分类效果并不是最优的。因此本文考虑“概率”决策树,即每个node的分裂是一个概率。

Limits:由于反向传播,损失还需可微。

适用的场景:图像分类,语义分割。提供了一个全局最优策略来估计在叶子中所采取的预测。不需要大量额外超参数

二、Deep Forest

***研究动机:***目前的深度学习模型大多建立在神经网络之上,即可以通过反向传播进行训练的多层参数化可微非线性模块。本文探讨了基于决策树等不可微模块构建深度模型的可能性关系。

关系: 是一种决策树的集成方法。传统的学习模型决策树,与dnn区别因素在于,与生成新特征的dnn相比,决策树和助推机在学习过程中总是对原始特征表示进行工作;换句话说,没有模型内的特征转换。此外,与具有任意高模型复杂度的DNNs相比,决策树和增强机器只能具有有限的模型复杂度。虽然模型的复杂性本身并不能导致dnn的成功,但它仍然很重要,因为如果想要利用大的训练数据,就需要大的模型容量。

***Limits:1未来的一个重要问题是增强特性的重新表示过程。gcForest的当前实现采用了最简单的类向量形式,即相关实例所属的叶节点上的类分布。当原始特征向量是高维的时,这样少量的增强特征很容易被淹没。

2随机森林不适合gpu,对设备计算要求高。

适用的场景:图像分类、面部识别、音乐分类、手移动识别、语义分割、低维数据、高维数据。小规模数据中也能很好地工作,并使用户能够根据计算量控制训练成本,超参数也较少。当dnn并不优越时,它提供了一种替代方案。有很多任务,特别是分类/符号或混合建模任务。

阅读参考

https://blog.csdn.net/helei001/article/details/50777478

https://blog.csdn.net/wangqingbaidu/article/details/52575042

https://blog.csdn.net/weixin_43595430/article/details/105369697

https://blog.csdn.net/loading_123/article/details/78860344