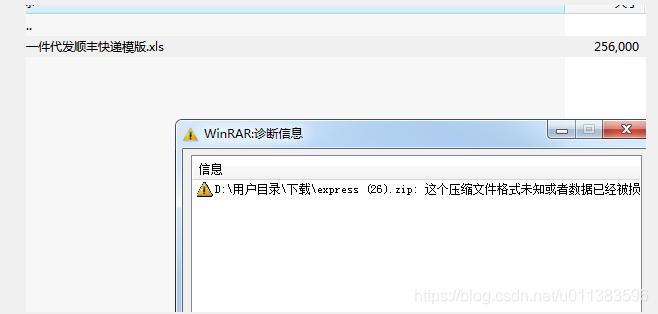

今天正常的导压缩文件,发现一个问题,当数量据大点时,比如我的表有25万个字时,就提示我解压失败

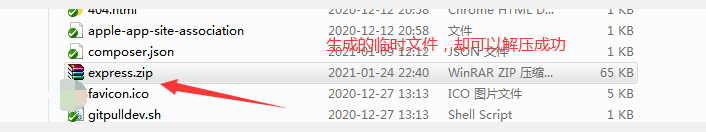

后来我慢慢排查,我把删除临时文件的代码注释掉,让程序生成临时文件。

发现,临时文件只有65kb,且是可以解压力成功的。(浏览器下载同一个zip包有211kb)

后来我又百度许久,网上都说需要加

ob_clean();

flush();以便把缓存区的数据,制刷到浏览器,但我代码里也加了

后来我去百度了下php的缓存机制(以下这段,摘至网上)

buffer是一个内存地址空间,Linux系统默认大小一般为4096(1kb),即一个内存页。主要用于存储速度不同步的设备或者优先级不同的 设备之间传办理数据的区域。通过buffer,可以使进程这间的相互等待变少。这里说一个通俗一点的例子,你打开文本编辑器编辑一个文件的时候,你每输入 一个字符,操作系统并不会立即把这个字符直接写入到磁盘,而是先写入到buffer,当写满了一个buffer的时候,才会把buffer中的数据写入磁 盘,当然当调用内核函数flush()的时候,强制要求把buffer中的脏数据写回磁盘。

同样的道理,当执行echo,print的时候,输出并没有立即通过tcp传给客户端浏览器显示, 而是将数据写入php buffer。php output_buffering机制,意味在tcp buffer之前,建立了一新的队列,数据必须经过该队列。当一个php buffer写满的时候,脚本进程会将php buffer中的输出数据交给系统内核交由tcp传给浏览器显示。所以,数据会依次写到这几个地方echo/print -> php buffer -> tcp buffer -> browser

所以到这,问题可能已经明朗:程序生成的临时文件可以解压,浏览器下载的不行,应该是浏览器下载文件时,还跟着有缓存数据,这种在较大的文件,可能比较明显。

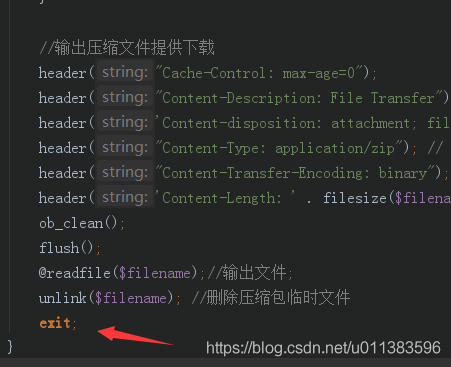

所以怎么解决呢?程序结束时,加个exit;

好了,导出解压成功了。