随着人工智能技术的发展,聊天机器人已经成为了我们生活中的一部分。无论是在客服机器人上还是智能助手上,聊天机器人都能够给我们带来真正的便利和快乐。现在,你也可以轻松搭建自己的ChatGPT聊天机器人,和它天马行空地聊天!

第一步:准备所需材料

首先,你需要一些基本的技术知识和一些必备的软件工具,包括:

-

Python基本语法:ChatGPT是使用Python开发的,因此你需要先掌握一些基本的Python语法。

-

PyTorch:ChatGPT是使用PyTorch构建的,因此在搭建ChatGPT之前,你需要先了解PyTorch的基本使用方法。

-

Transformers库:这是一个用于自然语言处理的Python库,可以帮助我们轻松地搭建和训练ChatGPT模型。

第二步:搭建ChatGPT模型

现在你已经准备好了所有必要的软件工具,那么就让我们开始搭建ChatGPT模型吧!

以下是一个简单的示例代码,可以使用Transformers和PyTorch搭建ChatGPT模型:

import torch

from transformers import GPT2Tokenizer, GPT2LMHeadModel# 加载预训练模型和分词器

tokenizer = GPT2Tokenizer.from_pretrained('gpt2')

model = GPT2LMHeadModel.from_pretrained('gpt2')# 输入文本

text = 'Hello, how are you?'# 将文本编码为ID

input_ids = tokenizer.encode(text, return_tensors='pt')# 生成响应

output = model.generate(input_ids, max_length=1000)# 将响应解码为文本

output_text = tokenizer.decode(output[0], skip_special_tokens=True)

print(output_text)

这段代码使用了GPT2模型和分词器,从输入文本中生成了一个1000个字符的响应。

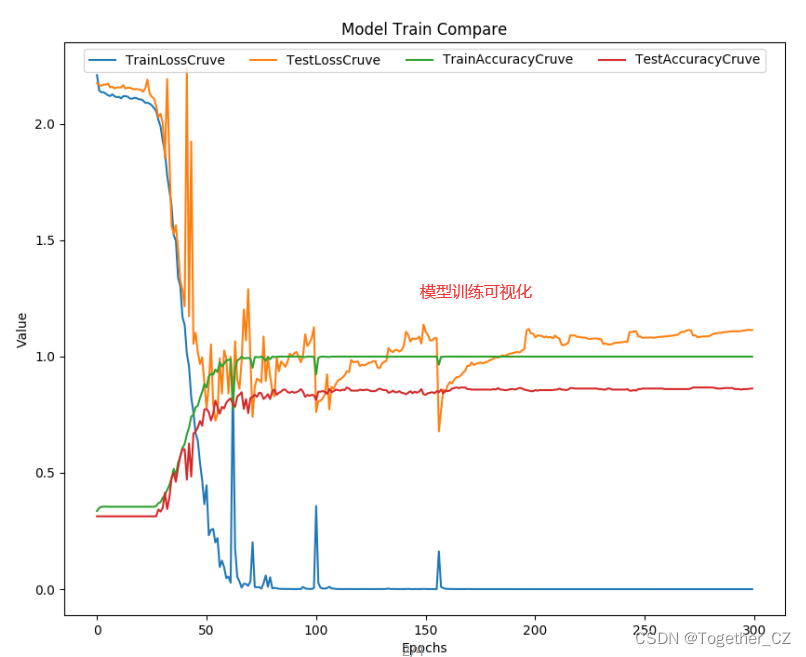

第三步:训练ChatGPT模型

如果你想让你的ChatGPT模型可以更加智能和对话更加流畅,那么你需要利用机器学习的方法对模型进行训练。

以下是一个简单的示例代码,可以使用Transformers和PyTorch训练ChatGPT模型:

import torch

from transformers import GPT2Tokenizer, GPT2LMHeadModel, TextDataset, DataCollatorForLanguageModeling, Trainer, TrainingArguments# 加载预训练模型和分词器

tokenizer = GPT2Tokenizer.from_pretrained('gpt2')

model = GPT2LMHeadModel.from_pretrained('gpt2')# 加载数据集

dataset = TextDataset(tokenizer=tokenizer, file_path='data.txt', block_size=128)# 设置训练参数

training_args = TrainingArguments(output_dir='./results', # output directoryoverwrite_output_dir=True, # overwrite the content of the output directorynum_train_epochs=1, # number of training epochsper_device_train_batch_size=32, # batch size for trainingsave_steps=1000, # save checkpoint every 1000 stepssave_total_limit=2, # only keep last 2 checkpointswarmup_steps=500, # number of warmup steps for learning rate schedulerweight_decay=0.01, # strength of weight decaylogging_dir='./logs', # directory for storing logslogging_steps=1000, # log every 1000 steps)# 设置DataCollator

data_collator = DataCollatorForLanguageModeling(tokenizer=tokenizer, mlm=False,

)# 构建Trainer

trainer = Trainer(model=model,args=training_args,data_collator=data_collator,train_dataset=dataset,

)# 开始训练

trainer.train()

这段代码使用了TextDataset和DataCollatorForLanguageModeling来读取和处理数据集,使用GPT2模型和分词器训练ChatGPT模型,并将结果保存在results目录中。

第四步:让ChatGPT机器人和你聊天

现在你已经成功搭建和训练了自己的ChatGPT机器人了!那么让我们来看看如何和它进行聊天。

以下是一个简单的示例代码,可以使用训练好的ChatGPT机器人进行聊天:

import torch

from transformers import GPT2Tokenizer, GPT2LMHeadModel# 加载训练好的模型和分词器

tokenizer = GPT2Tokenizer.from_pretrained('results')

model = GPT2LMHeadModel.from_pretrained('results')# 开始聊天

while True:# 获取用户输入user_input = input('You: ')# 将用户输入编码为IDinput_ids = tokenizer.encode(user_input, return_tensors='pt')# 生成响应output = model.generate(input_ids, max_length=1000)# 将响应解码为文本output_text = tokenizer.decode(output[0], skip_special_tokens=True)# 输出机器人的响应print('ChatGPT: ' + output_text)

这段代码使用了训练好的模型和分词器,可以和ChatGPT机器人进行聊天交流!

结语

通过这份资料,你已经学会了如何搭建、训练和使用ChatGPT聊天机器人了!希望这份资料能够帮助你打造出一款智能、有趣的聊天机器人,让你的生活充满更多色彩!