1、什么是GPU加速计算

GPU,又称显示核心、视觉处理器、显示芯片,是一种专门在个人电脑、工作站、游戏机和一些移动设备(如平板电脑、智能手机等)上图像运算工作的微处理器,与CPU类似,只不过GPU是专为执行复杂的数学和几何计算而设计的,这些计算是图形渲染所必需的。随着人工智能的发展,如今的GPU已经不再局限于3D图形处理了。GPU 加速计算是指同时利用图形处理器 (GPU) 和 CPU,加快科学、分析、工程、消费和企业应用程序的运行速度。GPU 加速器于 2007 年由 NVIDIA® 率先推出,现已在世界各地为政府实验室、高校、公司以及中小型企业的高能效数据中心提供支持。GPU 能够使从汽车、手机和平板电脑到无人机和机器人等平台的应用程序加速运行。

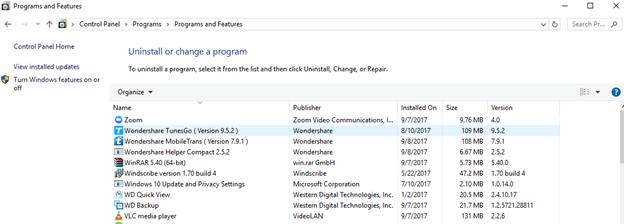

2、GPU与CPU的性能比较

理解 GPU 和 CPU 之间区别的一种简单方式是比较它们如何处理任务。CPU 由专为顺序串行处理而优化的几个核心组成,而 GPU 则拥有一个由数以千计的更小、更高效的核心(专为同时处理多重任务而设计)组成的大规模并行计算架构。

GPU的特点是有大量的核(多达几千个核)和大量的高速内存,最初被设计用于游戏,计算机图像处理等。GPU主要擅长做类似图像处理的并行计算,所谓的“粗粒度并行(coarse-grainparallelism)”。这个对于图像处理很适用,因为像素与像素之间相对独立,GPU提供大量的核,可以同时对很多像素进行并行处理。但这并不能带来延迟的提升(而仅仅是处理吞吐量的提升)。比如,当一个消息到达时,虽然GPU有很多的核,但只能有其中一个核被用来处理当前这个消息,而且GPU核通常被设计为支持与图像处理相关的运算,不如CPU通用。GPU主要适用于在数据层呈现很高的并行特性(data-parallelism)的应用,比如GPU比较适合用于类似蒙特卡罗模拟这样的并行运算。

CPU和GPU本身架构方式和运算目的不同导致了CPU和GPU之间的不同,主要不同点列举如下。

更形象点的说法是:

现在全班要去春游,你有一辆保时捷和一辆大巴:保时捷只有四个座位,但半个小时就到了;大巴有50个座位,但要一个多小时。为了让全班尽早过去,大巴一定是首选。从计算的角度看,各位的CPU就是保时捷,GPU就是大巴。GPU每个核心都很弱,但众多的核心还是让GPU在并行计算上拥有了相当的优势。另外一点,GPU有相当的价格优势。单纯从浮点数计算能力来看,不到300块的GT430(91.564G)已经接近于一两千块的i7(107.6G)。

3、如何部署 GPU 加速应用

理解 CPU 与 GPU 之间区别的一种简单方式就是对比它们如何处理任务。 CPU 由专为顺序串行处理而优化的几个核心组成。另一方面,GPU 则由数以千计的更小、更高效的核心组成,这些核心专为同时处理多任务而设计。

4、CPU 对阵 GPU

理解 CPU 与 GPU 之间区别的一种简单方式就是对比它们如何处理任务。 CPU 由专为顺序串行处理而优化的几个核心组成。另一方面,GPU 则由数以千计的更小、更高效的核心组成,这些核心专为同时处理多任务而设计。

GPU 拥有数以千计的核心,可高效地处理并行任务、

5、GPU的优势

上面已经介绍的很详细。因为GPU的特点特别适合于大规模并行运算,GPU在“深度学习”领域发挥着巨大的作用,因为GPU可以平行处理大量琐碎信息。深度学习所依赖的是神经系统网络——与人类大脑神经高度相似的网络——而这种网络出现的目的,就是要在高速的状态下分析海量的数据。例如,如果你想要教会这种网络如何识别出猫的模样,你就要给它提供无数多的猫的图片。而这种工作,正是GPU芯片所擅长的事情。而且相比于CPU,GPU的另一大优势,就是它对能源的需求远远低于CPU。GPU擅长的是海量数据的快速处理。

将GPU加速器用于机器学习的早期用户包括诸多规模的网络和社交媒体公司,另外还有数据科学和机器学习领域中一流的研究机构。与单纯使用CPU的做法相比,GPU具有数以千计的计算核心、可实现10-100倍应用吞吐量,因此GPU已经成为数据科学家处理大数据的处理器。

6、GPU的劣势

简单地讲,不是所有运算都可以并行化,其实这也是并行计算的弱势。但几乎所有矩阵运算都有并行化的可能,所以Machine Learning的很多方法移植到GPU还是相当有搞头的。

7、现状与趋势

工业与学术界的数据科学家已将GPU用于机器学习以便在各种应用上实现开创性的改进,这些应用包括图像分类、视频分析、语音识别以及自然语言处理等等。尤其是深度学习,人们在这一领域中一直进行大力投资和研究。深度学习是利用复杂的多级「深度」神经网络来打造一些系统,这些系统能够从海量的未标记训练数据中进行特征检测。

虽然机器学习已经有数十年的历史,但是两个较为新近的趋势促进了机器学习的广泛应用:海量训练数据的出现以及GPU计算所提供的强大而高效的并行计算。人们利用GPU来训练这些深度神经网络,所使用的训练集大得多,所耗费的时间大幅缩短,占用的数据中心基础设施也少得多。GPU还被用于运行这些机器学习训练模型,以便在云端进行分类和预测,从而在耗费功率更低、占用基础设施更少的情况下能够支持远比从前更大的数据量和吞吐量。

目前大量的开发语言如R、Python等的机器学习/深度学习框架和包都支持GPU,比如,TensorFlow,Theano,scikit-learn 等等