来源:投稿 作者:小灰灰

编辑:学姐

论文标题:

Real-World Automatic Makeup via Identity Preservation Makeup Net

论文链接:https://www.ijcai.org/proceedings/2020/0091.pdf

论文代码:https://github.com/huangzhikun1995/IPM-Net

社交网络的不断发展也让人们对美颜技术提出了更高的要求,在完成图像美化的同时保证图像的真实性是至关重要的。

本文重点研究现实世界的自动化妆问题。给定一张非化妆目标图像和一张参考图像,自动化妆是生成一张人脸图像,它与参考图像中的化妆风格保持原始身份。在现实世界的场景中,面部化妆任务需要一个强大的系统来应对环境变化。

现实世界中人脸化妆的两个主要挑战可以概括如下:

首先,现实世界图像中的背景很复杂。以前的方法也容易改变背景的风格;

其次,前景面也容易受到影响。例如,“浓妆”可能会丢失原始身份的区分信息。

最后评价指标的缺失。对于化妆效果的好坏还是依靠志愿者的主观判断,缺少客观的量化指标。

为了解决这个挑战,我们引入了一种新的化妆模型,称为身份保护化妆网络(IPM-Net),它不仅保留了背景,而且保留了原始身份的关键模式。具体来说,我们将人脸图像分解为两个不同的信息代码,即身份内容代码和化妆风格代码。

在推理的时候,我们只需要修改妆容代码,就可以生成目标人物的各种妆容。作者从现实世界需求出发,探索了完成人脸自动上妆同时保留图像的真实性的方法,同时提出了使用FID以及LPIPS来量化人脸自动上妆的效果。

本文的创新点

1、我们提出了一种新的自动化妆模型,称为Identity 。Preservation Makeup Net (IPM-Net), 为了解决现实世界中自动化妆的两个问题任务。我们的方法有效地转移了化妆风格将参考图像转换为目标图像,同时保留研究的背景和关键模式原始身份。

2、该方法能在较短的推理时间内实现可控的化妆转移,我们的模型每秒可以处理 16 张 256*256 的人脸图像。。它使我们的模型更接近现实世界的实践

3、作为一个小贡献,我们介绍了FID和SSIM对于化妆的真实性和多样性进行评价。我们的该方法在这两方面都优于其他竞争性方法定性和定量结果。

网络结构

2.1 图像预处理

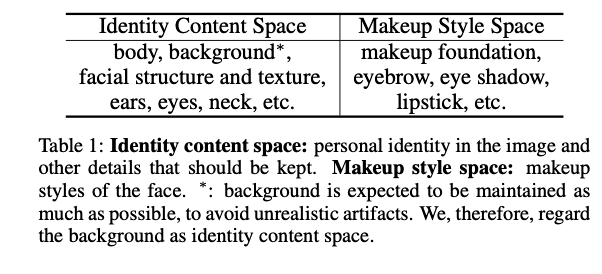

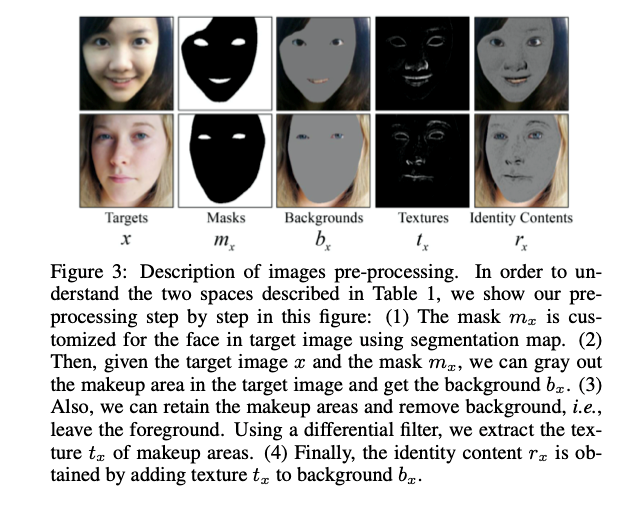

我们注意到,自动化妆的目的只是改变目标图像的几个部分,同时保留大多数身份内容信息。因此,我们建议首先将面部图像分解为两个空间(见表1)。身份内容空间包含图像中的个人身份信息和其他应保留的详细信息。化妆风格空间是学习脸上的化妆风格。为了帮助两种不同的特征提取,我们对输入图像进行了预处理。

具体来说,我们为每个人脸定制了一个面具和一个细粒度纹理。

预处理结果如图3所示。给定一个输入图像x,我们通过四个步骤生成输入图像rx中的身份内容:

(1)我们首先通过人脸解析算[1]法获取mask,

(2) 为了保留背景,我们将目标图像x和相应的掩码mx相乘,得到背景图像bx。我们进一步将化妆区域设置为灰色,但bx会丢失面部纹理信息。

(3) 因此,我们使用微分滤波器[2]提取化妆区域的纹理,该滤波器仅保留必要的纹理并滤除噪声信号。此外,我们还增加了面部特征纹理的权重,以突出面部特征的纹理tx。

(4) 最后,通过添加纹理tx和bx背景来生成身份内容输入图像rx。

2.2框架

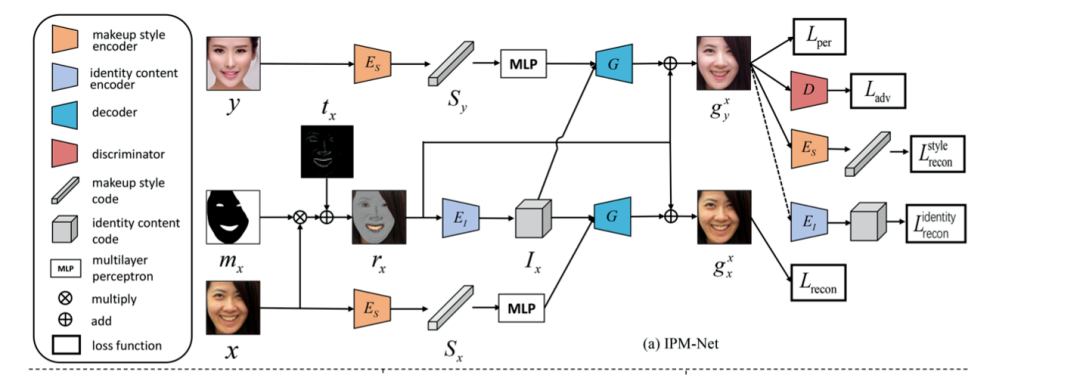

给定目标图像X和相应的遮罩mx和纹理tx,通过图3中描述的预处理步骤生成身份内容输入图像rx。如图2(a)所示,引入身份内容编码器Ei和化妆风格编码器Es以将面部图像分离为两个不同的代码:

2.3 网络细节

我们的IPM网络使用Pytorch框架。我们还使用PaddlePaddle来实现我们的方法,并达到类似的性能。我们所有的实验都是在一个NVIDIAGTX2080TiGPU上进行的。我们应用两种基本块,即ConvBlock和ResBlock。ConvBlock包含卷积、批量标准化和ReLU激活层。ResBlock包含两个ConvBlock,但我们删除了最后一个激活层。我们在图2(a)中的网络结构是基于这两个块构建的:

(1)Ei由三个ConvBlock和一个ResBlock组成,以256×64×64的格式输出身份内容代码Ix。

(2) Es使用三个ConvBlock和三个ResBlock的组合,而在最后添加一个平均池层。目标图像和参考图像都共享ES,每种化妆风格都由一个128维的矢量表示。

(3)G采用ConvBlocks,并利用Adam 融合身份内容和化妆风格。进一步利用上采样层将图像重新缩放为输入图像形状。此外,rx被添加到G生成的图像中,作为剩余连接。

(4) D遵循多尺度鉴别器架构。在训练阶段,每个图像的大小调整为321×321,然后随机裁剪为256×256。随机水平翻转被用作简单的数据扩充。我们采用Adam对整个IPM网络进行优化,λ1=0.5,λ2=0.999,并将学习率设置为0.0001。我们训练我们的模型进行1000000次迭代,批量大小设置为3。

实验结果

3.1 定性结果

实验结果均在在 Makeup Dataset以及采集自网络的图像进行测试。

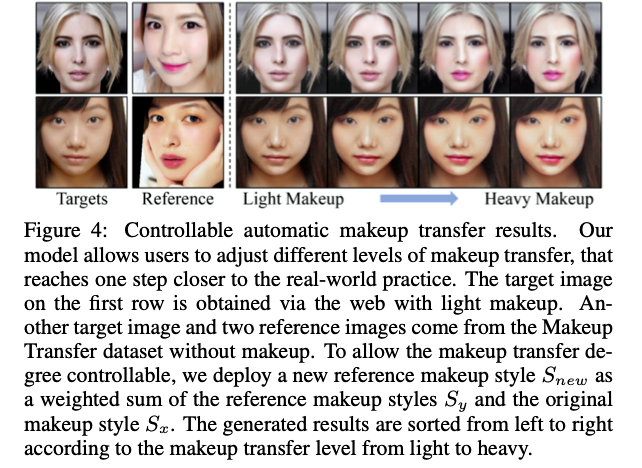

我们的模型允许用户调整不同层次的化妆转移,这更接近现实世界的实践。第一行上的目标图像是通过带有淡妆的网络获得的。另一张目标图像和两张参考图像来自化妆传输数据集,无需化妆。为了使化妆转换的程度可控,我们部署了一个新的参考化妆风格Snew,作为参考化妆风格Sy和原始化妆风格Sx的加权和。生成的结果根据化妆转移级别从轻到重从左到右排序。

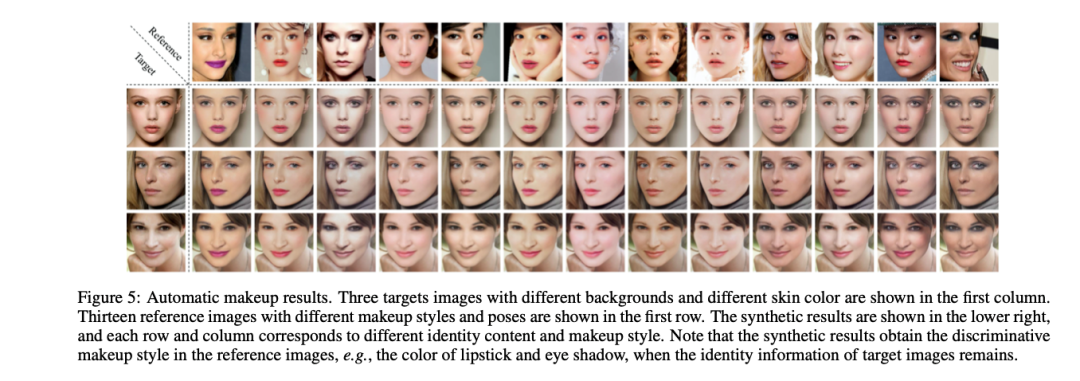

下图是自动补妆结果。第一列显示了三个具有不同背景和不同肤色的目标图像。第一行显示了13张不同化妆风格和姿势的参考图片。合成结果显示在右下角,每一行和每一列对应不同的身份内容和化妆风格。当目标图像的身份信息保留时,合成结果获得参考图像中的鉴别化妆风格,例如唇膏和眼影的颜色。

3.2 定量结果

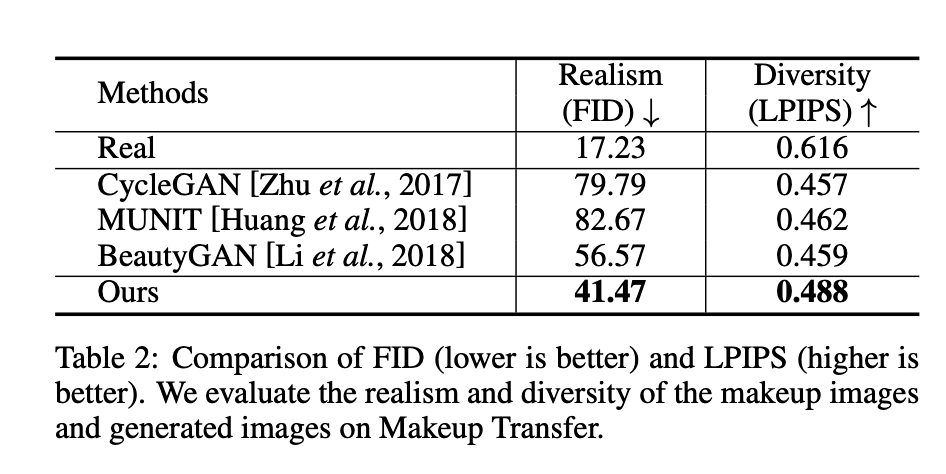

如下表可见:FID(越低越好)和LPIP(越高越好)的比较。我们评估了化妆图像的真实性和多样性,以及化妆转移时生成的图像。

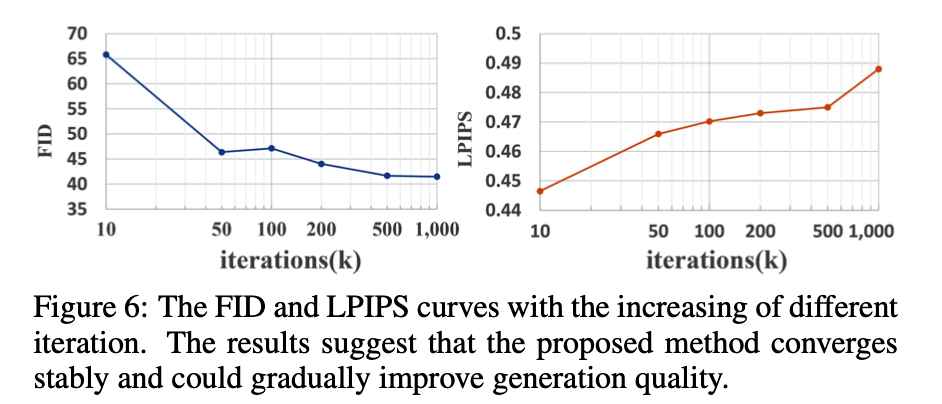

FID[4]和LPIPS[5] 曲线随不同迭代次数的增加而增加。结果表明,该方法收敛稳定,能逐步提高图像质量。

参考文献

[1] Changqian Yu, Jingbo Wang, Chao Peng, Changxin Gao, Gang Yu, and Nong Sang. Bisenet: Bilateral segmentation network for real-time semantic segmentation. In ECCV, 2018.

[2] Yifei Pu, Weixing Wang, Jiliu Zhou, Yiyang Wang, and Huading Jia. Fractional differential approach to de- tecting textural features of digital image and its fractional differ- ential filter implementation. Science in China Series F: Informa- tion Sciences, 51(9):1319–1339, 2008.

[3] Wei-Sheng Lai, Jia-Bin Huang, Narendra Ahuja, and Ming-Hsuan Yang. Fast and accurate image super-resolution with deep laplacian pyramid networks. TPAMI, 2018.

[4] Martin Heusel, Hubert Ramsauer, Thomas Unterthiner, Bernhard Nessler, and Sepp Hochreiter. Gans trained by a two time-scale update rule converge to a local nash equilibrium. In NeurlPS, 2017.

[5] Changqian Yu, Jingbo Wang, Chao Peng, Changxin Gao, Gang Yu, and Nong Sang. Bisenet: Bilateral segmentation network for real-time semantic segmentation. In ECCV, 2018.

关注下方《学姐带你玩AI》🚀🚀🚀

回复“CVPR”获取CV方向顶会必读论文

码字不易,欢迎大家点赞评论收藏!