数理统计期末复习笔记

主要内容:

数据压缩,点估计,假设检验,区间检验

Reference: Statistical Inference, Casella&Berger

Chapter 6 Data Reduction(数据压缩)

随机样本:

-

无限样本:X1,...,Xn∼iidf(x∣θ),f(x⃗∣θ)=∏i=1nf(xi∣θ)X_1,...,X_n\stackrel{iid}\sim f(x|\theta), f(\vec{x}|\theta)=\prod_{i=1}^n f(x_i|\theta)X1,...,Xn∼iidf(x∣θ),f(x∣θ)=∏i=1nf(xi∣θ)

-

有限样本:有放回:仍为独立同分布;无放回:边缘分布相同

统计量:

- 关于样本X1,...,XnX_1,...,X_nX1,...,Xn的函数T(X1,...,Xn)T(X_1,...,X_n)T(X1,...,Xn):用来重定向参数θ\thetaθ的若干性质

- eg:样本均值:X‾=X1+....+Xnn\overline{X}=\frac{X_1+....+X_n}{n}X=nX1+....+Xn,样本方差:S2=∑i=1n(Xi−X‾)2n−1S^2=\frac{\sum_{i=1}^n (X_i-\overline{X})^2}{n-1}S2=n−1∑i=1n(Xi−X)2,分母为n-1是因为此时是σ2\sigma^2σ2的无偏估计

充分统计量:

-

统计量T(X1,...,Xn)T(X_1,...,X_n)T(X1,...,Xn)是充分统计量当且仅当P(x1,...,xn∣T(x1,...,xn)=t,θ)=P(x1,...,xn∣T(x1,...,xn)=t)P(x_1,...,x_n|T(x_1,...,x_n)=t,\theta)=P(x_1,...,x_n|T(x_1,...,x_n)=t)P(x1,...,xn∣T(x1,...,xn)=t,θ)=P(x1,...,xn∣T(x1,...,xn)=t)

-

本质:将(X1,...,Xn)(X_1,...,X_n)(X1,...,Xn)的空间根据TTT的值作划分

-

判定:T(X1,...,Xn)T(X_1,...,X_n)T(X1,...,Xn)是充分统计量当且仅当存在函数g,h:p(x1,...,xn∣θ)=h(x1,...,xn)g(T(x1,...,xn)∣θ)g,h: p(x_1,...,x_n|\theta)=h(x_1,...,x_n)g(T(x_1,...,x_n)|\theta)g,h:p(x1,...,xn∣θ)=h(x1,...,xn)g(T(x1,...,xn)∣θ)(密度函数分离)

最小充分统计量:

-

统计量T(X1,...,Xn)T(X_1,...,X_n)T(X1,...,Xn)是最小充分统计量当且仅当其为充分统计量,且任意充分统计量UUU,T=g(U)T=g(U)T=g(U)

-

本质:TTT的值决定空间的最大可能分划

-

判定:T(X1,...,Xn)T(X_1,...,X_n)T(X1,...,Xn)是最小充分统计量当且仅当仅当R(x,y∣θ)=p(y1,...,yn∣θ)p(x1,...,xn∣θ)R(x,y|\theta)=\frac{p(y_1,...,y_n|\theta)}{p(x_1,...,x_n|\theta)}R(x,y∣θ)=p(x1,...,xn∣θ)p(y1,...,yn∣θ)当且仅当T(x)=T(y)T(x)=T(y)T(x)=T(y)时与θ\thetaθ独立

完全统计量:

-

对于分布族p(x1,...,xn∣θ),θ∈Θp(x_1,...,x_n|\theta),\theta\in \Thetap(x1,...,xn∣θ),θ∈Θ,统计量T(X1,...,Xn)T(X_1,...,X_n)T(X1,...,Xn)是完全统计量当且仅当对任意ggg,若Eθ(g(T))=0,∀θE_\theta(g(T))=0,\forall \thetaEθ(g(T))=0,∀θ,则g=0a.e.g=0 \quad a.e.g=0a.e. 注:$E_\theta f(x,\theta)=\int f(x,\theta) p(x|\theta)dx $

-

判定:

- 是:证明∫g(T(x1,...,xn))p(x1,...,xn∣θ)=0⇒g=0a.e.\int g(T(x_1,...,x_n))p(x_1,...,x_n|\theta)=0\Rightarrow g=0 \quad a.e.∫g(T(x1,...,xn))p(x1,...,xn∣θ)=0⇒g=0a.e.

- 否:构造函数g≠0g\neq0g=0,但是Eθg(T)=0,∀θE_\theta g(T)=0,\forall \thetaEθg(T)=0,∀θ;一般来说定义域与θ\thetaθ相关的函数没有完全充分统计量

-

性质:完全统计量必定是充分统计量;完全统计量和最小充分统计量无关;但是在指数组分布中,完全统计量必定是最小充分统计量

辅助统计量:

- 统计量S(x1,...,xn)S(x_1,...,x_n)S(x1,...,xn)是辅助统计量当且仅当SSS与θ\thetaθ独立

- 性质:Basu定理:任何完全统计量和辅助统计量独立

Chapter 7 Point Estimation(点估计)

估计:给定采样X1,...,XnX_1,...,X_nX1,...,Xn,利用其估计参数θ\thetaθ

矩估计

对θ=(θ1,...,θk)\theta=(\theta_1,...,\theta_k)θ=(θ1,...,θk),求解方程组:

{μ1(θ)=E(X)=X1+...+Xnnμ2(θ)=E(X2)=X12+...+Xn2n...μk(θ)=E(Xk)=X1k+...+Xnkn\left\{\begin{aligned} &\mu_1(\theta)=E(X)=\frac{X_1+...+X_n}{n} \\ &\mu_2(\theta)=E(X^2)=\frac{X_1^2+...+X_n^2}{n} \\ &...\\ &\mu_k(\theta)=E(X^k)=\frac{X_1^k+...+X_n^k}{n} \\ \end{aligned}\right. ⎩⎨⎧μ1(θ)=E(X)=nX1+...+Xnμ2(θ)=E(X2)=nX12+...+Xn2...μk(θ)=E(Xk)=nX1k+...+Xnk

得到对(θ1,...,θk)(\theta_1,...,\theta_k)(θ1,...,θk)的矩估计(θ^1,...,θ^k)(\hat{\theta}_1,...,\hat{\theta}_k)(θ^1,...,θ^k).

优点:计算方便

缺点:渐近性质不好,结果可能在定义域Θk\Theta_kΘk以外

极大似然估计

基本概念:

-

似然函数:L(θ∣x)=p(x1,...,xn∣θ)=∏i=1np(xi∣θ)L(\theta|x)=p(x_1,...,x_n|\theta)=\prod_{i=1}^n p(x_i|\theta)L(θ∣x)=p(x1,...,xn∣θ)=∏i=1np(xi∣θ);对数似然函数:I(θ∣x)=logp(x1,...,xn∣θ)=∑i=1nlogp(xi∣θ)I(\theta|x)=\log p(x_1,...,x_n|\theta)=\sum_{i=1}^n\log p(x_i|\theta)I(θ∣x)=logp(x1,...,xn∣θ)=∑i=1nlogp(xi∣θ)

-

定义:θ^=argmaxθ∈ΘL(θ∣x)\hat{\theta}=\operatorname{argmax}_{\theta\in \Theta} L(\theta|x)θ^=argmaxθ∈ΘL(θ∣x)

验证:

- 必要条件:∂L∂θ=0,∂L∂θ2⪯0\frac{\partial L}{\partial \theta} =0, \frac{\partial L}{\partial \theta^2}\preceq 0∂θ∂L=0,∂θ2∂L⪯0 semi negative definite并且小于等于函数的边界值

- 证明:c≥I(θ∣x)c\geq I(\theta|x)c≥I(θ∣x)并且取等当且仅当θ=θ^\theta=\hat{\theta}θ=θ^

- 在离散参数中间中,可以计算相邻比值L(k+1∣x)/L(k∣x)L(k+1|x)/L(k|x)L(k+1∣x)/L(k∣x)判断大小

性质:

-

不变性:如果θ\thetaθ的最大似然估计是θ^\hat{\theta}θ^,那么μ=g(θ)\mu=g(\theta)μ=g(θ)的最大似然估计就是μ^=g(θ^)\hat{\mu}=g(\hat{\theta})μ^=g(θ^)

-

对于θ\thetaθ的任意估计W(x1,...,xn)W(x_1,...,x_n)W(x1,...,xn),如果∂∂θEθW(x)=∫W(x)∂∂θf(x∣θ)dx\frac{\partial}{\partial \theta}E_\theta W(x)=\int W(x)\frac{\partial}{\partial \theta} f(x|\theta) dx∂θ∂EθW(x)=∫W(x)∂θ∂f(x∣θ)dx

-

Var(W(x))≥(∂∂θEθW(x))2Eθ((∂∂θlogf(x∣θ))2)Var(W(x))\geq \frac{(\frac{\partial}{\partial \theta} E_\theta W(x))^2}{E_\theta ((\frac{\partial}{\partial \theta}\log f(x|\theta))^2)} Var(W(x))≥Eθ((∂θ∂logf(x∣θ))2)(∂θ∂EθW(x))2

分母=nEθ((∂∂θlogp(x∣θ))2)=nE_\theta ((\frac{\partial}{\partial \theta}\log p(x|\theta))^2)=nEθ((∂θ∂logp(x∣θ))2)=Fisher Information

- Fisher Information Matrix In(θ)\mathcal{I}_n(\theta)In(θ):描述XXX为刻画θ\thetaθ带来的信息量大小的矩阵;当θ\thetaθ为k维时是k×kk\times kk×k的矩阵,这里的分母是1维的情况:

[In(θ)]i,j=Eθ[(∂∂θilogf(X;θ))(∂∂θjlogf(X;θ))][\mathcal{I}_n(\theta)]_{i, j}=\mathrm{E}_{\theta}\left[\left(\frac{\partial}{\partial \theta_i} \log f(X ; \theta)\right)\left(\frac{\partial}{\partial \theta_j} \log f(X ; \theta)\right) \right] [In(θ)]i,j=Eθ[(∂θi∂logf(X;θ))(∂θj∂logf(X;θ))]

-

特别的,如果WWW无偏,则Var(W)≥1nEθ((∂∂θlogp(x∣θ))2)Var(W)\geq \frac{1}{nE_\theta ((\frac{\partial}{\partial \theta}\log p(x|\theta))^2)}Var(W)≥nEθ((∂θ∂logp(x∣θ))2)1为定值

-

对于指数组分布,有∂∂θEθ(∂∂θlogp(x∣θ)=∫∂∂θ(∂∂θlogp(x∣θ)p(x∣θ))dx\frac{\partial}{\partial \theta} E_\theta (\frac{\partial}{\partial \theta} \log p(x|\theta)=\int \frac{\partial}{\partial\theta}(\frac{\partial}{\partial \theta} \log p(x|\theta) p(x|\theta))dx∂θ∂Eθ(∂θ∂logp(x∣θ)=∫∂θ∂(∂θ∂logp(x∣θ)p(x∣θ))dx,从而

Eθ((∂∂θlogp(x∣θ))2=−Eθ(∂2∂θ2logp(x∣θ))E_\theta ((\frac{\partial}{\partial \theta}\log p(x|\theta))^2=-E_\theta (\frac{\partial^2}{\partial \theta^2}\log p(x|\theta)) Eθ((∂θ∂logp(x∣θ))2=−Eθ(∂θ2∂2logp(x∣θ))

,以及:In(θ)=−E(∂2I(θ)∂θr∂θs)\mathcal{I}_n(\theta)=-E(\frac{\partial^2 I(\theta)}{\partial \theta_r\partial \theta_s})In(θ)=−E(∂θr∂θs∂2I(θ)) -

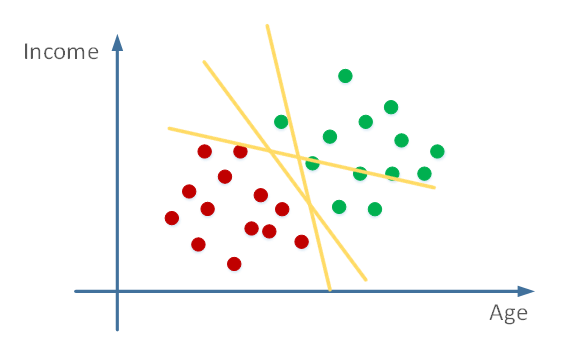

MSE=Eθ(θ^−θ)2=B2+VMSE=E_\theta(\hat{\theta}-\theta)^2=B^2+VMSE=Eθ(θ^−θ)2=B2+V: V=Varθ(θ^),B=Eθ(θ^)−θV=Var_\theta(\hat{\theta}), B=E_\theta(\hat{\theta})-\thetaV=Varθ(θ^),B=Eθ(θ^)−θ

因此,在偏差BBB和方差VVV之间必然有tradeoff

-

渐近性:

-

正规化条件:

- 分布PθP_\thetaPθ有共同的支集

- 参数空间Θ\ThetaΘ包含一个Rk\mathbb{R}^kRk中的开集

- θ^\hat{\theta}θ^是唯一使得∂∂θI(θ∣x)=0\frac{\partial}{\partial\theta}I(\theta|x)=0∂θ∂I(θ∣x)=0的θ\thetaθ

-

一致性:θ→pθ0\theta\stackrel{p}\rightarrow \theta_0θ→pθ0

-

渐近正态性:n(θ^−θ0)→dN(0,1I(θ))\sqrt{n}(\hat{\theta}-\theta_0)\stackrel{d}\rightarrow N(0,\frac{1}{I(\theta)})n(θ^−θ0)→dN(0,I(θ)1),I(θ)I(\theta)I(θ)就是In(θ)n\frac{\mathcal{I}_n(\theta)}{n}nIn(θ),即Eθ((∂∂θlogp(x∣θ))2)E_\theta ((\frac{\partial}{\partial \theta}\log p(x|\theta))^2)Eθ((∂θ∂logp(x∣θ))2),所以也可以写成(θ^−θ0)→dN(0,1In(θ))(\hat{\theta}-\theta_0)\stackrel{d}\rightarrow N(0,\frac{1}{I_n(\theta)})(θ^−θ0)→dN(0,In(θ)1)

推论:(Delta Method)n(γ(θ^)−γ(θ0))→dN(0,γ′(θ)2I(θ))\sqrt{n}(\gamma(\hat{\theta})-\gamma(\theta_0))\stackrel{d}\rightarrow N(0,\frac{\gamma'(\theta)^2}{I(\theta)})n(γ(θ^)−γ(θ0))→dN(0,I(θ)γ′(θ)2)

-

渐近有效性:样本数量充分大时,θ^\hat{\theta}θ^是无偏估计中方差最小的

Best Unbiased Estimator最佳无偏估计

对于t(θ)t(\theta)t(θ)的估计WWW,如果∀θ,EθW=t(θ)\forall \theta, E_\theta W=t(\theta)∀θ,EθW=t(θ),则称其无偏;如果WWW无偏,且对任意其它无偏估计W′W'W′,Varθ(W′)≥Varθ(W),∀θVar_\theta(W')\geq Var_\theta(W),\forall \thetaVarθ(W′)≥Varθ(W),∀θ,则称WWW为最佳无偏估计量

性质:

最佳无偏估计量不一定存在,但是若存在则唯一

判定:

-

WWW是最佳无偏估计当且仅当其与任意其它无偏估计不相关:cor(W,W′)=0cor(W,W')=0cor(W,W′)=0

-

证明WWW不是最佳无偏估计:给出一个和WWW相关的无偏估计

-

给出一个无偏估计:取XXX的一个完全统计量TTT,则:

- TTT的任意一个函数ϕ(T)\phi(T)ϕ(T)都是Eθϕ(T)E_\theta\phi(T)Eθϕ(T)的无偏估计

- 任意h(x1,...,xn)h(x_1,...,x_n)h(x1,...,xn)若为t(θ)t(\theta)t(θ)的一个无偏估计,则ϕ(T)=E(h(x1,...,xn)∣T)\phi(T)=E(h(x_1,...,x_n)|T)ϕ(T)=E(h(x1,...,xn)∣T)是t(θ)t(\theta)t(θ)的无偏估计

Chapter 7 假设检验

基本定义

-

通过样本反推参数θ\thetaθ是否满足属于某个集合Θ0\Theta_0Θ0:

零假设H0H_0H0:θ∈θ0\theta\in \theta_0θ∈θ0;否则:H1H_1H1: θ∈Θ1=Θ/Θ0\theta\in \Theta_1=\Theta/\Theta_0θ∈Θ1=Θ/Θ0. 设定一个判定规则:输入XXX,输出接收/拒绝

如果样本X是由θ∈Θ0\theta\in \Theta_0θ∈Θ0生成的,则本应接收。如果拒绝了,则造成第一类错误(假阳性)

如果样本X是由θ∈Θ1\theta\in \Theta_1θ∈Θ1生成的,则本应拒绝。如果接收了,则造成第二类错误(假阴性)

-

假设判定规则定义了拒绝区域RRR,拒绝H0H_0H0当且仅当T(X)∈RT(X)\in RT(X)∈R,则:

权函数β(θ)=Pθ(T(X)∈R)\beta(\theta)=P_\theta(T(X)\in R)β(θ)=Pθ(T(X)∈R),当θ∈Θ0\theta\in \Theta_0θ∈Θ0时,β(θ)=Pθ(第一类错误率)\beta(\theta)=P_\theta(第一类错误率)β(θ)=Pθ(第一类错误率);否则=1−Pθ(第二类错误率)1-P_\theta(第二类错误率)1−Pθ(第二类错误率)

-

目标:尽可能减少这两类错误的概率,即在Θ0\Theta_0Θ0中β\betaβ尽可能,Θ1\Theta_1Θ1中β\betaβ尽可能大

-

但是一般来说根据连续性两个目标不太可能同时达到,所以改为定义检验水平(固定一端):

如果supθ∈Θ0β(θ)=α\sup_{\theta\in \Theta_0}\beta(\theta)=\alphasupθ∈Θ0β(θ)=α,则称为size为α\alphaα的检验;如果≤α\leq \alpha≤α,则称为level为α\alphaα的检验

如果supθ∈Θ0β(θ)≤infθ∈Θ1β(θ)\sup_{\theta\in \Theta_0}\beta(\theta)\leq \inf_{\theta\in\Theta_1}\beta(\theta)supθ∈Θ0β(θ)≤infθ∈Θ1β(θ),则称为无偏的检验

-

常见的检验构造方法

似然比方法

-

定义λ(x)=supθ∈Θ0L(θ∣x)supθ∈ΘL(θ∣x)=L(θ0^∣x)L(θ^∣x)\lambda(x)=\frac{\sup_{\theta\in\Theta_0}L(\theta|x) }{\sup_{\theta\in\Theta}L(\theta|x)}=\frac{L(\hat{\theta_0}|x)}{L(\hat{\theta}|x)}λ(x)=supθ∈ΘL(θ∣x)supθ∈Θ0L(θ∣x)=L(θ^∣x)L(θ0^∣x),当λ(x)≤c\lambda(x)\leq cλ(x)≤c时拒绝

注:λ\lambdaλ也可考虑直接取关于充分统计量TTT的函数

优势:最普适的构造方法;可以用来消去讨厌参数(nuisance parameter,即不需要检验但是与分布有关的参数)

-

渐近性:

假设x1,...,xn∼iidf(x∣θ)x_1,...,x_n\stackrel{iid}\sim f(x|\theta)x1,...,xn∼iidf(x∣θ),则在零假设下,−2logλ(x)→dχk2,k=dim(Θ)−dim(Θ0)-2\log \lambda(x)\stackrel{d}\rightarrow \chi_k^2, k=\dim(\Theta)-\dim(\Theta_0)−2logλ(x)→dχk2,k=dim(Θ)−dim(Θ0)

从而,如果建立一个检验,在−2logλ(x)≥χk,α2-2\log \lambda(x)\geq \chi_{k,\alpha}^2−2logλ(x)≥χk,α2时拒绝,则得到一个渐近level为α\alphaα的检验

一致最大功效检验(UMP)

-

假设CαC_\alphaCα是所有level为α\alphaα的检验的集合,则对任意β()∈Cα\beta()\in C_\alphaβ()∈Cα,β\betaβ是UMP当且仅当任意其它β′∈Cα\beta'\in C_\alphaβ′∈Cα,β′(θ)≤β(θ),∀θ∈Θ0c\beta'(\theta)\leq \beta(\theta),\forall \theta \in \Theta_0^cβ′(θ)≤β(θ),∀θ∈Θ0c

-

判定:

-

如果Θ0={θ0},Θ1={θ1}\Theta_0=\{\theta_0\},\Theta_1=\{\theta_1\}Θ0={θ0},Θ1={θ1},那么一个具有拒绝区域R={x∣f(x∣θ1)>kf(x∣θ0)}R=\{x|f(x|\theta_1)>kf(x|\theta_0)\}R={x∣f(x∣θ1)>kf(x∣θ0)},并且Pθ0(x∈R)=αP_{\theta_0}(x\in R)=\alphaPθ0(x∈R)=α的测试必定是一个UMP检验

-

如果Θ0={θ≤θ0},Θ1={θ>θ0}\Theta_0=\{\theta\leq \theta_0\},\Theta_1=\{\theta>\theta_0\}Θ0={θ≤θ0},Θ1={θ>θ0},并且分布族PθP_\thetaPθ是单调的:∀θ1<θ2\forall \theta_1<\theta_2∀θ1<θ2,fθ2(x)fθ1(x)\frac{f_{\theta_2}(x)}{f_{\theta_1}(x)}fθ1(x)fθ2(x)在区域{x∣fθ2(x)>0或fθ1(x)>0}\{x|f_{\theta_2}(x)>0 或f_{\theta_1}(x)>0\}{x∣fθ2(x)>0或fθ1(x)>0}上单调不减,那么一个当且仅当T(x)>t0T(x)>t_0T(x)>t0时拒绝的检测是level为α=Pθ0(T>t0)\alpha=P_{\theta_0}(T>t_0)α=Pθ0(T>t0)的UMP检验

-

-

注意:

对于离散的分布,UMP可能是离散的

UMP检测不一定存在

Wald检验和Score检验

- 这两个检验方法是渐近性的

- 如果Θ0={θ0}\Theta_0=\{\theta_0\}Θ0={θ0},则在零假设下,有I(θ)(θ^−θ)→asyN(0,1)\sqrt{\mathcal{I}(\theta)} (\hat{\theta}-\theta)\stackrel{asy}\rightarrow N(0,1)I(θ)(θ^−θ)→asyN(0,1)(θ^\hat{\theta}θ^为MLE),并且在一般情况下I(θ)→Var(θ)\mathcal{I}(\theta)\rightarrow Var(\theta)I(θ)→Var(θ),因此,得到两个自然的渐近检验:

- Wald:∣θ^−θVar(θ^)∣≥Zα/2\left|\frac{\hat{\theta}-\theta}{\sqrt{Var(\hat{\theta})}}\right|\geq Z_{\alpha/2}Var(θ^)θ^−θ≥Zα/2,其中Var(θ^)Var(\hat{\theta})Var(θ^)可以通过分布求出

- Score:∣θ^−θVar(θ)∣≥Zα/2\left|\frac{\hat{\theta}-\theta}{\sqrt{Var({\theta})}}\right|\geq Z_{\alpha/2}Var(θ)θ^−θ≥Zα/2,其中Var(θ)Var({\theta})Var(θ)可以通过分布求出

Union Intersection和Intersection Union检验:

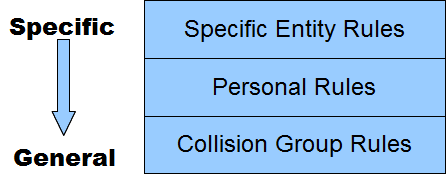

- 这两个检验是为了解决假设是某些简单集合的并集的情况。这里前一个项是指拒绝域的形式,后一个项是指零假设的形式

- 因此:Θ0=∩γ∈ΓΘγ\Theta_0=\cap_{\gamma\in\Gamma}\Theta_\gammaΘ0=∩γ∈ΓΘγ,则为Union Intersection检验。将其分解为若干检验HγH_\gammaHγ:Hγ0=ΘγH_{\gamma0}=\Theta_\gammaHγ0=Θγ,假设每个检验的拒绝域为RγR_\gammaRγ,则最终得到的检验的拒绝域R=∪γ∈ΓRrR=\cup_{\gamma\in \Gamma} R_rR=∪γ∈ΓRr,因为接受域小,所以拒绝域相对的就大

- 反之,Θ0=∪γ∈ΓΘγ\Theta_0=\cup_{\gamma\in\Gamma}\Theta_\gammaΘ0=∪γ∈ΓΘγ,则为Intersection Union检验。将其分解为若干检验HγH_\gammaHγ:Hγ0=ΘγH_{\gamma0}=\Theta_\gammaHγ0=Θγ,假设每个检验的拒绝域为RγR_\gammaRγ,则最终得到的检验的拒绝域R=∩γ∈ΓRrR=\cap_{\gamma\in \Gamma} R_rR=∩γ∈ΓRr,

p值

-

p值是一个关于样本的函数p(x)p(x)p(x),表征的是H0H_0H0为真时观测到至少与当前样本xxx相同极端的样本的概率。也就是说,如果一个样本的p值为ttt,则可以断言同类型样本的出现概率为t

-

一般使用p值都是反过来用,即把要验证的假设当做H1H_1H1,然后说明样本具有足够小的p值(一般取0.05),从而说明如果H0H_0H0成立,那么样本会是非常特殊的,从而反过来证明H1H_1H1很可能成立

-

依据上面的性质,可以抽象出一个定义:

0≤p(x)≤1,∀x0\leq p(x)\leq1,\forall x0≤p(x)≤1,∀x. 一个p值是有效的,当且仅当对任意θ∈Θ0,∀α\theta\in \Theta_0,\forall \alphaθ∈Θ0,∀α,Pθ(x:p(x)≤α)≤αP_\theta(x:p(x)\leq \alpha)\leq \alphaPθ(x:p(x)≤α)≤α,也就是说,在Θ0\Theta_0Θ0中,小的p值一定意味着小的出现概率,进一步意味着H1H_1H1为真。

-

构造:考虑构造函数W(x)W(x)W(x):较大的WWW值意味着H1H_1H1更可能为真

对任意xxx,定义P(x)=supθ∈Θ0Pθ(W(X)≥W(x))P(x)=\sup_{\theta\in\Theta_0} P_\theta (W(X)\geq W(x))P(x)=supθ∈Θ0Pθ(W(X)≥W(x))即为所求p值

置换检验

X1,...,Xn∼F,Y1,...,Ym∼GX_1,...,X_n\sim F, Y_1,...,Y_m\sim GX1,...,Xn∼F,Y1,...,Ym∼G,现在希望检验H0:F=G,H1:F≠GH_0:F=G,H_1:F\neq GH0:F=G,H1:F=G

定义T=∣X‾n−Y‾m∣T=|\overline{X}_n-\overline{Y}_m|T=∣Xn−Ym∣,对X1,...,YmX_1,...,Y_mX1,...,Ym做置换,得到TTT值Ti,i=1∼N!T_i,i=1\sim N!Ti,i=1∼N!;并且原本的TTT值为TobsT_{obs}Tobs,那么对于观测X的p值就是P0(T>Tobs)=∑i1(Ti>obs)N!P_0(T>T_{obs})=\frac{\sum_{i} 1({T_i>obs})}{N!}P0(T>Tobs)=N!∑i1(Ti>obs),因为理论上如果两个的分布相同那么p值应该会比较高。

Chapter 8 区间检验

置信区间:对于样本xxx,和区间[L(x),U(x)][L(x),U(x)][L(x),U(x)],其置信度为1−α=infθPθ(θ∈[L(x),U(x)])1-\alpha=\inf_{\theta}P_\theta(\theta\in[L(x),U(x)])1−α=infθPθ(θ∈[L(x),U(x)]),也就是说,θ\thetaθ至多只有α\alphaα的概率不在该区间中

构造:

-

概率不等式:

Hoeffding’s不等式: Xi∈[ai,bi]X_i\in [a_i,b_i]Xi∈[ai,bi] 独立,则P(∣X‾−EX∣≥t)≤2exp{−2n2t2∑i(bi−ai)2}P(|\overline{X}-EX|\geq t)\leq 2\exp \{-\frac{2n^2t^2}{\sum_i(b_i-a_i)^2}\}P(∣X−EX∣≥t)≤2exp{−∑i(bi−ai)22n2t2}

-

测试取逆

假设可以建立一个level为α\alphaα的测试,并且定义C(x)={θ0:x∈A(θ0)}C(x)=\{\theta_0:x\in A(\theta_0)\}C(x)={θ0:x∈A(θ0)},则C(x)C(x)C(x)为一个1−α1-\alpha1−α的置信集合

-

枢轴方法

Q(X1,...,Xn,θ)Q(X_1,...,X_n,\theta)Q(X1,...,Xn,θ)称为一个枢轴,若QQQ与θ\thetaθ独立;则Pθ(a≤Q(x,θ)≤b)=1−αP_\theta(a\leq Q(x,\theta)\leq b)=1-\alphaPθ(a≤Q(x,θ)≤b)=1−α(a,b为Q的分布的1-alpha区间端点)

-

Delta方法(近似)

θ^\hat{\theta}θ^为MLE,则由于n(γ(θ^)−γ(θ0))→dN(0,γ′(θ)2I(θ))\sqrt{n}(\gamma(\hat{\theta})-\gamma(\theta_0))\stackrel{d}\rightarrow N(0,\frac{\gamma'(\theta)^2}{I(\theta)})n(γ(θ^)−γ(θ0))→dN(0,I(θ)γ′(θ)2),我们知道γ(θ0)±Z1−α/2∣π′(θ)∣/In(θ)\gamma(\theta_0)\pm Z_{1-\alpha/2}|\pi'(\theta)|/\sqrt{I_n(\theta)}γ(θ0)±Z1−α/2∣π′(θ)∣/In(θ)(仔细推一下这个形式)

高维情况:n(Yn−θ)→dNp(0,Σ)\sqrt{n}\left(Y_n-\theta\right) \stackrel{d}{\rightarrow} N_p(0, \Sigma)n(Yn−θ)→dNp(0,Σ);n(g(Yn)−g(θ))→dN(0,(∂g(θ)∂θ)′Σ(∂g(θ)∂θ))\sqrt{n}\left(g\left(Y_n\right)-g(\theta)\right) \stackrel{d}{\rightarrow} N\left(0,\left(\frac{\partial g(\theta)}{\partial \theta}\right)^{\prime} \Sigma\left(\frac{\partial g(\theta)}{\partial \theta}\right)\right)n(g(Yn)−g(θ))→dN(0,(∂θ∂g(θ))′Σ(∂θ∂g(θ)))

Σ\SigmaΣ:协方差矩阵

-

Score方法(近似)

Q(X∣θ)=∂∂θlogL(θ∣X)−Eθ(∂2∂θ2I(θ∣X))→N(0,1)Q(X \mid \theta)=\frac{\frac{\partial}{\partial \theta} \log L(\theta \mid X)}{\sqrt{-E_\theta\left(\frac{\partial^2}{\partial \theta^2} I(\theta \mid X)\right)}}\rightarrow N(0,1)Q(X∣θ)=−Eθ(∂θ2∂2I(θ∣X))∂θ∂logL(θ∣X)→N(0,1),因此集合{θ:∣Q(x∣θ)∣≤zα/2}\left\{\theta:|Q(x \mid \theta)| \leq z_{\alpha / 2}\right\}{θ:∣Q(x∣θ)∣≤zα/2}置信区间为1−α1-\alpha1−α

-

LRT方法(近似)

同理,当Θ0=θ0\Theta_0=\theta_0Θ0=θ0时,LRT的渐进性也可以用来构造置信区间:Cn={θ:L(θ)L(θ^)>e−χk,1−α2/2}C_n=\left\{\theta: \frac{L(\theta)}{L(\widehat{\theta})}>e^{-\chi_{k, 1-\alpha}^2 / 2}\right\}Cn={θ:L(θ)L(θ)>e−χk,1−α2/2}

-

最优长度:在所有1−α1-\alpha1−α的置信区间中,存在某个长度最短的置信区间。这要求∫abf(z)dz=1−α\int_a^b f(z)dz=1-\alpha∫abf(z)dz=1−α,当f单峰时把峰取在其中并且使得两端的函数值相等即可