1. 向量化多元线性回归,及梯度下降算法

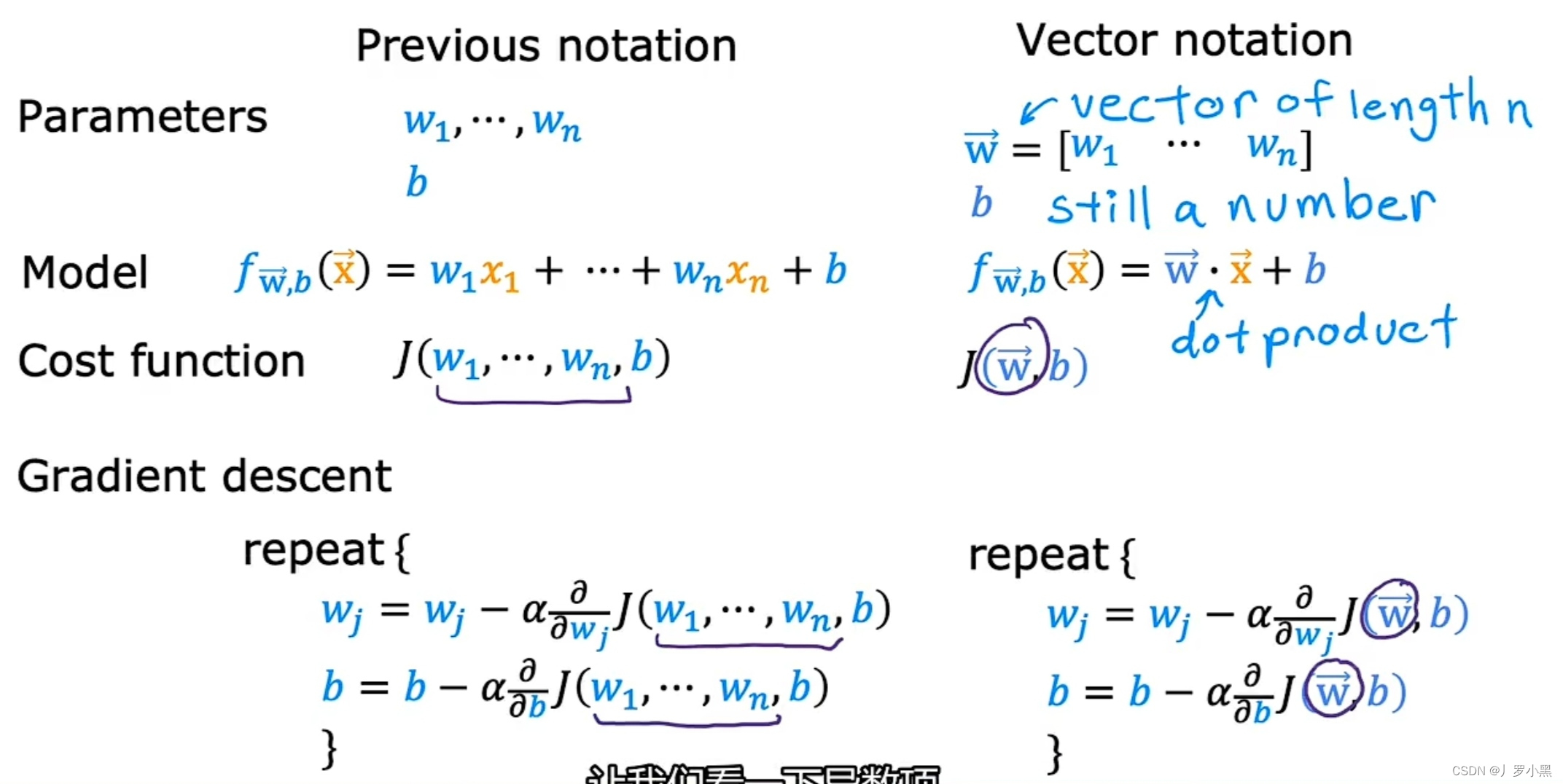

- 将W₁,…,Wn写成向量W,将X₁,…,Xn写成向量X,而b还是之前的b

- 注意:在多元线性回归的梯度下降算法中,Wj是指从W₁到Wn中的某一项,因为多元线性回归有多个特征(变量),所以对于每一个特征X都有对应的W。而对于每一个W,梯度下降算法在每一步都要对其进行更新

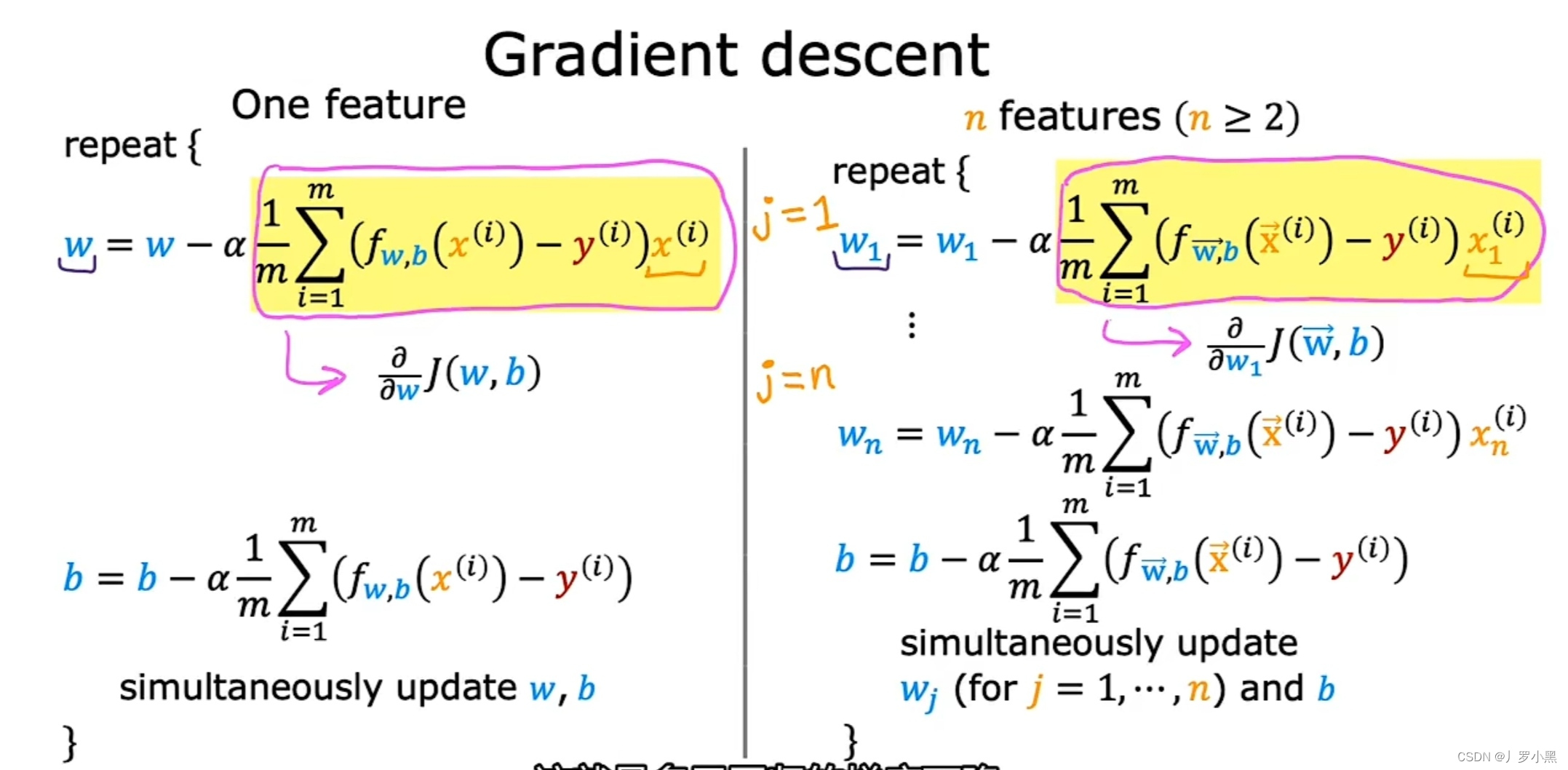

2. 单元和向量化多元线性回归的梯度下降算法对比

- 这里的多元和单元是指X的个数

- 左边是单元线性回归的梯度下降算法,右边是向量化多元线性回归的梯度下降算法

- 黄色内部是成本函数J对W₁的偏导

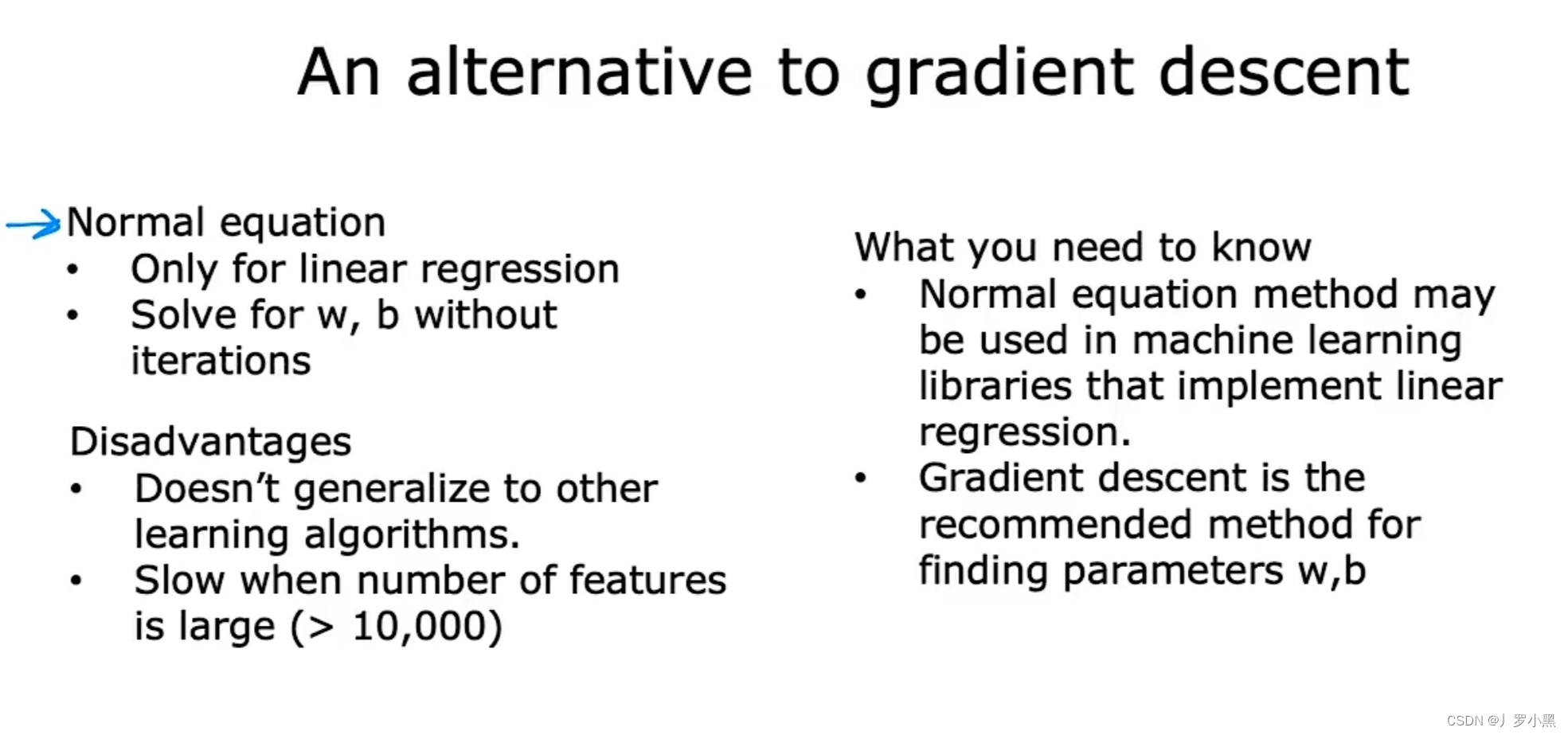

3. 正规方程的优缺点

- 优点:只适用于线性回归,且求解w和b时不需要迭代梯度下降算法

- 缺点:没有推广到其他的学习算法,如果特征数量过大,它的速度会很慢

- 在某些机器学习库中可能会使用正规方程法,来求w和b,从而实现线性回归

- 但是正规方程法了解即可,我们最好还是使用梯度下降算法来求w和b