ChatGPT写代码

✋ChatGPT 是一个基于人工智能的自然语言处理模型,可以帮助程序员更高效地、更自然地与计算机交互。ChatGPT 可以解决程序员在日常开发中遇到的各种问题,例如语法错误、API 使用、代码实现、架构设计等等。

💥通过与 ChatGPT 进行交互,程序员可以避免繁琐的语法和细节,更专注于业务需求和算法实现。ChatGPT 可以提供与人类类似的智能交互,帮助程序员准确理解和表达意图,提高开发效率和可维护性。

我只能说ChatGPT 用它来帮我们写代码那是真的太强了。🚀

但是我们手头上并没有ChatGPT ,有还是收费的,通过下面的方式,完全可以达到人手一个ChatGPT,而且还不需要魔法。

人手一个ChatGPT

更多的AI工具,可以参考AiBard123

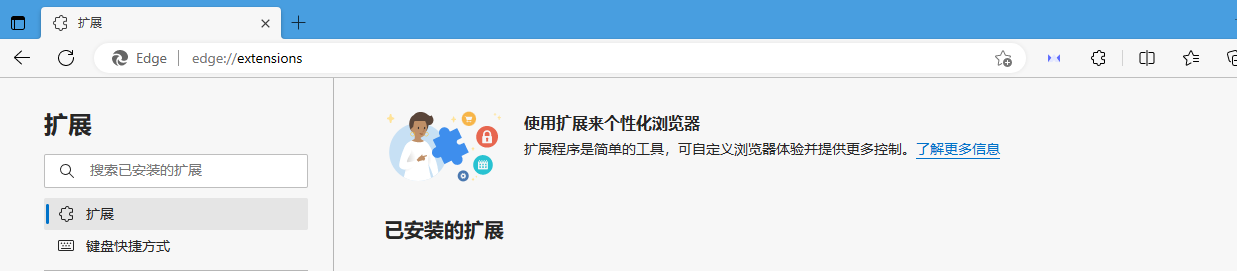

🗼打开windows 的 edge 浏览器。

🗼在地址栏中输入:edge://extensions/

🦁 搜索扩展:wetab 安装扩展,并启用 他。

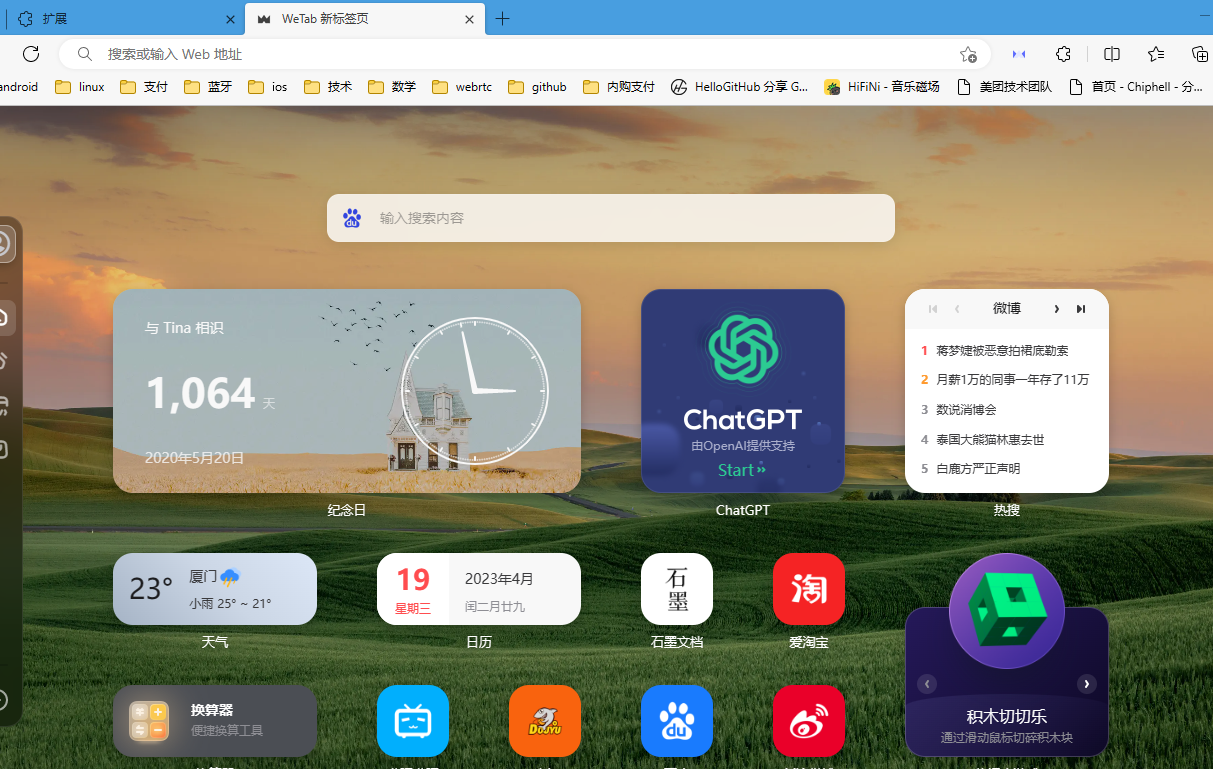

🦁新建一个页面,就是wetab 的icon 栏。

🐔看到了这个ChatGPT,就可以点击进去,这个就是ChatGPT的页面了。

写个看AI新闻的python程序

🐔可能有人不相信,ChatGPT写代码的能力,这里我们通过一个例子来看看,ChatGPT 写代码的能力强不强。

现在的新闻太多了,如果关心某个类别的新闻,可以用python 获取 全部网页的新闻后,把需要的新闻过滤出来,就是我们关心的新闻了。

让ChatGPT来写这段代码。

用python写一段程序:抓取 https://www.ithome.com/ 网址,并解析出所有的链接和链接标题

ChatGPT 回答如下:

🐸好的,可以使用Python中的requests库来获取页面的HTML内容,使用BeautifulSoup库来解析页面内容,进而提取页面中的链接和链接标题。下面是一个基本的示例代码:

import requests

from bs4 import BeautifulSoupurl = 'https://www.ithome.com/'

r = requests.get(url)

r.encoding = 'utf-8'

soup = BeautifulSoup(r.text, 'html.parser')links = soup.find_all('a') # 获取所有链接标签

for link in links:href = link.get('href') # 获取链接地址title = link.get_text() # 获取链接标题if href and title: # 过滤掉没有链接地址或标题的标签print('{} : {}'.format(title, href))

解析过程大致如下:

-

使用requests库获取网页内容。在本例中,我们使用了IT之家网站(URL为https://www.ithome.com/)作为示例页面。

-

将请求结果的编码设置为UTF-8。网页的编码方式可能是不同的,需要根据实际情况进行调整。

-

使用BeautifulSoup库解析HTML内容。在这里,我们使用了html.parser作为解析器来解析HTML文档。

-

通过find_all(‘a’)方法获取所有的链接标签。

-

遍历所有链接标签,分别使用get(‘href’)和get_text()方法获取链接地址和链接标题。

-

过滤掉没有链接地址或标题的标签,并打印输出结果。

这一段程序是非常完整的,完全不用修改就可以在python下运行。

👀我们继续问他:

我需要安装哪些库

🐸回答如下:

您需要先安装requests和beautifulsoup4这两个Python库才能运行上述程序。

您可以通过在命令行中执行以下命令来安装这两个库:

pip install requests

pip install beautifulsoup4

安装完成后,您就可以运行上述程序,获取IT之家网站的链接和标题了。

注意:如果您使用的是Anaconda环境,则无需再次安装上述库,因为Anaconda已经自带了这两个库。

回答的非常的正确。

还可以继续的问题,他们帮忙我们继续的改正代码,提出的新需求也可以帮我们完成。

👀

继续修改代码,刚才是全部打印,现在改成:如果标题中 含有ai或者gpt的关键字,才打印出来

🐸回答如下:

好的,您可以在代码中加入一些逻辑来过滤标题中不包含“ai”或“gpt”的链接。这里是一个修改后的程序示例:

python

import requests

from bs4 import BeautifulSoupurl = 'IT之家'

r = requests.get(url)

r.encoding = 'utf-8'

soup = BeautifulSoup(r.text, 'html.parser')links = soup.find_all('a')

for link in links:href = link.get('href')title = link.get_text()if href and title and ('ai' in title.lower() or 'gpt' in title.lower()): #过滤掉没有链接地址或标题的标签,和不包含 "ai" 或 "gpt" 关键字的链接print('{} : {}'.format(title, href))

我们使用了in运算符来检查标题中是否包含“ai”或“gpt”关键字,同时调用lower()方法将标题转换为小写字母,以避免大小写对结果的影响。

现在程序只会打印出包含“ai”或“gpt”的链接标题了。

更多的AI工具,可以参考AiBard123