作者 | 金鹿

本文经授权转自公众号腾讯科技(ID:qqtech),如需转载,请联系对方:

机器学习和人工智能初创公司Humanloop首席执行官拉扎·哈比比(Raza Habib),5月29日邀请OpenAI首席执行官萨姆·奥特曼(Sam Altman)以及其他20多位开发者,共同探讨了人工智能的未来。奥特曼非常坦率地分享了OpenAI未来两年的产品路线图,还谈到OpenAI的使命以及人工智能的社会影响等问题。

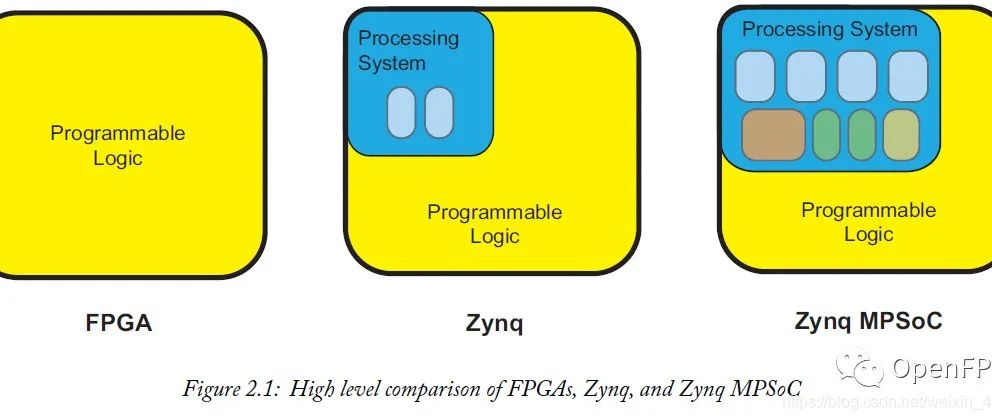

图源:Sam Altman个人博客

以下为访谈要点:

OpenAI严重受制于GPU短缺

在整个讨论中出现的一个共同主题是,目前OpenAI的GPU供应非常有限,这导致他们推迟了许多短期计划。客户最大的抱怨是API的可靠性和速度。奥特曼承认存在这种担忧,并解释说大部分问题是因GPU短缺所致。

长度为32k的上下文功能还不能推广给更多的人。OpenAI还没有克服相关技术挑战,所以虽然看起来他们很快(今年)就会有100k到1M令牌的上下文窗口,但更大的窗口都需要在研究上取得突破。

微调API目前也受到GPU可用性的限制。它们还没有使用Adapters或LoRa等高效的调优方法,因此调优的运行和管理需要大量的计算。将来会有更好的微调支持。他们甚至可以托管一个社区贡献模型的市场。

专用容量供应受GPU可用性的限制。OpenAI也提供专用容量,为客户提供该模型的私人副本。但要使用这项服务,客户必须愿意支付相当于10万美元的费用。

OpenAI的近期路线图

奥特曼分享了他所看到的OpenAI API临时近期路线图。

2023年:

更便宜、更快的GPT-4:这是OpenAI的首要任务。总的来说,OpenAI的目标是尽可能地降低“智能成本”,因此他们将努力随着时间的推移继续降低API的成本。

更长的上下文窗口:在不久的将来,上下文窗口可能高达100万令牌。

微调API:微调API将扩展到最新的模型上,但其确切形式将由开发者真正想要的元素来决定。

支持会话状态的API:当你今天调用聊天API时,你必须反复地传递相同的会话历史,并反复支付同样的令牌。将来,会有一个版本的API可以记住会话历史记录。

2024年:

多模态:这在GPT-4发布时进行了演示,但在更多GPU上线之前不能扩展到所有人。

插件“没有PMF”,可能不会很快出现在API中

许多开发人员都对通过API访问ChatGPT插件感兴趣,但奥特曼说他认为这些插件不会很快发布。除了浏览,插件的使用表明他们还没有PMF。奥特曼表示,很多人认为他们希望自己的应用被集成到ChatGPT中,但实际上,他们真正想要的是将ChatGPT引入自己的应用中。

OpenAI将避免与他们的客户竞争,除了ChatGPT

许多开发者表示,他们对使用OpenAI API构建产品感到紧张,因为OpenAI最终可能会发布与他们竞争的产品。对此,奥特曼表示,OpenAI不会发布更多ChatGPT之外的产品。他说,许多伟大的平台公司都有自己的杀手级应用,ChatGPT将允许他们通过成为自家产品的客户来改进API。ChatGPT的愿景是成为一个超级智能的工作助手,但还有很多其他的GPT用例是OpenAI无法触及的。

监管是必要的,但开源同样重要

虽然奥特曼呼吁对未来的模型进行监管,但他并不认为现有的模型是危险的,认为监管或禁止它们将是一个大错误。奥特曼强调了开源的重要性,并表示OpenAI正在考虑开源GPT-3。他们还没有开源的部分原因在于,他怀疑有多少个人和公司有能力托管大语言模型。

缩放定律仍然成立

最近许多文章都声称“巨型人工智能模型的时代已经结束”,但奥特曼表示,这并没有准确地表达他的意思。

OpenAI的内部数据表明,模型性能的缩放定律仍然成立,扩大模型将继续可以帮助提升性能。但这种扩展速度无法维持下去,因为OpenAI在短短几年内就把模型放大了数百万倍,这样做是不可持续的。不过,这并非意味着OpenAI将停止扩大模型,只是意味着它们的规模可能每年只会增加一倍或三倍,而不是以指数级速度增长。

缩放定律继续发挥作用的事实对通用人工智能(AGI)开发的时间线具有重要意义。缩放假设是指,我们可能已经具备了构建AGI所需的大部分要素,剩下的大部分工作将是采用现有方法,并将其扩展到更大的模型和更大的数据集上。如果缩放时代已经结束,那么我们应该期待AGI离我们更遥远。但事实上,缩放定律继续成立的事实强烈地暗示了时间线正变得更短。