大型语言模型(LLM)是人工智能领域中的一个重要研究方向,在ChatGPT之后,它经历了快速的发展。这些发展主要涉及以下几个方面:

- 模型规模的增长:LLM的规模越来越大,参数数量显著增加。这种扩展使得模型能够处理更复杂、更长的输入序列,并生成更准确、更具连贯性的输出。同时,更大规模的模型还能够涵盖更广泛的知识和语言上下文,提供更全面的回答和解决方案。

- 领域专精化:LLM在不同领域的专精化得到了进一步的发展。研究人员通过对特定领域的训练数据进行更多的优化,使得模型在特定领域的问答、文本生成等任务中表现更出色。这使得LLM能够为特定行业或专业领域提供更精准的支持和咨询。

- 提升对语义理解和推理能力:研究人员致力于提高LLM对语义理解和推理的能力。通过引入更多的上下文信息、关联知识和逻辑推理机制,LLM能够更好地理解复杂问题,进行推理和分析,并给出更深入、准确的回答。

- 模型训练的效率和速度提升:研究人员提出了一系列技术来提高LLM的训练效率和推理速度。例如,采用分布式训练方法,利用多台计算机进行并行训练,加快模型收敛速度。此外,还有一些压缩和加速技术,可以在保持性能的同时减少模型的计算资源消耗。

- 理解和应对偏见:LLM的发展也关注了如何更好地理解和应对模型中的偏见。研究人员努力解决模型在生成结果时可能存在的性别、种族、文化等偏见问题,以确保模型的输出更加公正和中立。

本文将总结目前能见到的所有开源的大语言模型。

Falcon-40B-Instruct

Falcon-40B- instruct是TII基于Falcon-40B构建的40B参数因果解码器模型,在Baize上进行微调。

位于阿布扎比的技术创新研究所(TII)宣布了其开源大型语言模型(LLM)——Falcon-40B。Falcon-40B拥有400亿个参数,是阿联酋首个大型人工智能模型,表明了该国在人工智能领域的雄心以及推动创新和研究的承诺。

与大多数llm(通常只向非商业用户提供访问)不同,Falcon-40B对研究和商业用途都开放。TII还将模型的权重包含在开源包中,这将增强模型的功能并允许更有效的微调。

自2023年3月亮相以来,Falcon-40B的表现令人印象深刻。当使用斯坦福大学的HELM工具进行基准测试时,与OpenAI的GPT-3、DeepMind的Chinchilla AI和谷歌的PaLM-62B等其他知名模型相比,它使用的训练计算能力更少。

Vicuna

Vicuna是一个开源聊天机器人,通过从ShareGPT收集的用户共享对话进行训练。使用GPT-4作为评判的初步评估显示,Vicuna-13B的质量达到了OpenAI ChatGPT和Google Bard的90%以上,训练Vicuna-13B的费用约为300美元。代码和权重以及在线演示都是公开的,可供非商业用途。

在对Vicuna与70K用户共享的ChatGPT对话进行微调后,我们发现与Alpaca相比,Vicuna能够生成更详细和结构良好的答案,质量与ChatGPT相当。

Vicuna是通过微调LLaMA基础模型创建的,该模型使用了从ShareGPT收集的大约70K用户共享对话和公共api。

训练也有以下改进。

内存优化:将最大上下文长度从512扩展到2048,通过利用梯度检查点和flash attention解决内存压力。

多轮对话:调整训练损失以考虑多轮对话,并仅根据聊天机器人的输出计算微调损失。

通过Spot实例降低成本:使用SkyPilot管理的spot来降低成本,利用更便宜的spot实例来自动恢复抢占和自动区域切换。这个解决方案将训练7B模型的成本从500美元削减到140美元左右,将训练13B模型的成本从1000美元左右削减到300美元左右。

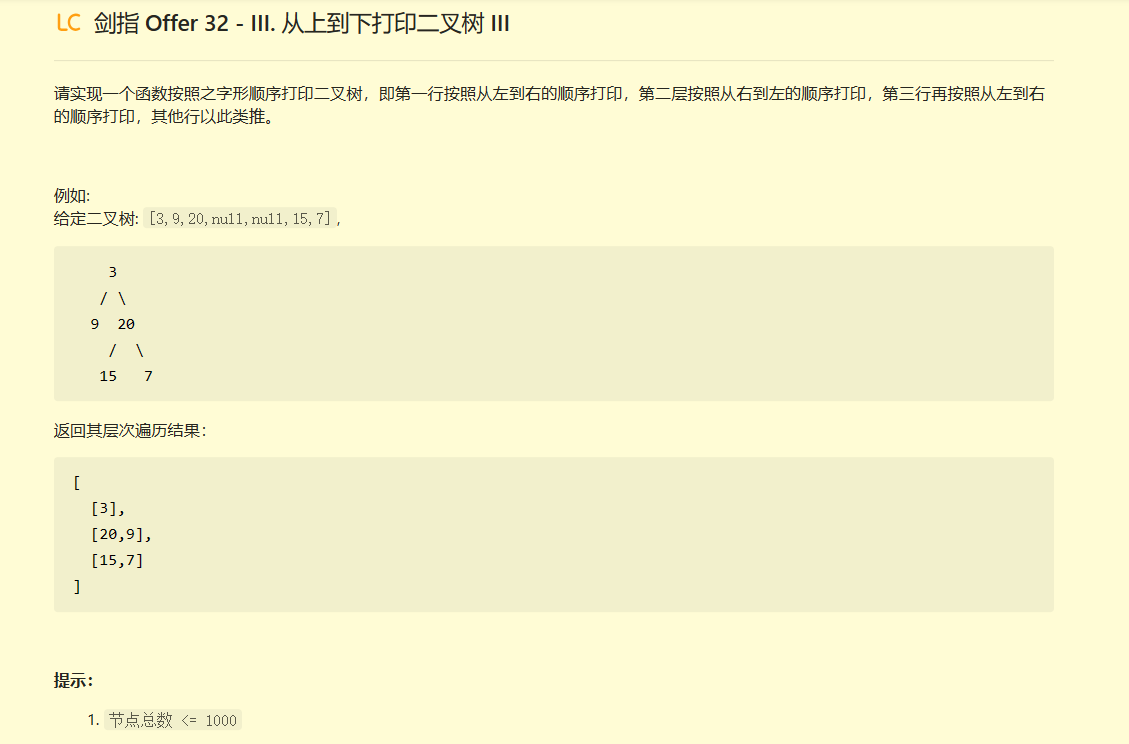

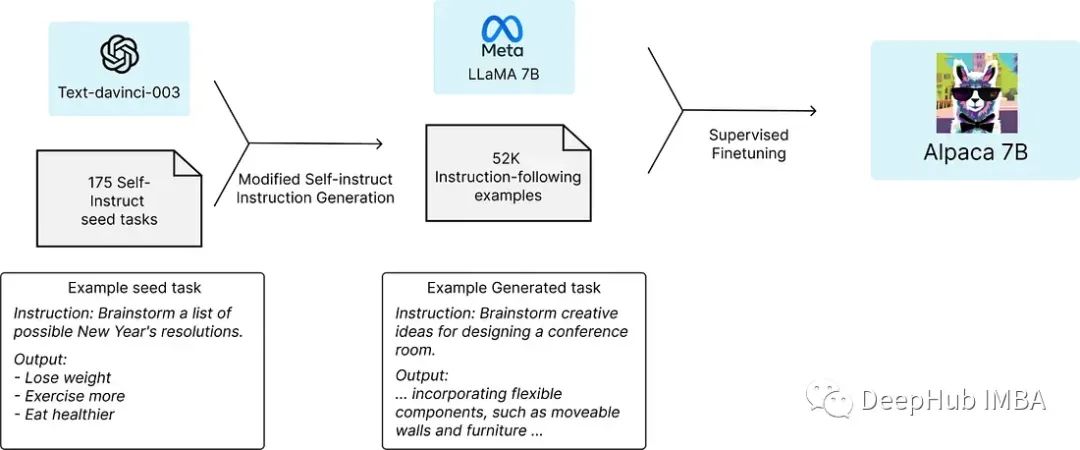

Alpaca

Alpaca,在Meta的LLaMA 7B模型上进行了微调。使用text-davinci-003以自指导的方式生成52K指令跟随LLaMA 模型。在评估集上,Alpaca表现出许多与OpenAI的text- davincic -003相似的行为,但但是他却非常的小,且易于地复制。

下图说明了Alpaca是如何训练的。

使用HuggingFace的训练框架对LLaMA模型进行了微调,利用了完全分片数据并行和混合精确训练等技术。在8台80GB的a100上微调7B LLaMA模型花了3个小时,在大多数云计算提供商那里,a100的成本不到100美元。

LLaMA

LLaMA(Large Language Model Meta AI),一个最先进的基础大型语言模型,旨在帮助研究人员推进他们在人工智能这一子领域的工作。

与其他大型语言模型一样,LLaMA的工作方式是将单词序列作为输入,并预测下一个单词以递归地生成文本。从使用人数最多的20种语言中选择了文本,重点关注那些带有拉丁和西里尔字母的语言

在大多数基准测试中,LLaMA- 13b优于GPT-3(175B),而LLaMA- 13b优于GPT-3(175B),而65B与Chinchilla-70B和PaLM-540B类似。

GPT J

gpt - j6b是使用Ben Wang的Mesh Transformer JAX训练的Transformer 模型。“GPT-J”表示模型的类别,“6B”表示可训练参数的个数。模型共28层,模型维数为4096,前馈维数为16384。模型维度被分成16个头,每个头的维度为256。该模型使用50257的标记化词汇表进行训练,使用与GPT-2/GPT-3相同的bp集。该模型由EleutherAI发布。GPT-J的核心功能是获取一串文本并预测下一个令牌。

GPT-J是在Pile上训练的,这是一个已知包含亵渎、猥亵和其他粗暴语言的数据集。所以GPT-J可能会产生社会上不可接受的文本。

Dolly

Databricks的Dolly-V2-12B,一个在Databricks机器学习平台上训练的大型语言模型。基于Pythia-12B, Dolly接受了约15k条指令/响应调优记录,这些记录是由Databricks员工在基于InstructGPT论文领域中生成的,包括头脑风暴、分类、封闭QA、生成、信息提取、开放QA和总结。

总结

大型语言模型在ChatGPT以后经历了快速的发展。这些发展包括模型规模的增加、领域专精化、语义理解和推理能力的提升、训练效率和速度的提高,以及对偏见的理解和应对等方面。除了以上6个比较好的开源大语言模型外,还有各种不同版本,所以HuggingFace创建了一个排行榜(leaderboard)

有兴趣的可以看看:

https://avoid.overfit.cn/post/a4da1098db9d4bf4b00365b28c201db9

作者:Varun Mathur