本文介绍Linux系统中配置Hadoop、HBase和Spark环境,包括安装Java运行环境、下载安装包、进行配置和测试。通过这种方式,可以搭建一个强大的分布式计算环境,用于处理大规模数据集。为了成功配置Hadoop、HBase和Spark环境,需要理解它们之间的关系和各自的组件。

配置虚拟机

测试环境使用vmware workstation pro软件在Windows系统中创建一个虚拟机(后续构建多节点集群可配置好相关环境之后直接克隆,仅需修改简单参数即可构建集群),并在虚拟机中安装Ubuntu系统,这样可以在不影响原有系统的情况下体验和测试。

虚拟机VMware 中安装Linux系统-Ubuntu_runepic的博客-CSDN博客![]() https://blog.csdn.net/weixin_40694662/article/details/130030888?spm=1001.2014.3001.5501

https://blog.csdn.net/weixin_40694662/article/details/130030888?spm=1001.2014.3001.5501

安装Java

Hadoop、HBase和Spark都是基于Java开发的,因此首先需要安装Java运行环境。可以从Oracle官网上下载适合自己操作系统的Java安装包,并按照安装向导进行安装。

Ubuntu系统安装java1.8_ubuntu 安装java1.8_runepic的博客-CSDN博客![]() https://blog.csdn.net/weixin_40694662/article/details/130943367?spm=1001.2014.3001.5501

https://blog.csdn.net/weixin_40694662/article/details/130943367?spm=1001.2014.3001.5501

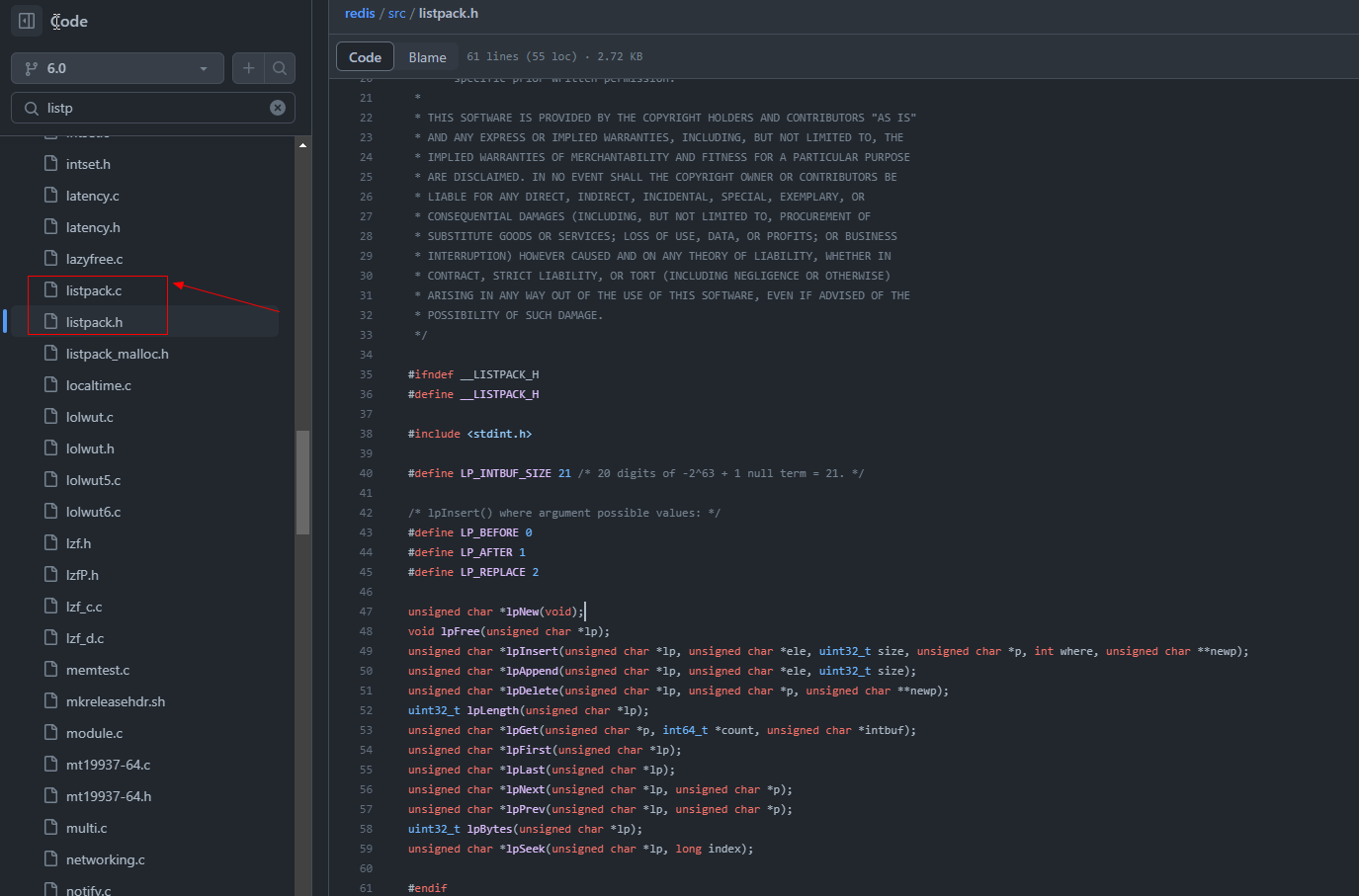

安装Hadoop

Hadoop是一种分布式系统,用于处理大规模数据集。可以从Apache Hadoop官网下载Hadoop的安装包,并按照官方文档进行安装和配置。在配置过程中,需要指定Hadoop的主节点和从节点,以及相关的配置参数,如端口号、数据目录等。

分布式安装配置Hadoop3.2.4_runepic的博客-CSDN博客![]() https://blog.csdn.net/weixin_40694662/article/details/130982964?spm=1001.2014.3001.5501

https://blog.csdn.net/weixin_40694662/article/details/130982964?spm=1001.2014.3001.5501

安装Zookeeper

Zookeeper是一个开源的分布式协调服务,在Hadoop和各种分布式系统中应用广泛。

分布式安装配置zookeeper3.4.12_runepic的博客-CSDN博客![]() https://blog.csdn.net/weixin_40694662/article/details/131044875?spm=1001.2014.3001.5501

https://blog.csdn.net/weixin_40694662/article/details/131044875?spm=1001.2014.3001.5501

安装HBase

HBase是一个分布式的NoSQL数据库,用于处理结构化数据。可以从Apache HBase官网下载HBase的安装包,并按照官方文档进行安装和配置。在配置过程中,需要指定HBase的主节点和从节点,以及相关的配置参数,如端口号、数据目录等。

Ubuntu系统中分布式安装配置HBase-2.3.7_runepic的博客-CSDN博客![]() https://blog.csdn.net/weixin_40694662/article/details/131127434?spm=1001.2014.3001.5501

https://blog.csdn.net/weixin_40694662/article/details/131127434?spm=1001.2014.3001.5501

安装Spark

Spark是一个开源的分布式计算系统,用于处理大规模数据集。可以从Apache Spark官网下载Spark的安装包,并按照官方文档进行安装和配置。在配置过程中,需要指定Spark的主节点和从节点,以及相关的配置参数,如端口号、数据目录等。

分布式安装配置spark-3.2.3_runepic的博客-CSDN博客![]() https://blog.csdn.net/weixin_40694662/article/details/131165881?spm=1001.2014.3001.5501

https://blog.csdn.net/weixin_40694662/article/details/131165881?spm=1001.2014.3001.5501

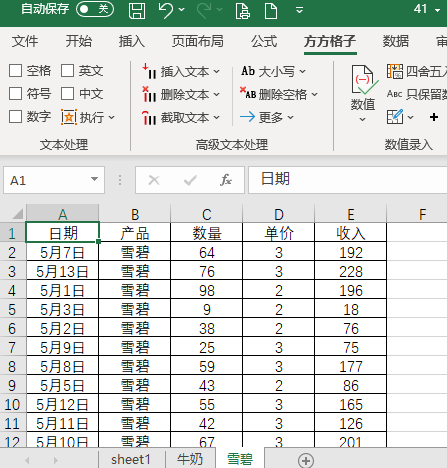

测试环境

安装完成后,需要测试Hadoop、HBase和Spark环境是否正常工作。可以使用Hadoop和Spark提供的样例程序进行测试,如WordCount和PageRank。测试过程中,需要注意查看日志输出和错误信息,以便进行排除故障。

启动方式可参照:

如何启动和关闭分布式集群_runepic的博客-CSDN博客![]() https://blog.csdn.net/weixin_40694662/article/details/131230085

https://blog.csdn.net/weixin_40694662/article/details/131230085

提交方式如下,后续开发jar包类似方式提交计算集群运行

bin/spark-submit --class org.apache.spark.examples.SparkPi --master yarn --deploy-mode client ./examples/jars/spark-examples_2.12-3.2.3.jar 10

也可启动spark shell 交互式计算