1.卷积神经网络底层原理

声明:以下为《大话计算机》作者冬瓜哥课程视频截图,仅供学习

1.1卷积

一张图经过一种卷积核(核函数)滑动窗口进行卷积运算后得到一张特征图,这只是这种卷积核视角下看到的特征。所以我们需要多种卷积核获得不同视角下的原图的特征。

使用不同的卷积核抓取不同的特征。卷积核是什么特征就会在原图中找这些特征。

1.2卷积神经网络(CNN)

卷积层 + DNN = CNN

卷积是为了提取原图特征码,解决了深度神经网络的两个问题:一、输入像素太多。二、对相似物体会判断失误,需要提高泛化能力。提取原图特征可以同时解决这两个问题。

先对原图做卷积处理,后将得到的图展开并送入到深度神经网络的输入层。

疑问:卷积处理之后的数据比原始信息更多了。卷积使得泛化能力提高了,但信息输入量也大幅提升了

解决办法:对特征图本身进行降质采样(直接降低其分辨率)。降质操作成为池化(Pooling),对特征图进行降质处理,特征仍然会大部分保留。为进一步降低输入信息量的数量,对于卷积生成的特征图中的像素值,如果为负值(机器调参可能将卷积核中某个值调成负值),则直接把它当作0看待,相当于直接剔除负值。这个剔除负值的函数叫做ReLU(修正线性单元)

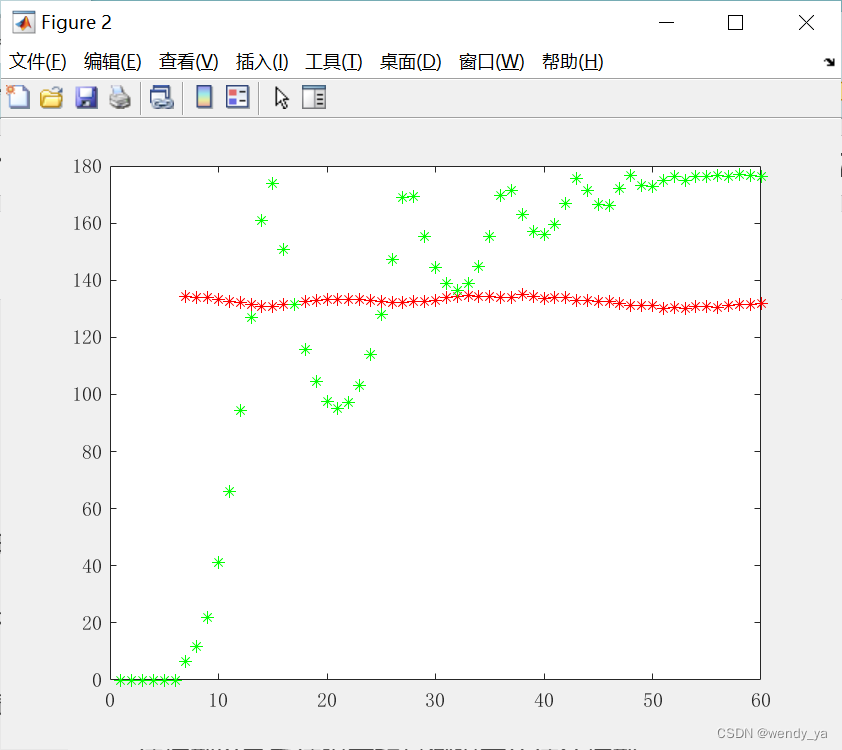

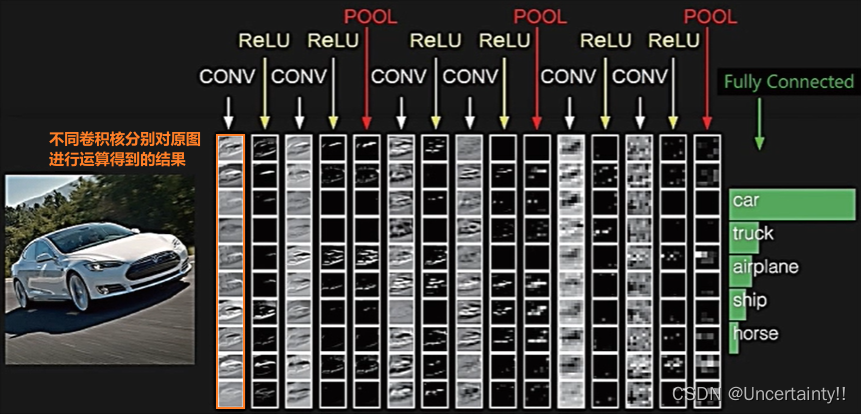

卷积过程:卷积(提取原图的某一特征)、ReLU(剔除特征图中负值)、池化 (对特征图降质)

通过多次卷积过程将一张图片逐步抽象

卷积核中的值一开始是随机给出的,靠机器学习不断训练迭代计算,最终穷举出有效的卷积核可以实现准确分类

你只能控制的是用多少个卷积核,以及其他一些周边参数。实际上你可能也不知道用多少个合适,就像你判断一个人,你也不知道该用哪些角度来端详他,只能靠经验,不断尝试,找出规律。这就是ML专家的价值。