本文详细配置名称节点的高可用,什么是高可用可参考官方文档

说在前面

- 工作环境:VMware® Workstation 12 Pro 12.5.6 build-5528349

- linux版本:CentOS-7-x86_64-Minimal-1611.iso

- JDK版本:jdk-8u65-linux-x64.tar.gz

- Hadoop版本:hadoop-2.7.6.tar.gz

关于高可用

-

满足 24 * 365

一年365天不间断运行

-

满足 99.999% (5个9)

一年最多宕机 365 * 24 * 0.0001 = 1 小时

生产环境介绍

本文配置供需要5台主机,具体情况如下

- 两个名称节点(s201, s205)

s201:192.168.32.201 //NameNode

s201:192.168.32.205 //NameNode

- 三个数据节点

s202:192.168.32.202 //DataNode

s203:192.168.32.203 //DataNode

s204:192.168.32.204 //DataNode

详细配置如下

1. 新增数据节点主机(s205),配置ssh

- 生成秘钥对,然后将公钥发给其他主机(s201, s202, s203, s204)

$>ssh-keygen -t rsa -P '' -f ~/.ssh/id_rsa$>cd ~/.ssh

$>cat id_rsa.pub >> authorized_keys

$>chmod 644 authorized_keys//重命名

$>mv id_rsa.pub id_rsa.pub.s205.0$>scp id_rsa.pub.s205.0 centosmin0@s201:/home/centosmin0/.ssh/authorized_keys

$>scp id_rsa.pub.s205.0 centosmin0@s202:/home/centosmin0/.ssh/authorized_keys

$>scp id_rsa.pub.s205.0 centosmin0@s203:/home/centosmin0/.ssh/authorized_keys

$>scp id_rsa.pub.s205.0 centosmin0@s204:/home/centosmin0/.ssh/authorized_keys

- 将s201主机的公钥发送给主机s205

$>scp id_rsa.pub centosmin0@s205:/home/centosmin0/.ssh/authorized_keys

2. 配置高可用生产环境

- 从原生产环境(full)中复制出高可用生产环境(ha):

$> cp -r /soft/hadoop/etc/full ha

- 将原生产环境(full)的符号链接指向高可用生产环境(ha):

xcall.sh "ln -sfT /soft/hadoop/etc/ha /soft/hadoop/etc/hadoop"

- 使用批处理脚本分发给其他主机

3. 配置core-site.xml和hdfs-site.xml文件(s201)

- core-site.xml

<!-- 配置hdfs文件系统名称服务 -->

<property><name>fs.defaultFS</name><value>hdfs://mycluster</value>

</property>

- hdfs-site.xml

<!-- 配置nameservice -->

<property><name>dfs.nameservices</name><value>mycluster</value>

</property><!-- myucluster下的名称节点两个id -->

<property><name>dfs.ha.namenodes.mycluster</name><value>nn1,nn2</value>

</property><!-- 配置每个nn的rpc地址 -->

<property><name>dfs.namenode.rpc-address.mycluster.nn1</name><value>s201:8020</value>

</property>

<property><name>dfs.namenode.rpc-address.mycluster.nn2</name><value>s205:8020</value>

</property><!-- 配置webui端口 -->

<property><name>dfs.namenode.http-address.mycluster.nn1</name><value>s201:50070</value>

</property>

<property><name>dfs.namenode.http-address.mycluster.nn2</name><value>s205:50070</value>

</property><!-- 名称节点共享编辑目录 -->

<property><name>dfs.namenode.shared.edits.dir</name><value>qjournal://s202:8485;s203:8485;s204:8485/mycluster</value>

</property><!-- java类,client使用它判断哪个节点是激活态 -->

<property><name>dfs.client.failover.proxy.provider.mycluster</name><value>org.apache.hadoop.hdfs.server.namenode.ha.ConfiguredFailoverProxyProvider</value>

</property><!-- 脚本列表或者java类,在容灾情况下保护激活态的nn -->

<property><name>dfs.ha.fencing.methods</name><value>sshfence</value>

</property>

<property><name>dfs.ha.fencing.ssh.private-key-files</name><value>/home/centosmin0/.ssh/id_rsa</value>

</property><!-- 配置JN存放edit的本地路径 -->

<property><name>dfs.journalnode.edits.dir</name><value>/home/centosmin0/hadoop/journal</value>

</property>

- 将文件呢分发给其他主机(s202, s203, s204, s205, s206)

4. 部署细节

- 在jn节点(每个数据节点就素一个jn节点)启动jn进程(s202, s203, s204)

$>hadoop-daemon.sh start journalnode

-

启动jn之后,在两个NN(名称节点)之间进行disk元数据同步

- 如果是全新集群,先format文件系统,只需要在一个nn上执行

[s201] $>hadoop namenode -format-

如果将非HA集群转换成HA集群,复制原NN的metadata到另一个NN

步骤一:清除原来的dfs

[s201]$>scp -r /home/centos/hadoop/dfs centos@s206:/home/centos/hadoop/步骤二:在新的NN(未格式化的NN)上运行以下命令(s205),实现待命状态引导(注意:需要启动s201的名称节点,提示是否格式化,选择N)

```$>hdfs namenode -bootstrapStandby```步骤三:在一个NN上执行以下命令,完成edit日志到jn节点的传输

$>hdfs namenode -initializeSharedEdits步骤四:启动所有节点[s201]$>hadoop-daemon.sh start namenode //启动名称节点$>hadoop-daemons.sh start datanode //启动所有数据节点[s205]$>hadoop-daemon.sh start namenode //启动名称节点```  -

HA管理

$>hdfs haadmin -transitionToActive nn1 //切成激活态

$>hdfs haadmin -transitionToStandby nn1 //切成待命态

$>hdfs haadmin -transitionToActive --forceactive nn2//强行激活

$>hdfs haadmin -failover nn1 nn2 //模拟容灾演示,从nn1切换到nn2

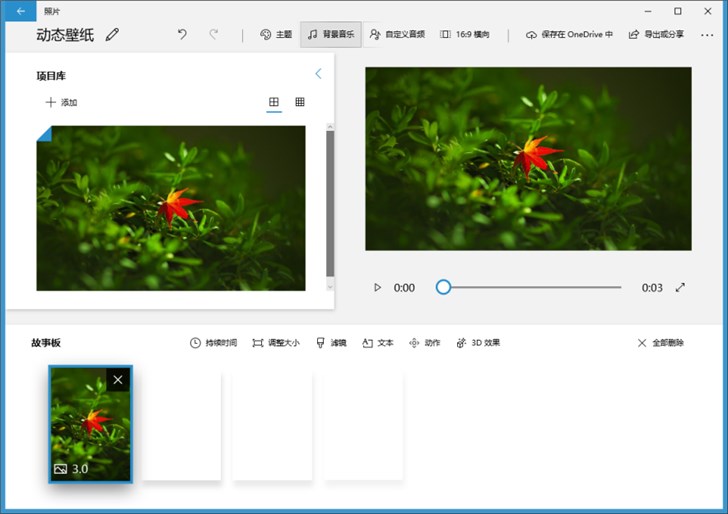

webui下成功状态:

s201:active状态(激活状态)

s205:standby状态(待命状态)

待命状态下无法访问文件系统: