我们现在生活在一个PhotoShop时代,PS已经成了一个动词。自从有了PS以后,很多事情变成了可能,因而网上各种图片的真实性变得难以分辨。

一、PS技术

Adobe作为著名的图形图像和排版软件的生产商,旗下的Photoshop、Premiere、After Effects等软件一直深受好评,特别是Photoshop由于其强大的功能,更是风靡全球。

2018年7月,美国时代周刊杂志刊登了特朗普与普京合成照,并且把这个合成照片用作《时代》封面。时代官方推特账号还发了一个动图,特朗普的脸渐渐变成普京,普京又变回特朗普。

PS技术修复老照片

利用PS技术对图片中的对象复制、粘贴

网友用PS技术自制的图片

二、反PS技术

尽管PS技术大部分时候都是用于“正途”的,但若滥用PS技术对于某些部门的取证工作将会带来一定的麻烦。

为了有效控制虚假视频和图片的传播,2019年6月中旬,全球最大的修图和音视频剪辑软件公司Adobe在博客上宣布,其研究人员(Richard Zhang、Oliver Wang)与加州大学伯克利分校的科学家(Sheng-Yu Wang、Andrew Owns和Alexi A.Efros)合作取得了新的研究成果,利用机器学习技术,可以检测出面部图像是不是被人为修改过的,即反PS技术工具。

去年Adobe就曾研究过用AI识别被篡改图像,可以识别三种类型的修改:拼接、复制和删除。图片每次被修改时都会留下痕迹,只是这些改动难以被人眼察觉,放大图片后,就能看到锋利的切割边缘、过度平滑的平面,以及不自然的噪点。奇热影视

研究人员训练了一个深度学习神经网络来识别图像处理。第一种方法是识别RGB的变化,第二种是识别噪点。这项技术将这两种方法结合起来用,以此实现更准确的识别。

上图中由左至右依次为:经修改的图像、检测到修改、自动还原后的图像、原始图像。

反PS技术检测到修改的部分

目前,该检测技术仅限于Photoshop的Face Aware Liquify功能。它是一个常用的工具,主要用于调整面部形状和改变面部表情。然而,这样的工具也经常被用来完全改变人脸以掩盖他们真实的样子。研究人员选择了一个包含Liquify编辑前后图像的人脸数据库,并基于其上训练了一个神经网络。

研究团队做了实验发现,由此产生的算法在检测图像真伪上非常有效。实验中,当被要求辨别照片是否被修过时,人工辨别出真伪的正确率为53%,而算法的正确率则高达99%。为了进一步完善这一设计,科研人员还尝试添加将照片恢复到原始图片的功能,但研究目前还未结束。

新的研究主要基于三个方面:

- 创建一种比人工更可靠的识别人脸是否修改的工具;

- 该工具是否可以解码对图像所做的特定更改;

- 是否可以撤消这些更改以查看原始内容。

目前,Adobe与加州大学伯克利分校的研究人员合作研究的这项反PS技术还处于早期阶段。对于这一研究成果,Adobe也表示目前没有将之立即商业化的计划。同时,公司的一位发言人也指出,目前Adobe在这方面的努力远不止于此,这只是它在用AI精准检测图像、视频、音频和文档操作方面的众多成果之一。

三、AI换脸技术

除了PS技术可以修改图片内容外,随后又出现了更为先进的AI换脸技术。2017年12月,一个名为“DeepFakes”的用户在Reddit上发布了一个“假视频”,他利用了深度学习和AI新技术,在成人电影中把演员的脸替换成他人的脸,从而制作成了这个看上去以假乱真的视频。这项AI Deepfakes就是基于人工智能的深度换脸技术。简单来说就是脸部替换,可以将B的脸换到A的脸上。比PS更为可怕的是,这项技术不仅可以生成图片,还可以生成视频。

在上图中,好莱坞女星盖尔·加朵(Gal Gadot)的脸换到了情色片的视频上了,而且达到以假乱真的效果。

某色情网站上的各种换脸视频

从这些视频发布后,网络上不断有人发表文章和报道,抨击这一“换脸”技术,称这种技术将会对社会产生很多负面的影响。比如说,这个“换脸”技术会给很多无辜清白的人造成困扰;“假视频”会加剧虚假新闻的散播,进而将大大损坏视频作为证据的可信度。

视频中普京的脸被换成了特朗普

影师作品中的换脸

女主播换脸

DeepFakes的出现可以说是人脸交换技术的一个突破。利用DeepFakes技术,只需要一个GPU和一些训练数据,就能够制作出以假乱真的换脸视频。

2019年5月,三星AI研究室创建了新的工具,通过机器学习,只要有几张图片,就可以合成为虚拟的视频。通常,要做出以假乱真的视频需要大量数据支持。但这项新的deepfake技术不再需要大量数据,新的神经网络只需要少量数据就能生成新的人脸信息甚至是视频,也就是说一张普通照片就能伪造一段视频。奇热影视

不只是面部表情,口型和声音也可以造假。此前,一批来自斯坦福大学、马克斯普朗克信息学研究所、普林斯顿大学和Adobe Research的研究人员组织了一个团队,他们创建了一种算法,能编辑头部特写的对话视频。这种应用从各种视频片段中提取讲话时的唇部动作,并采用机器学习将它“移植”到目标视频中,让观众看起来更自然。

利用DeepFakes技术将自己的表情附加到目标人物中

四、DeepNude技术

在DeepFakes据美国科技媒体Motherboard 6月27日报道,一位化名Alberto的程序员最近开发出一款名叫DeepNude的应用,只要给DeepNude一张女性照片,借助神经网络技术,App可以自动“脱掉”女性身上的衣服,显示出裸体。目前DeepNude只能处理女性照片,如果原图裸露的皮肤越多,处理效果越好;而上传男性照片,最后得出的照片还是替换成女性下体。

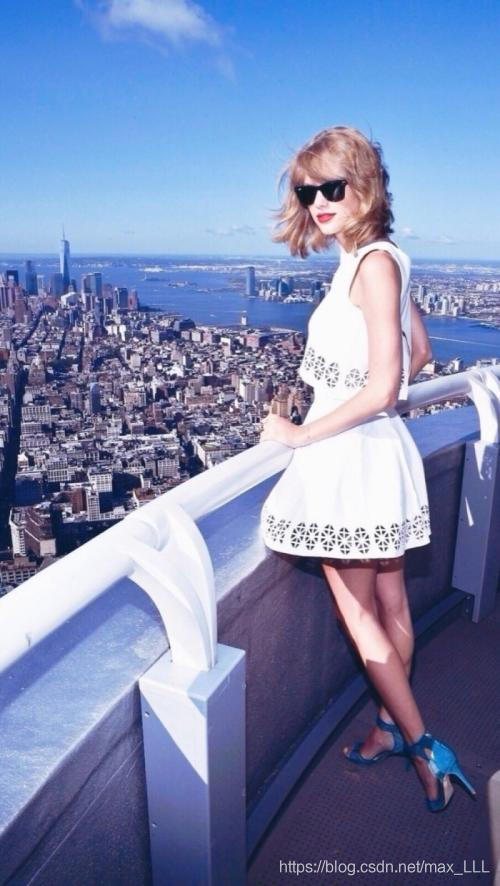

用DeepNude处理歌手泰勒·斯威夫特照片

Alberto表示,该软件基于加州大学伯克利分校研究者开发的开源算法pix2pix创建,并使用1万张女性裸图加以训练。这一算法与之前的人工智能换脸技术DeepFakes算法相似。

目前DeepNude官网已上线,照片可在官网处理,可下载的Windows和Linux应用也在6月23日推出,使用者无需专业知识。这款应用有免费版和50美元付费版。使用免费版获得的图片会出现较大水印,付费版虽然没有免费版出现的水印,但会在图片左上角加上“FAKE”(虚假)的印章式标注。

五、科学技术是双刃剑

任何事物总有两面性,事实上,本应造福人类的科学技术被滥用的例子数不胜数。比如:

- 诺贝尔发明硝酸甘油炸药本是为了采矿挖掘效率更高,却被广泛用于战争和恐怖袭击;

- 谷歌地球曾因为太过清晰,被用来探测他人隐私。

目前市场上存在大量P图、修图软件,甚至某些手机厂家在其产品上也推出了自带的美颜功能。对于社交媒体上的这些照片,或许其目的仅仅是出于爱美之心,但不得不承认,这些“照骗”的盛行,的确让我们对社交媒体的信任日渐下降。

越来越多的普通人掌握了PS技术,造假证、假章也变得很容易:

从安全角度来说,犯罪分子利用这些虚假的照片行骗,成功率也相应的提高了。另一方面,对于相关执法部门的人像取证工作,也增加了难度。

可以说,反PS技术的出现,可以在一定程度上降低此类风险,帮助执法人员鉴定伪造的数字影像的内容。

但从另一方面来说,反PS技术如果也被恶意利用,亦会产生一些不好的影响。例如,去马赛克。众所周知,照片打码在某种程度上是对个人的隐私进行保护的一种基本措施。例如:

- 医院影响资料中,对患者照片进行打码;

- 新闻采访中,对某些当事人/受害者面部打码。

除了面部打码,更多的是在社交媒体中对某些照片中的关键信息打码,防止隐私泄露。例如:火车票,飞机票、登机牌、护照,证件、车牌等。

但反PS技术一旦成熟,且被不法分子恶意利用,照片中的这些马赛克便失去了保护隐私的意义。

此外,对于某些按要求规定必须经特殊处理后才能发布的照片,反PS技术同样也会带来一定的风险。如在某些军事基地、关键基础设施拍摄的可能涉及国家机密信息的图片,其中的打码信息如果被还原,其危害不言而喻。

科学技术的发展使人类不断获得新的能力和财富,享受到科技进步带来的种种好处,但也使人类面临科技的挑战,甚至承担着不堪忍受的代价。正当的运用科学技术,为人类造福,才能推断世界和谐发展。

![[“吊打面试官“系列之] 一晚带你玩转图片懒加载及其底层原理](https://img-blog.csdnimg.cn/20200801232108541.gif#pic_center)