目录

前言

参数解释

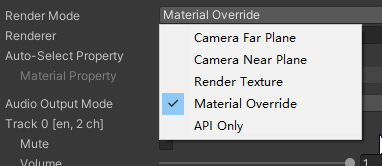

RenderMode渲染方式

VideoPlayer类中的API

前言

在之前的VR场景中已经使用过VideoPlayer播放视频(Unity.UI的交互(6)-播放视频),不过在VR中设置是有些不同的,这里更详细地说明一下VideoPlayer组件的设置与使用,以及VideoPlayer类中常用的API。

参数解释

其中: Source——视频源,设置为VideoClip就可以选择Assets文件夹内的视频文件,也可以设置为URL,播放网络上的视频(需要用一些工具去获取视频源地址);

Audio Output Mode——声音的播放是通过视频,或是其他声音源

RenderMode渲染方式

常用的是前4种:

1. Camera Far Plane——基于摄像机的渲染,渲染在摄像机的远平面上,这时候视频在最远的地方播放:

2. Camera Near Plane——基于摄像机的渲染,渲染在摄像机的近平面上,这时候视频会将所有画面都覆盖了:

选择以上两种时,都需要选择相应的摄像机。

3. RenderTexture——将视频画面保存在RenderTexture上,用来做基于UGUI的播放器(就是使用UI组件播放)

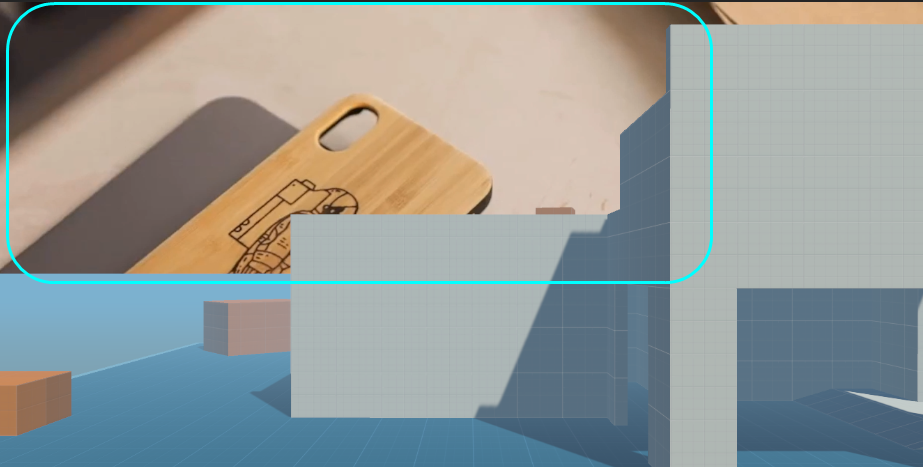

4. Material Override——将视频画面复制给所选Render的Material,比如可以附着在场景内的任何物体上,建立一个球Sphere,将球拖到Renderer内,它就在球上播放:

VideoPlayer类中的API

在使用VideoPlayer类之前,需要引入命名空间UnityEngine.Video,代码中可以通过getCompoment<VideoPlayer>()获取组件,并修改其参数:

clip——视频片段

frameCount——视频的总帧数

frameRate——视频的帧率

time——视频当前播放的时间

Play()——播放

Paurse()——暂停