大数据技术概论

大数据技术的产生

大数据的基本概念

●大数据简介:

大数据是规模非常巨大和复杂的数据集,传统数据库管理工具处理起来面临很多问题,比如说获取、存储、检索、共享、分析和可视化,数据量达到PB、EB或ZB的级别。

大数据有三个V:

一是数据量(Volume),数据量是持续快速增加的;

二是高速(Velocity)的数据;三是多样化(Variety)数据类型和来源。

随着云时代的来临,大数(Big data)也吸引了越来越多的关注。支撑大数据以及云计算的底层原则是一样的,即规模化、自动化、资源配置、自愈性。

●大数据的处理流程

数据采集数据统计分析数据挖掘

1.数据采集:

利用多种轻型数据库来接收发自客户端的数据,并且用户可以通过这些数据库来进行简单的查询和处理工作,具有并发性高的特点。经常使用的产品有:MySQL,Oracle,HBase,RedisMongoDB和等,并且这些产品的特点各不相同

2.统计分析:

将海量的来自前端的数据快速导入到一个集中的大型分布式数据库或者分布式存储集群,利用分布式技术来对存储于其内的集中的海量数据进行普通的查询和分类汇总等,以此满足大多数常见的分析需求。会面临:导入数据量大,查询涉及的数据量大,查询请求多的挑战。

3数据挖掘

基于前面的查询数据进行数括挖掘,来满足高级别的数据分析需求:这一步面临算法复杂,并且计算涉及的数据量和计算量都大的难题。一般使用R/SAS等统计软件。

●大数据在各个领的应用

咨询业:BM对50000名咨询顾问的档案建立了数学模型,从而计算机可以对不同的项目自动挑选出最合适的团队。广告业:硅谷的最优边界公司对网上广告提供了优化服务,对每一条网上广告都可以计算出反应率和投资收益率市场营业:

UMBRIA公司通过数值计算选择博客网站上应该跳出来的广告产品,通过向量数学,可以确认汉堡王的广告的确对年轻人的目标客户最有效媒体业:

纽约的 INFORM公司运用几何学原理将文章根据单词和词组进行转换,存入虚图书馆,然后根据读者档案挑选出最适合读者阅读的文章提供给读者社交网络:

社交网络产生了海量用户以及实时和完整的数据,同时社交网络也记录了用户群体的情绪,通过深入挖握这些数据来了解用户,然后将这些分析后的数据信息推给需要的品牌商家或是微博营销公司。

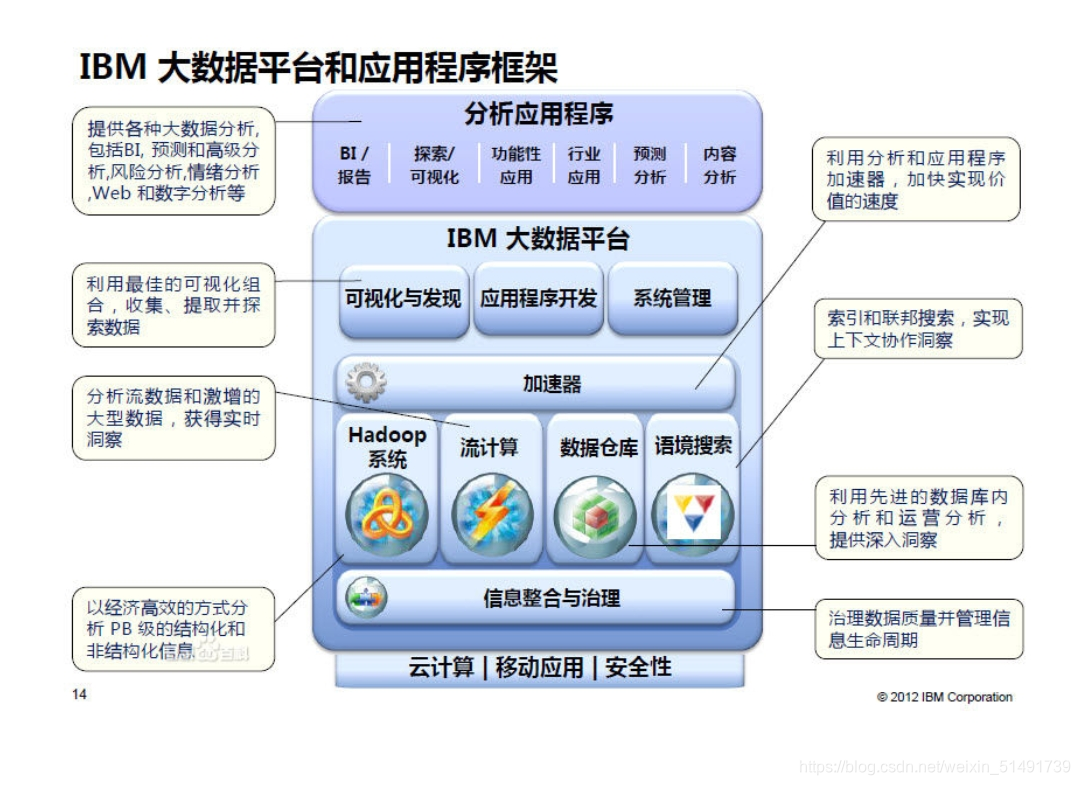

●IBM的大数据战略

基于“3A5步”动态路线图,IBM提出了“大数

据平台”架构。该平台的四大核心能力包括

Hadoop系统、流计算

(StreamComputing)、数据仓库(DataWarehouse)和信息整合与治理(InformationIntegration and Governance)。

大数据产生的原因

1,互联网的发展,产生海量可获得的非结构化数据。

2,传统数据库在处理非结构化数据出现瓶颈。

3,分布式技术和搜索技术的发展。

大数据概念的提出

1、“大数据的名称来自于未来学家托夫勒所著的《第三次浪潮》尽管“大数据”这个词直到最近才受到人们的高度关注,但早在1980年,茗名未来学家托夫勒在其所著的《第三次浪潮》中就热情地将“大数据”称颂为“第三次浪潮的华彩乐章”。《自然》杂志在2008年月推出了名为大数据”的封面专栏。从2009年开始“大数据”才成为互联网技术行业中的热门词汇。

2、最早应用大数据的是麦肯锡公司(McKinsey)对“大数据”进行收集和分析的设想,来自于世界著名的管理咨询公司麦肯锡公司。麦肯锡公司右到了各种网络平台记录的个人淘备潜在的商业价值,于是投入大量人力秘密进行调研,在2011年6月发布了关于大数据”的报告:该报告对“大数据”的影响、关键技术和应用领域等都进行了详尽的分析。麦肯锡的报告得到了金融界的高度重视,而后逐渐受到了各行各业关注。

3、“大数据的特点由维克托迈尔恩伯格和肯尼斯库克耶在大数据时代》中提出过维克托迈尔舍恩怕格和肯尼克耶编写的大数据时代中提出:“大数据的4V特点: volume(数据量大)、 Velocity入和处理速度快)、 Variely(数据多样性)、 Value(价值密度低)。这些特点基本上得到了大家的认可,凡提到“大数据特点的文章,基本上采用了这4个特点。

4、在云计算出现之后大数据才凸显其真正价值自从有了云计算服务器,“大数据”才有了可以运行的轨道,才可以实现其真正的价值有人就形象地将种“大数据的应用比作一辆辆汽车”,支撑起这些“汽车”运行的“公路“就是云计算,最名的实例就是Google搜索引擎面对海量Weh数据:Google于2006年首先提出云计算的概念。支撑Gogl内部各种“大数据应用的,正是 Gougle公司自行研发的云计算服务器。

“大数据”的基本判断标准

什么样的数据才是“大数据”?透过层层的迷雾和众说纷纭,可以讲:有了云计算服务器才有了“大数据”应用的价值。维克托曾说过:“假设你要测量一个葡萄园的温度,但是整个葡萄园只有一个温度测量仪,那你就必须确保这个测试仪是精确的而且能够一直工作。反过来,如果每100棵葡萄树就有一个测量仪,有些测试的数据可能会是错误的,也可能会更加混乱,但众多的读数合起来就可以提供一个更加准确的结果。因为这里面包含了更多的数据,而它提供的价值不仅能抵消掉错误数据造成的影响,还能提供更多的额外价值。现在想想增加读数频率的这个事情。如果每隔一分钟就测量一下温度,十次甚至百次的话,不仅读数可能出错,连时间先后都可能搞混。试想,如果信息在网络中流动,那么一条记录很可能在传输过程中被延迟,在其到达的时候已经没有意义了,甚至干脆在奔涌的信息洪流中彻底迷失。虽然得到的信息不再准确,但收集到的数量庞大的信息让我们放弃严格精确的选择变得更为划算为了高频率而放弃了精确性,结果观察到了一些本可能被错过的变化。虽然如果能够下足够多的工夫,这些错误是可以避免的,但在很多情况下,与致力于避免错误相比,对错误的包容会带来更多好处。为了规模的扩大,我们接受适量错误的存在。”其中描述葡萄园测量仪采集的数据就是大数据。大数据实质上是全面、混杂的并且具有数据量大、输入和处理速度快、数据多样性、价值密度低特点的数据。

第四范式——大数据对科学研究产生的影响

吉姆·格雷是一个传奇人物。他是1998年图灵奖得主,著名的计算机科学家。2007年1月28日,他在自己酷爱的航海运动中驾驶帆船失踪于茫茫大海之上。短短17天之前,1月11日,他在加州山景城召开的NRC-CSTB(National Research Council-Computer Science and Telecommunications Board)上,发表了他的著名演讲:科学方法的一次革命。在这篇演讲中,吉姆·格雷将科学研究的范式分为四类——除了之前的实验范式、理论范式、仿真范式之外,新的信息技术已经促使新的范式出现——数据密集型科学发现(Data-Intensive Scientific Discovery)。

这个第四范式,所谓的“数据密集型”,也就是现在我们所称的“大数据”。

吉姆·格雷(左)

一、何谓“第四范式”

“范式”一词,英文名Paradigm,一般指已经形成模式的,可直接套用的某种特定方案或路线。在计算机科学界,编程有编程范式,数据库有数据库架构的范式,不一而足。

总之,你将其认为是某种必须遵循的规范或大家都在用的套路即可。

在科学发现领域,第一范式,是指以实验为基础的科学研究模式。简单说来,就是以伽利略为代表的文艺复兴时期的科学发展初级阶段。在这一阶段,伽利略老师爬上比萨斜塔扔俩铁球,掐着脉搏为摆动计时等等我们耳熟能详的故事,为现代科学开辟了崭新的领域,开启了现代科学之门。

当实验条件不具备的时候,为了研究更为精确的自然现象,第二范式,即理论研究为基础的科学研究模式随之而来。在这个阶段,科学家们会将无法用实验模拟的科学原理用模型简化,去掉一些复杂的因素,只留下关键因素,然后通过演算得到结论。比如我们熟知的牛顿第一定律:任何物体都要保持匀速直线运动或静止状态,直到外力迫使它改变运动状态为止。这个结论就是在假设没有摩擦力的情况下得出的。令人欣喜的是,当时的理论科学与实验科学结合得如此完美,任何一个理论都很容易被实验所证实。因此第二范式很快成为了重要的科研范式。

第二范式发展到极致是19世纪末,当时牛顿三大定律解释了经典力学,麦克斯韦理论解释了电磁学。经典物理学的大厦构建得宏伟壮观,而且似乎毫无瑕疵。

结果在20世纪初,天边的两朵乌云无情地破坏了它的完美。量子力学和相对论两座暂新的高山拔地而起,那是科学的另一个黄金时代。然而,不论是量子力学还是相对论,不约而同地以理论研究为主,超凡的头脑和计算超越了实验。尽管在一段时间之后,经过复杂设计的实验终究还是证实了计算的理论。因此每一位中学物理老师都会把牛顿和爱因斯坦相提并论,并称人类历史上最伟大的两位物理学家。

随着验证理论的难度和经济投入越来越高,正在科学研究逐渐力不从心之际,另一位顶尖科学家站了出来。冯·诺依曼老师,在上世纪中期提出了现代电子计算机的架构,并一直持续到今天。

冯·诺依曼

于是,随着电子计算机的高速发展,第三范式,即利用电子计算机对科学实验进行模拟仿真的模式得到迅速普及。不论在基础科学研究还是工程实验中,计算机仿真越来越多地取代实验,成为科研的常用方法。

半个世纪之后的2013年,诺贝尔化学奖甚至授予了用计算机模拟开发多尺度复杂化学系统模型的科学家卡普拉斯、莱维特和瓦谢勒。诺贝尔化学奖评选委员会在当天发表的声明中说:现在,对化学家来说,计算机是同试管一样重要的工具,计算机对真实生命的模拟已为化学领域大部分研究成果的取得立下了“汗马功劳”。

那么,当时间进入互联网时代,吉姆·格雷认为,鉴于数据的爆炸性增长,数据密集范式理应并且已经从第三范式即计算范式中分离出来,成为一个独特的科学研究范式,即“第四范式”。

二、“第四范式”的特点

同样是计算,第四范式与第三范式有什么区别呢?

最显著的区别就是:

计算范式是先提出可能的理论,再搜集数据,然后通过计算仿真进行理论验证。

而数据密集型范式,是先有了大量的已知数据,然后通过计算得出之前未知的可信的理论。

简单举个例子说明吧。以前我们对一个问题(比如雾霾)进行研究是这样的:首先,发现问题,比如出现雾霾了,想知道雾霾是什么,怎么预防。其次,发现这个事儿好像不那么简单,雾霾的形成机理除了源头、成分等东西之外,还包括气象因素,包括地形、风向、湿度等等,参数之多超出了我们的控制范围。那么我们要怎么办呢?去除一些看起来不怎么重要的参数,保留一些简单的参数,提出一个理论。然后搜集数据,用计算机进行模拟,并不断对理论进行修正。最后得出可信度比较高的结果,以此来对可能形成雾霾天气的预测。

这条途径大家都熟悉,这就是第三范式。

但是,这条途径中有一个看起来很小的问题:你如何确定哪些参数是重要的,哪些是不重要的?那些看起来不重要的参数,会不会在某些特定条件下,起到至关重要的作用?毕竟南美洲的一只蝴蝶扇扇翅膀都可能引起印度洋的风暴啊不是么?

从这一点来看,能够获取最全面的数据,也许才能真正探寻到雾霾的成因,以及做出更科学的预测。那么第四范式就是这样一个研究方法。

首先,布置海量的监测点,收集海量的数据。海量的意思就是比传统意义上多得多。传统意义上我们在北京市布置几十个上百个监测点,海量的意思……嗯,我们假设每款手机都自带PM2.5测量功能,这样全北京市就有2000万的监测点,而且这些监测点还有空间的移动信息。这样相对于固定监测点所产生的数据,就是海量数据。

其次,利用这些数据,分析得出雾霾的形成原因和预测。

最后,验证预测,从中总结出理论。

大家已经看到了,第二和第三步我都只用了一句话。不是因为它很简单,恰恰相反,而是因为它太复杂,我无法在这篇小文章中详细阐述。

事实上,在当今,许多研究人员所面临的最大问题,已经不是缺少数据,而是面对太多的数据,不知道怎么来使用它们。因为这种体量的数据,基本上可以认为,已经超出了普通人的理解和认知能力。

幸运的是我们有了超级计算机,有了计算集群,有了超大的分布式数据库,还有了基于互联网的云计算。这就使得运用第四范式的科学研究成为了可能。

三、“第四范式”的挑战

第四范式科研已经在气象和环境、生物和医学方面取得了很大进展,但很明显,随着移动互联网的发展,各行各业产生的数据呈现爆炸式的增长,科研人员所面对的各个领域的数据只会越来越多。那么问题来了,实现第四范式的科研,从中发现更多更新的成果,所面临的挑战有哪些呢?

第一,不同结构数据的整合。

作为一个研究雾霾的人员,我需要气象数据,还需要工厂排放的数据、汽车尾气的数据,这些不同来源的数据势必有不同的形态。简单点说,一个excel表跟一个word文档,怎么把它们结合起来使用(当然实际情况比这个复杂得多)。

这是一开始我们要使用第四范式时就会面对的最大问题。

第二,海量数据的处理。

你使用的excel表可以处理多少条数据?很多人可能不知道,一个工作表是65535行(2的16次方=65536)和255列(2的8次方=256)。桌面使用的Access数据表呢?我实际使用中,基本上超过十万条速度就会很慢了。SQL Server或者Oracle这类商用数据库?百万到千万级数据记录问题不大,过亿甚至到千亿的量级,凭借分布式处理也还可以支撑。但更多呢?千万亿量级呢?

不要以为千万亿量级是一个很遥远的概念。简单起见,不按1024按1000算,一MB就是一百万Byte,一GB就是十亿,一TB就是万亿,一PB就是千万亿……PB后面是EB、ZB、YB。

嗯,阿里巴巴2014年3月宣布其数据量已经超过100PB。所以说,当你想剁手的时候,想像一下你给这么多数据里所做的贡献也不过是沧海一粟,估计负罪感会减轻很多吧。

为了解决这么多数据的问题,常见的数据库肯定是只能摊手了。好在做搜索引擎的那些人早就要面对这个问题,然后他们也比较好地解决了这个问题。谷歌的MapReduce架构,阿帕奇在此基础上弄出的Hadoop,几年的功夫就席卷了计算机界,成为目前分析大数据的领先平台。所以现在这个问题暂时算是解决了,当然了,永远只能是“暂时”解决。

第三,算法的发展。

其实针对大数据的算法没多少好说的,基本上还是最开始那些算法。最基本的,贝叶斯、决策树、k-关联算法、聚类分析。值得一提的是人工智能,从70年代发展以后,近几年人工智能倒是借着大数据的东风发展了一把。因为人工智能主要依靠大量数据的训练,所以数据越多,对人工智能的训练就越靠谱。因此类似于人工智能、遗传算法之类的分层次不太可控的算法,应该是发展方向。

第四,研究结论的展现。

这是值得一提的方面。对于大数据的分析,展现出的结论一般人未必能直观地了解。本来嘛,过亿数量级的数据,已经超出了人类统计学的理解能力。如何将其展现给人类(甲方/用户/普通群众),则是一个如何将神化的东西接地气的问题。大数据分析结果的可视化,在近几年确实是一个热点。另一方面,移动互联时代,读图比读文字要直观得多(本文只有文字而没有图是一大缺陷,希望我罗里吧嗦的文字能够让看的人看得懂)。大家在微博上看到的大部分大数据分析结论,都是图片更直观。因此,如何将研究结果展现出来,让人脑能够接受,这也是一个很重要的问题。

数据的可视化展示

四、高校利用“第四范式”开展科研

本来作为科普文,到第三部分也就可以结束了。但身为高校的一份子,有些事情还是想继续说说,遂有此部分文字。

作为科研的主力军,我国高校承担了国家70%以上的科研项目,并取得了大量的科研成果。同时,自上世纪八十年代以来,我国高校迅速经过第一和第二范式的科研训练,很快接受了第三范式。计算机仿真成为科研中快速追赶世界领先水平的重要手段。

然而,面对大数据海啸(这个词已经取代了“浪潮”成为更形象的比喻了)的第四范式,我国高校却面临一定的困局。

首先,收集并管理海量数据,需要巨量的投入。没有一所高校或研究机构能够负担上千万台服务器这样的投入。另一方面,在互联网和云计算技术已经发展成熟的时代,重复投入建设也是一种巨大的浪费。

其次,大部分高校尚未能理解大数据对于科研意味着什么。提出理论、进行模拟和仿真、得到结论这一传统步骤仍然是主要的研究方式,更遑论大数据的基本原理和分析方法,很多科研人员更是所知寥寥。

这一困局无法突破,科研的未来只能继续跟在别人身后亦步亦趋,难以在工程学科、社会学科等方面得出重大的成果。而如果能够突破这一困局,或许将成为我国整个科技工作实现弯道超车的关键。事实上,非洲一些贫困国家的科研,已经通过互联网实现与欧洲或北美的共同研究,并取得了相当快的进展。利用欧洲和北美积累的科研大数据,非洲一些国家比如肯尼亚、南非、阿尔及利亚的科研水平得到了大幅的提高。

传统大数据研究的步骤

(作者)个人认为,要积极拥抱科研的“第四范式”,国内高校需要在以下几个方面取得突破:

1、尽快搭建自身的虚拟云平台,为科研人员提供虚拟计算空间。目前浙江大学已经计划与阿里巴巴合作建设私有云,将来为每位教师提供个人的计算空间服务。

2、将云计算、大数据分析技术作为基础课程设置,使其作为科研的基本工具和必要科研素质。

3、与大型互联网企业进行合作,作为科研平台建设的一部分,力争以低廉价格获取各类海量数据和计算资源。在这方面,斯坦福大学与亚马逊云服务的合作可作借鉴。亚马逊为美国大学提供廉价的云计算资源及可供分析的数据资源,解脱了大学对于这方面巨量投入的负担,同时也使得亚马逊积累的海量数据能够得到更好的利用。

4、以交叉学科平台建设、协同创新中心建设等多样化的科研模式创新,促进不同类型不同来源数据的整合,形成新知识新发现的不断涌现。

综上,数据密集型科技发现范式,超越了时间和空间的限制,也超越了学科藩篱,是科技发展史上难得的契机。抓住其发展方向,扩大其应用范围,实现我国科研的跨越式发展并非天方夜谭。

云计算与大数据的关系

云计算:云计算是通过互联网提供全球用户计算力、存储服务,为互联网信息处理提供硬件基础。云计算,简单说就是把你自己电脑里的或者公司服务器上的硬盘、CPU都放到网上,统一动态调用,现在比较有名的云计算服务商是亚马逊的AWS。

大数据:大数据运用日趋成熟的云计算技术从浩瀚的互联网信息海洋中获得有价值的信息进行信息归纳、检索、整合,为互联网信息处理提供软件基础。大数据,简单说,就是把所有的数据放到一起分析,找到关联,实现预测。这里的所有数据对应的是之前的抽样调研取得的部分数据。

云计算与大数据的关系:

云计算是基础,没有云计算,无法实现大数据存储与计算。大数据是应用,没有大数据,云计算就缺少了目标与价值。两者都需要人工智能的参与,人工智能是互联网信息系统有序化后的一种商业应用。这才是:云计算与大数据真正的出口!

而商业智能中的智能从何而来?方法之一就是通过大数据这个工具来对大量数据进行处理,从而得出一些关联性的结论,从这些关联性中来获得答案,因此,大数据是商业智能的一种工具。 而大数据要分析大量的数据,这对于系统的计算能力和处理能力要求是非常高的,传统的方式是需要一个超级计算机来进行处理,但这样就导致了计算能力空的时候闲着、忙的时候又不够的问题, 而云计算的弹性扩展和水平扩展的模式很适合计算能力按需调用,因此,云计算为大数据提供了计算能力和资源等物质基础。

大数据的4V特征

大数据的主要应用及行业推动力量

1.主要应用

1)联网企业可以应用大数据技术,通过监控并分析每日产生的几百GB的网络广告用户点击数据,了解哪些用户在哪些时段点击广告,从而判断广告投放是否有价值,并及时进行调整。

2)智能电网可通过大数据技术对用户的用电数据进行监测,智能电表每隔几分钟就将这些数据采集并发送到后端集群中,之后集群就会对这数亿条数据进行分析,得出用户大概的用包模式,根据用电模式来调节电力生产,这样就能够有效避免电力资源的浪费。

3)车联网应用大数据技术。车载终端每隔几分钟都会上传一些路况数据到后 端数据集群县,后台会分析这些数据来判断大致路况是什么情况,之后将有价值的路况信息推送到客户岩,能够帮助客户节省在路上的时间。

4)医疗大数据。在医疗行业,每个人看病都有病例,如果把全国几千万病例都汇总起来c后进行数据分析和数据处理,就会从中找出一一些模式和规律,通过这些模式和规律可以非常助于医生对各种疾病的诊治。

2.基本应用

大数据在许多行业都有应用,比如制造业、金融业、汽车行业、互联网行业、餐饮行业、电信行业、能源行业、物流行业、城市管理、生物医学、功能安全领域等等。具体的应用有产品故障诊断与预测、信贷风险分析、商品推荐和针对性广告投放、流行病预测、犯罪预测等等

我国政府推动大数据行业发展

大数据已成为当前经济发展和国家竞争力提升的新引擎,不但促进社会创新,还引起社会结构的重大变革,给全球带来了深远影响。科多大数据带你走进各地方政府的大数据发展规划。

1.地方政府的大数据发展计划简介(1)广东:

2012年12月出台《广东省实施大数据战略工作方案》,2014年2月成立广东省大数据管理局作为专门职能部门,负责政府大数据公开和开发引导,2014年5月出台《广东省信息化促进条例》,作为对大数据战略的制度保障。整体来看,广东省大数据战略侧重于在政府职能转变时期提升公共服务水平,促进政府和社会的良性互动。

(2)重庆:

2013年6月发布《重庆市大数据行动计划》,其中涉及内容较为全面,包括建设大数据产业基地,结合政府和社会的力量构建大数据采集体系,鼓励社会资本加入开发公共服务大数据应用,重点在于结合前期云计算发展框架,完善大数据产业生态链的建设。

(3)上海:

2013年7月发布《上海推进大数据研究合发展三年行动计划(2013-2015)》,提出大数据公共服务平台并具体规划了6个公共服务领域,2014年5月提出通过上海政府数据服务平台向公众开放政府大数据的具体计划,并初步投入试运营,其战略部署重视大数据资源的共享开发,构建大数据产业链。

(4)天津:

2013年11月,发布《滨海新区大数据行动方案(2013-2015)》,指向ICT相关4个领域的重点建设,包括引进大数据企业、建设数据中心等,其中包括1个大数据产业示范基地和3个产业园区,目标是建设具有国际水平的大数据资源聚集区和大数据产业中心。

(5)贵州:

2014年3月发布《关于加快大数据产业发展应用若干政策的意见》和《贵州省大数据产业发展应用规划纲要(2014~2020年)》,设定了建设大数据产业示范园区,引进和培育大数据龙头企业,通过大数据带动相关产业发展,引进和培养大数据人才的战略目标。其中有对于公共大数据资源的开发共享、电子政务云等多项“云上贵州”工程的具体规划。

(6)陕西:

2014年5月成立陕西省大数据产业联盟,以“西咸新区大数据产业园”为载体吸引大数据企业入驻,同时结合高校科研资源提升大数据开发水平。但对于公共大数据的共享和利用,还没有具体的部署。此外,自2013年开始,湖北、青海等多省份也开始布局大数据规划,其主要内容和关键目标各有侧重。

大数据的关键技术

大数据关键技术涵盖数据存储、处理、应用等多方面的技术,根据大数据的处理过程,可将其分为大数据采集、大数据预处理、大数据存储及管理、大数据处理、大数据分析及挖掘、大数据展示等。

1、大数据采集技术

大数据采集技术是指通过 RFID 数据、传感器数据、社交网络交互数据及移动互联网数据等方式获得各种类型的结构化、半结构化及非结构化的海量数据。

因为数据源多种多样,数据量大,产生速度快,所以大数据采集技术也面临着许多技术挑战,必须保证数据采集的可靠性和高效性,还要避免重复数据。

2、大数据预处理技术

大数据预处理技术主要是指完成对已接收数据的辨析、抽取、清洗、填补、平滑、合并、规格化及检查一致性等操作。

因获取的数据可能具有多种结构和类型,数据抽取的主要目的是将这些复杂的数据转化为单一的或者便于处理的结构,以达到快速分析处理的目的。

3、大数据存储及管理技术

大数据存储及管理的主要目的是用存储器把采集到的数据存储起来,建立相应的数据库,并进行管理和调用。

4、大数据处理

大数据的应用类型很多,主要的处理模式可以分为流处理模式和批处理模式两种。批处理是先存储后处理,而流处理则是直接处理。

扩展资料:

大数据无处不在,大数据应用于各个行业,包括金融、汽车、餐饮、电信、能源、体能和娱乐等在内的社会各行各业都已经融入了大数据的印迹。

1、制造业,利用工业大数据提升制造业水平,包括产品故障诊断与预测、分析工艺流程、改进生产工艺,优化生产过程能耗、工业供应链分析与优化、生产计划与排程。

2、金融行业,大数据在高频交易、社交情绪分析和信贷风险分析三大金融创新领域发挥重大作用。

3、汽车行业,利用大数据和物联网技术的无人驾驶汽车,在不远的未来将走入我们的日常生活。

4、互联网行业,借助于大数据技术,可以分析客户行为,进行商品推荐和针对性广告投放。

5、电信行业,利用大数据技术实现客户离网分析,及时掌握客户离网倾向,出台客户挽留措施。

典型的大数据计算结构

大数据包括结构化、半结构化和非结构化数据,非结构化数据越来越成为数据的主要部分。

据IDC的调查报告显示:企业中80%的数据都是非结构化数据,这些数据每年都按指数增长60%。

大数据就是互联网发展到现今阶段的一种表象或特征而已,没有必要神话它或对它保持敬畏之心,在以云计算为代表的技术创新大幕的衬托下,这些原本看起来很难收集和使用的数据开始容易被利用起来了,通过各行各业的不断创新,大数据会逐步为人类创造更多的价值。

其次,想要系统的认知大数据,必须要全面而细致的分解它,着手从三个层面来展开:

第一层面是理论

理论是认知的必经途径,也是被广泛认同和传播的基线。

在这里从大数据的特征定义理解行业对大数据的整体描绘和定性;

从对大数据价值的探讨来深入解析大数据的珍贵所在;

洞悉大数据的发展趋势;

从大数据隐私这个特别而重要的视角审视人和数据之间的长久博弈。

第二层面是技术

技术是大数据价值体现的手段和前进的基石。

在这里分别从云计算、分布式处理技术、存储技术和感知技术的发展来说明大数据从采集、处理、存储到形成结果的整个过程。

第三层面是实践

实践是大数据的最终价值体现。在这里分别从互联网的大数据,政府的大数据,企业的大数据和个人的大数据四个方面来描绘大数据已经展现的美好景象及即将实现的蓝图。

大数据经典应用案例:

洛杉矶警察局和加利福尼亚大学合作利用大数据预测犯罪的发生。

google流感趋势(Google Flu Trends)利用搜索关键词预测禽流感的散布。

统计学家内特.西尔弗(Nate Silver)利用大数据预测2012美国选举结果。

麻省理工学院利用手机定位数据和交通数据建立城市规划。

梅西百货的实时定价机制。根据需求和库存的情况,该公司基于SAS的系统对多达7300万种货品进行实时调价。

医疗行业早就遇到了海量数据和非结构化数据的挑战,而近年来很多国家都在积极推进医疗信息化发展,这使得很多医疗机构有资金来做大数据分析。

现在的社会是一个高速发展的社会,科技发达,信息流通,人们之间的交流越来越密切,生活也越来越方便,大数据就是这个高科技时代的产物。