什么是全连接神经网络?怎么理解“全连接”?

1、全连接神经网络解析:对n-1层和n层而言,n-1层的任意一个节点,都和第n层所有节点有连接。即第n层的每个节点在进行计算的时候,激活函数的输入是n-1层所有节点的加权。

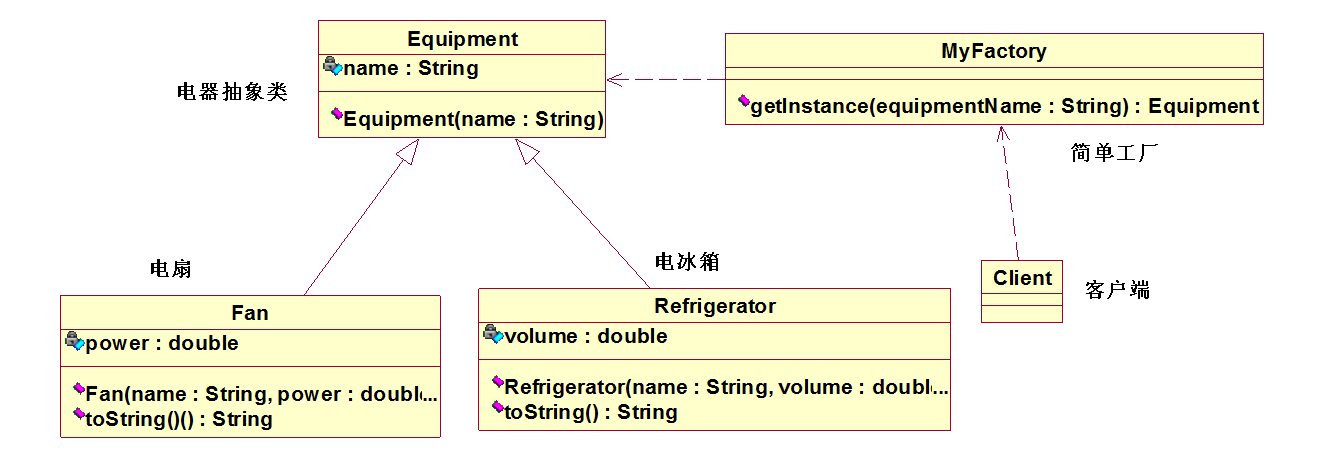

2、全连接的神经网络示意图:3、“全连接”是一种不错的模式,但是网络很大的时候,训练速度回很慢。部分连接就是认为的切断某两个节点直接的连接,这样训练时计算量大大减小。

神经网络1、一般的SGD的模型只有一层WX+b,现在需要使用一个RELU作为中间的隐藏层,连接两个WX+b,仍然只需要修改Graph计算单元为:而为了在数学上满足矩阵运算,我们需要这样的矩阵运算:这里N取1024,即1024个隐藏结点。

2、于是四个参数被修改:其中,预测值计算方法改为:3、计算3000次,可以发现准确率一开始提高得很快,后面提高速度变缓,最终测试准确率提高到88.8%。

谷歌人工智能写作项目:神经网络伪原创

什么是全连接神经网络,怎么理解“全连接”?

1、全连接神经网络解析:对n-1层和n层而言,n-1层的任意一个节点,都和第n层所有节点有连接AI发猫。即第n层的每个节点在进行计算的时候,激活函数的输入是n-1层所有节点的加权。

2、全连接的神经网络示意图:3、“全连接”是一种不错的模式,但是网络很大的时候,训练速度回很慢。部分连接就是认为的切断某两个节点直接的连接,这样训练时计算量大大减小。

神经网络1、一般的SGD的模型只有一层WX+b,现在需要使用一个RELU作为中间的隐藏层,连接两个WX+b,仍然只需要修改Graph计算单元为:而为了在数学上满足矩阵运算,我们需要这样的矩阵运算:这里N取1024,即1024个隐藏结点。

2、于是四个参数被修改:其中,预测值计算方法改为:3、计算3000次,可以发现准确率一开始提高得很快,后面提高速度变缓,最终测试准确率提高到88.8%。

如何画出神经网络的结构图

免费高清图片素材网站推荐

。

免费高清图片素材网站推荐以下这几个:1、PickPikPickPik是一个由AI智能分类的无版权图片分享网站,为了获得更好的搜索结果,该网站中的每张照片都是手动命名,并且该团队还开发了一个智能AI神经网络来对每张图片进行美学评分,只有评分最高的图片才会在搜索中展示。

该网站上的所有图片几乎都可以用于任何商业设计项目,包括网页设计、应用程序设计、PSD和HTML模版等,博主和社交媒体团队都可以免费使用这些图片。

2、UnSplashUnSplash免费高清壁纸分享网是一个坚持每天分享高清摄影图片的站点,每天更新一张高质量的图片素材,全是生活中的景色作品,清新的生活气息图片可以作为桌面壁纸,也可以应用于各种需要的环境。

UnSplash网站上的图片大又清,适合各种使用。

3、PixaBayPixaBay免费高质量图片素材分享网是一个提供无版权图片素材的图片提供商,不论数字或者印刷格式,个人或者商业用途,都可以免费使用该网站任何图像,并且无原作者署名要求。

同时,Pixabay也推出了手机App找图,支持iOS、Android两大平台,Pixabay手机应用功能非常简单,你可以把它想像成是一个无限大的相册,里面有大量的图库素材,通过手机滑动来快速切换浏览,也能通过搜索方式输入关键字来找出相关图片。

4、FoodiesFeedFoodiesFeed免费食品素材分享网是一个提供丰富的免费高分辨率食品摄影图片的站点,每周至少更新5张。

可下载和用于任何个人或商业目的,类别有早餐、咖啡、烹饪、水果、主菜、甜品等。FoodiesFeed素材网站由23岁的捷克人Jakub创办。

他不仅是一位美食家,也是一位食物摄影爱好者,虽然是业余的,不过不影响他拍摄美食素材分享给其他用户。用户可以通过邮箱来订阅该网站的内容,每周获取免费的美食类素材。

5、StockSnapStockSnap免费图片素材高清资源库是一个提供可自由下载使用的高清晰摄影图片作品的素材库,所提供的资源相当实用,该网站由多位摄影师组成,提供丰富的免费照片,可随意使用,无需经过授权。

StockSnap网站的设计其实非常简单,其宗旨就是希望能为寻找美丽图片的使用者提供一个完整且丰富的图片素材资源库,网站每天都会有摄影师上传发布作品,找出高品质、高清晰度的照片并更新到该网站上来,让更多的人去免费使用。

用什么软件制作神经网络结构图,类似下图这种

神经网络Kohonen模型

。

一、Kohonen模型概述1981年芬兰赫尔辛基大学Kohonen教授提出了一个比较完整的,分类性能较好的自组织特征影射(Self-OrganizingFeatureMap)人工神经网络(简称SOM网络)方案。

这种网络也称为Kohonen特征影射网络。这种网络模拟大脑神经系统自组织特征影射功能,它是一种竞争式学习网络,在学习中能无监督地进行自组织学习。

二、Hohonen模型原理1.概述SOM网络由输入层和竞争层组成。输入层神经元数为N,竞争层由M=R×C神经元组成,构成一个二维平面阵列或一个一维阵列(R=1)。输入层和竞争层之间实现全互连接。

SOM网络的基本思想是网络竞争层各神经元竞争对输入模式的响应机会,最后仅有一个神经元成为竞争的胜者,并对那些与获胜神经元有关的各连接权朝着更有利于它竞争的方向调整,这一获胜神经元就表示对输入模式的分类。

SOM算法是一种无教师示教的聚类方法,它能将任意输入模式在输出层映射成一维或二维离散图形,并保持其拓扑结构不变。即在无教师的情况下,通过对输入模式的自组织学习,在竞争层将分类结果表示出来。

此外,网络通过对输入模式的反复学习,可以使连接权矢量空间分布密度与输入模式的概率分布趋于一致,即连接权矢量空间分布能反映输入模式的统计特征。

2.网络权值初始化因为网络输入很可能出现在中间区,因此,如果竞争层的初始权值选择在输入空间的中间区,则其学习效果会更加有效。

3.邻域距离矩阵SOM网络中的神经元可以按任何方式排列,这种排列可以用表示同一层神经元间的Manhattan距离的邻域距离矩阵D来描述,而两神经元的Manhattan距离是指神经元坐标相减后的矢量中,其元素绝对值之和。

4.Kohonen竞争学习规则设SOM网络的输入模式为Xp=(,,…,),p=1,2.…,P。

竞争层神经元的输出值为Yj(j=1,2,…,M),竞争层神经元j与输入层神经元之间的连接权矢量为Wj=(wj1,wj2,…,wjN),j=1,2,…,M。

Kohonen网络自组织学习过程包括两个部分:一是选择最佳匹配神经元,二是权矢量自适应变化的更新过程。

确定输入模式Xp与连接权矢量Wj的最佳匹配的评价函数是两个矢量的欧氏距离最小,即,j=1,2,…,M,]]g,确定获胜神经元g。dg=mjin(dj),j=1,2,…,M。

求输入模式Xp在竞争层的获胜神经元g及其在邻域距离nd内的神经元的输出。中国矿产资源评价新技术与评价新模型dgm为邻域距离矩阵D的元素,为竞争层中获胜神经元g与竞争层中其它神经元的距离。

求输入模式Xp在竞争层的获胜神经元g及其在邻域距离nd内的神经元的权值修正值。中国矿产资源评价新技术与评价新模型式中:i=1,2,…,N;lr为学习速率;t为学习循环次数。

Δwjt(t+1)的其余元素赋值为0。进行连接权的调整wji(t+1)=wji(t)+Δwji(t+1)。

5.权值学习中学习速率及邻域距离的更新(1)SOM网络的学习过程分为两个阶段第一阶段为粗学习与粗调整阶段。

在这一阶段内,连接权矢量朝着输入模式的方向进行调整,神经元的权值按照期望的方向在适应神经元位置的输入空间建立次序,大致确定输入模式在竞争层中所对应的影射位置。

一旦各输入模式在竞争层有了相对的影射位置后,则转入精学习与细调整阶段,即第二阶段。

在这一阶段内,网络学习集中在对较小的范围内的连接权进行调整,神经元的权值按照期望的方向在输入空间伸展,直到保留到他们在粗调整阶段所建立的拓扑次序。学习速率应随着学习的进行不断减小。

(2)邻域的作用与更新在SOM网络中,脑神经细胞接受外界信息的刺激产生兴奋与抑制的变化规律是通过邻域的作用来体现的邻域规定了与获胜神经元g连接的权向量Wg进行同样调整的其他神经元的范围。

在学习的最初阶段,邻域的范围较大,随着学习的深入进行,邻域的范围逐渐缩小。

(3)学习速率及邻域距离的更新在粗调整阶段,学习参数初始化最大学习循环次数MAX_STEP1=1000,粗调整阶段学习速率初值LR1=1.4,细调整阶段学习速率初值LR2=0.02,最大邻域距离MAX_ND1=Dmax,Dmax为邻域距离矩阵D的最大元素值。

粗调阶段学习循环次数step≤MAX_STEP1,学习速率lr从LR1调整到LR2,邻域距离nd从MAX_ND1调整到1,求更新系数r,r=1-step/MAX_STEP1,邻域距离nd更新,nd=1.00001+(MAX_ND1-1)×r。

学习速率lr更新,lr=LR2+(LR1-LR2)×r。在细调整阶段,学习参数初始化,最大学习循环次数MAX_STEP2=2000,学习速率初值LR2=0.02,最大邻域距离MAX_ND2=1。

细调阶段MAX_STEP1<step≤MAX_STEP1+MAX_STEP2,学习速率lr慢慢从LR2减少,邻域距离nd设为1,邻域距离nd更新,nd=MAX_ND2+0.00001。

学习速率lr更新,lr=LR2×(MAX_STEP1/step)。6.网络的回想——预测SOM网络经学习后按照下式进行回想:中国矿产资源评价新技术与评价新模型Yj=0,j=1,2,…,M,(j≠g)。

将需要分类的输入模式提供给网络的输入层,按照上述方法寻找出竞争层中连接权矢量与输入模式最接近的神经元,此时神经元有最大的激活值1,而其它神经元被抑制而取0值。这时神经元的状态即表示对输入模式的分类。

三、总体算法1.SOM权值学习总体算法(1)输入参数X[N][P]。(2)构造权值矩阵W[M][N]。1)由X[N][P]求Xmid[N],2)由Xmid[N]构造权值W[M][N]。

(3)构造竞争层。1)求竞争层神经元数M,2)求邻域距离矩阵D[M][M],3)求矩阵D[M][M]元素的最大值Dmax。(4)学习参数初始化。(5)学习权值W[M][N]。

1)学习参数学习速率lr,邻域距离nd更新,分两阶段:(i)粗调阶段更新;(ii)细调阶段更新。2)求输入模式X[N][p]在竞争层的获胜神经元win[p]。

(i)求X[N][p]与W[m][N]的欧氏距离dm;(ii)按距离dm最短,求输入模式X[N][p]在竞争层的获胜神经元win[p]。

3)求输入模式X[N][p]在竞争层的获胜神经元win[p]及其在邻域距离nd内的神经元的输出Y[m][p]。

4)求输入模式X[N][p]在竞争层的获胜神经元win[p]及其在邻域距离nd内的神经元的权值修正值ΔW[m][N],从而得到输入模式X[N][p]产生的权值修正值ΔW[M][N]。

5)权值修正W[M][N]=W[M][N]+ΔW[M][N]。

6)学习结束条件:(i)学习循环到MAX_STEP次;(ii)学习速率lr达到用户指定的LR_MIN;(iii)学习时间time达到用户指定的TIME_LIM。(6)输出。

1)学习得到的权值矩阵W[M][N];2)邻域距离矩阵D[M][M]。(7)结束。2.SOM预测总体算法(1)输入需分类数据X[N][P],邻域距离矩阵D[M][M]。

(2)求输入模式X[N][p]在竞争层的获胜神经元win[p]。1)求X[N][p]与W[m][N]的欧氏距离dm;2)按距离dm最短,求输入模式X[N][p]在竞争层的获胜神经元win[p]。

(3)求获胜神经元win[p]在竞争层排列的行列位置。(4)输出与输入数据适应的获胜神经元win[p]在竞争层排列的行列位置,作为分类结果。(5)结束。

四、总体算法流程图Kohonen总体算法流程图见附图4。五、数据流图Kohonen数据流图见附图4。

六、无模式识别总体算法假定有N个样品,每个样品测量M个变量,则有原始数据矩阵:X=(xij)N×M,i=1,2,…,N,j=1,2,…,M。

(1)原始数据预处理X=(xij)N×M处理为Z=(zij)N×M,分3种处理方法:1)衬度;2)标准化;3)归一化。程序默认用归一化处理。

(2)构造Kohonen网竞争层与输入层之间的神经元的连接权值构成矩阵WQ×M。WQ×M初始化。(3)进入Kohonen网学习分类循环,用epoch记录循环次数,epoch=1。

(4)在每个epoch循环中,对每个样品n(n=1,2,…,N)进行分类。从1个样品n=1开始。

(5)首先计算输入层的样品n的输入数据znm(m=1,2,…,M)与竞争层Q个神经元对应权值wqm的距离。

(6)寻找输入层的样品n与竞争层Q个神经元的最小距离,距离最小的神经元Win[n]为获胜神经元,将样品n归入获胜神经元Win[n]所代表的类型中,从而实现对样品n的分类。

(7)对样品集中的每一个样品进行分类:n=n+1。(如果n≤N,转到5。否则,转到8。

)(8)求分类后各神经元所对应的样品的变量的重心,用对应的样品的变量的中位数作为重心,用对应的样品的变量的重心来更新各神经元的连接权值。(9)epoch=epoch+1;一次学习分类循环结束。

(10)如果满足下列两个条件之一,分类循环结束,转到11;否则,分类循环继续进行,转到4。1)全部样品都固定在某个神经元上,不再改变了;2)学习分类循环达到最大迭代次数。

(11)输出:1)N个样品共分成多少类,每类多少样品,记录每类的样品编号;2)如果某类中样品个数超过1个,则输出某类的样品原始数据的每个变量的均值、最小值、最大值和均方差;3)如果某类中样品个数为1个,则输出某类的样品原始数据的各变量值;4)输出原始数据每个变量(j=1,2,…,M)的均值,最小值,最大值和均方差。

(12)结束。七、无模式识别总体算法流程图Kohonen无模式总体算法流程图见附图5。

神经网络ART1模型

一、ART1模型概述自适应共振理论(AdaptiveResonanceTheory)简称ART,是于1976年由美国Boston大学S.Grossberg提出来的。

这一理论的显著特点是,充分利用了生物神经细胞之间自兴奋与侧抑制的动力学原理,让输入模式通过网络双向连接权的识别与比较,最后达到共振来完成对自身的记忆,并以同样的方法实现网络的回想。

当提供给网络回想的是一个网络中记忆的、或是与已记忆的模式十分相似的模式时,网络将会把这个模式回想出来,提出正确的分类。

如果提供给网络回想的是一个网络中不存在的模式,则网络将在不影响已有记忆的前提下,将这一模式记忆下来,并将分配一个新的分类单元作为这一记忆模式的分类标志。

S.Grossberg和G.A.Carpenter经过多年研究和不断发展,至今已提出了ART1,ART2和ART3三种网络结构。

ART1网络处理双极型(或二进制)数据,即观察矢量的分量是二值的,它只取0或1。二、ART1模型原理ART1网络是两层结构,分输入层(比较层)和输出层(识别层)。

从输入层到输出层由前馈连接权连接,从输出层到输入层由反馈连接权连接。

设网络输入层有N个神经元,网络输出层有M个神经元,二值输入模式和输出向量分别为:Xp=(,,…,),Yp=(,,…,),p=1,2,…,P,其中P为输入学习模式的个数。

设前馈连接权和反馈连接权矩阵分别为W=(wnm)N×M,T=(tnm)N×M,n=1,2,…,N,m=1,2,…,M。

ART1网络的学习及工作过程,是通过反复地将输入学习模式由输入层向输出层自下而上的识别和由输出层向输入层自上而下的比较过程来实现的。

当这种自下而上的识别和自上而下的比较达到共振,即输出向量可以正确反映输入学习模式的分类,且网络原有记忆没有受到不良影响时,网络对一个输入学习模式的记忆分类则告完成。

ART1网络的学习及工作过程,可以分为初始化阶段、识别阶段、比较阶段和探寻阶段。1.初始化阶段ART1网络需要初始化的参数主要有3个:即W=(wnm)N×M,T=(tnm)N×M和ρ。

反馈连接权T=(tnm)N×M在网络的整个学习过程中取0或1二值形式。这一参数实际上反映了输入层和输出层之间反馈比较的范围或强度。由于网络在初始化前没有任何记忆,相当于一张白纸,即没有选择比较的余的。

因此可将T的元素全部设置为1,即tnm=1,n=1,2,…,N,m=1,2,…,M。(1)这意味着网络在初始状态时,输入层和输出层之间将进行全范围比较,随着学习过程的深入,再按一定规则选择比较范围。

前馈连接权W=(wnm)N×M在网络学习结束后,承担着对学习模式的记忆任务。在对W初始化时,应该给所有学习模式提供一个平等竞争的机会,然后通过对输入模式的竞争,按一定规则调整W。

W的初始值按下式设置:中国矿产资源评价新技术与评价新模型ρ称为网络的警戒参数,其取值范围为0<ρ≤1。2.识别阶段ART1网络的学习识别阶段发生在输入学习模式由输入层向输出层的传递过程中。

在这一阶段,首先将一个输入学习模式Xp=(,,…,)提供给网络的输入层,然后把作为输入学习模式的存储媒介的前馈连接权W=(wnm)N×M与表示对这一输入学习模式分类结果的输出层的各个神经元进行比较,以寻找代表正确分类结果的神经元g。

这一比较与寻找过程是通过寻找输出层神经元最大加权输入值,即神经元之间的竞争过程实现的,如下式所示:中国矿产资源评价新技术与评价新模型中国矿产资源评价新技术与评价新模型中国矿产资源评价新技术与评价新模型至此,网络的识别过程只是告一段落,并没有最后结束。

此时,神经元m=g是否真正有资格代表对输入学习模式Xp的正确分类,还有待于下面的比较和寻找阶段来进一步确定。一般情况下需要对代表同一输入学习模式的分类结果的神经元进行反复识别。

3.比较阶段ART1网络的比较阶段的主要职能是完成以下检查任务,每当给已学习结束的网络提供一个供识别的输入模式时,首先检查一下这个模式是否是已学习过的模式,如果是,则让网络回想出这个模式的分类结果;如果不是,则对这个模式加以记忆,并分配一个还没有利用过的输出层神经元来代表这个模式的分类结果。

具体过程如下:把由输出层每个神经元反馈到输入层的各个神经元的反馈连接权向量Tm=(t1m,t2m,…,tNm),m=1,2,…,M作为对已学习的输入模式的一条条记录,即让向量Tm=(t1m,t2m,…,tNm)与输出层第m个神经元所代表的某一学习输入模式Xp=(,,…,)完全相等。

当需要网络对某个输入模式进行回想时,这个输入模式经过识别阶段,竞争到神经元g作为自己的分类结果后,要检查神经元g反馈回来的向量Tg是否与输入模式相等。

如果相等,则说明这是一个已记忆过的模式,神经元g代表了这个模式的分类结果,识别与比较产生了共振,网络不需要再经过寻找阶段,直接进入下一个输入模式的识别阶段;如果不相符,则放弃神经元g的分类结果,进入寻找阶段。

在比较阶段,当用向量Tg与输入模式XP进行比较时,允许二者之间有一定的差距,差距的大小由警戒参数ρ决定。首先计算中国矿产资源评价新技术与评价新模型Cg表示向量Tg与输入模式XP的拟合度。

在式中,(tng*xn)表示向量Tg=(t1g,t2g,…,tNg)与输入模式Xp=(,,…,)的逻辑“与”。当Tg=XP时,Cg=1。

当Cg≥ρ时,说明拟合度大于要求,没有超过警戒线。以上两种情况均可以承认识别结果。

当Cg≠1且Cg>ρ时,按式(6)式(7)将前馈连接权Wg=(w1g,w2g,…,wNg)和反馈连接权Tg=(t1g,t2g,…,tNg)向着与XP更接近的方向调整。

中国矿产资源评价新技术与评价新模型tng(t+1)=tng(t)*xn,n=1,2,…,N。

(7)当Cg<ρ时,说明拟合度小于要求,超过警戒线,则拒绝识别结果,将神经元g重新复位为0,并将这个神经元排除在下次识别范围之外,网络转入寻找阶段。

4.寻找阶段寻找阶段是网络在比较阶段拒绝识别结果之后转入的一个反复探寻的阶段,在这一阶段中,网络将在余下的输出层神经元中搜索输入模式Xp的恰当分类。

只要在输出向量Yp=(,,…)中含有与这一输入模式Xp相对应、或在警戒线以内相对应的分类单元,则网络可以得到与记忆模式相符的分类结果。

如果在已记忆的分类结果中找不到与现在输入的模式相对应的分类,但在输出向量中还有未曾使用过的单元,则可以给这个输入模式分配一个新的分类单元。

在以上两种情况下,网络的寻找过程总能获得成功,也就是说共振终将发生。

三、总体算法设网络输入层有N个神经元,网络输出层有M个神经元,二值输入模式和输出向量分别为:Xp=(,,…,),Yp=(,,…,)p=1,2,…,p,其中p为输入学习模式的个数。

设前馈连接权和反馈连接权矩阵分别为W=(wnm)N×M,T=(tnm)N×M,n=1,2,…,N,m=1,2,…,M。

(1)网络初始化tnm(0)=1,中国矿产资源评价新技术与评价新模型n=1,2,…,N,m=1,2,…,M。0<ρ≤1。

(2)将输入模式Xp=(,,…,)提供给网络的输入层(3)计算输出层各神经元输入加权和中国矿产资源评价新技术与评价新模型(4)选择XP的最佳分类结果中国矿产资源评价新技术与评价新模型令神经元g的输出为1。

(5)计算中国矿产资源评价新技术与评价新模型中国矿产资源评价新技术与评价新模型判断中国矿产资源评价新技术与评价新模型当式(8)成立,转到(7),否则,转到(6)。

(6)取消识别结果,将输出层神经元g的输出值复位为0,并将这一神经元排除在下一次识别的范围之外,返回步骤(4)。

当所有已利用过的神经元都无法满足式(8),则选择一个新的神经元作为分类结果,转到步骤(7)。

(7)承认识别结果,并按下式调整连接权中国矿产资源评价新技术与评价新模型tng(t+1)=tng(t)*xn,n=1,2,…,N。

(8)将步骤(6)复位的所有神经元重新加入识别范围之内,返回步骤(2)对下一模式进行识别。(9)输出分类识别结果。(10)结束。四、实例实例为ART1神经网络模型在柴北缘-东昆仑造山型金矿预测的应用。

1.建立综合预测模型柴北缘—东昆仑地区位于青海省的西部,是中央造山带的西部成员——秦祁昆褶皱系的一部分,是典型的复合造山带(殷鸿福等,1998)。

根据柴北缘—东昆仑地区地质概括以及造山型金矿成矿特点,选择与成矿相关密切的专题数据,建立柴北缘—东昆仑地区的综合信息找矿模型:1)金矿重砂异常数据是金矿的重要找矿标志。

2)金矿水化异常数据是金矿的重要找矿标志。3)金矿的化探异常数据控制金矿床的分布。4)金矿的空间分布与通过该区的深大断裂有关。5)研究区内断裂密集程度控制金矿的产出。

6)重力构造的存在与否是金矿存在的一个标志。7)磁力构造线的存在也是金矿存在的一个重要标志。8)研究区地质复杂程度也对金矿的产出具有重要的作用。9)研究区存在的矿(化)点是一个重要的标志。

2.划分预测单元预测工作是在单元上进行的,预测工作的结果是与单元有着较为直接的联系,在找矿模型指导下,以最大限度地反映成矿信息和预测单元面积最小为原则,通过对研究区内地质、地球物理、地球化学等的综合资料分析,对可能的成矿地段圈定了预测单元。

采用网格化单元作为本次研究的预测单元,网格单元的大小是,40×40,将研究区划分成774个预测单元。

3.变量选择(表8-6)4.ART1模型预测结果ART1神经网络模型算法中,给定不同的阈值,将改变预测分类的结果。

本次实验选取得阈值为ρ=0.41,系统根据此阈值进行计算获得计算结果,并通过将不同的分类结果赋予不同的颜色,最终获得ART模型预测单元的分类结果。分类的结果是形成29个类别。

分类结果用不同的颜色表示,其具体结果地显示见图8-5。图形中颜色只代表类别号,不代表分类的好坏。将矿点专题图层叠加以后,可以看出,颜色为灰色的单元与矿的关系更为密切。

表8-6预测变量标志的选择表图8-5东昆仑—柴北缘地区基于ARTL模型的金矿分类结果图。

脑皮层神经网络是什么样的 脑皮层神经网络示意图

。

所谓神经网络算法顾名思义是模拟生物神经网络而产生的一种算法,首先需要用一些已知的数据输入到神经网络中,使它知道什么样的数据属于哪一类(训练),然后将未知的数据输入进去,神经网络通过已知的数据对其进行判断来完成分类(分类)。

可以用来进行图像识别、分类;数据预测;曲线拟合等。推荐找本机器学习,人工智能方面的书看。

BP神经网络训练生成的图片解释,急求。

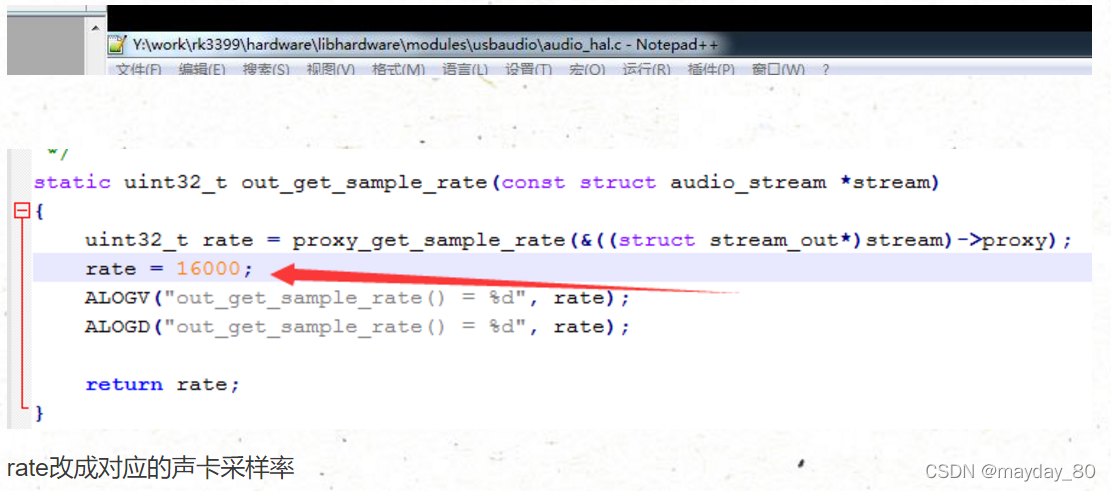

那这张呢,到了最大迭代次数了,可是还是收敛不到指定的精度。出现的情况就是像图上一样,均方误差达到0.00128左右的时候就无法继续下去了,误差梯度总是反复,先下降,一会又缩回去了。

即使我把迭代次数设置到10000次均方误差也就稳定在0.00128左右了,主要是误差梯度总是不停的反复,这是为什么呢?是收敛失败吗?