“大多数人类和动物的学习可以说属于无监督学习。有人说,如果智能是一块蛋糕,那么无监督学习就是蛋糕,监督学习是锦上添花,强化学习是锦上添花。”

这似乎很有趣,对吧?

强化学习是最接近人类学习的。

就像我们人类从我们生活的动态环境中学习,我们的行为决定我们是否受到奖励或惩罚一样,强化学习代理也是如此,其最终目标是最大化奖励。

不是我们要找的吗?

我们希望人工智能代理和我们一样聪明和果断。

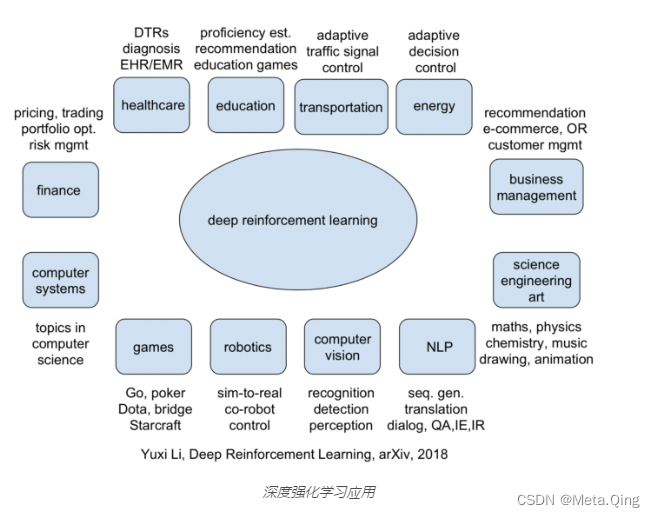

强化学习技术是所有解决方案的基础,从自动驾驶汽车到被医疗 AI 机器人取代的外科医生。它已成为新兴技术的主要驱动力,坦率地说,这只是冰山一角。

在本文中,我们将讨论十种不同的强化学习应用程序,并了解它们如何在所有行业中塑造 AI 的未来。

以下是我们将介绍的内容:

- 自动驾驶汽车

- 数据中心冷却

- 红绿灯控制

- 卫生保健

- 图像处理

- 机器人技术

- 自然语言处理

- 营销

- gamble

- 强化学习应用:关键要点

自动驾驶汽车

开放上下文环境中的车辆驾驶应该得到机器学习模型的支持,该模型使用现实世界中所有可能的场景和场景进行训练。

然而-

这些不同场景的集合是一个需要解决的复杂问题。我们如何确保自动驾驶汽车已经学习了所有可能的场景并安全地掌握了每一种情况?

答案是强化学习。

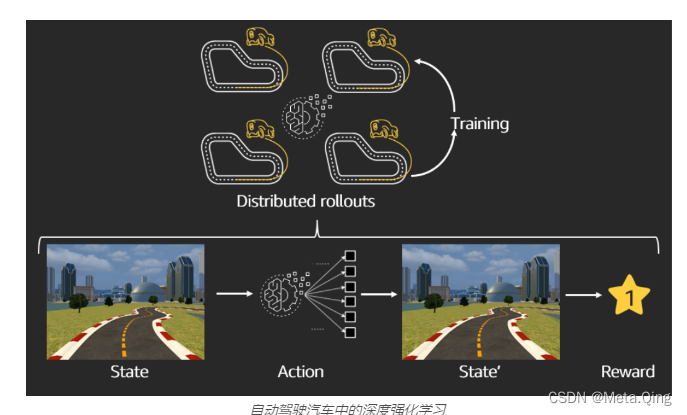

强化学习模型在动态环境中进行训练,方法是根据自身经验学习策略,遵循探索和利用原则,最大限度地减少对交通的干扰。自动驾驶汽车有很多方面需要考虑,具体取决于它做出的最佳决策。

驾驶区域、交通处理、保持限速、避免碰撞是重要因素。

许多模拟环境可用于测试自动驾驶汽车技术的强化学习模型。

DeepTraffic是一个开源环境,它结合了强化学习、深度学习和计算机视觉的力量来构建由 MIT 推出的用于自动驾驶的算法。它模拟无人驾驶车辆,如无人机、汽车等。

Carla是另一个优秀的替代品,用于支持自动驾驶系统的开发、培训和验证。它复制了城市布局、建筑物、车辆,在非常接近现实的实时模拟环境中训练自动驾驶汽车。

自动驾驶在这些合成环境的帮助下使用强化学习来解决轨迹优化和动态路径的重大问题。

强化学习代理在这些动态环境中进行训练以优化轨迹。智能体学习运动规划、路线改变、停车的决策和位置以及速度控制等。

一篇关于 Confidence based Reinforcement Learning 的论文提出了一种有效的解决方案,可以将强化学习与具有高置信度分数的基线基于规则的策略一起使用。

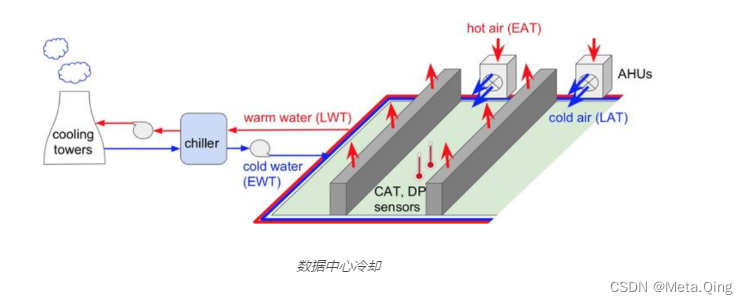

数据中心冷却

在这个时代,人工智能可以帮助我们解决一些世界上最具挑战性的物理问题——比如能源消耗。随着整个世界处于虚拟化和基于云的应用程序的边缘,像数据中心这样的大型商业和工业系统需要大量的能源消耗来保持服务器的运行。

有趣的事实:使用机器学习算法的谷歌数据中心已将用于冷却的能量减少了 40%。

该领域的研究人员已经证明,几个小时的探索可以实现数据驱动、基于模型的学习。

与现有的 PID 控制器相比,这种具有很少或没有先验知识的强化学习代理方法可以有效且安全地调节服务器楼层的条件。数据中心内数千个传感器收集的数据具有温度、功率、设定点等属性,这些属性被用于训练用于数据中心冷却的深度神经网络。

由于缺乏多样化的数据集,很难通过传统的机器学习算法直接解决这个问题,因此基于深度 Q 学习网络 (DQN) 的方法被广泛用于克服这一挑战。

红绿灯控制

随着城市化进程的加快和家庭汽车保有量的增加,交通拥堵已成为一个巨大的问题,尤其是在大都市地区。

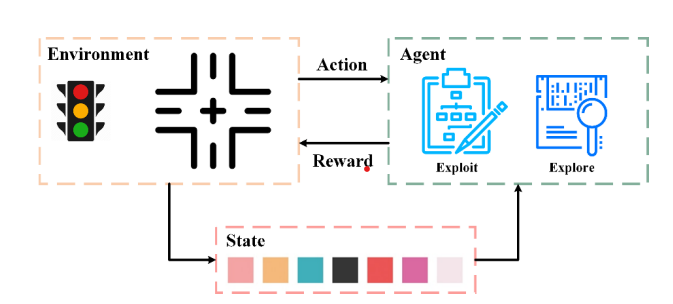

强化学习是一种趋势数据驱动的自适应交通信号控制方法。这些模型的训练目标是使用基于当前交通状态优化控制交通信号灯的价值函数来学习策略。

决策需要是动态的,取决于来自不同方向的交通到达率,这应该在一天中的不同时间有所不同。由于这种非平稳行为,处理流量的传统方式似乎受到限制。此外,为具有 x 个车道的交叉口训练的策略π不能在具有 y 个车道的交叉口中重复使用。

红绿灯控制的强化学习框架——源文件

强化学习 (RL) 是一种趋势方法,因为它具有数据驱动的性质,可用于复杂城市交通网络中的自适应交通信号控制。

将深度强化学习算法应用于交通网络存在一些局限性,例如探索-利用困境、多智能体训练方案、连续动作空间、信号协调等。

卫生保健

选择药物是困难的。当患者已服药多年且未见任何改善时,情况更具挑战性。

最近的研究表明,患有慢性疾病的患者在放弃之前会尝试不同的药物。我们必须找到正确的治疗方法并将它们映射到正确的人。

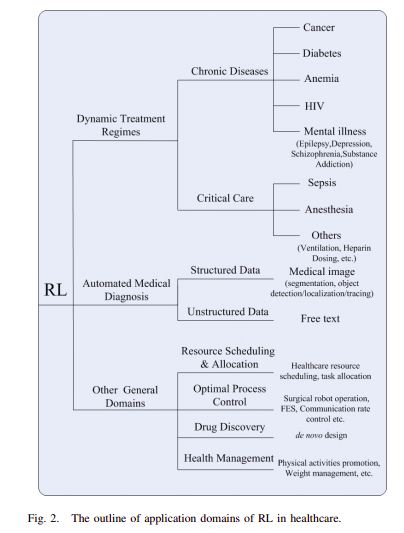

医疗保健行业一直是技术进步的早期采用者和重要受益者。在过去的几年里,该行业明显倾向于强化学习,特别是在为患有长期疾病的患者实施动态治疗方案 ( DTR ) 方面。

它还在自动化医疗诊断、健康资源调度、药物发现和开发以及健康管理中得到应用。

医疗保健中的强化学习

自动化医疗诊断

深度强化学习 (DRL) 增强了强化学习框架,该框架使用深度神经网络的代表性能力学习一系列动作,以最大限度地提高预期奖励。

强化学习已经接管了医学报告的生成、结节/肿瘤和血管阻塞的识别、这些报告的分析等。有关此问题空间的更多见解以及强化学习方法提供的解决方案,请参阅本文。

DTR(动态治疗方案)

DTR 涉及连续的医疗保健决策——包括治疗类型、药物剂量和预约时间——根据个体患者的病史和随着时间的推移而量身定制。该输入数据被馈送到输出治疗选项的算法,以提供患者最理想的环境状态。

棘手的是,患有艾滋病等慢性长期疾病的患者会对药物产生耐药性,因此需要随着时间的推移更换药物,这使得治疗顺序很重要。当医生需要针对个别患者调整治疗时,他们可能会参考过去的试验、系统评价和分析。但是,对于许多 ICU 条件,特定的用例数据可能不可用。

许多入住 ICU 的患者也可能病得太重,无法纳入临床试验。我们需要其他方法来帮助 ICU 临床决策,包括大量的观察数据集。鉴于重症患者的动态特性,一种称为强化学习 (RL) 的机器学习方法特别适用于 ICU 环境。

机器人手术

决策制定中一个强大的强化学习应用程序是使用手术机器人,可以最大限度地减少错误和任何变化,并最终帮助提高外科医生的效率。达芬奇就是这样一种机器人,它允许外科医生以比传统方法更大的灵活性和可控性来执行复杂的手术。

所服务的关键功能是帮助外科医生使用先进的仪器,实时翻译外科医生的手部动作,并提供手术区域的 3D 高清视图。

图像处理

强化学习是数据密集型的,并且精通与动态且最初未知的环境进行交互。监督和非监督神经网络在图像处理中提供的当前解决方案更多地关注识别对象的分类。然而,他们不承认不同实体之间的相互依赖以及与人类感知程序的偏差。

它用于图像处理的以下子领域。

目标检测和定位

RL 方法通过最大化长期奖励来学习多个搜索策略,从整个图像作为提议开始,允许代理依次发现多个对象。

它提供了更多搜索路径的多样性,并且可以在单个提要中找到多个对象并生成边界框或多边形。这篇关于深度强化学习的主动对象定位的论文验证了它的有效性。

场景理解

基于深度卷积神经网络的人工视觉系统使用大型标记数据集来学习将图像序列映射到人类生成的场景描述的函数。强化学习为物理场景理解提供了丰富且通用的模拟引擎。

本文展示了一种基于像素奖励(pixelRL)的图像处理新模型。在 pixelRL 中,一个代理被附加到每个像素上,负责通过采取行动来改变像素值。这是一种有效的学习方法,通过考虑自身像素和相邻像素的未来状态来显着提高性能。

强化学习是最现代的机器学习技术之一,其中学习是通过与环境的交互来进行的。它用于计算机视觉任务,如特征检测、图像分割、对象识别和跟踪。

以下是在图像处理中使用强化学习的一些其他示例:-

- 配备视觉传感器的机器人,它们可以从中学习周围环境的状态

- 用于理解文本的扫描仪

- CT扫描等医学图像的图像预处理和分割

- 通过视频分割和逐帧图像处理进行交通分析和实时道路处理

- 用于交通和人群分析等的闭路电视摄像机。

机器人技术

机器人在高度动态和不断变化的环境中运行,因此无法预测接下来会发生什么。强化学习在这些场景中提供了相当大的优势,使机器人足够健壮,并有助于在不同场景中自适应地获取复杂的行为。

它旨在消除对耗时且繁琐的检查的需求,并用计算机视觉系统代替它们,以确保生产装配线上更高水平的质量控制。

机器人用于仓库导航,主要用于零件供应、质量检测、包装,在其他人、车辆和设备也涉及的环境中实现整个过程的自动化。

传统的机器学习范式处理所有这些场景都很复杂。机器人应该足够智能且反应灵敏,能够在这些复杂的环境中行走。它被训练具有对象操作知识,可根据嵌入图像处理和计算机视觉功能的对象的纹理和质量来抓取不同大小和形状的对象。

让我们快速浏览一下强化学习为其提供解决方案的机器人领域的一些用例。

产品组装

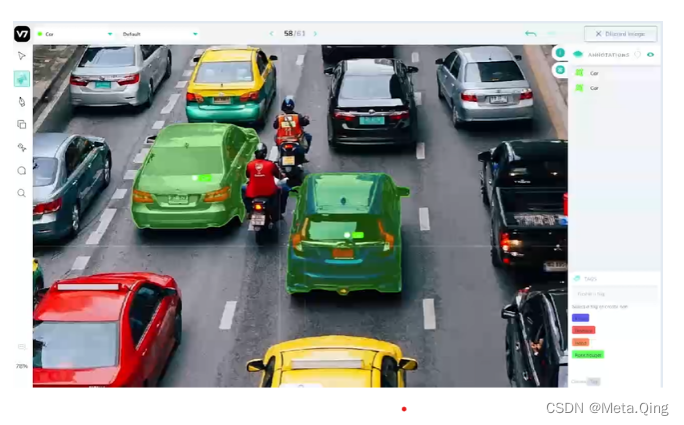

多家制造商使用计算机视觉来帮助改进他们的产品组装过程,并使其完全自动化,并从整个流程中消除人工干预。产品组装中的一个中心区域是对象检测和对象跟踪。

缺陷检查

使用多模态数据训练深度强化学习模型,以轻松识别缺失的部分、凹痕、裂缝、划痕和整体损坏,图像跨越数百万个数据点。

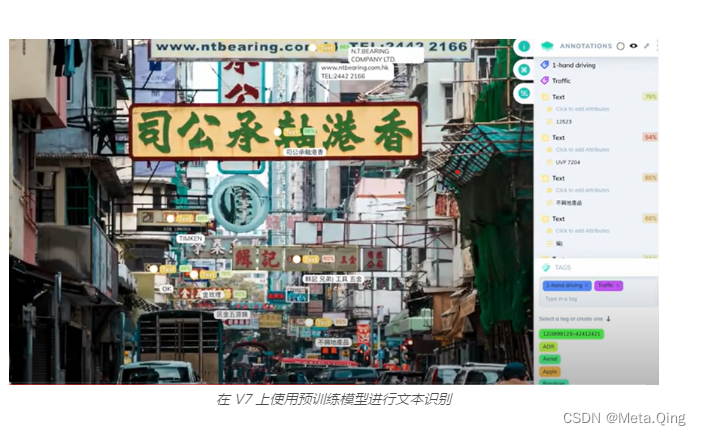

使用 V7 的软件,您可以训练对象检测、实例分割和图像分类模型来发现缺陷和异常。

库存管理

随着计算机视觉领域的发明,大公司和仓库的库存管理已经自动化,可以实时跟踪库存。深度强化学习代理可以定位空容器,并确保补货得到充分优化。

自然语言处理

语言理解使用强化学习是因为其固有的决策性质。智能体试图理解句子的状态,并试图形成一个动作集,使其增加的价值最大化。

问题很复杂,因为状态空间很大;动作空间也很大。强化学习用于 NLP 的多个领域,如文本摘要、问答、翻译、对话生成、机器翻译等。

强化学习代理可以被训练来理解文档的几句话,并用它来回答相应的问题。结合 RNN 的强化学习用于生成这些问题的答案,如本文所示。

由 Salesforce 领导的研究引入了一种新的训练方法,它结合了标准监督词预测和强化学习 (RL),显示出对之前最先进的摘要模型的改进,如本文所示。

致力于减少人工干预的工业或医疗保健机器人使用强化学习将自然语言指令映射到可执行动作序列。

在训练过程中,学习者反复构建动作序列,执行这些动作,并观察产生的奖励。一个奖励函数在后端工作,它定义了这些执行动作的质量。本文证明了这种方法可以与监督学习技术相媲美,同时只需要几个带注释的训练示例。

该领域的另一项有趣研究是由斯坦福大学、俄亥俄州立大学和微软研究院的研究人员领导的关于 Deep RL for dialog generation的研究。

深度强化学习在聊天机器人对话中找到应用。使用两个虚拟代理模拟对话,并在渐进式迭代中提高质量。

营销

强化学习被用于各种营销领域,以开发最大限度地提高客户增长并争取长期和短期回报之间的平衡的技术。

让我们来看看在营销领域使用通过强化学习进行实时竞价的各种场景。

为客户定制推荐

个性化的产品建议为客户提供他们想要的东西。强化学习机器人经过训练可以处理具有挑战性的障碍,如声誉、有限的客户数据和消费者不断变化的心态。

它动态地了解客户的需求并分析行为以提供高质量的推荐。这增加了公司的投资回报率和利润率。

为广告创造最有益的内容

想出吸引更广泛受众的最佳营销方案具有挑战性。基于 Q-Learning 的模型在奖励的基础上进行训练,并发展积极行动和期望结果的内在知识。强化学习模型将找到用户更有可能点击的广告,从而增加客户足迹。

通过商店的闭路电视识别客户的兴趣领域,以提供更好的广告和优惠。

消费者和品牌的强化学习

没有人工智能的力量,在优化广告对客户的影响方面存在很大障碍。

用幼稚的方法来分析哪个广告适合特定场景的需求是非常困难的。它为强化学习模型铺平了道路。该算法满足相关的用户偏好,并为买家动态选择完美的频率。

结果,增加的在线转换正在将浏览转变为业务。

gamble

强化学习已经取代了创建视频游戏的传统方法。

与需要复杂行为树来构建游戏逻辑的传统视频游戏相比,训练强化学习模型要简单得多。在这里,代理被设置为在模拟游戏环境中通过执行必要的动作序列来自行学习以实现所需的行为。

在强化学习中,应该针对游戏的所有方面对代理进行训练,例如寻路、防御、攻击和创建基于情境的策略,以使游戏对对手感兴趣。

根据机器人获得的情报,设置游戏级别。

Google DeepMind 是游戏优化的一个活生生的例子。

我们已经在 AlphaGo 中看到,经过 RL 训练的代理击败了历史上最强的围棋选手,打进了当时认为不可能的目标。众所周知,这对人工智能来说是一款非常具有挑战性的游戏。

AlphaGo 是一种由谷歌公司 DeepMind 创建的计算机程序,它融合了高级搜索树和深度神经网络。这些神经网络将围棋棋盘作为输入,通过包含数百万个类似神经元的连接的不同网络层导出特征。

强化学习代理也用于错误检测和游戏测试。这是因为它能够在没有人工输入、压力测试和为潜在错误创建情况的情况下运行大量迭代。

育碧等较新的游戏公司最近利用强化学习来减少游戏中发现的活动错误的数量。RL 代理在游戏环境中使用探索和开发技术进行训练,以测试其一些游戏机制,以尝试修复它们。

强化学习应用:关键要点

最后,快速回顾一下我们学到的一切:

- 强化学习涉及训练模型,以便它们产生一系列决策。它要么使用一种积极的机制进行训练,在这种机制中,模型会因未来更有可能产生它的行为而获得奖励。另一方面,负强化学习增加了惩罚,因此它们不会再次产生当前的结果序列。

- 强化学习改变了医疗保健、机器人技术、游戏、零售、营销等各个领域的动态。

- 由于强化学习通过预测客户对产品/服务的选择和行为来增加利润率的基本能力,许多公司已经开始使用数字化管理营销活动。

- 医疗保健是另一个使用强化学习来帮助医生发现治疗类型、建议适当剂量的药物和服用此类剂量的时间的领域。

- 强化学习方法用于游戏优化领域和模拟游戏创建的合成环境。

- 强化学习还可以在自动驾驶汽车中应用,以训练代理以优化轨迹并动态规划最有效的路径。

- RL 可用于 NLP 用例,例如文本摘要、问答、机器翻译。