(2023.05.10-2023.06.08)论文阅读简单记录和汇总

2023/05/10:今天状态,复阳大残,下午淋了点雨吹了点风,直接躺了四个小时还是头晕- -应该是阳了没跑了。

2023/06/03:前两周出差+复阳,这两周调整作息把自己又弄得累个半死。

2023/06/08:下周组会谁做汇报?原来是我做汇报啊艹艹艹

目录

- (arxiv 2023)MULTISCALE AUGMENTED NORMALIZING FLOWS FOR IMAGE COMPRESSION

- (IJCAI 2023)Improve Video Representation with Temporal Adversarial Augmentation

- (Tinypaper ICLR 2023)FAST ADVERSARIAL CNN-BASED PERTURBATION ATTACK ON NO-REFERENCE IMAGE QUALITY METRICS

- (IEEE SPL 2023)Entropy-constrained Implicit Neural Representations for Deep Image Compression

- (CVPR 2023)Video Compression with Entropy-Constrained Neural Representations

- (arxiv 2023)Compression with Bayesian Implicit Neural Representations

- (arxiv 2023)LEARNED WAVELET VIDEO CODING USING MOTION COMPENSATED TEMPORAL FILTERING

- (ICLR 2020)Scalable Model Compression by Entropy Penalized Reparameterization

- (Neurocomputing 2023)Multiple Hypotheses Based Motion Compensation for Learned Video Compression

- (CVPRW 2023)Adaptive Human-Centric Video Compression for Humans and Machines

1. (arxiv 2023)MULTISCALE AUGMENTED NORMALIZING FLOWS FOR IMAGE COMPRESSION

Paper:https://arxiv.org/abs/2305.05451

1.1 摘要

大多数基于学习的图像压缩方法由于其不可逆设计而缺乏高图像质量的效率。常用的压缩自编码器结构的解码函数只是编码变换的近似逆。这个问题可以通过使用可逆潜变量模型来解决,如果没有进行量化,它可以进行完美的重建。此外,许多传统的图像和视频编码器采用动态块划分来根据图像的内容改变某些图像区域的压缩。受这种方法的启发,分层潜在空间被应用于基于学习的压缩网络。本文提出了一种新的概念,将层次潜空间应用于增广归一化流,即可逆潜变量模型。我们表现最好的模型实现了平均利率节省比近似的单比例尺模型超过7%。

1.2 结论

在本文中,我们提出了两种新的架构,它们扩展了基于ANF的具有分层潜在空间的图像压缩网络的概念。我们的两个模型是ANFIC架构的修改版本。我们通过添加基于RDONet的分层lsunit来重新设计ANFIC的潜在空间,并为我们的RDOANFIC-Split模型开发了一个可逆的潜在分裂网络,该网络可以从单尺度潜在中获得多尺度表示。

综上所述,与单尺度ANFIC相比,采用多尺度隐空间可以显著提高压缩性能。最后的ANF层使用了分层潜在空间,参见RDOANFIC-Split模型,我们能够节省平均超过7%的比特率。我们的研究结果证明,RDONet原理不仅可以提高压缩自编码器的性能,而且可以提高基于ANF的体系结构的性能。

看了一眼感觉是普通的A+B方法,没有进一步看下去的欲望,很朴素的两者混合,之前课题组也有其他人提到过DL-based图像压缩的可逆性问题,讨论中说的是可逆性会导致性能下降,不可逆的非线性变换又会导致不可避免的有损压缩。

2. (IJCAI 2023)Improve Video Representation with Temporal Adversarial Augmentation 通过时间对抗性增强改进视频表示

Paper:https://arxiv.org/abs/2304.14601

Code: https://github.com/jinhaoduan/TAF

挺有意思的啊,挂了库,但是404了hhhh,有点怀疑作者是不是在投稿期间建了个Coming Soon忽悠审稿人,等中了就把库删了以免有人上来提issue。不过这也是CV界的常态了,我的态度就是吃枣药丸 😁😁😁

2.1 摘要

最近的研究表明,如果以适当的方式使用,对抗性增强有利于神经网络(nn)的泛化。本文介绍了一种利用时间注意力的新型视频增强技术——时间对抗增强技术(TA)。与传统的对抗性增强不同,时间对抗增强技术TA是专门设计用于通过最大化时间相关损失函数来转移神经网络对视频片段的注意力分布的。我们证明了时间对抗增强技术TA将获得不同的时间视图,这将显著影响神经网络的焦点。用这些例子进行训练,弥补了时间信息感知不平衡的缺陷,增强了防御时间变化的能力,最终导致更好的泛化。为了利用TA,我们提出用于改进视频表示的时间视频对抗微调(TAF)框架。TAF是一种与模型无关的、通用的、可解释的训练策略。我们使用四个强大的模型(TSM、GST、TAM和TPN)在三个具有挑战性的与时间相关的基准(Something-something V1&V2和diving48)上评估TAF。实验结果表明,在不引入额外参数或计算成本的情况下,TAF有效地提高了这些模型的测试精度,并且有显著的边际。作为副产物,TAF还提高了分布外(OOD)设置下的鲁棒性。

2.2 贡献

- 我们介绍了时间对抗增强技术(TA)。TA改变了视频片段的时间分布,为视频理解模型提供了更多的时间视图。

- 我们提出时间视频对抗性微调(TAF)框架利用时间对抗增强来规范网络的注意力分布。TAF是一个模型无关的、通用的、可解释性友好的训练方案。这是第一个通过明确地利用对抗性机器学习来改进视频理解模型的工作。

- TAF在四个强大的视频理解模型上进行评估,包括TSM、TAM、GST和TPN,并通过三个与时间相关的基准(something -something V1 & V2和Diving48)进行评估。实验结果表明,在不增加任何参数和计算成本的情况下,TAF可以显著提高测试精度。

- TAF是在分布外(out-of - distribution)的设置下进行测试的,它有效地提高了防御自然损坏数据的鲁棒性。

2.3 方法

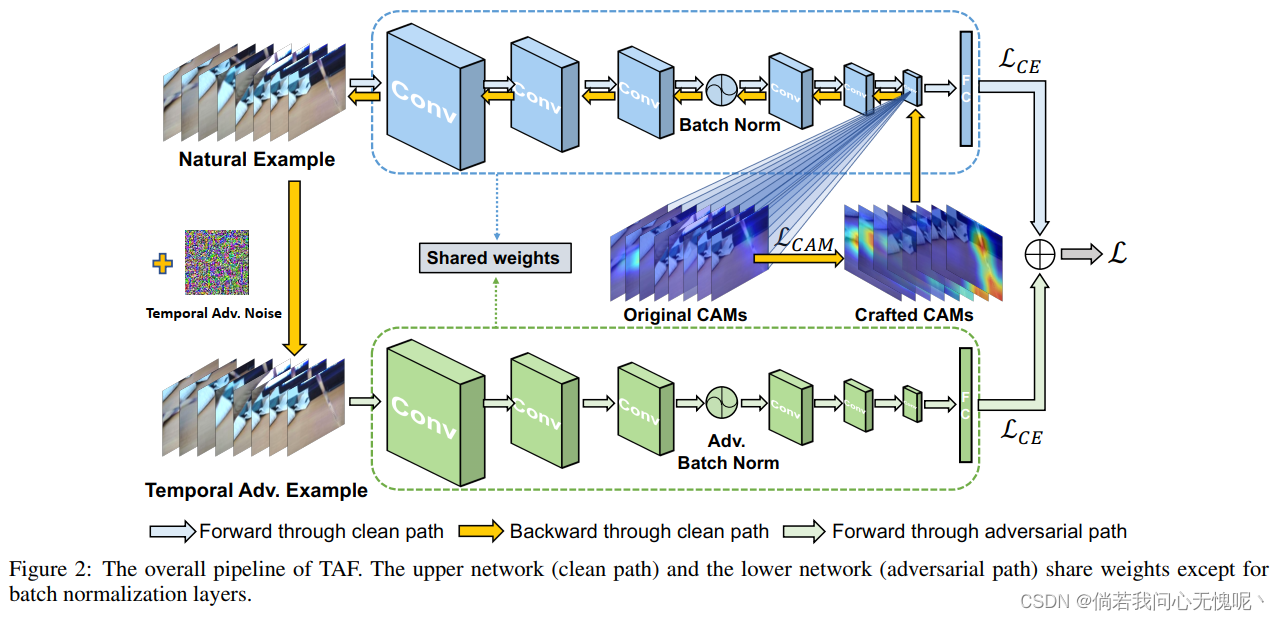

在本节中,我们描述了如何使用提出的时间视频对抗微调框架TAF捕获平衡的时间信息。首先,我们重新审视普通对抗增强。然后,详细说明时间对抗增强技术TA以及基于CAM的度量。最后,我们概述了时间视频对抗微调框架TAF的训练和测试过程。TAF的管道如图2所示。

2.3.1 普通对抗增强

对抗性增强来源于对抗性扰动,这是一种难以察觉的噪声,可以很容易地干扰训练有素的神经网络的预测。在基于图像的视觉任务中,一些研究表明对抗性扰动可以被看作是一种特殊的增强,以提高泛化和鲁棒性。

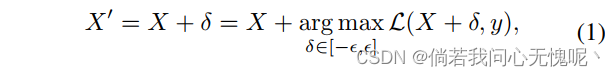

对于一个给定的模型 F \mathcal{F} F,由权重 θ \theta θ参数化组成,输入为 X ∈ R C × H × W X \in \R^{C \times H \times W} X∈RC×H×W,通道为 C C C,分辨率为 H × W H \times W H×W,其对抗增强样例 X ′ X' X′可以定义为

其中 δ \delta δ是每个单步解或迭代PGD攻击算法得到的对抗噪声, ϵ \epsilon ϵ是攻击预算, L \mathcal{L} L是一个常规分类损失,例如交叉熵损失。

普通对抗增强是图像任务的有效技术,但它不适合视频场景。视频理解模型经常遭受严重的过拟合问题,在Something-something V1数据集上观察到超过40%的过拟合差距(即,顶级训练精度vs顶级验证精度)。这种严重的过拟合表明在训练过程中引入了大量与泛化无关的噪声。对于神经网络来说,损失函数在决定吸收哪些特征或信息方面起着至关重要的作用。因此,单独使用分类损失可能会将这些不相关的噪声传播回对抗扰动,最终损害神经网络的泛化。

2.3.2 时间对抗增强

为了解决这个问题,提出的时间对抗增强(TA)利用基于CAM的时间损失函数来单独利用时间注意力相关信息,这是视频最基本和最基本的特征之一。在这里,我们展示了如何将时间信息纳入对抗性增强。

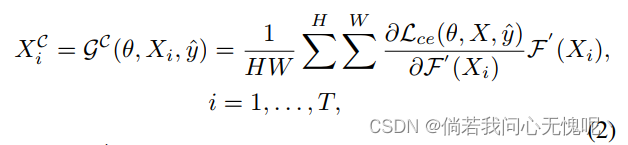

对于一个给定的由权重 θ \theta θ参数化的模型 F \mathcal{F} F,和视频素材 X ∈ R T × N c × H × W X \in \R^{T \times N_c \times H \times W} X∈RT×Nc×H×W,包含 T T T帧、 N c N_c Nc个通道和 H × W H \times W H×W的分辨率,对于 X i X_i Xi帧,我们考虑模型 F \mathcal{F} F的CAMs。

3.(Tinypaper ICLR 2023)FAST ADVERSARIAL CNN-BASED PERTURBATION ATTACK ON NO-REFERENCE IMAGE QUALITY METRICS 对无参考图像质量指标的基于 CNN 的快速对抗扰动攻击

Paper:https://arxiv.org/pdf/2305.15544.pdf

Code:https://github.com/katiashh/FACPA

3.1 摘要

现代基于神经网络的无参考图像和视频质量指标表现出与全参考指标一样高的性能。这些度量被广泛用于提高计算机视觉方法的视觉质量和比较视频处理方法。然而,这些指标对于传统的对抗性攻击并不稳定,这可能导致不正确的结果。我们的目标是研究无参考度量适用性的边界,在本文中,我们提出了一种针对无参考质量度量的快速对抗性摄动攻击。提出的攻击(FACPA)可以作为实时视频处理和压缩算法的预处理步骤。本研究可以进一步帮助设计稳定的基于神经网络的无参考质量指标。

3.2 结论

在本文中,我们提出了一种基于cnn的快速攻击,提高了NR质量指标的得分。与以往方法的比较表明,我们的攻击比迭代方法快得多,比普遍的对抗性摄动方法更有效。提出的攻击速度表明,它可以注入到视频压缩和其他实时算法中。因此提出的攻击可以作为度量可靠性的额外验证。

4. (IEEE SPL 2023)Entropy-constrained Implicit Neural Representations for Deep Image Compression 用于深度图像压缩的熵约束隐式神经表示

Paper:https://ieeexplore.ieee.org/abstract/document/10132493

4.1 摘要

各种数据类型的隐式神经表示(INRs)由于其有效性,在深度学习领域获得了普及。然而,先前对INRs 的研究只关注于原始表征的恢复。本文利用熵约束神经网络的模型压缩技术,研究了一种基于INRs的图像压缩模型。具体来说,提出的模型训练一个 多层感知器(MLP)来过拟合单个图像, 然后使用其权重来优化其压缩表示 使用加性均匀噪声。因此,提出的模型以端到端的方式有效地最小化了模型权重的大小。这个训练优化过程对于 调整图像压缩的失真率是非常理想的。与 其他模型压缩技术相比,所提出的模型在没有额外训练过程或内存成本的情况下实现。通过引入熵损失,本文证明了 所提出的模型可以在保持较高图像质量 的同时保持较小的模型尺寸。实验结果表明,该模型的性能与传统的图像压缩模型相当,且不会产生很高的存储成本。

4.2 方法

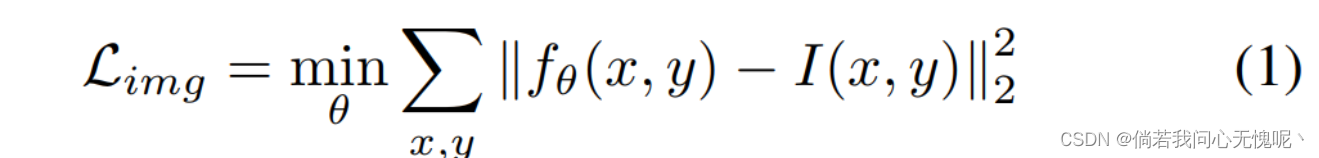

编码图像表示为 I I I, I [ x , y ] I[x,y] I[x,y]表示 ( x , y ) (x,y) (x,y)处像素的RGB值,映射函数可以定义为 f θ : R 2 → R 3 f_\theta: \R^2 \to \R^3 fθ:R2→R3, f θ f_\theta fθ通常是一个参数为 θ \theta θ的MLP模型,整体表示为 f θ ( x , y ) = ( R , G , B ) f_\theta (x,y)=(R,G,B) fθ(x,y)=(R,G,B),通常采用MSE作为损失函数:

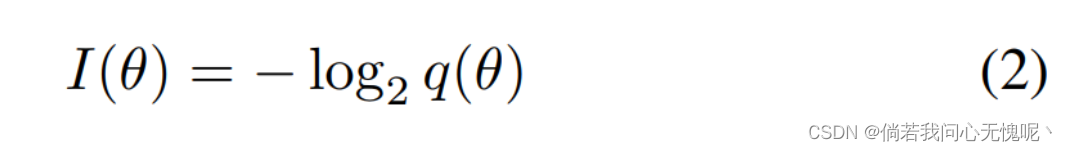

熵可以表示为:

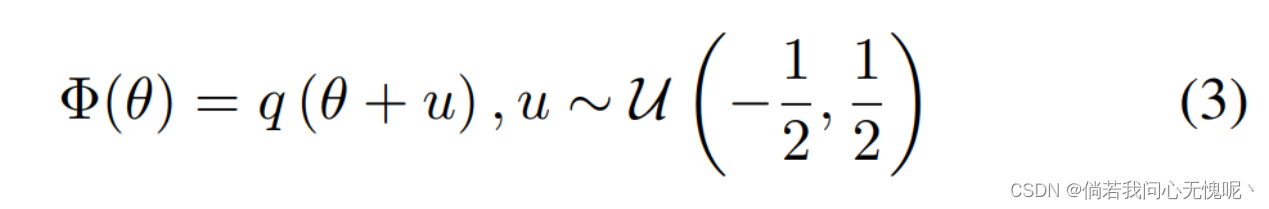

作者建模了一个量化逼近函数,从模型概率密度函数采样建模得到,可以通过一下函数进行熵编码:

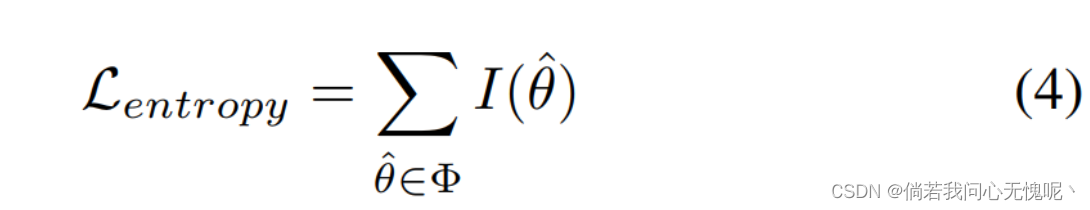

U ( − 1 / 2 , 1 / 2 ) \mathcal{U}(-1/2,1/2) U(−1/2,1/2)是独立同分布均匀分布的噪声。这种加性噪声作为一个很好的 近似熵使用负对数似然 与噪声离散化。该技术已广泛应用于 深度图像压缩模型中,通过熵编码来减小潜在特征的大小。这些模型 利用一个近似函数来优化 潜在特征的熵。另一方面,提出的模型使用 这个函数来优化和压缩MLP 本身的权重,而不是潜在特征。为了提高模型权值的稀疏性 ,所提出的模型利用模型权值的一个可微的 近似 θ ^ \hat{\theta} θ^来计算它作为损失 函数。近似表达式为:

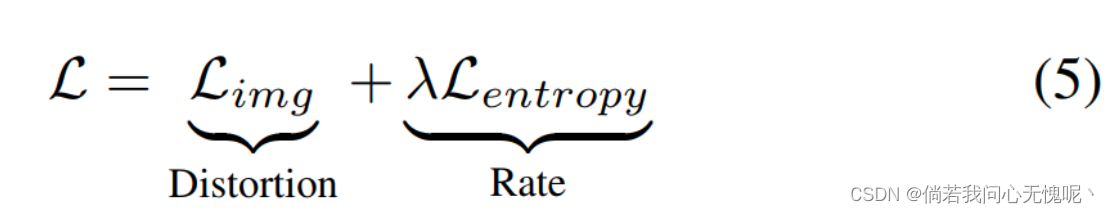

提出的模型结合了这个损失函数 最小化量化表示中的熵。这 导致 模型权重的相对稀疏的离散表示,从而在执行熵编码时显著减小压缩模型的大小 。该方法可以端到端、可训练地应用于现有的 INRs框架。因此, 整体损失函数只是 原始失真损失和模型权值 重参数化的熵的相加组合:

通过在不同的实验中调整λ,我们可以研究RD性能,这表明 压缩模型大小和模型性能之间的权衡。值得 注意的是,所提出的模型不需要任何后训练过程,并以 端到端方式有效地学习优化结果。

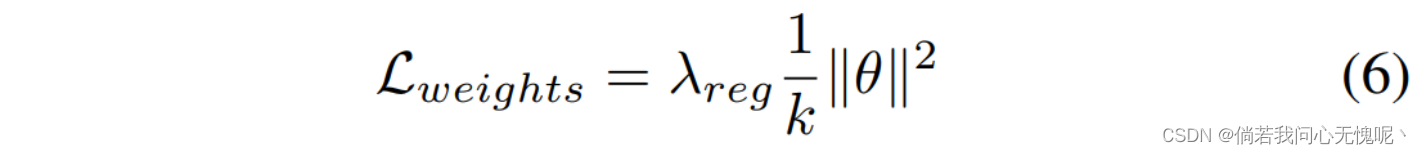

此外,本文还采用了权重正则化项 来最小化熵。这个术语与权重稀疏性有关, 但需要对其进行微调,以便在 速率和失真之间获得更好的权衡。具体而言,L2范数正则化 应用于模型权重,以实现以下优化目标:

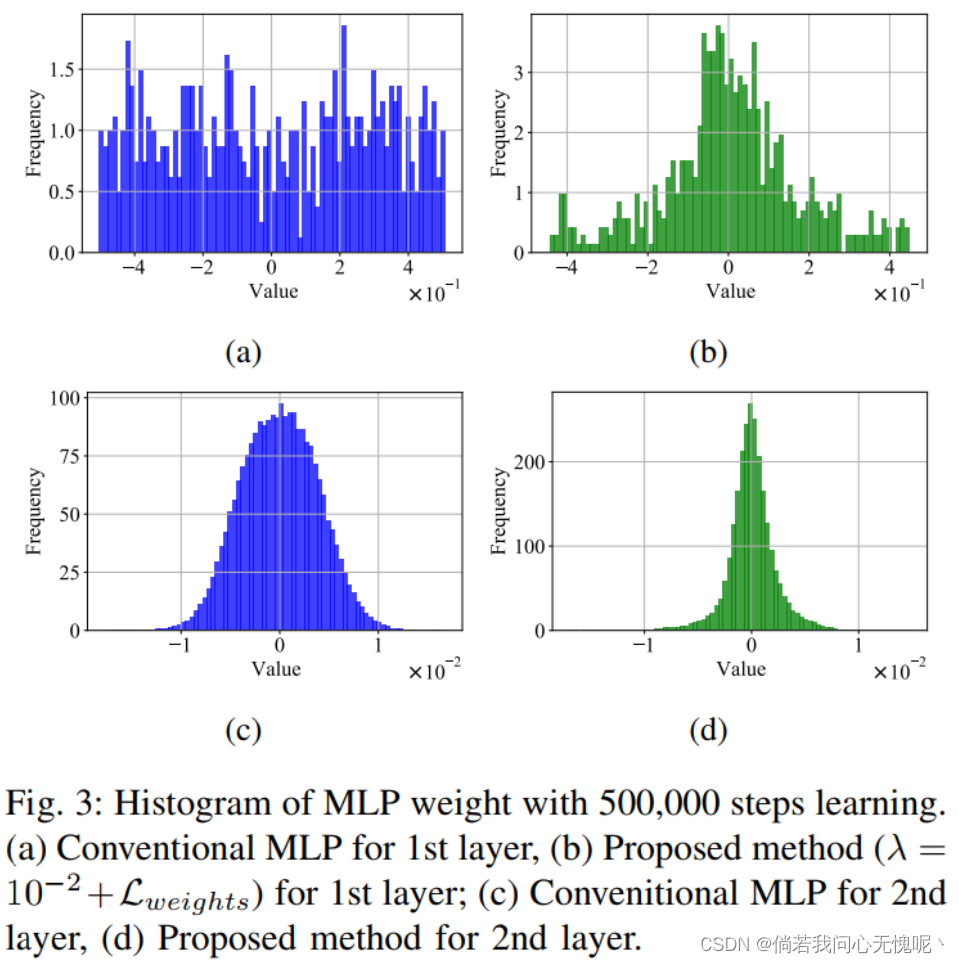

其中 k k k是权值 θ θ θ的个数。对于这四个结果, 本文考虑正则化加权参数 λ r e g = 1 0 − 3 λ_{reg} = 10^{−3} λreg=10−3。训练后的网络权值呈 直方图分布,冗余值的频率很高,如图3所示。

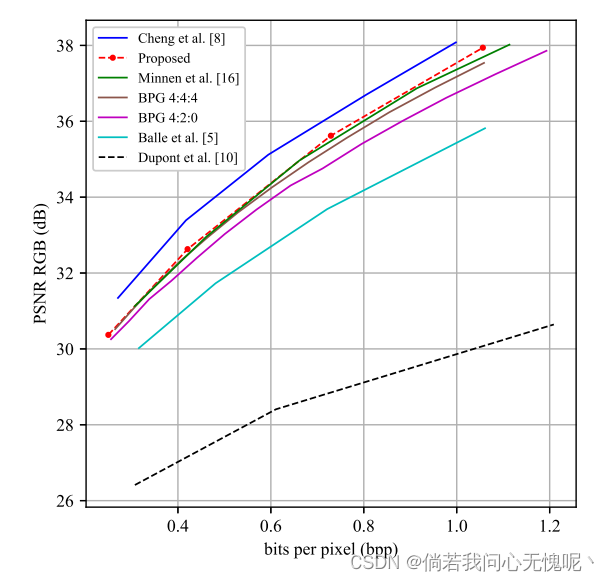

4.3 结论

提出了一种含有熵损失基于inr的图像压缩模型。提出的模型的关键思想是最小化权参数的熵,这在模型尺寸减小中起着重要作用, 进一步有助于以端到端 的方式利用熵编码。为了学习最小权值表示,采用加性 均匀噪声来准确估计模型权值的熵 。与基于自动编码器的 图像压缩模型相比,基于INR的方法只需要 很小的模型权值就可以重建整个图像。实验结果还表明,该模型 的性能明显优于传统的INR模型。

这性能也忒好了

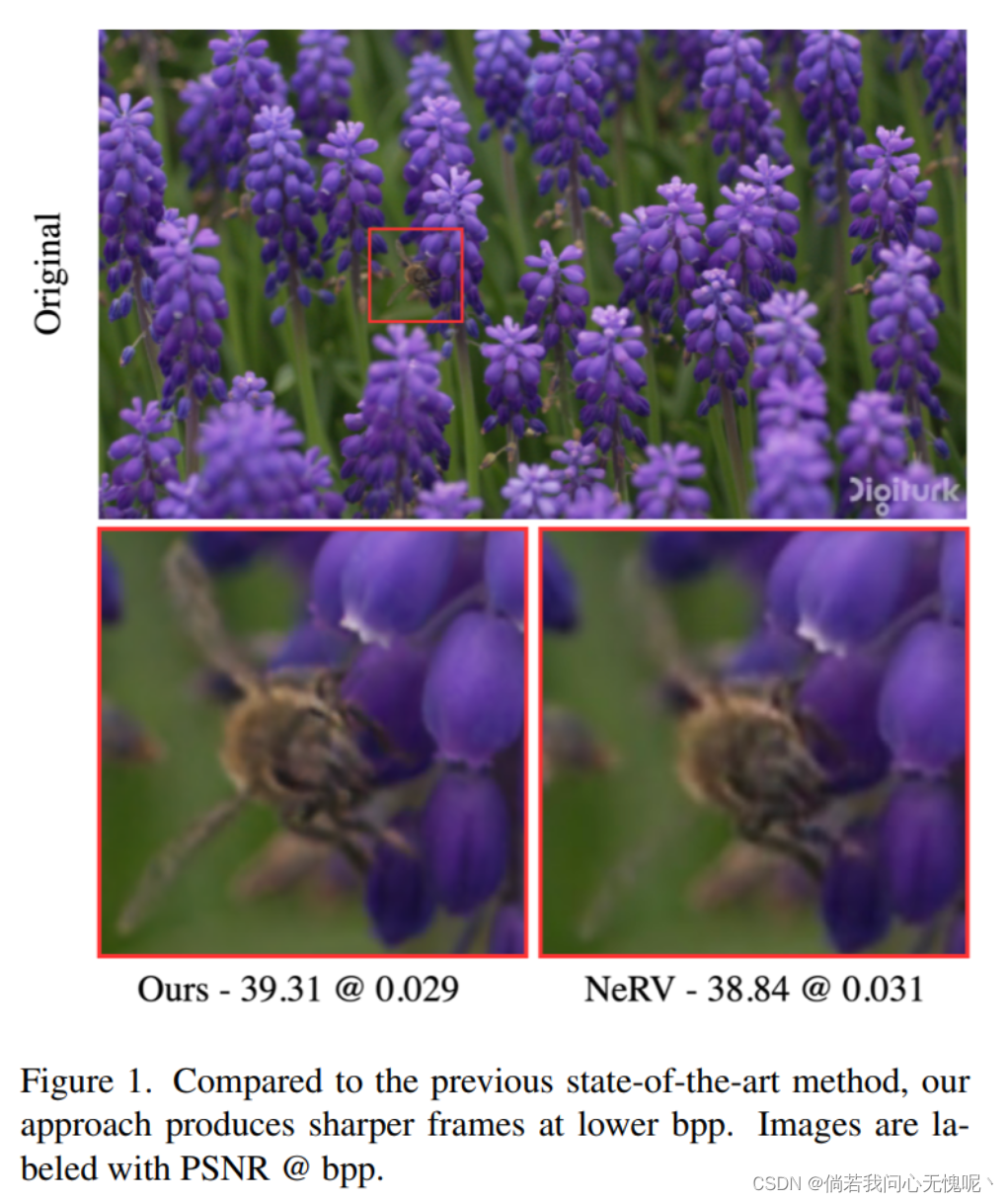

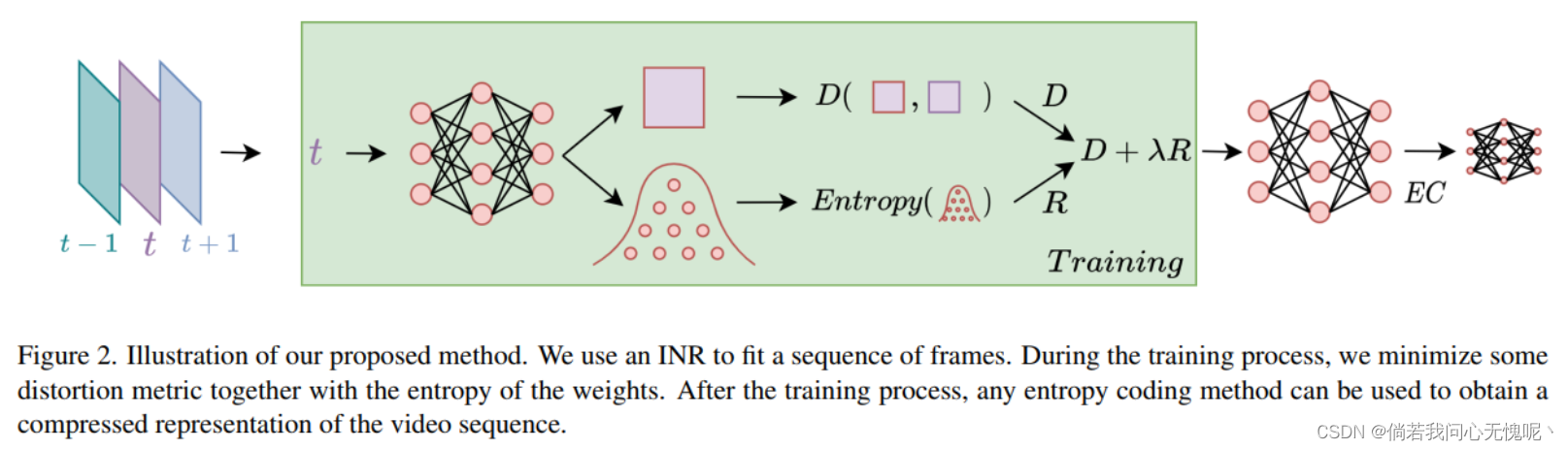

5.(CVPR 2023)Video Compression with Entropy-Constrained Neural Representations 具有熵约束神经表示的视频压缩

Paper:https://openaccess.thecvf.com/content/CVPR2023/papers/Gomes_Video_Compression_With_Entropy-Constrained_Neural_Representations_CVPR_2023_paper.pdf

看起来跟第四篇SPL的文章好像啊,不过作者和机构截然不同。

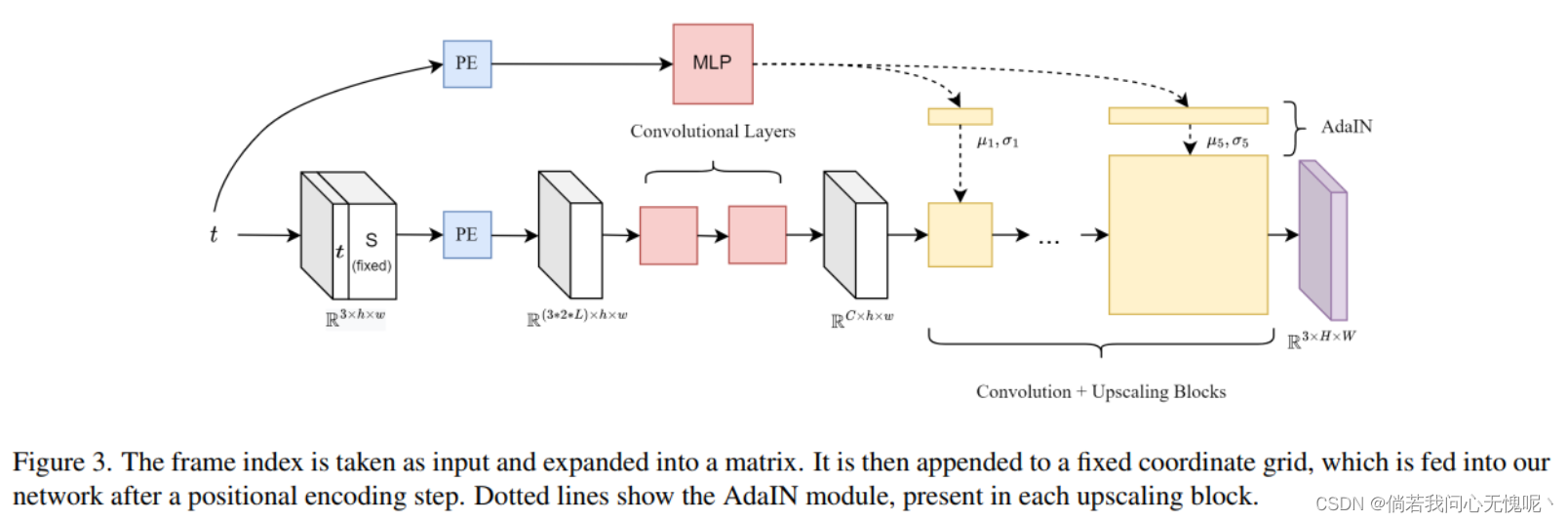

5.1 摘要

将视频编码为神经网络是最近提出的一种方法,它允许新形式的视频处理。然而,对于视频 压缩任务,传统技术仍然优于神经视频表示(NVR)方法。这种性能差距可以用目前的NVR方法来解释:(1)使用的架构不能有效地获得时间和空间信息的紧凑表示;(2)没有联合优化率失真损失 (首先在视频上过拟合网络 ,然后使用启发式技术,如训练后 量化或权值修剪来压缩模型)。我们提出了一种新的卷积视频表示架构,可以更好地表示时空信息 和一种能够联合优化码率和失真的训练策略。所有的网络参数和量化参数 都是端到端联合学习的,不需要之前工作中使用的后训练操作。我们在UVG数据集上评估我们的方法,获得了相较其他NVRs进行视频压缩的SOTA结果。此外, 我们提供了第一个基于nvr的视频压缩方法 ,该方法改进了常用的HEVC基准 (x265,禁用b帧,“medium”预设),缩小了与基于自动编码器的视频压缩技术的差距。本文的几点贡献总结如下:

- 我们提出了一种新颖的紧凑卷积架构 用于神经视频表示,它具有比NeRV更好的 表示能力和比E-NeRV更快的编码和解码速度.

- 我们正式地将信号压缩与INRs定义为R-D问题通过建模权值的熵和使用量化感知训练(允许端到端训练并消除对修剪等后训练技术的需要)

- 我们表明,这样的熵建模也可以改进其他方法,例如,NeRV;

- 我们在UVG数据集上评估了我们的方法,改进了使用INRs进行视频压缩的最新结果,并优于DVC,后者是一种成熟的神经视频压缩方法。

5.2 方法

有意思,确实跟第四篇图像INR的文章很像,我看上面一篇的时候还在想能不能用到视频中去转头就看到这篇视频的。

在结构方面的变动不大,基本是E-NeRV前面的MLP也丢掉了,换成了一个坐标连接形式的输入,并且添加了两个卷积层,在解码FPS上有略微提升。其实这里我也很不了解,按照我的经验E-NeRV的训练时间是要明显短于NeRV的,为什么表1中的结论是E-NeRV的训练时间是NeRV的两倍多。此外,表一就只在bigbuckbunny数据上进行实验有点太小儿科了,怎么不得多给点实验结果。

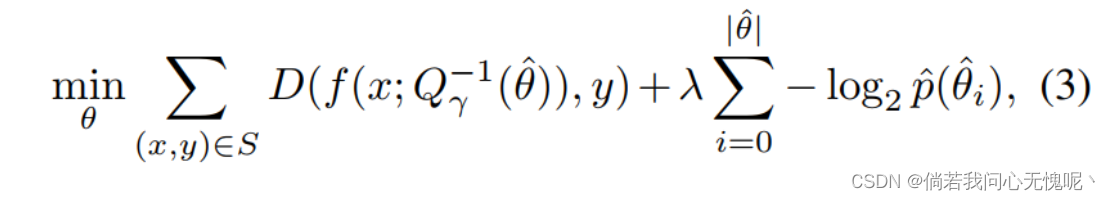

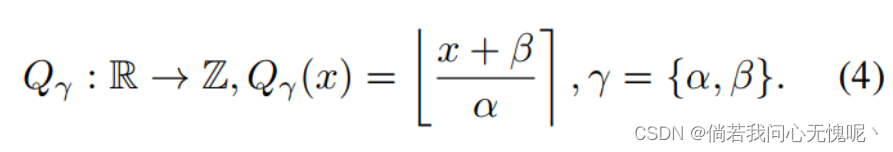

根据香农定理,计算熵需要采用一组离散符号。然而,对于网络优化需要使用连续的权重。为了解决这个问题,作者定义了:(1)一个包含可学习参数 γ \gamma γ的量化函数 Q γ Q_\gamma Qγ,将连续权重映射到离散符号;(2)一个逆量化函数 Q γ − 1 Q_\gamma^{-1} Qγ−1,将离散符号映射到各自量化区间的中心值。 Q γ − 1 Q_\gamma^{-1} Qγ−1显然不是 Q γ Q_\gamma Qγ的精准逆函数,因此 Q γ − 1 ( Q γ ( x ) ) Q_\gamma^{-1}(Q_\gamma(x)) Qγ−1(Qγ(x))在恢复 x x x时会产生一个误差除非 x x x刚好是其量化区间的中心点。

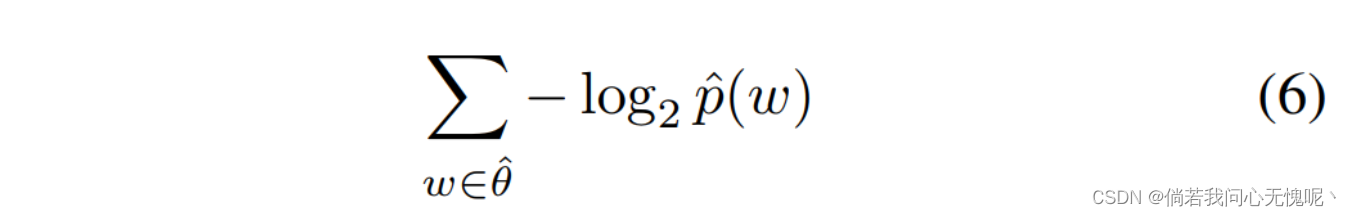

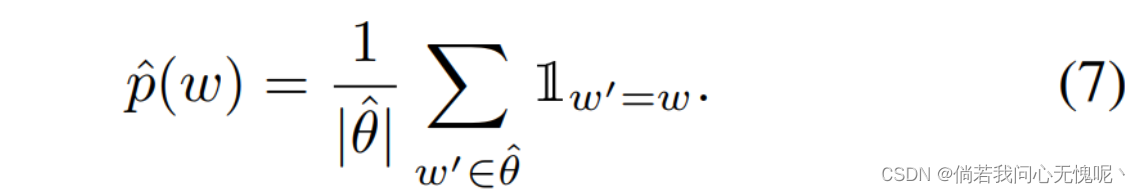

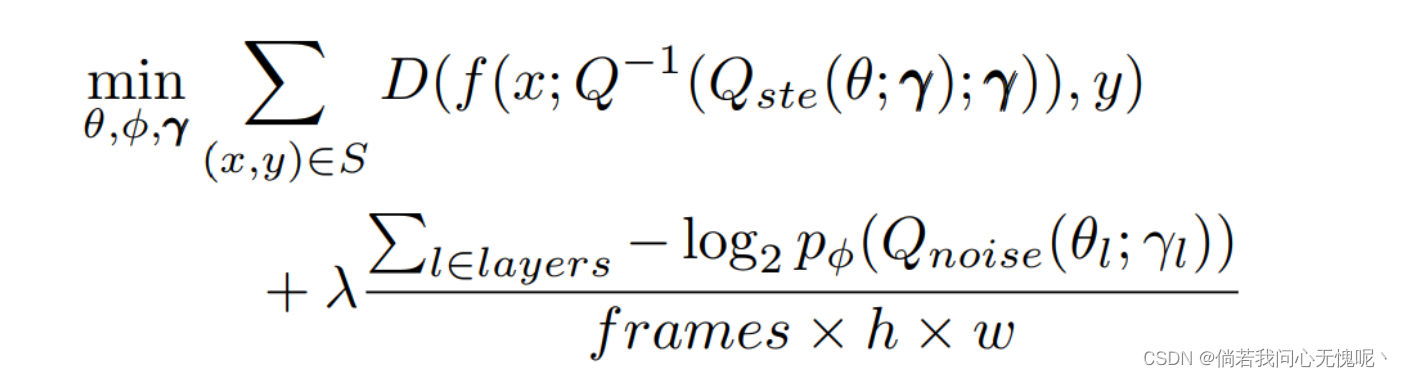

我们对连续权重 θ \theta θ进行优化,使用 θ ^ = Q γ ( θ ) \hat{\theta}=Q_\gamma(\theta) θ^=Qγ(θ)计算模型的码率,并且使用带有量化误差的权重 Q γ − 1 ( θ ^ ) Q_\gamma^{-1}(\hat{\theta}) Qγ−1(θ^)通过网络前向传递得到信号的近似值。为了进一步简化,假设 θ ^ \hat{\theta} θ^是由无记忆信源产生的符号组成。优化问题可以由下式表示:

其中 p ^ \hat{p} p^是 θ ^ \hat{\theta} θ^的概率质量函数,可以很容易计算得到。为了优化这种损失,该过程通过学习可以适当地表示信号的参数θ和提供足够小的量化误差的γ来最小化失真 。同时, Q γ ( θ ) Q_γ(θ) Qγ(θ)的分布也必须 具有足够小的熵,以使 R R R最小。

由此,可以确定了这一过程中引入的两个误差源。第一个误差是根据映射函数 f θ f_\theta fθ估计信号 s s s导致的误差,其可以通过增加模型参数数量进行最小化,在INR架架构中进行更好的选择等等。第二个是由量化函数 Q γ Q_\gamma Qγ造成的量化误差,这可以通过适当地移动量化区间的中心或使用更多更小宽度的量化区间来最小化,但会增加分布熵的代价。

量化: 现在定义函数 Q γ Q_γ Qγ,类似于文献[12,23],我们使用标量量化,将整数作为我们的离散符号集,并将 Q γ Q_γ Qγ定义为分别具有尺度和移位参数 α α α和 β β β的仿射变换,然后四舍五入到最接近的整数

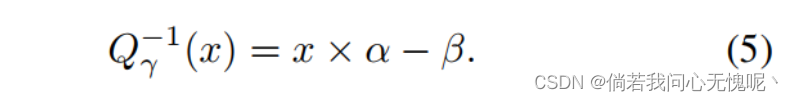

则反量化函数可以自然地定义为:

如文献[12,23],神经网络的每一层都是单独量化的,并且有自己的参数 α α α和 β β β,这两个参数本身是学习得到的。这允许在改变不同参数的量化时采用某种粒度级别,同时不会在必须存储的尺度和移位参数的数量上产生太大的开销。

这个过程的一个问题是 舍入运算的不可微性。在文献中有两种主要的方法来解决这个问题。首先是用与量化区间相同尺度的均匀噪声替换舍入操作。这经常被用作替代量化[13]。第二种是在计算用于舍入操作的梯度时使用直通估计器(STE)。我们将它们定义为两个函数, Q n o i s e Q_{noise} Qnoise和 Q s t e Q_{ste} Qste。与Balle等人[4]一样,我们使用 Q s t e Q_{ste} Qste来计算失真度量获得了最好的结果,因为它避免了随机噪声的引入,并且 Q n o i s e Q_{noise} Qnoise用于计算熵项。

熵建模: 给定 θ ^ \hat{\theta} θ^,我们可以计算出对网络中所有权值进行编码的最小位长度,如下所示:

其中

其中

这种方法的问题在于不可微分操作 I \mathbb{I} I(怎么用mathbb也打不出空心的1,尴尬) 。为了使用梯度下降训练网络,我们需要找到对权重的离散分布进行可微分近似的方法。我们遵循Balle等人的方法[4],通过用 Q n o i s e Q_{noise} Qnoise替换离散率项来用微分熵代替。然后,我们寻找一个参数化函数 p ϕ p_ϕ pϕ,它近似于由均匀噪声 θ ~ \tilde{\theta} θ~扰动的参数的概率密度函数。

我们可以使用上文提出的 损失函数[4],优雅地将这个近似的参数与INR的参数联合拟合。此外,我们将近似 p φ p_φ pφ与标准均匀密度进行卷积。Balle等人[4]认为,这可以更好地近似潜在分布,这也是我们经验观察到的。(除了使用参数化函数 p ϕ p_ϕ pϕ作为近似的概率密度函数之外,我们还将该函数与标准均匀密度进行卷积操作。这可以看作是将参数化函数 p ϕ p_ϕ pϕ与均匀分布进行混合,以获得更精确的概率密度函数。通过卷积操作,可以将参数化函数与均匀分布进行融合,从而更好地逼近所需的概率密度函数。这样做的目的是提高模型的准确性和性能。)

给定 p θ p_\theta pθ,我们的完全体损失可以定义为

其中 γ γ γ从每一层收集所有的 α α α和 β β β。左边的 项使用量化权重计算数据集上的失真度量,这些权重是使用每个 层各自的 α α α和 β β β计算的。右边的项近似最小位长度,以使用 p ϕ p_ϕ pϕ编码近似量化的参数。码率项除以总像素数,使λ不因视频的分辨率和帧数进行调整改变。

为了对神经网络的权重进行建模,我们将每层中的权重解释为来自独立来源的权重。在每一层中,权重取为独立同分布的样本。我们尝试了不同的模式, 例如联合建模网络中的所有权重,但发现 通过允许每个层 独立建模,我们获得了更好的结果。根据Balle等人[5],我们对每个层的权值分布拟合了一个 小神经网络。这个过程的细节可以参考[5, 附录6.1]。在训练过程结束时,我们使用 上下文自适应二进制算术编码器(CABAC)进行 熵编码,采用 DeepCABAC[32]提供的实现对 神经网络的权值执行经典CABAC编码。

5.3 结论

我们提出了一种新颖的卷积架构,用于视频 表示,能够实现更高保真度的编码。我们将其与端到端基于熵的神经网络压缩方法相结合来实现视频压缩,通过将损失形式化为率失真问题来弥合与神经视频压缩的差距。我们通过在UVG 数据集上进行测试来证明我们方法的有效性,在使用INRs的视频压缩中产生了最先进的结果。虽然目前的结果是有希望的, 采用神经表示视频压缩作为可行的编码器仍然需要未来的研究 成本更低的熵建模方法,以便 加快编码时间,以及进一步的架构改进,在紧凑的网络中寻求参数的最佳分布。

6. (arxiv 2023)Compression with Bayesian Implicit Neural Representations 使用贝叶斯隐式神经表示进行压缩

6.1 摘要

许多常见类型的数据可以表示为将坐标映射到信号值的函数,例如在图像的情况下,将像素位置映射到RGB值。基于这种观点,可以通过将一个紧凑的神经 网络过拟合到它的功能表示中,然后对网络权重进行编码来压缩数据。然而,目前大多数解决方案都是低效的,因为量化到低比特 精度大大降低了重建质量。为了解决这个问题,我们提出对数据进行过拟合变分贝叶斯神经网络,并使用相对熵编码 而不是量化和熵编码来压缩近似后验权重样本。该策略通过最小化 β β β-ELBO来直接优化速率失真性能,并通过调整β来针对给定的网络架构实现 不同的速率失真权衡。此外,我们引入了一种迭代算法来学习先验权重分布,并对变分后验采用渐进式改进过程 显著提高了性能。实验表明,该方法在保持简单性的同时,在图像和音频压缩方面取得了 较强的性能。本文贡献如下:

- 通过使用相对熵编码编码INR权重样本,我们提出了变分贝叶斯隐式神经表示用于模态不可知数据压缩。我们将我们的方法成为贝叶斯隐式神经表示压缩(COMBINER)。

- 我们提出了一种迭代算法来学习权重的先验分布,并提出了一种渐进策略来改进后验,这两种方法都显著提高了性能。

- 我们对CIFAR-10, Kodak和librisspeech数据集进行了实验,并证明了COMBINER虽然比相关方法简单,但却实现了强大的性能。

6.3 结论和局限性

结论: 在本文中,我们提出了一种新的神经压缩方法COMBINER,该方法首先 将数据编码为变分贝叶斯隐式神经表示,然后使用相对熵编码传递近似后验权重样本。不像以前的基于INRE的神经网络编解码器,COMBINER支持联合速率失真优化,因此能够自适应激活和修剪网络参数。围绕这个框架,我们还引入了 迭代算法来学习先验权重分布,并逐步改进变分后验,从而显著提高了率失真性能。实验证明了我们的 在低分辨率和高分辨率图像和音频上的强大压缩性能,展示了变分贝叶斯隐式神经表示压缩的巨大潜力。

局限性: 我们提出的新压缩方法存在一些局限性。首先,如5.2节 所述,虽然COMBINER的解码过程很快,但其编码时间却相当长。优化变分后验分布需要数千次迭代,并且 逐步微调它们也很耗时。概率MAML[54]可能会 减少编码时间,但它可能会导致更复杂的训练过程。其次,贝叶斯神经网络天生对初始化敏感[55]。有时需要相当大的努力来确定最佳的初始化设置,以实现训练稳定性和优越的率失真性能。尽管存在这些挑战,我们相信COMBINER为 与INRs联合压缩率失真优化铺平了道路。

7.(arxiv 2023)LEARNED WAVELET VIDEO CODING USING MOTION COMPENSATED TEMPORAL FILTERING 使用运动补偿时间滤波的学习小波视频编码

Paper:https://arxiv.org/abs/2305.16211

7.1 摘要

本文提出了一种基于运动补偿时间滤波(MCTF)的端到端可训练小波视频编码器。从而,我们为可学习视频压缩引入了一种不同的编码方案,目前该方案主要由残差和条件编码方法主导。通过在时间、水平和垂直维度上执行离散 小波变换,我们获得了一个具有空间 和时间可扩展性的可解释框架。我们专注于研究一种新的可训练MCTF模块,该模块使用提升方案实现。我们展示了在训练期间如何考虑MCTF中的多个时间分解级别,以及如何处理由于MCTF编码顺序造成的较大 时间位移 。此外,我们提出了MCTF的内容自适应扩展 ,该扩展可以在 推理过程中适应不同的运动强度。在我们的实验中,我们将基于mctf的 方法与基于学习的条件编码器和传统混合视频编码进行了比较。特别是在高速率下,我们的 方法具有很好的速率失真性能。我们的 方法在UVG数据集上比HEVC平均节省了 21%的Bjøntegaard Delta,因此优于最先进的学习视频编码器。本文贡献总结如下:

- 介绍了首个端到端可训练小波视频编码方案。

- 我们提出了一种适合MCTF中多个时间分解层次的训练策略。

- 我们研究由于MCTF编码结构造成的大型时域位移,并提出了第一种解决方案,以更有效地处理这些情况。

- 我们提出了一种内容自适应MCTF方法,该方法可以适应推理过程中不同的运动类型。

7.2 结论

本文介绍了基于MCTF的首个端到端可训练的 小波视频编码器。我们提出了一个训练策略,在训练过程中考虑多个时间分解层次 。此外,我们提出了下采样 策略,作为处理MCTF中较大时间 位移的第一个解决方案。我们新颖的内容自适应MCTF 使我们的方法能够适应每个 序列的不同运动类型。实验结果表明,我们的学习 MCTF视频编码器具有良好的率失真性能,特别是在高比特率下。在UVG数据集上, 与 HM相比,当GOP大小为4和8时,我们的方法MCTF-CA实现了平均BD率节省 -21%和-9%。因此,它明显优于最先进的视频 编码器DCVC-HEM。

作为学习小波视频编码器的初始版本, 有各种改进的可能性。首先,我们将测试实际使用所需的不同时间子带编码器 ,因为iWave++的自回归上下文模型禁止并行化。其次,MCTF 结构需要扩展以处理大于8 的GOP大小和更多样化的运动类型。为此,我们将研究双向运动估计。为了减轻更大GOP大小的重影 ,我们将实现截断DWT的自适应选择 ,而不进行时间更新[29]。此外, 内容自适应MCTF的复杂性可以通过来限制,使用预测器来选择自适应MCTF选项。基于mctf的方法为常见的基于自动编码器的视频编码器提供了一种可解释和可扩展的替代方案。我们迈出了进一步发展这一重要研究方向的第一步。

8. (ICLR 2020)Scalable Model Compression by Entropy Penalized Reparameterization 通过熵惩罚重新参数化的可扩展模型压缩

Paper: https://arxiv.org/abs/1906.06624

Unofficial Code: https://github.com/Dan8991/SMCEPR_pytorch

Code 2:https://www.tensorflow.org/tutorials/optimization/compression

貌似在tensorflow的官网代码中提供了一份。

8.1 摘要

我们描述了一种简单而通用的神经网络权重压缩方法, ,其中网络参数(权重和偏差)在“潜在”空间中表示,相当于重新参数化。该空间配备 学习概率模型,在训练过程中对参数表示施加熵惩罚,训练后使用 简单的算术编码器对表示进行压缩。分类精度和模型可压缩性共同最大化,比特率和精度之间的权衡由超参数指定。我们使用六种不同的模型架构在MNIST、CIFAR-10和ImageNet 分类基准上评估了该方法。我们的研究结果表明,最先进的模型压缩可以以可扩展和通用的 方式实现,而不需要复杂的过程,如多阶段训练。

本文的贡献是双重的。首先,我们提出了一种新的端到端可训练模型压缩方法,该方法在模型参数的重参化空间中使用标量量化和熵惩罚。重新参数化使我们能够使用有效的SQ,同时在表示模型参数方面实现灵活性。其次,我们在多个数据集上对各种 网络架构提供了最先进的结果。这表明,许多之前的方法所采用的更复杂的策略,包括预训练、多阶段训练、稀疏化、自适应编码等,并不是获得良好性能所必需的。我们的方法适用于现代 大型图像数据集和神经网络架构,如ImageNet上的ResNet-50。

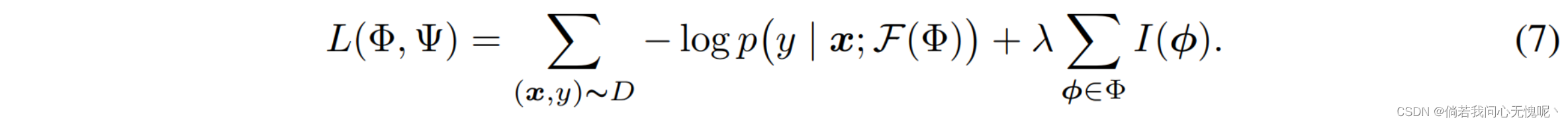

总体表现出来的目标函数就是下图的形式,左边是使用图像分类任务的带量化映射函数的交叉熵损失,即精度损失;右侧是熵约束项,即码率损失。

8.2 结论

我们描述了一种简单的模型压缩方法,该方法基于两个要素:联合(即端到端) 在单个训练阶段优化可压缩性和任务性能,以及模型参数的重新参数化,这增加了标量量化表示的灵活性 ,并且适用于任意网络架构。我们证明,使用这个简单的框架可以实现最先进的模型压缩性能,优于依赖于复杂的多阶段训练程序的 方法。由于其简单性, 方法特别适用于较大的模型,例如VGG,特别是ResNets。在未来的工作中,我们 可能会考虑更灵活(更深)参数解码器的潜在好处。

9.(Neurocomputing 2023)Multiple Hypotheses Based Motion Compensation for Learned Video Compression 基于多假设的学习视频压缩运动补偿

9.1 摘要

近年来,视频压缩技术引起了广泛的研究关注。然而,在现有的方法中,用于对齐的运动仅局限于一个假设,导致运动估计不准确,特别是对于具有复杂运动的复杂场景。基于传统视频压缩中的多假设思想,我们针对可学习视频压缩,提出了基于多假设的运动补偿方法,通过对多种假设进行有效的时间信息融合,提高运动补偿效率。特别提出了多假设模块,该模块产生多个运动和扭曲特征 ,以挖掘足够的时间信息,并从 参考框架中提供各种假设推断。为了更充分地利用这些假设,我们采用了假设关注模块 ,引入了通道型挤压激励层和多尺度网络。此外,本文还采用上下文组合的方法,对加权假设进行融合,生成具有强大时间先验的有效上下文。最后,利用有效上下文通过合并加权扭曲特征来提高 压缩效率。大量实验表明, 所提出的方法可以显著提高学习视频压缩的率失真性能。与最先进的端到端视频压缩方法相比,在PSNR和MS-SSIM方面可以实现13%以上的平均比特率降低。

本文的贡献总结如下:

- 我们提出了基于多假设的运动补偿,目的是在学习视频压缩中利用解码后的运动来生成多个运动和扭曲特征。给定基于多个假设的多重翘曲,产生充分对齐的特征,从而充分利用参考帧中的多个参考样本进行运动补偿。

- 我们提出了假设关注模块来学习不同假设的权重,通过挤压激励层和多尺度网络探索不同运动扭曲的特征之间的关系。在此基础上,提出了上下文组合模块,通过合并加权扭曲特征生成有效上下文。

- 大量的实验结果表明,该方法在各种数据集上都优于当前最先进的方法。特别是,我们的方法可以实现超过13%的比特率平均降低,与PSNR和MS-SSIM近似时的DCVC方法比较。

9.2 结论

本文针对学习视频压缩,开发了基于多假设的运动补偿方案 ,包括多假设模块、假设关注模块 和追求高级编码性能的上下文组合模块 。方法的新颖之处在于采用了复杂的多假设机制,可以利用参照系的多种信息实现更好的时间先验 挖掘。具体来说,多运动和扭曲特征由多假设模块产生,用于提供各种假设,其中当前框架中的样本可以参考参考框架中的多个样本。此外,提出了假设注意模块,通过注意基础结构探索多个假设之间的关系。最后,通过上下文组合对 加权假设进行融合,生成提高压缩效率的有效上下文。实验结果表明,我们的方法优于目前最先进的方法。

10.(CVPRW 2023)Adaptive Human-Centric Video Compression for Humans and Machines 适用于人和机器的自适应以人为本的视频压缩

10.1 摘要

我们提出了一个新的框架来压缩以人为中心的视频,以供人类观看和机器分析。我们的系统使用三个编码分支来结合通用面部先验学习的能力和数据依赖的 细节恢复。通用分支将人脸嵌入到由学习的高质量 (HQ)码本描述的离散代码空间中,以重建HQ基线人脸。域自适应分支通过补充代码本添加域特定信息来调整重建以适应当前数据域。任务自适应分支从低质量(LQ)输入中获取辅助细节,以帮助机器分析修复后的面部。引入自适应权重来平衡重建中域自适应和任务自适应特征的使用,推动包括感知质量、 保真度、比特率和任务精度在内的标准之间的权衡。此外,提出的 在线学习机制根据实际压缩需求自动调整自适应权值。通过共享主通用分支,与传统编码方案相比,我们的框架可以更灵活地扩展到多个数据域和多个任务。我们的实验表明,在非常低的比特率下,我们可以恢复具有高感知质量的人脸供人类观看,同时保持高识别精度供机器使用。

贡献总结如下:

- 一种新的基于鲁棒人脸恢复的以人为中心的视频压缩框架,以适应人类和机器的压缩需求。通用分支使用高效的离散通用代码本表示确保基线高质量面部重建。领域自适应分支使用特定于领域的代码本提供补充信息,以调整当前数据领域的重建。任务自适应分支从LQ输入中获得额外的详细线索对修复后的面部进行协助分析。我们的方法 可以很容易地扩展到多个数据域和任务。

- 灵活的测试阶段质量控制。将高质量通用特征 和域自适应特征 加权结合,以平衡感知质量和对当前数据域的真实性。同样地, 高质量通用特性和任务自适应低质量特性使用使用一个组合权重结合在一起用于平衡比特率和任务性能。

- 根据当前测试数据和实际压缩需要,自动调整域自适应特征和任务自适应特征组合权值的在线元学习机制。

10.2 结论

我们提出了一个以人为中心视频压缩的鲁棒框架,以适应人类观看和机器分析。通用分支使用高效通用码本表示,保证了高感知质量的人脸重建。在附加分支中提供了 域自适应和任务自适应的细节,分别提高了 当前数据域的视觉真实性,供人类使用,以及用于机器分析的任务性能。在线调整通用特征、领域自适应特征和任务自适应特征的组合权值 ,以适应不同的压缩需求。实验证明了在极低比特率下具有优异的感知质量和任务 准确性。与传统的 编码方法相比,我们的框架可以灵活配置 ,并且可以更好地扩展到多个数据域和任务。