1.[方式1]API站获取API-Key

获取API-Key看教程 【保姆级教程】手把手教你玩转多种OneAPI平台,白嫖GPT3.5

这里送两个模型的API-Key[限额限时],给大家试用

支持模型gpt-3.5-turbo

sk-aTU1v09zvzfZLJ6oCzhIxilgri7sFYZ0Xf1lItmqKCGgI2Mt

支持模型glm-4-flash

sk-imPBx64LT9WjxVaOii0BWJQWLqD1RLw4Rn0XVU1k3q7HgvPE

2.使用API-Key

2.1 使用gpt-3.5-turbo模型

from langchain.chat_models import ChatOpenAIllm = ChatOpenAI(openai_api_base="https://api.crond.dev/v1", # 注意,末尾要加 /v1openai_api_key="aHP78iUOsuamufjyc2lkt0KD0iOFRKfly8fQ74QcdWrPbyrm",model="gpt-3.5-turbo" # 启用gpt-3.5-turbo模型

)res = llm.predict("hello")print(res)

2.2 使用glm-4-flash模型

from langchain.chat_models import ChatOpenAIllm = ChatOpenAI(openai_api_base="https://api.crond.dev/v1", # 注意,末尾要加 /v1openai_api_key="sk-imPBx64LT9WjxVaOii0BWJQWLqD1RLw4Rn0XVU1k3q7HgvPE",model="glm-4-flash" # 启用glm-4-flash模型

)res = llm.predict("hello")print(res)

3.[方式2]硅基流动获取API-Key

注册方法看这篇

【1024送福利】硅基流动送2000万token啦!撒花✿✿ 附使用教程

硅基

真香!这些都能用ChatOpenAI直接调用

4.使用API-Key

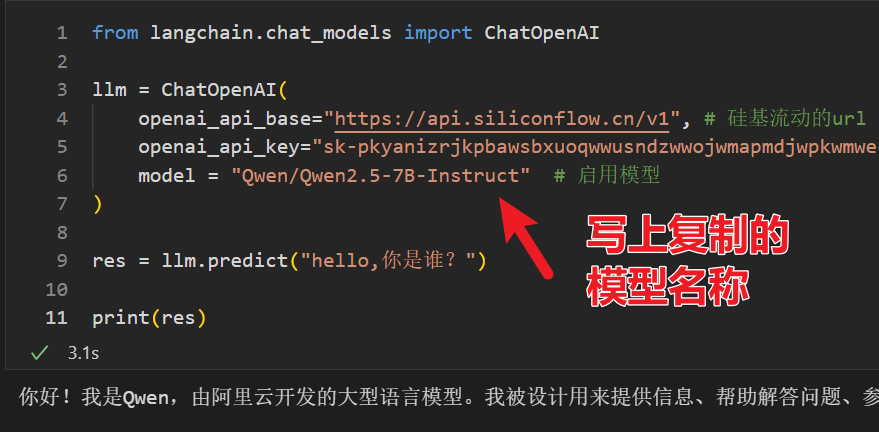

我已Qwen/Qwen2.5-7B-Instruct和Pro/thudm/chatglm-3-6b为例示范,其他模型同理,只要你的余额充足

4.1 使用Qwen/Qwen2.5-7B-Instruct

直接可以跟模型对话啦!

from langchain.chat_models import ChatOpenAIllm = ChatOpenAI(openai_api_base="https://api.siliconflow.cn/v1", # 硅基流动的urlopenai_api_key="sk-pkyanizrjkpbawsbxuoqwwusndzwwojwmapmdjwpkwmwe", # 自己的api-keymodel = "Qwen/Qwen2.5-7B-Instruct" # 启用模型

)res = llm.predict("hello,你是谁?")print(res)

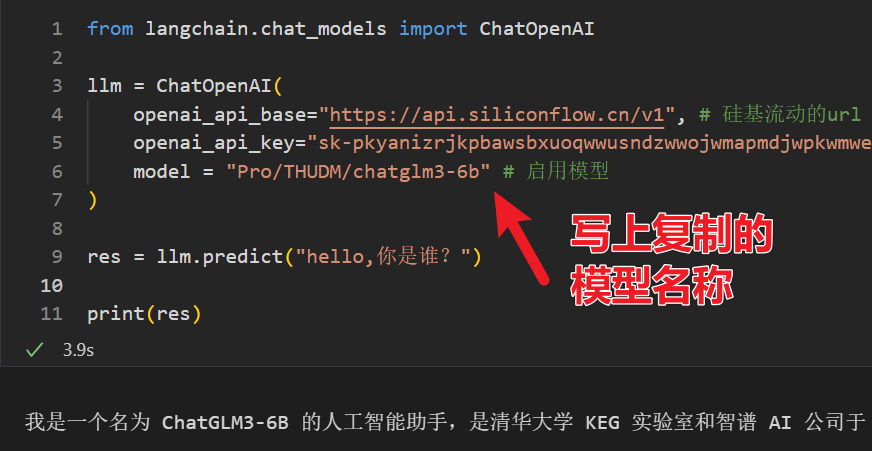

4.2 使用Pro/thudm/chatglm-3-6b

from langchain.chat_models import ChatOpenAIllm = ChatOpenAI(openai_api_base="https://api.siliconflow.cn/v1", # 硅基流动的urlopenai_api_key="sk-pkyanizrjkpbawsbxuoqwwusndzwwojwmapmdjwpkwmwe", # 自己的api-keymodel = "Pro/THUDM/chatglm3-6b" # 启用模型

)res = llm.predict("hello,你是谁?")print(res)

这样就能开发自己的高级应用啦!

\

参考链接

LangChain使用ChatOpenAI