1873年,当时科学家约瑟·美(Joseph May)及伟洛比·史密夫(WilloughbySmith)就发现了硒元素结晶体感光后能产生电流,这是电子影像发展的开始。以后陆续有组织和学者研究电子影像,发明了几种不同类型的图像传感器。其中重要的发明有20世纪50年代诞生的光学倍增管PMT和70年代出现的电荷耦合装置CCD。

20世纪末,又有三种新型的图像传感器问世了,它们分别是互补氧化金属半导体CMOS、接触式图像传感器(Contact lmage Sensor,简称CIS)和LBCAST传感器系统(Lateral Buried Charge Accumulator, Sensing Transistor Array)。

1、PMT Photo Multiplier Tube 光学倍增管

从五十年代发展到现在,PMT是最早出现的图像传感器,技术已经非常成熟,是目前性能最好的传感器。它就像一个圆柱体小灯泡,直径约一寸,长度约二寸;内置多个电极,将进入的光信号转化为电信号,即使很微弱的光线也可准确补捉。其最高动态范围可达4.2,相对于其它类型只能达到3.2-3.6的传感器,PMT要胜出不少;而且它非常耐用,可以运作十万小时以上。但是由于其造价相当高,只能应用于专业的印刷、出版业扫描仪及工程分析。

2、CCD Charge Coupled Device 电荷耦合装置

CCD是美国贝尔实验室于1969年发明的,与电脑晶片CMOS技术相似,也可作电脑记忆体及逻辑运作晶片。CCD是一种特殊的半导体材料,由大量独立的感光二极管组成,一般这些感光二极管按照矩阵形式排列(富士公司的Super CCD除外)。CCD的感光能力比PMT低,但近年来CCD技术有了长足的进步,又由于CCD的体积小、造价低,所以广泛应用于扫描仪、数码相机及数码摄像机中。目前大多数数码相机采用的图像传感器都是CCD。

早期的CCD是隔行扫描(隔行传输Interline Transfer)的,这样可以提高快门速度,但图像精度大为降低。新的CCD一般都是逐行扫描(全帧传输FullFrame Transfer)的。

它在一块半导体上集成制造出感光器件:光电二极管和一些电路。每个单元呈整齐的矩阵式排列,CCD像素=行数×列数。每个像素单元中有大约30%的面积用来制造光电二极管,在剩余的可用面积中,会放置一个转移寄存器。在接受一个指令后,光电二极管感受到的光强,会被放置在这个转移寄存器中并暂时存储在这里,这是一个模似信号。接着就是把这每一个像素中的光强值,变成数字信号,再由相机中的处理器组合成一幅数字图像。由于每个像素单元中,真正用于感光的面积只占30%左右,所以它的感光效率比较低。所以在真正的成品中,会在每个像素单元的上面,再放一个小的光学镜片,我们把它叫做“微透镜”。微透镜在光电二极管的正上方,面积造得比较大,这样就能把更多的入射光集中到光电二极管上,使等效的感光面积达到像素面积的70%左右。

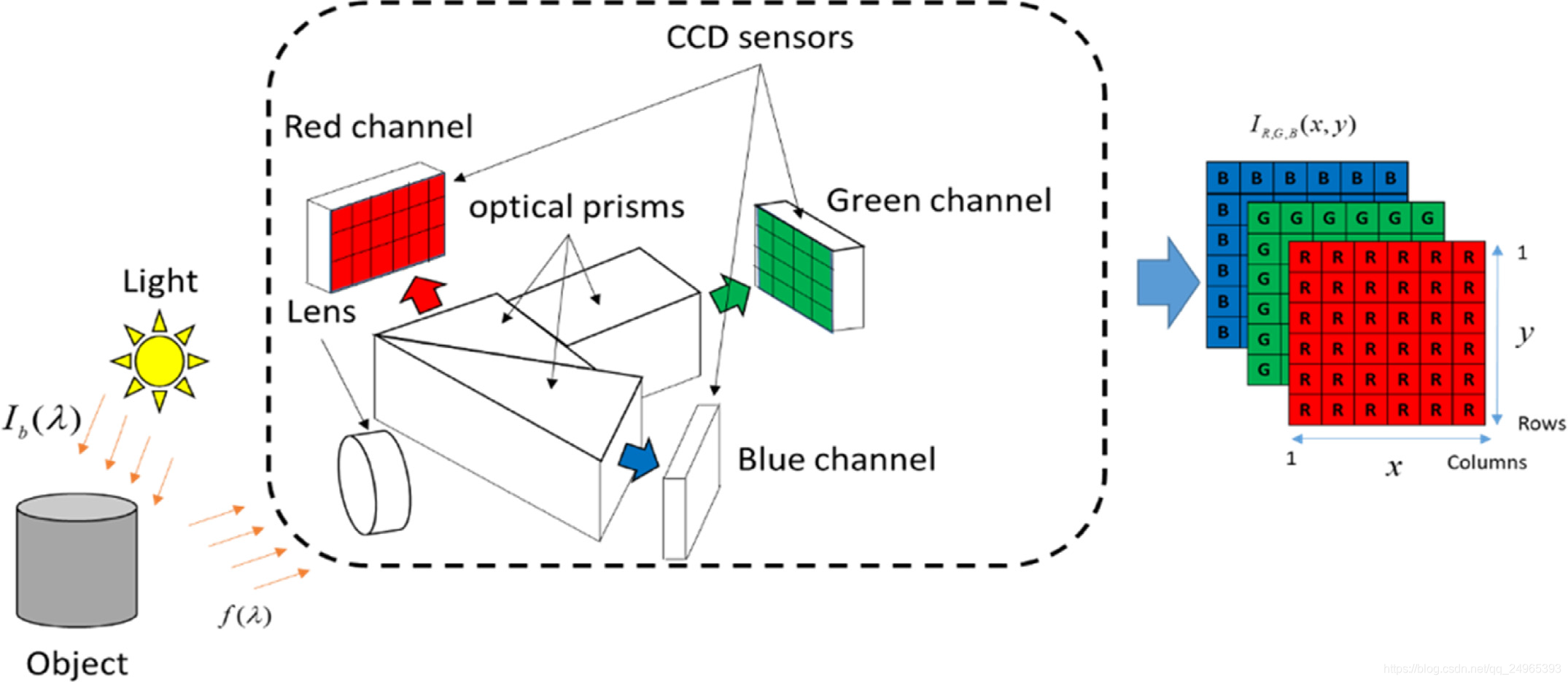

原色CCD和补色CCD:实际上CCD本身是不能分辨颜色的,所以,在实际应用时需要使用色彩滤镜,一般地就是在CCD器件的滤镜层涂上不同的颜色。滤镜上不同的色块按G-R-G-B(绿-红-绿-蓝)的顺序象马赛克一样排列,使每一片“马赛克”下的像素感应不同的颜色。红色滤镜只能透过红光,蓝色滤镜只能透过蓝光。

例如,在一个130万像素的CCD上,有325000个像素感应红色,325000个像素感应蓝色,650000个像素感应绿色。在一个使用这种CCD的分辨率为1280x1024的数码相机中,有640x512个红色像素、640x512个蓝色像素和640x1024个绿色像素,绿色像素多一点,是因为人类眼睛对绿色的敏感性和对其它颜色不一样。最后在记录图像时,每个像素的真实色彩就是它与周围像素象混合的平均值。目前大多数数码相机都是采用这种CCD。

线性CCD,不同于矩阵CCD,可能感光元件线性排列,所以是条状。比如条形码扫描枪。

3、CMOS Complementary Metal Oxide Semiconductor 互补氧化金属半导体

CMOS直到1998年它才被用于制作图像传感器。CMOS的优点是结构比CCD简单,耗电量只有普通CCD的1/3左右,而且制造成本比CCD要低。自从佳能公司在专业数码单反相机EOS D30中采用了CMOS以来,已经有越来越多的数码单反相机使用它,目前数码单反相机中几乎有一半采用CMOS作为图像传感器。

4、CCD与CMOS的比较

CCD与CMOS两种传感器在“内部结构”和“外部结构”上都是不同的。CCD器件的成像点为X-Y纵横矩阵排列,每个成像点由一个光电二极管和其控制的一个电荷存储区组成;CCD仅能输出模拟电信号,输出的电信号还需经后续地址译码器、模数转换器、图像信号处理器处理,并且还需提供三相不同电压的电源和同步时钟控制电路。CMOS器件的集成度高、体积小、重量轻,它最大的优势是具有高度系统整合的条件,因为采用数字——模拟信号混合设计,从理论上讲,图像传感器所需的所有功能,如垂直位移、水平位移暂存器、传感器阵列驱动与控制系统(CDS)、模数转换器(ADC)接口电路等完全可以集成在一起,实现单芯片成像,避免使用外部芯片和设备,极大地减小了器件的体积和重量。

CCD存储的电荷信息,需在同步信号控制下一位一位地实施转移后读取,电荷信息转移和读取输出需要有时钟控制电路和三组不同的电源相配合,整个电路较为复杂,速度较慢。CMOS光电传感器经光电转换后直接产生电压信号,信号读取十分简单,还能同时处理各单元的图像信息,速度比CCD快得多。

从功耗和兼容性来看,CCD需要外部控制信号和时钟信号来获得满意的电荷转移效率,还需要多个电源和电压调节器,因此功耗大;而CMOS-APS使用单一工作电压,功耗低,仅相当于CCD的1/10-1/100,还可以与其他电路兼容,具有功耗低、兼容性好的特点。

CCD传感器需要特殊工艺,使用专用生产流程,成本高;而CMOS传感器使用与制造半导体器件90%的相同基本技术和工艺,且成品率高,制造成本低,目前用于摄像的50万像素的CMOS传感器不到10美元。

CCD使用电荷移位寄存器,当寄存器溢出时就会向相邻的像素泄漏电荷,导致亮光弥散,在图像上产生不需要的条纹。而CMOS-APS中光探测部件和输出放大器都是每个像素的一部分,积分电荷在像素内就被转为电压信号,通过X-Y输出线输出,这种行列编址方式使窗口操作成为可能,可以进行在片平移、旋转和缩放,没有拖影、光晕等假信号,图像质量高。

高速性是CMOS电路的固有特性,CMOS图像传感器可以极快地驱动成像阵列的列总线,并且ADC 在片内工作具有极快的速率,对输出信号和外部接口干扰具有低敏感性,有利于与下一级处理器连接。CMOS图像传感器具有很强的灵活性,可以对局部像素图像进行随机访问,增加了工作灵活性。

5.成像系统要素

- 视场:能够在显示器上看到的物体上的部分。

- 景深:成像系统能够保持聚焦清晰的最近和最远的距离之差。

- 工作距离:观察物体时,镜头最后一面透镜顶点到被观察物体的距离。

- 畸变:由镜头所引起的光学误差,使得像面上各点的放大倍数不同,导致变形

- 视差:是由传统镜头引起的,在最佳聚焦点外物体上各点的变化,远心镜头可以解决此题。

- 图像传感器尺寸:图像传感器(一般是 CCD 或 CMOS )有效的工作区域,一般指的是水平尺寸。对所希望的视场来说,这个参数对决定预先放大倍数( PMAG )是很重要的。多数图像传感器的长度与宽度之比是 4:3

- 预放大倍数:是指视场与图像传感器尺寸的比值,这个过程是由镜头来完成的。

- 系统放大倍数:是指显示器上的图像与实际物体大小的比值,也就是整个系统的放大倍数。它也可以写成预放大倍数与电子放大倍数的乘积,而电子放大倍数则是显示器尺寸与图像传感器尺寸的比值。

分辨率:能够最小分辨的物体上两点间的距离,表征了对细节的辨别能力。

6.图像/视频数据量的计算

不同格式图片分辨率定义(CCD/CMOS传感器感光元件个数):

CIF: 352*288=10万像素;

DCIF: 512*384=20万像素;

D1(4CIF): 704*576=40万像素;

720P: 1280*720=100万像素;

1080P:1920*1080=200万像素;

计算机真彩像素点按RGB三色原理存储,红绿蓝每种颜色256种(2的8次方,一个字节长度),所以一个像素点需要3个字节24个比特位。现在计算容量大了,存储时再RGB基础上增加一个256种灰度,所以需要4个字节,也就是32位,这样的像素点现在也叫真彩。

比特率是指每秒传送的比特 (bit) 数。单位为 bps(bit Per second) ,比特率越高,传送的数据越大。比特率表示经过编码 ( 压缩 ) 后的音、视频数据每秒钟需要用多少个比特来表示,而比特就是二进制里面最小的单位,要么是 0 ,要么是 1 。比特率与音、视频压缩的关系,简单的说就是比特率越高,音、视频的质量就越好,但编码后的文件就越大;假如比特率越少则情况恰好相反。

码流 (DataRate) 是指视频文件在单位时间内使用的数据流量,也叫码率,是视频编码中画面质量控制中最重要的部分。同样分辨率下,视频文件的码流越大,压缩比就越小,画面质量就越高。

1、 720P单幅图像数据量 = 1280 × 720 × 24/8/1024 = 2700 KByte。

2、 活动图像的数据量

国内 PAL 活动图像是每秒传输 25 帧。 数字动态图像是由 I 帧 /B 帧 /P 帧构成。其中 I 帧是参考帧: 可以认为是一副真实的图像照片。 B 帧和 P 帧可简单理解为预测帧, 主要是图像的增量变化数据,数据量一般较小。

极限情况下, 25 帧均为 I 帧,即每帧传输的图像完全不同。则:

720P 活动图像的每秒传输的极限数据量 = 2700 KByte × 25 = 67500 KByte/s

转换成网络传输 Bit 流 = 67500 × 8 = 540000 Kbit/s(即Kbps) ,即 528M 的带宽。

在实际视频会议应用中, 由于有固定场景, 因此以传输增量数据为主 (传输以 B 帧和 P 帧为24,I帧为1) ,一般在 10%-40% 之间, 40% 为变化较多的会议场景。 假设增量数据在 20% 的情况下,计算如下:

原始数据量 = 2700 KByte × 20% × 24 + 2700 KByte =15660 KByte/s = 123 Mbit/s

3、 H.264 压缩净荷数据量

H.264 最大的优势是具有很高的数据压缩比率,在同等图像质量的条件下, H.264 的压缩比是 MPEG-2 的 2 倍以上,是 MPEG-4 的 1.5 ~ 2 倍。举个例子,原始文件为 88GB ,采用MPEG-2 压缩后 为 3.5GB , 压缩比为 25 ∶ 1 , 而采用 H.264 压缩后为 1.1GB ,从 88GB 到 1.1GB ,H.264 的压缩比达到惊人的 80 ∶ 1

视频会议中都对原始码流进行编解码压缩。采用 H.264 ,压缩比取 80 : 1 。计算如下:

在 20% 的情况下,压缩后的净荷数据量 = 123/80 = 1.6 Mbit/s

4、 采用 H.264 压缩后的传输数据量

加上网络开销,传输数据量 = 净荷数据量 * 1.3

在 20% 的情况下,压缩后的传输数据量 = 1.6 * 1.3 = 2.08 Mbit/s

5、家用监控存储量

带宽计算:

CIF 视频格式的所需带宽:512Kbps( 视频格式的比特率 ) × 50( 监控点的摄像机的总路数之和 )=25Mbps( 下行带宽 ) 即:采用 CIF 视频格式监控中心所需的网络下行带宽至少 25Mbps

D1 视频格式的所需带宽:1.5Mbps( 视频格式的比特率 ) × 50( 监控点的摄像机的总路数之和 )=75Mbps( 下行带宽 ) 即:采用 D1 视频格式监控中心所需的网络下行带宽至少 75Mbps

720P(100 万像素 ) 的视频格式的所需带宽:2Mbps( 视频格式的比特率 ) × 50( 监控点的摄像机的总路数之和 )=100Mbps( 下行带宽 ) 即:采用 720P 的视频格式监控中心所需的网络下行带宽至少 100Mbps

1080P(200 万像素 ) 的视频格式的所需带宽:4Mbps( 视频格式的比特率 ) × 50( 监控点的摄像机的总路数之和 )=200Mbps( 下行带宽 ) 即:采用 1080P 的视频格式监控中心所需的网络下行带宽至少 200Mbps

存储空间计算:

码流大小 ( 单位: KB/s ;即:比特率 ÷ 8) × 3600( 单位:秒; 1 小时的秒数 ) × 24( 单位:小时;一天的时间长 ) × 30( 保存的天数 ) × 50( 监控点要保存摄像机录像的总数 ) ÷ 0.9( 磁盘格式化的损失 10% 空间 )= 所需存储空间的大小 ( 注:存储单位换算 1TB=1024GB ; 1GB=1024MB ; 1MB=1024KB)

50 路存储 30 天的 CIF 视频格式录像信息的存储空间所需大小为:64 × 3600 × 24 × 30 × 50 ÷ 0.9=8789.1GB ≈ 9TB

50 路存储 30 天的 D1 视频格式录像信息的存储空间所需大小为:192 × 3600 × 24 × 30 × 50 ÷ 0.9=26367.2GB ≈ 26TB

50 路存储 30 天的 720P(100 万像素 ) 视频格式录像信息的存储空间所需大小为:256 × 3600 × 24 × 30 × 50 ÷ 0.9=34.33GB ≈ 35TB

50 路存储 30 天的 1080P(200 万像素 ) 视频格式录像信息的存储空间所需大小为:512 × 3600 × 24 × 30 × 50 ÷ 0.9=68.66GB ≈ 69TB

7、人眼分辨率

8、快门、曝光时间

拍的一脸糊照主要和两个原因有关,一是对焦不准,二是快门速度跟不上物体的运动速度。

说到这里,就不得不说一下快门了。快门是一种控制相机曝光时间的装置,可以理解为一个小黑屋里唯一的一扇窗,控制窗的开关,就可以决定阳光透过窗照进来的时间长短。也就是说,快门开启时间越长,进入相机的光线越多,感光片有效曝光时间越长;反之,快门开启的时间越短,进入相机的光线就越少,感光片的有效曝光时间越短。

在摄影技术发明之初,曝光时间通常需要好几分钟。所以拍照开始时由摄影师人为将镜头盖取下,过几分钟后再盖上,即完成了一次曝光拍照。但随着技术的发展,胶片的感光速度越来越快,曝光时间也越来越短,甚至短到了几百分之一秒,人为操作远远不能满足曝光需求了。所以,快门作为一种能准确控制曝光时间的装置便代替了操作镜头盖的曝光方式。

相机的快门有两道闸门,分别是:前帘(靠近镜头的闸门)、后帘(靠近传感器的闸门)。在进行拍摄时,后帘从下往上打开,此时前帘还是闭合的,所以不会有光进入。然后前帘从上往下打开,画面从上往下进行曝光。等曝光结束后,后帘就从上往下闭合,整个曝光过程结束。等到前帘闭合后,就可以进行下一次曝光了。

相机之所以有两个快门帘,就是为了能从上往下曝光,也能从上往下结束曝光。如果相机只有一个前帘,那么是从上往下开始曝光,当曝光结束就要从下往上,这就会导致上面的曝光比下面多。当你使用非常快的快门速度进行拍摄时,画面的上下部分就会出现比较明显的不一样的情况。

说回拍照,其实曝光过程就是要定格那时那刻所拍摄的画面成为照片,如果快门很快,就可以做到瞬间定格画面,呈现的画面也较清晰。但如果快门慢,曝光时间长,相机就会把运动物体——比如你家主子的运动轨迹保留在画面中,所以照片里会出现拖影。所以拍运动物体时快门一般要调到很快,而专门拍摄光轨等需要显示轨迹的图片时就要把曝光时间调得很长了。

Tips1:快门速度要快以及不要手抖

一台可以手动调节快门的相机,一般都有“1/2/、1/15、1/30、1/60、1/250……”这样的快门数值设置。这些数值需要依照不同的拍摄场景来选取,比如当你要拍摄慢跑的人或相似速度的场景时,比1/250s慢的快门都有可能造成不同程度的模糊。这仅是一个参考值,快门设置还和现场光线、焦段和相机的防抖性能差异相关。(具体可查找常见的速度快门对应表)

Tips2:避免跑焦以及不要手抖

在按下快门前,记得检查焦点是否正确聚焦在想要拍摄的对象上,半按快门对焦,然后平面移动构图并按下快门拍摄画面。但对于大部分的新手来说,移动构图的过程中常会造成焦点偏移,自然会因为脱焦而造成对焦点模糊。

当我们遇到活泼好动、不断变换位置的拍摄对象时,我们最好选择连续自动对焦模式+陷阱对焦的双重保险方式来捕捉合焦率更高的照片。连续自动对焦功能在拍摄焦平面变化不大的移动物体时,效果比较好,而拍摄不断运动的物体,往往合焦失败情况较多。因此在拍摄可预见运动轨迹的移动物体时,可使用“陷阱对焦”(即在选定位置对好焦等待主子进入“攻击范围”后,再按动快门合焦)的方式,开启连拍进行高速捕捉。

9、摄像机组成及原理

摄像头工作原理是,将光学组件获得的光信号,投射到图像传感器上,完成由光信号到电信号的转换,然后再转換为数字图像信号,最后进行信号的算法处理。摄像头主要组成部分是光学组件lens、CMOS传感器、DSP、模组组装及其他部件。

10、智能相机图像处理核心硬件

图像处理能力:FPGA<DSP<高阶CPU

ASIC是性能和功耗方面的理想选择。为给定应用开发专用SoC(片上系统),实现定制架构以适应数据流,并优化功耗。然而开发成本高,适用于消费品(即数千个单元的生产量)。由于专用性,ASIC设备的灵活性和可编程性非常低或几乎为零。

FPGA是低或中等生产量的高性能应用程序的最佳选择。FPGA非常灵活,可以满足几乎所有应用的要求。由于FPGA每个设备的可用逻辑元件(LE)数量不断增加,时钟频率不断增加,以及利用大规模并行性的可能性,能够实现接近ASIC的处理性能,具有完全可重新配置的优势。然而,FPGA的功耗相对较高,即使存在设计方法和开发环境,基于FPGA的解决方案也比基于CPU的解决方案(DSP、微控制器等)需要更多的开发时间和专业知识。

DSP设备和媒体处理器与嵌入式通用RISC处理器(PowerPC、ARM等)和微控制器有许多共同特点。所有这些设备都是基于CPU的,即基于处理器核心。因此,它们都具有极好的可编程性,使用高级语言如C/C++和专用开发环境。NRE (non-recurring engineering)成本非常低,并且具有很好的灵活性,因此适合大多数应用。

基于CPU的设备之间的主要差异出现在性能级别。微控制器可以被看作是增强的RISC处理器,通过添加CPU核心存储器(RAM、ROM、闪存)、外围设备和I/O接口(ADC、DAC等)。此外,DSP内核提供了专用的体系结构和一些特定的硬件结构,以优化算术运算的执行,如MAC(乘法-累加)和SIMD单元。最后,媒体处理器是一类专用于音频和视频处理的DSP设备,适用于处理数据流。DSP和媒体处理器可以具有VLIW(超长指令字)体系结构,例如NXP的TriMedia处理器。

11、智能相机接口和通信协议

有线接口和无线接口

例如,如果相机配备了Aptina Imaging(原Micron Imaging)的MT9M413图像传感器,能够提供高达660M pixels/s的图像,需要一个相机接口充分利用该传感器(完整配置下为5.44 Gbit/s(680 M Bytes/s))。然而如果有其他限制,保持传感器和通信接口之间数据速率兼容的规则可能会被打破。例如,对于使用电池的智能相机,即使实时视频传输250 Kbit/s的带宽使也不可能。有两种解决方法:

1、无线ZigBee协议,因为其功耗非常低。

2、减少带宽要求的另一种解决方案是图像压缩算法。然而,压缩和解压缩图像会给相机和主机带来额外的处理负担,并可能导致图片质量损失,具体取决于所需的压缩比。

并且带宽不是唯一的决定性因素。例如,GigE Vision系统的实现成本低,但最终结果可能会阻碍应用程序的响应能力和开发时间。GigE Vision还处于起步阶段,而Camera Link和IEEE 1394已经过现场验证。还必须考虑标准的完整性。USB 2.0在专有协议上运行;事实上,USB 2.0上的视频传输标准甚至不存在。GigE Vision和IEEE 1394摄像头在供应商之间兼容,并且比Camera Link更易于配置。

12、深度相机

深度相机就是能够测量物体与相机距离的相机。 根据测距原理分类:双目立体视觉深度相机、结构光深度相机、单目深度相机

- 双目立体相机原理是计算机视觉中的立体匹配。优点:适用于动态目标、不依赖主动光源及主动信号,与目标检测深度学习等方法完成目标分类;缺点:精度受成像信号强度及物体表面纹理密度影响,计算量较大,3D测量精度随距离增长而下降,对标定精度及温度振动稳定性要求高

- 结构光深度相机原理是主动投影非可见光的已知图案,通过比对参考距离理想平面反射的理想成像特征斑点位置与实际环境物体表面反射成像的特征斑点位置的差异,实现快速鲁棒的特征点匹配,达到较高的精度的视差计算结果。除了特征斑点发射与成像斑点比对之外,其他技术与双目立体相机相似,解决了双目立体相机在匹配算法复杂度,环境光照与物体表面纹理适应性的问题,并且通过不同编码的结构光可提高匹配点数。优点:精度高、适用于缺乏纹理物体;缺点:不适于室外强光环境、测距10米内、不适于吸光材料

- 单目深度相机原理是通过分析单个相机的运动轨迹形成虚拟的双目相机成像,从而得到视差值,测量静止物体的相对深度。《基于深度学习的单目深度估计》借助激光雷达,双目相机的大量真值数据进行训练结合从连续图像中结合视觉里程计提供的稀疏深度测量结果提高深度估计精度、与传统方法的约束和先验知识结合,缓解数据标注压力、对于模糊环境和罕见物体,深度学习估计效果下降、对算力的要求较高

14、ISP(image signal processing),图像信号处理芯片

在手机摄像头和车载摄像头等领域有着广泛应用,是图像信号处理的核心芯片。

ISP pipeline 流程:光线经过lens镜头,镜头校正、颜色矫正后,投射到sensor上,经过光电转换成模拟电信号,再由A/D转换成数字信号,交给ISP芯片处理。然后,得到的bayer pattern的image,再经过BLC(black level compensation,黑电平补偿)、lens shading( lens shading correction,镜头阴影矫正)、BPC(bad pixel correction,去坏点)、CIP(demosaic,去马赛克插值)、DNS(denoise,去噪)、AWB(自动白平衡)、 color correction(颜色矫正)、 gamma 矫正、色彩空间转换( RGB 转换 YUV),然后输出 YUV( 或者 RGB) 格式的数据,再通过 I/O 接口传输到 CPU 中处理。

各个模块功能简述如下:

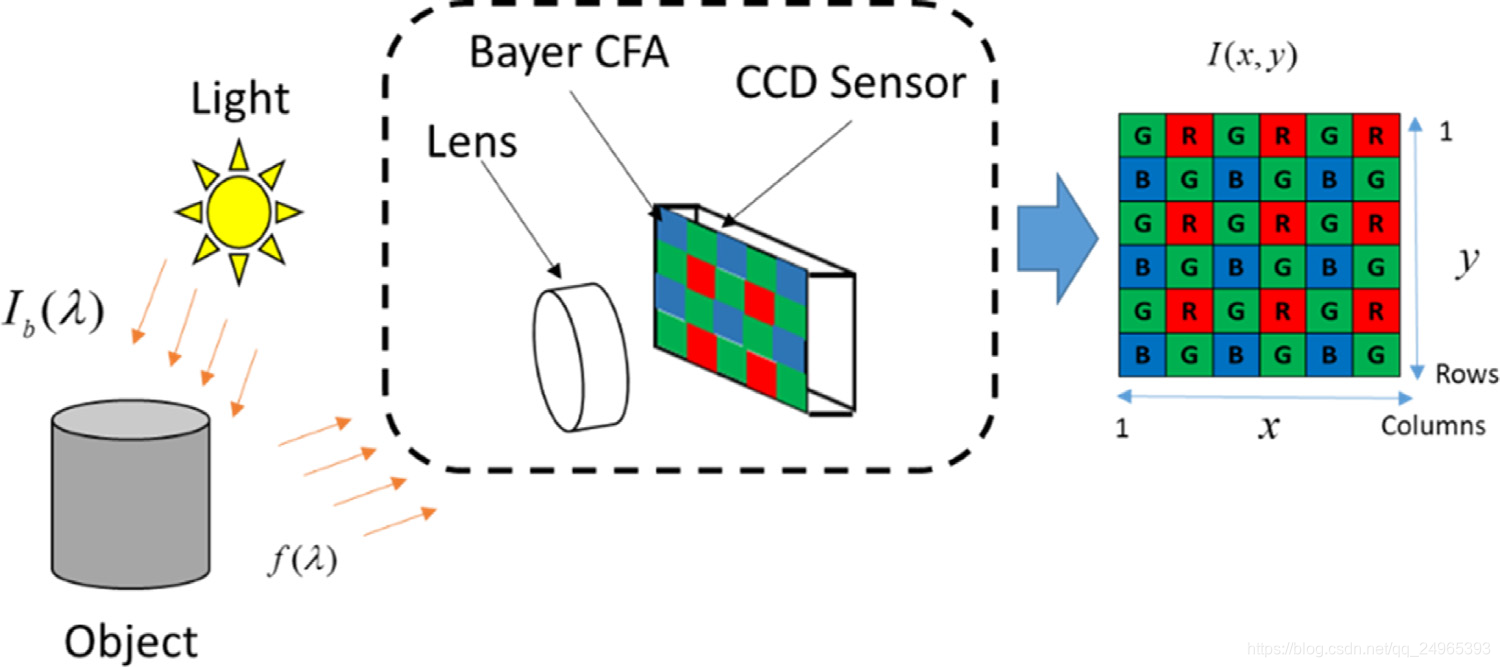

1. Bayer pattern 贝尔模板彩色滤波阵列

通常把图像传感器表面覆盖的滤波称为彩色滤波阵列(Color Filter Arrays,CFA)。目前最常用的滤镜阵列是棋盘格式的,原色贝尔模板彩色滤波阵列(Bayer Pattern CFA)RGB表示红绿蓝的滤镜阵列单元。由于人的视觉对绿色最为敏感, 所以在 Bayer CFA 中 G分量是R和B的二倍,在每个像素点上只能获取一种色彩分量的信息,然后根据该色彩分量的信息通过插值算法得到全色彩图像。

通常把图像传感器表面覆盖的滤波称为彩色滤波阵列(Color Filter Arrays,CFA)。目前最常用的滤镜阵列是棋盘格式的,原色贝尔模板彩色滤波阵列(Bayer Pattern CFA)RGB表示红绿蓝的滤镜阵列单元。由于人的视觉对绿色最为敏感, 所以在 Bayer CFA 中 G分量是R和B的二倍,在每个像素点上只能获取一种色彩分量的信息,然后根据该色彩分量的信息通过插值算法得到全色彩图像。

2. BLC(Black level Correction) 黑电平补偿

物理器件不可能是理想的, 由于杂质、 受热等其他原因的影响, 即使没有光照射到pixel,

像素单元也会产生电荷, 这些电荷产生了暗电流。 而且,暗电流与光照产生的电荷很难进行区分。Black Level 是用来定义图像数据为0对应的信号电平。减少暗电流对图像信号的影响,有效的方法是从已获得的图像信号中减去参考暗电流信号。一般在传感器中,像素区头几行作为不感光区,这部分区域也做了RGB的color filter,其平均值作为校正值用于自动黑电平校正, 然后在下面区域的像素都减去此矫正值。做了black level 矫正后图片亮度降低。

3. LSC(Lens Shading Correction) 镜头阴影矫正

由于镜头本身的物理性质, 造成图像四周亮度相对中心亮度逐渐降低,图像光照在透过镜头照射到pixel上时, 边角处的焦点夹角大于中心焦点夹角, 造成边角失光。为了补偿四周的亮度,需要进行Lens Shading的矫正。方法是根据算法计算每个像素对应的亮度矫正值, 从而补偿周边衰减的亮度。

4. BPC(Bad Pixel Correction) 去坏点

一般情况下,RGB信号应与景物亮度呈线性响应关系, 但由于Senor部分pixel不良导致输出的信号不正常, 出现坏点:全黑环境下输出图像中的白点,高亮环境下输出图像中的黑点。坏点修复方法通常有两种:一种是自动检测坏点并自动修复,另一种是建立坏点像素链表进行固定位置的坏像素点修复,这种方式是 OTP 的方式。坏点有时候是故意放进去,作为一个参考标尺。

5. DNS 去噪

使用cmos sensor获取图像,光照程度和传感器问题是生成图像中大量噪声的主要因素。同时,当信号经过ADC 时,又会引入其他一些噪声。这些噪声会使图像整体变得模糊,而且丢失很多细节,所以需要对图像进行去噪处理。空间去噪传统的方法有均值滤波、 高斯滤波等。但是, 一般的高斯滤波在进行采样时主要考虑了像素间的空间距离关系,并没有考虑像素值之间的相似程度, 因此这样得到的模糊结果通常是整张图片一团模糊。所以,一般采用非线性去噪算法,例如双边滤波器,在采样时不仅考虑像素在空间距离上的关系,同时加入了像素间的相似程度考虑,因而可以保持原始图像的大体分块, 进而保持边缘。在实际的应用中,小波去噪比较合适,而且在整个pipeline中的各个分段,都会或多或少的应用到DNS,在ISP的整个过程中特别重要,几乎存在于其各个部分。

6. 颜色插值

当光线通过 Bayer型CFA阵列之后,光线打在传感器上,分别得到了BGR数据,在这里,BGR的数据采样比为1:2:1,是因为人眼对绿色光(550nm)更为敏感,其中G也称作亮度信息,BR为色度信息。可以看出,在上面的Bayer图中,每一个pixel都只有BGR数据中的一个,所以就需要利用CIP插值来补充其他两个通道的颜色信息。才能形成一幅正常的全彩色image。

7. AWB(Automatic White Balance) 自动白平衡

自动白平衡的基本原理是在任意环境下,把白色物体还原成白色物体,也就是通过找到图像中的白块, 然后调整R/G/B 的比例。AWB 算法通常步骤如下:

- 色温统计,根据图像统计出色温;

- 计算通道增益: 计算出R和B通道的增益;

- 进行偏色的矫正: 根据给出的增益, 算出偏色图像的矫正。灰度世界法和完美反射法等都是比较常用且有效的方法。

8. Gamma Correction

人眼对外界光源的感光值与输入光强不是呈线性关系的,而是呈指数型关系的。在低照度下,人眼更容易分辨出亮度的变化,随着照度的增加,人眼不易分辨出亮度的变化。而摄像机感光与输入光强呈线性关系,为方便人眼辨识图像,需要将摄像机采集的图像进行gamma 矫正。Gamma 矫正是对输入图像灰度值进行的非线性操作,使输出图像灰度值与输入图像灰度值呈指数关系。

9. Color Correction

由于人类眼睛可见光的频谱响应度和半导体传感器频谱响应度之间存在差别,还有透镜等的影响, 得到的RGB值颜色会存在偏差,因此必须对颜色进行校正,通常的做法是通过一个3x3 的颜色变化矩阵来进行颜色矫正。

10.RGB转换YUV 色彩空间转换

YUV是一种基本色彩空间,人眼对亮度改变的敏感性远比对色彩变化大很多,因此,对于人眼而言,亮度分量Y 要比色度分量U、V重要得多。所以,可以适当地抛弃部分U、V分量,达到压缩数据的目的。

Laplacian 算子:YCbCr 其实是YUV经过缩放和偏移的改动版,Y 表示亮度,Cr、Cb表示色彩的色差,分别是红色和蓝色的分量。在YUV 家族中,YCbCr 是在计算机系统中应用最多的成员,其应用领域很广泛,JPEG、MPEG均采用此格式。 一般人们所讲的YUV 大多是指YCbCr。

色彩空间转换模块将RGB转换为YUV444,然后在YUV色彩空间上进行后续的彩色噪声去除、边缘增强等,也为后续输出转换为jpeg图片提供方便。

参考文献:

1、深入浅出安防视频监控系统 - 百度文库 https://wenku.baidu.com/view/ab297ffe910ef12d2af9e7ae.html

2、《现代光学基础-钟锡华》

3、养一只奶牛猫并不难,难的是如何给TA拍一张清楚的照片

4、人的眼睛相当于什么参数的镜头? - 知乎 https://www.zhihu.com/question/26507130/answer/33024802

5、自动驾驶中常用传感器硬件介绍_哔哩哔哩_bilibili https://www.bilibili.com/video/BV1pU4y1G7Vp

6、浙江大学视觉slam公开课-从视频标定到SLAM_哔哩哔哩_bilibili https://www.bilibili.com/video/BV1ax411R7Hd?p=1

7、《Smart Cameras》

8、【3D视觉工坊】第九期公开课:深度相机与应用_哔哩哔哩_bilibili https://www.bilibili.com/video/BV12A411Y75g/?spm_id_from=333.788.recommend_more_video.7

9、

10、