1.下载的软件清单:

ollama下载:

Download Ollama on macOS

nodejs下载:

Node.js — Download Node.js®

2.安装

安装Ollama

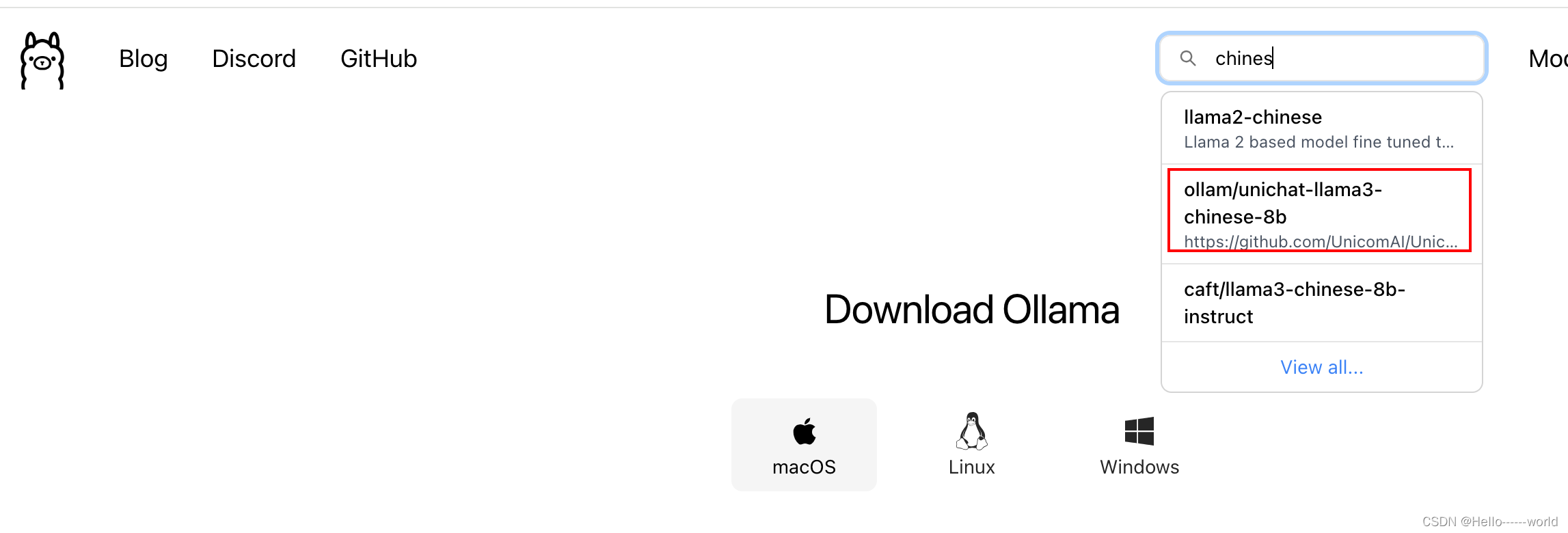

下载之后打开,直接点击Next以及Install安装ollama到命令行。安装完成后界面上会提示ollama run llama2,不需要执行这条命令,因为我们要安装llama3 的中文模型:

#这是默认的模型:

ollama run llama3

#这是中文模型:

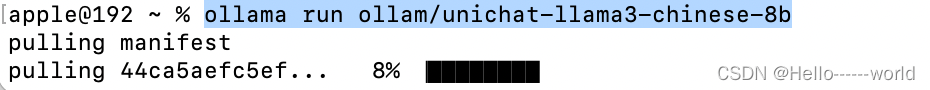

ollama run ollam/unichat-llama3-chinese-8b

等待下载完成,这时候可以去安装web页面;

安装WebUI

git clone https://github.com/ollama-webui/ollama-webui-lite.git

cd ollama-webui-lite

npm install

npm run dev

之后访问 localhost:3000

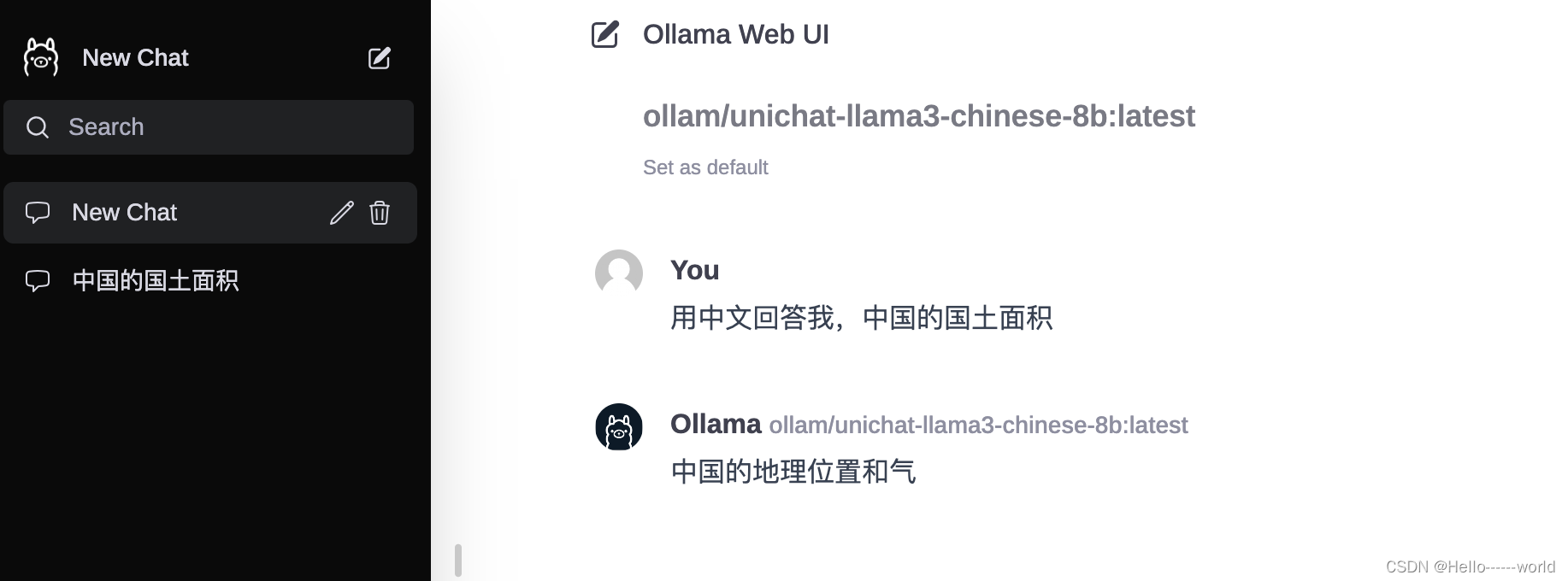

选择我们下载好的模型 即可实现本地化部署;

选择你的本地模型:

效果展示:

我的电脑跑这个模型还是很吃力的。。。时间很久

如果想下载别的模型可以在这里进行搜索