引言

本文是Poly-encoder1的阅读笔记,论文题目为基于预训练模型的快速准确多句评分模型。

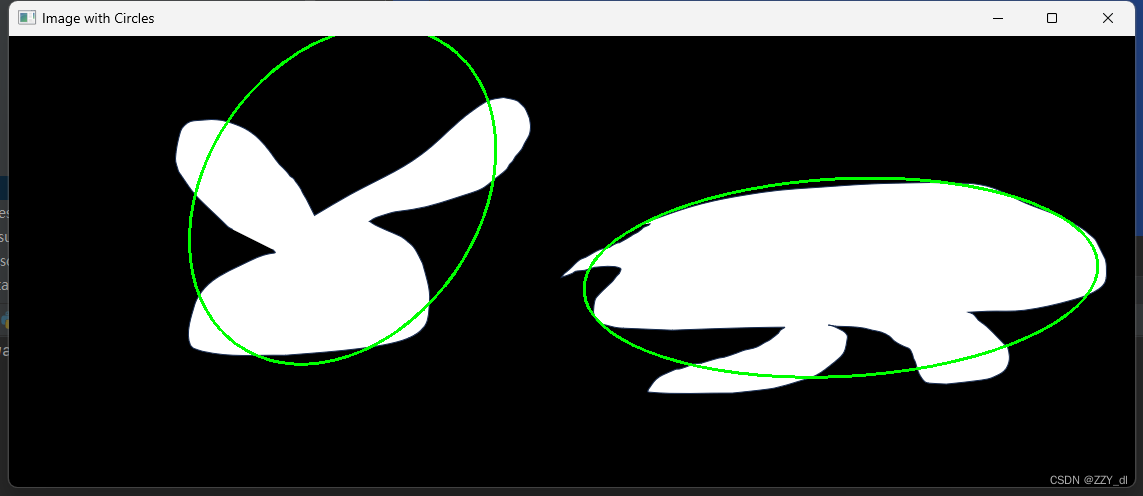

也是本系列第一篇基于Transformer架构的模型,对于进行句子对之间比较的任务,有两种常用的途经:Cross-encoder在句子对上进行交互完全自注意力;Bi-encoder单独地编码不同的句子。前者通常表现更好,但实际中太慢。

本篇工作提出了一种新的Transformer架构,Ploy-encoder,学习了全局而不是标记级自注意特征。Poly-encoder比Cross-encoder快,比Bi-encoder好。

总体介绍

对于句子对比较任务来说,有两种常用的途径:Cross-encoder和Bi-encoder。

Cross-encoder基于给定的输入句子和标签句子(组成一个句子对,将它们拼接在一起作为输入)进行交叉自注意,通常能获得较高的准确率,但速度较慢。

而Bi-encoder单独地对句子对中的句子进行自注意,分别得到句子编码。由于这种独立性,Bi-encoder可以对候选句子进行缓存,从而在推理时只需要计算输入句子的编码表示即可,大大加快推理速度。但是表现没有Cross-encoder好。

本文作者提出了一种新的Transformer结构,Poly-encoder,学习全局级而不是单词级的自注意特征。

Poly-encoder比Cross-encoder快,同时比Bi-encoder更准确。

相关工作

作者称Bi-encoder的方法为单独映射输入和候