Unlit shader

上篇中我们分析了Unlit shader的Properties在ShaderGUI中的处理,接下来看Sub Shader。

SubShader

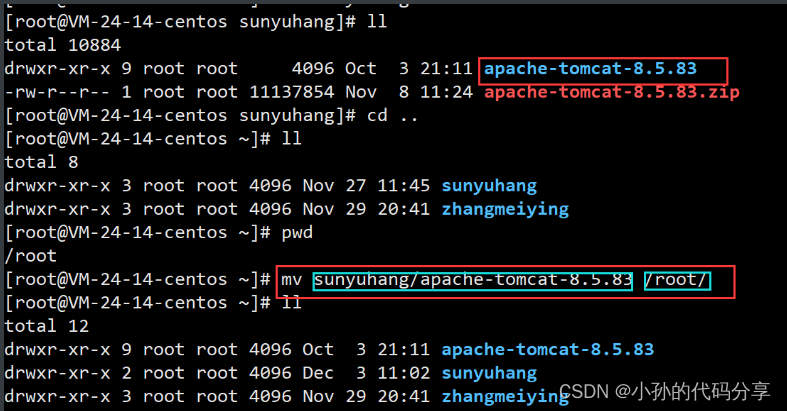

unlit shader以及其他URP shader包含两个SubShader,分别是针对ShaderModel4.5和2.0。由于unlit shader本身很简单,这两个SubShader几乎一样,唯一的差别是ShaderModel 4.5的SubShader会定义#pragma multi_compile _ DOTS_INSTANCING_ON,这个可参考dots-instancing-shaders,本文中先忽略它。总之这儿的要点是URP会针对比较强大的设备使用一个SubShader,而比较弱的设备使用另一个。但这并不是说URP只是把设备分成两类这么简单,这儿只说Shader。由于硬件总是要发展,我们关注的重点是ShaderModel4.5,因此就只看这第一个SubShader了。

Pass

我们看到unlit shader的SubShader中包含了3个Pass,分别是Unlit,DepthOnly和Meta。我们知道URP是单Pass渲染,这只是说URP是在一个Pass中完成物体的大部分计算,包含各种光照的计算等等。而Sub Shader中仍然是会包含多个pass,这些Pass是在渲染管线中特定的时候被执行。例如这儿的DepthOnlypass,是在渲染所有不透明物体之前预先生成一张depth texture的pass;而Metapass则只在烘焙光照贴图时使用。而决定这些pass被使用的并不是他们的名字,而是上面说过的LightModetag。但是Unlitpass并没有指定这个tag,所以它使用的就是默认的SRPDefaultUnlit。

unlit pass

首先分析unlit pass

- keyword定义:

#pragma shader_feature_local_fragment _ALPHATEST_ON#pragma shader_feature_local_fragment _ALPHAPREMULTIPLY_ON// -------------------------------------// Unity defined keywords#pragma multi_compile_fog#pragma multi_compile_instancing#pragma multi_compile _ DOTS_INSTANCING_ON

shader feature支持alpha test和 alpha premultiply,muti compile则包含fog, instacing和 dots instancing。这些都是一些宏定义开关,shader使用了不同的开关,会编译成不同的变体,变体才是最终使用的shader。对于shader feature是可以定义在材质上的,上面处理Properties的时候看到会根据不同情况设置不同的关键字,就是设置使用这儿的关键字,所以要首先包含这些关键字。而multi compile是指无论如何都要包含这些关键字(和材质是否开启没关系)。

- uniform定义:

uniform定义被包含在文件UnlitInput.hlsl中。这个hlsl文件定义了unlit shader使用的uniform,根据SRP的规则,使用的是CBuffer。

CBUFFER_START(UnityPerMaterial)float4 _BaseMap_ST;half4 _BaseColor;half _Cutoff;half _Surface;

CBUFFER_END

CBUFFER_START和CBUFFER_END是定义在SRP Core的Shader Library中的宏,并且根据不同的API有不同的定义,在GLES2中由于不支持constant uniform buffer,因此这两个宏被定义为空。

- Attributes 和 Varyings

这两个分别是vertex shader的输入,以及fragment shader的输入,这是URP的命名习惯,和内置流水线不一样。

struct Attributes{float4 positionOS : POSITION;float2 uv : TEXCOORD0;UNITY_VERTEX_INPUT_INSTANCE_ID};struct Varyings{float2 uv : TEXCOORD0;float fogCoord : TEXCOORD1;float4 vertex : SV_POSITION;UNITY_VERTEX_INPUT_INSTANCE_IDUNITY_VERTEX_OUTPUT_STEREO};

先忽略gpu instancing相关的宏。vs的输入只有位置和uv坐标,而fs的输入还多了一个fogCoord。

- Vertex shader

Varyings vert(Attributes input){Varyings output = (Varyings)0;UNITY_SETUP_INSTANCE_ID(input);UNITY_TRANSFER_INSTANCE_ID(input, output);UNITY_INITIALIZE_VERTEX_OUTPUT_STEREO(output);VertexPositionInputs vertexInput = GetVertexPositionInputs(input.positionOS.xyz);output.vertex = vertexInput.positionCS;output.uv = TRANSFORM_TEX(input.uv, _BaseMap);output.fogCoord = ComputeFogFactor(vertexInput.positionCS.z);return output;}

同样先忽略instacing。VS就是简单的从物体局部坐标系变换到clip space,将结果写入Varying的vertex;变换uv坐标;以及计算雾参数。

这儿要注意的是GetVertexPositionInputs方法。这个方法位于Packages\com.unity.render-pipelines.universal\ShaderLibrary\ShaderVariablesFunctions.hlsl中:

VertexPositionInputs GetVertexPositionInputs(float3 positionOS)

{VertexPositionInputs input;input.positionWS = TransformObjectToWorld(positionOS);input.positionVS = TransformWorldToView(input.positionWS);input.positionCS = TransformWorldToHClip(input.positionWS);float4 ndc = input.positionCS * 0.5f;input.positionNDC.xy = float2(ndc.x, ndc.y * _ProjectionParams.x) + ndc.w;input.positionNDC.zw = input.positionCS.zw;return input;

}

可以看到,这个方法里面计算了世界坐标,view坐标和clip space坐标,以及NDC坐标。几乎所有的URP shader都会调用这个方法。虽然说unlit shader里面只需要clip space坐标,但是为了统一就直接调用了。由于shader的函数都是内联的,不使用的变量和方法应该会被编译器优化掉(错了请告诉我),所以也不用太担心性能浪费。

关于uv坐标的变换,使用了TRANSFORM_TEX这个宏,这个宏的定义位于SRP Core的Shader Library中:

#define TRANSFORM_TEX(tex, name) ((tex.xy) * name##_ST.xy + name##_ST.zw)

就是使用_BaseMap_ST去缩放偏移了一下uv坐标。

最后,ComputeFogFactor也位于ShaderVariablesFunctions.hlsl中:

real ComputeFogFactor(float z)

{float clipZ_01 = UNITY_Z_0_FAR_FROM_CLIPSPACE(z);#if defined(FOG_LINEAR)// factor = (end-z)/(end-start) = z * (-1/(end-start)) + (end/(end-start))float fogFactor = saturate(clipZ_01 * unity_FogParams.z + unity_FogParams.w);return real(fogFactor);#elif defined(FOG_EXP) || defined(FOG_EXP2)// factor = exp(-(density*z)^2)// -density * z computed at vertexreturn real(unity_FogParams.x * clipZ_01);#elsereturn 0.0h;#endif

}

首先,real是一个宏定义,位于SRP Core的Common.hlsl中,对于支持half的平台,real就是half,否则就是float。

而UNITY_Z_0_FAR_FROM_CLIPSPACE是定义在URP的core.hlsl中的一个宏,会根据是否是reverse Z做不同的计算,关于z相关的话题是很重要也比较复杂的,将会单独写一篇,这儿就不说了。

- Fragment Shader

half4 frag(Varyings input) : SV_Target{UNITY_SETUP_INSTANCE_ID(input);UNITY_SETUP_STEREO_EYE_INDEX_POST_VERTEX(input);half2 uv = input.uv;half4 texColor = SAMPLE_TEXTURE2D(_BaseMap, sampler_BaseMap, uv);half3 color = texColor.rgb * _BaseColor.rgb;half alpha = texColor.a * _BaseColor.a;AlphaDiscard(alpha, _Cutoff);#ifdef _ALPHAPREMULTIPLY_ONcolor *= alpha;

#endifcolor = MixFog(color, input.fogCoord);return half4(color, alpha);}

SAMPLE_TEXTURE2D是一个定义在SRP Core shader library中的一个跨平台的宏,例如:

dx11是

#define SAMPLE_TEXTURE2D(textureName, samplerName, coord2) textureName.Sample(samplerName, coord2)

GLES2是

#define SAMPLE_TEXTURE2D(textureName, samplerName, coord2) tex2D(textureName, coord2)

AlphaDiscard也还是位于ShaderVariablesFunctions.hlsl中:

void AlphaDiscard(real alpha, real cutoff, real offset = 0.0h)

{

#ifdef _ALPHATEST_ON

clip(alpha - cutoff + offset);

#endif

}

很简单,根据是否定义_ALPHATEST_ON关键字,使用cutoff计算clip。

这儿还会判断关键字_ALPHAPREMULTIPLY_ON,如果定义,则会将alpha值预先乘到color上,这就是传统的Alpha预乘技术。

Depth only pass

Depth only pass用于生成场景的深度贴图。这个pass的代码在Packages\com.unity.render-pipelines.universal\Shaders\DepthOnlyPass.hlsl中。

本篇小结

本篇中我们主要分析了Unlit pass的内容,可以看到很多宏定义,函数都来自于URP和SRP Core的ShaderLibrary中。熟悉这些宏和函数方便我们写自己的自定义Shader。另外我们要注意CBuffer这个结构,后面会说一下SRP Batcher相关的内容。