2023年9月数学建模国赛期间提供ABCDE题思路加Matlab代码,专栏链接(赛前一个月恢复源码199,欢迎大家订阅):http://t.csdn.cn/Um9Zd

目录

1. 决策树原理

1.1 信息增益

1.2 增益率

1.3 基尼指数

2. 决策树剪枝

2.1 预剪枝

2.2 后剪枝

3. MATLAB实现

3.1 实现CART算法

3.2 数学建模案例

决策树是一种常用的机器学习算法,它可以用于分类和回归任务。决策树模型的优点在于其直观性和易解释性。在本文中,我们将详细介绍决策树的原理,包括如何构建决策树,如何进行特征选择,以及决策树的剪枝方法。我们还将使用MATLAB编写一个简单的决策树分类器,并通过一个数学建模案例演示其应用。

1. 决策树原理

决策树是一种基于树结构的分类和回归方法。它通过递归地分割数据空间进行预测。决策树的每个内部节点表示一个特征,每个分支表示一个特征取值,每个叶节点表示一个预测输出。

决策树构建的关键在于如何选择最佳的特征进行分割。常用的特征选择方法包括:信息增益、增益率和基尼指数等。接下来,我们将详细讨论这些方法。

1.1 信息增益

信息增益表示由于特征分割带来的熵的减小。熵是一种度量数据集不纯度的指标。给定一个数据集$D$,其熵定义为:

$$

H(D) = -\sum_{i=1}^k p_i \log_2 p_i

$$

其中$k$是类别数,$p_i$是第$i$个类别在数据集$D$中的比例。

当我们根据某个特征$A$的取值将数据集$D$划分为$v$个子集${D_1, D_2, \dots, D_v}$时,可以计算出条件熵:

$$

H(D|A) = \sum_{j=1}^v \frac{|D_j|}{|D|} H(D_j)

$$

信息增益定义为熵的减小:

$$

g(D, A) = H(D) - H(D|A)

$$

在构建决策树时,我们希望选择能使信息增益最大的特征进行分割。

1.2 增益率

虽然信息增益考虑了特征分割带来的熵的减小,但它对于取值较多的特征有所偏好。为了解决这个问题,可以使用增益率进行特征选择。增益率定义为:

$$

gr(D, A) = \frac{g(D, A)}{H_A(D)}

$$

其中$H_A(D)$表示特征$A$的熵:

$$

H_A(D) = -\sum_{j=1}^v \frac{|D_j|}{|D|} \log_2 \frac{|D_j|}{|D|}

$$

增益率考虑了特征的取值,因此可以减轻信息增益的偏好。

1.3 基尼指数

基尼指数也是一种度量数据集不纯度的指标,它表示从数据集中随机抽取两个样本,其类别不一致的概率。给定一个数据集$D$,其基尼指数定义为:

$$

Gini(D) = 1 - \sum_{i=1}^k p_i^2

$$

当我们根据某个特征$A$的取值将数据集$D$划分为$v$个子集${D_1, D_2, \dots, D_v}$时,可以计算出基尼指数的减小:

$$

\Delta Gini(D, A) = Gini(D) - \sum_{j=1}^v \frac{|D_j|}{|D|} Gini(D_j)

$$

在构建决策树时,我们希望选择能使基尼指数减小最大的特征进行分割。

2. 决策树剪枝

决策树的一个重要问题是容易过拟合。为了解决这个问题,可以对决策树进行剪枝。剪枝方法分为预剪枝和后剪枝。

2.1 预剪枝

预剪枝是在决策树构建过程中进行剪枝。具体来说,当某个节点的信息增益或基尼指数减小小于某个阈值时,停止对该节点的分割,并将其标记为叶节点。预剪枝可以有效地降低决策树的复杂度,但可能导致欠拟合。

2.2 后剪枝

后剪枝是在决策树构建完成后进行剪枝。具体来说,从决策树的叶节点开始,自底向上地计算剪枝前后的误差,若剪枝后的误差小于剪枝前的误差,则进行剪枝。后剪枝相比预剪枝更为精确,但计算复杂度较高。

3. MATLAB实现

接下来我们将使用MATLAB编写一个简单的决策树分类器。我们将使用CART算法(基于基尼指数的分类与回归树算法)构建决策树,并通过一个数学建模案例演示其应用。

3.1 实现CART算法

首先我们需要实现CART算法。在MATLAB中,我们可以使用fitctree函数构建分类决策树,使用predict函数进行预测。以下是一个简单的示例:

% 生成模拟数据

n_samples = 100;

X = [randn(n_samples, 2); randn(n_samples, 2) + 2];

y = [ones(n_samples, 1); -ones(n_samples, 1)];% 训练决策树

tree = fitctree(X, y);% 可视化决策树

view(tree, 'Mode', 'graph');% 预测新数据

X_new = [0, 0];

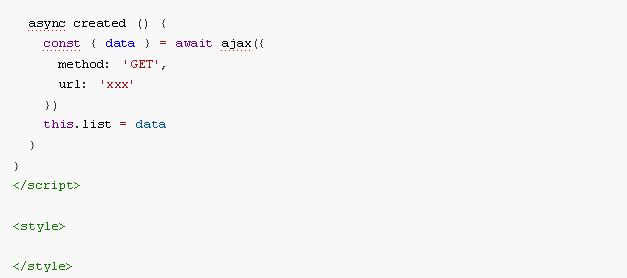

y_new = predict(tree, X_new);3.2 数学建模案例

假设我们需要对一份贷款申请数据进行风险评估,数据集包含以下特征:

- 年龄(连续特征)

- 收入(连续特征)

- 是否拥有房产(离散特征)

- 是否有车(离散特征)

目标是根据这些特征预测申请人是否会违约(1表示违约,-1表示不违约)。我们可以使用决策树进行分类。

首先,我们需要准备数据。在这个例子中,我们假设已经有一份包含1000个样本的训练数据。训练数据存储在一个1000行5列的矩阵中,前4列分别表示特征,第5列表示目标。以下是MATLAB代码:

% 加载数据

data = load('loan_data.txt');

X = data(:, 1:4);

y = data(:, 5);% 训练决策树

tree = fitctree(X, y);% 可视化决策树

view(tree, 'Mode', 'graph');