文章目录

- ModDrop++: A Dynamic Filter Network with Intra-subject Co-training for Multiple Sclerosis Lesion Segmentation with Missing Modalities

- 摘要

- 本文方法

- Dynamic Head with Filter Scaling

- Intra-subject Co-training

- 实验结果

ModDrop++: A Dynamic Filter Network with Intra-subject Co-training for Multiple Sclerosis Lesion Segmentation with Missing Modalities

摘要

多发性硬化症(MS)是一种慢性神经炎症性疾病,多模态MRI通常用于监测MS病变。已经开发了许多自动MS病变分割模型,并且已经达到了人类水平的性能。然而,大多数已建立的方法需要在假设训练期间使用的MRI模态在测试期间也可用,这在临床实践中无法保证。此前,一种称为模态丢弃(ModDrop)的训练策略已被应用于MS病变分割,以在缺失模态的情况下实现最先进的性能。

本文方法

- 提出了一种称为ModDrop++的新方法来训练一个适用于任意数量的输入MRI序列的统一网络

- ModDrop++在两个关键方面升级了ModDrop的主要思想

- 设计了一个即插即用的动态头,并采用了滤波器缩放策略来提高网络的表现力

- 设计了一种协同训练策略,以利用全模态之间的主体内关系

代码地址

本文方法

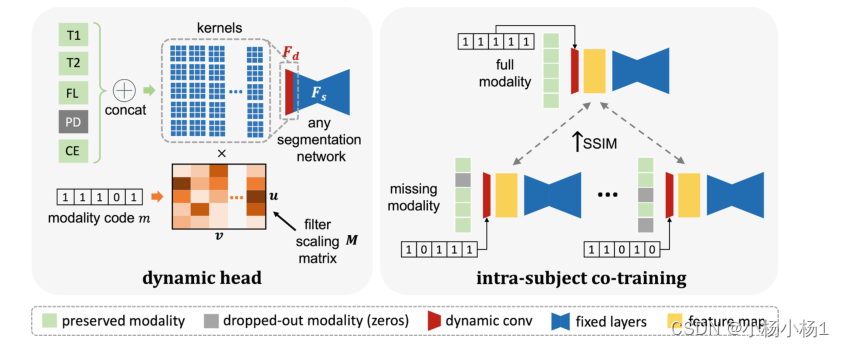

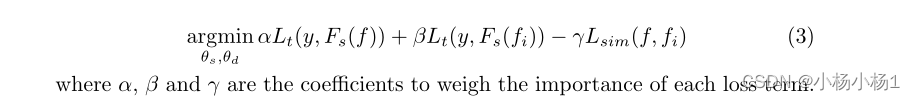

ModDrop++中的两个关键升级:即插即用动态头部(左)和主体内联合训练策略(右)。动态头旨在通过学习一组滤波器缩放矩阵来提高网络表现力,以针对每个缺失条件自适应地调整第一卷积层。受试者内部联合训练旨在在同一受试者的完整模态数据和缺失模态数据之间转移知识,即使在缺乏多个模态的情况下,也可以引导动态头部产生相似的特征表示

Dynamic Head with Filter Scaling

在ModDrop中,学习一组模型参数θ来处理所有可能的缺失条件。这可能会限制网络的表现力,并导致针对竞争缺失条件的次优性能。随着总模态数量的增加,这种情况可能会变得严重,因为K模态会导致2K−1缺失

为了提高网络的表现力,我们设计了一个动态头D,以自适应地生成以输入模态的可用性为条件的模型参数。我们使用二进制模态代码m∈RK,其中0/1表示每个模态的不存在/存在

为了减轻由人为归零信道引起的大输入变化,我们使用动态头来生成第一卷积层Fd的参数。假设输入通道和输出通道的数量为u和v,内核大小为p×q。通常,动态卷积层中的所有参数都是基于给定的先验单独生成的。在我们的场景中,要求动态头部学习从模态代码m生成总数量的uvpq+b参数(b个参数用于偏差)。然而,对于动态头部来说,这种映射可能太难学习了,而且我们的网络在初步实验中无法收敛。

为了解决这个问题,我们建议使用滤波器缩放策略更新我们的动态滤波器,该策略最初是为无监督的图像到图像转换而设计的[2]。我们的目标是,内核应该为具有不同退出模式的输入做出不同的贡献。然后,我们的动态头的任务变成学习为每个缺失条件生成滤波器缩放矩阵M∈Ru×v,其中M中的每个元素表示对应核在每个缺失条件下的贡献(缩放)。Fd中的核权重通过标量乘法用相应的比例因子更新。内核偏差以相同的方式更新。这种滤波器缩放策略将可学习参数的数量从uvpq+b减少到uv+b,这保留了我们网络的动态性质,但学习任务要简单得多。

Intra-subject Co-training

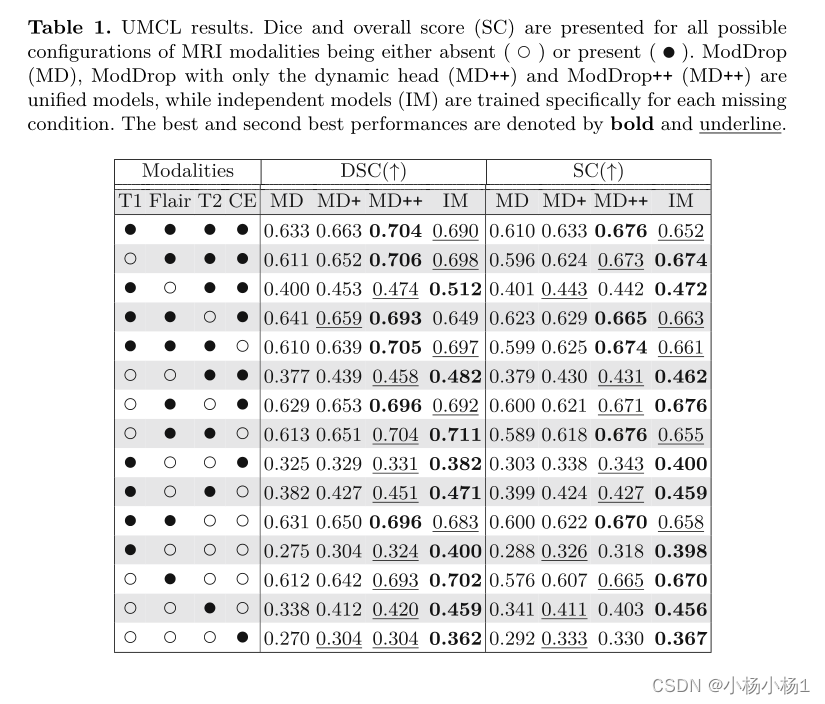

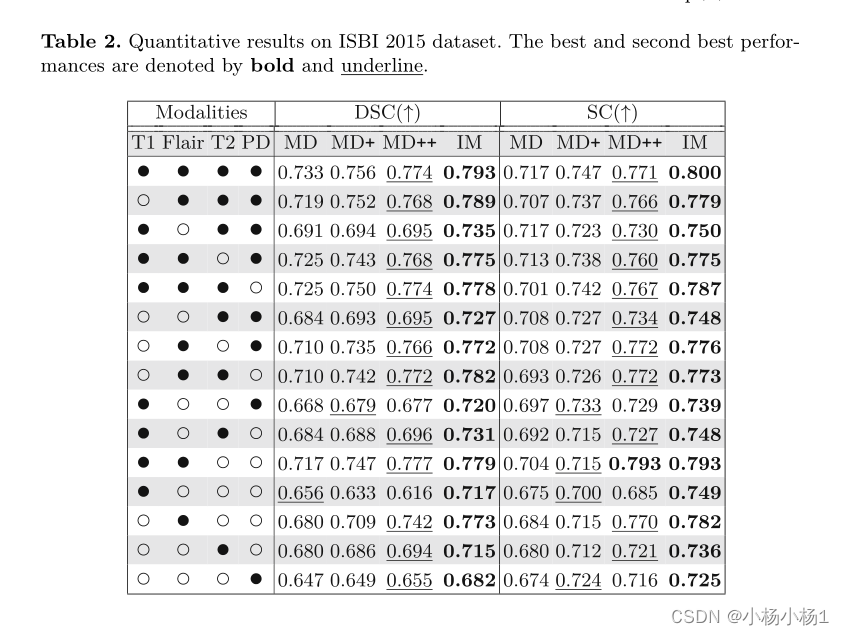

实验结果