AIGC 基础概念

- 定义与范畴

- 发展历程

- 早期基于规则生成阶段(符号主义阶段,1950s - 1970s):此阶段主要基于规则系统或符号主义构建规则引擎。通过人工定义的规则和逻辑来生成内容,例如在自然语言处理中,依据语法规则生成简单语句。但这种方式缺乏灵活性,难以应对复杂多变的现实情况。

- 机器学习引入后的发展(1980s - 1990s):机器学习方法逐渐兴起,强调数据驱动与特征工程。像线性回归、逻辑回归用于预测任务;聚类对数据进行分组;分类算法如 KNN、决策树、支持向量机(SVM)以及随机森林等,用于对数据进行分类。这些方法通过对大量数据的学习来提高性能,但在处理复杂的语义和结构信息时存在局限。

- 深度学习 / 神经网络的复兴(2010s 至今):

- 卷积神经网络(CNN):在图像和音频处理领域取得巨大成功。它通过卷积层、池化层等结构,自动提取数据中的特征,能够有效处理图像的空间结构和音频的时域特征,广泛应用于图像识别、图像生成、语音识别等任务。

- 循环神经网络(RNN):适合处理序列数据,如自然语言文本。其变体长短期记忆网络(LSTM)和门控循环单元(GRU)解决了 RNN 在处理长序列时的梯度消失和梯度爆炸问题,使得对长文本的处理能力大幅提升。

- 大模型阶段(2020s 至今):

- 预训练与生成式 AI:

- 核心技术:

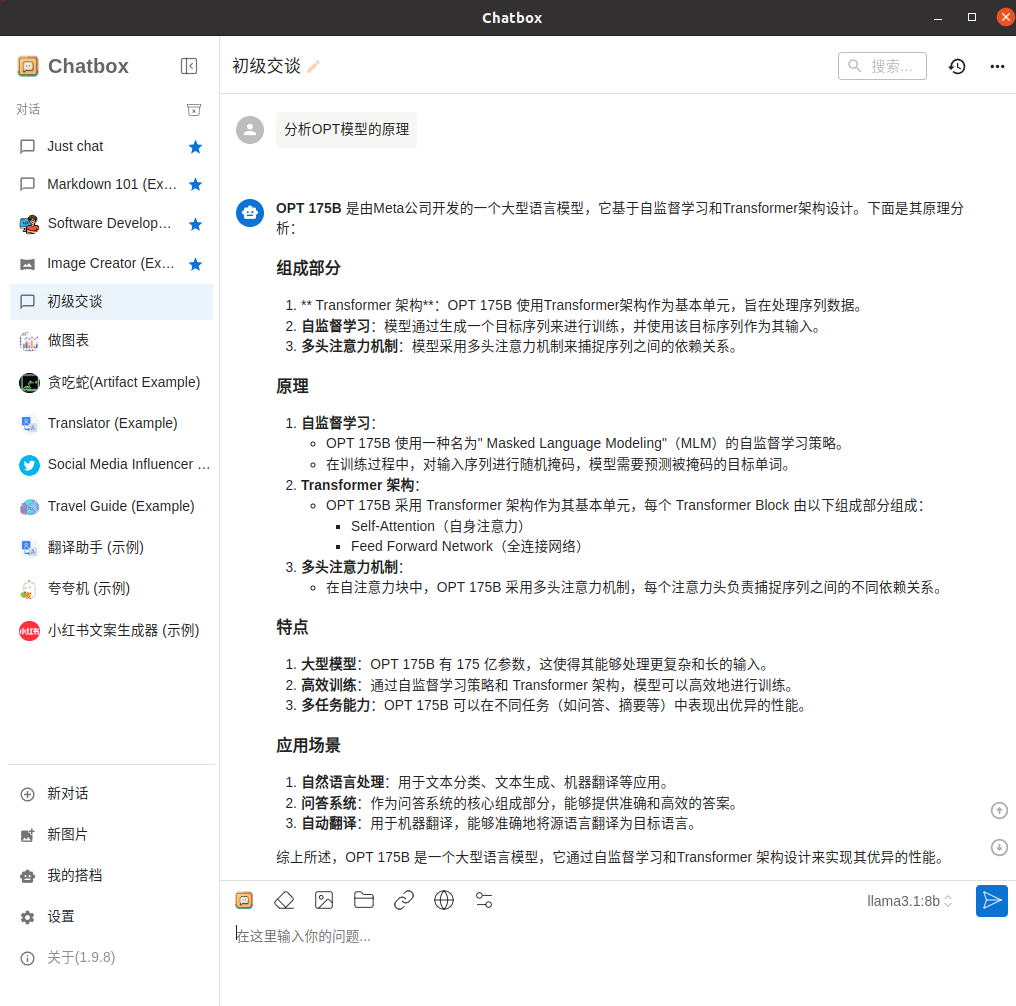

- Transformer 架构:具有数十亿甚至数千亿参数,支持多任务和多模态学习。其自注意力机制能有效捕捉序列中元素之间的长距离依赖关系,大大提高了模型处理复杂任务的能力。

- 预训练:使用海量数据对模型进行预训练,使模型学习到通用的语言或图像等知识表示。

- 微调范式:在预训练基础上,通过少量特定任务数据进行微调,赋予模型零样本或少样本学习能力,即在几乎没有或仅有少量样本的情况下完成任务。

- 分布式训练:为应对大模型巨大的计算需求,采用分布式训练技术,将模型训练任务分布到多个计算节点上并行处理。

- 大模型:如 BERT(2018 年提出)在自然语言处理任务中取得重大突破,改变了预训练语言模型的发展方向;GPT 系列模型更是推动了生成式 AI 的广泛应用,在文本生成、对话系统等方面表现出色。

- 核心技术:

- 预训练与生成式 AI:

- AIGC 与 AI 关系

- AIGC 与大模型的关系

核心技术

- 深度学习基础

- 神经网络架构:

- 前馈神经网络原理:神经元按照层次依次连接,信息从输入层向前传播到输出层,不形成回路。它是最基本的神经网络结构,常用于简单的模式识别和函数逼近任务。

- 递归 / 循环神经网络(RNN)及其变体(LSTM、GRU):RNN 能够处理序列数据,通过在时间维度上共享参数,对序列中的每个元素进行处理。LSTM 和 GRU 作为 RNN 的变体,引入门控机制,解决了 RNN 在处理长序列时难以保留长期信息的问题,在自然语言处理和时间序列分析等领域应用广泛。

- 卷积神经网络(CNN)在图像、音频处理应用:CNN 通过卷积层、池化层和全连接层组成,能够自动提取图像和音频数据中的局部特征,在图像识别、图像生成、音频分类等任务中表现优异。

- 基于 Transformer 架构的模型(BERT、GPT 系列):Transformer 架构以其自注意力机制和并行计算能力,在自然语言处理和其他序列处理任务中取得了巨大成功。BERT 侧重于双向语言理解,GPT 系列则更专注于生成任务。

- 深度学习训练方法:

- 反向传播算法:用于计算神经网络损失函数关于参数的梯度,通过链式法则将误差从输出层反向传播到输入层,从而更新参数以最小化损失函数。

- 神经网络架构: