学习>深度学习(DL)是现代人工智能(AI)的核心之一,但它并不是一夜之间出现的技术。从最初的理论提出到如今的广泛应用,学习>深度学习经历了几乎一个世纪的不断探索与发展。今天,我们一起回顾学习>深度学习的历史,看看它如何从简单的神经网络起步,一步步发展成今天改变世界的技术。

1. 神经网络的诞生:从“模仿大脑”开始

学习>深度学习的起点可以追溯到20世纪40年代。当时,沃伦·麦卡洛克(Warren S. McCulloch)和沃尔特·皮茨(Walter Pitts)通过发表论文《A logical calculus of the ideas immanent in nervous activity》,首次将数学与神经学结合,提出了一种基于神经网络的计算机模型。这一模型灵感来源于我们大脑中的神经元网络,他们尝试通过算法设定“阈值”,模拟信息如何在神经元之间传递。

紧接着,在1958年,弗兰克·罗森布拉特(Frank Rosenblatt)发表了《感知器:一种感知与识别的自动装置》一文,提出了现代神经网络的雏形——感知器。虽然感知器结构简单,但它是神经网络的最初模型,被认为是学习>深度学习的祖先。

2. 神经网络的核心:反向传播算法

神经网络的发展并没有一帆风顺。到了1960年代,虽然神经网络有了初步的构建,但仍面临很多困难。直到20世纪80年代,学习>深度学习的突破性进展才真正发生。当时,戴维·鲁梅尔哈特(David Rumelhart)、杰弗里·辛顿(Geoffrey Hinton)和罗纳德·威廉姆斯(Ronald Williams)提出了反向传播(Backpropagation)算法,这一算法成为了学习>深度学习的核心。

反向传播的基本思想是,通过不断地调整神经网络各层的“权重”来减少误差,从而提高模型的准确性。反向传播的出现使得神经网络能够通过多个层次的“学习”来不断优化,从而能够更加精准地完成任务。

在此之前,神经网络模型主要是前馈型(Feedforward),即数据只在神经网络中单向流动。但反向传播的引入,使得神经网络能够双向学习,从输入到输出的过程不再是单向的,而是能根据过去的错误不断调整,从而提高学习效果。

3. AI寒冬与反复发展的曲折历程

尽管反向传播算法带来了巨大的技术突破,但学习>深度学习的发展并非一帆风顺。从60年代到80年代,神经网络的研究经历了一个停滞期,也就是所谓的“AI寒冬”。主要的原因是缺乏足够的数据和资金支持。虽然模型的理论在不断发展,但没有足够的实践应用支持这些模型的成长,研究人员也无法获得足够的数据来训练和验证这些模型。

4. 长短期记忆网络(LSTM):突破时间序列的限制

学习>深度学习的另一个重大突破发生在1997年,赛普·霍赫赖特(Sepp Hochreiter)和尤尔根·施密德胡伯(Jürgen Schmidhuber)提出了长短期记忆网络(LSTM)。LSTM有效地解决了传统递归神经网络(RNN)无法处理长时间序列的问题。

LSTM的核心创新在于它能够处理时间序列数据中的长时间依赖关系,这对于处理如语言生成、语音识别等问题至关重要。通过LSTM,学习>深度学习模型能够记住更长时间的数据,从而提升了处理时序问题的能力。例如,LSTM能够帮助模型在自动补全句子的过程中理解时间顺序,而传统的神经网络则很难做到这一点。

5. 数据驱动与学习>深度学习的未来

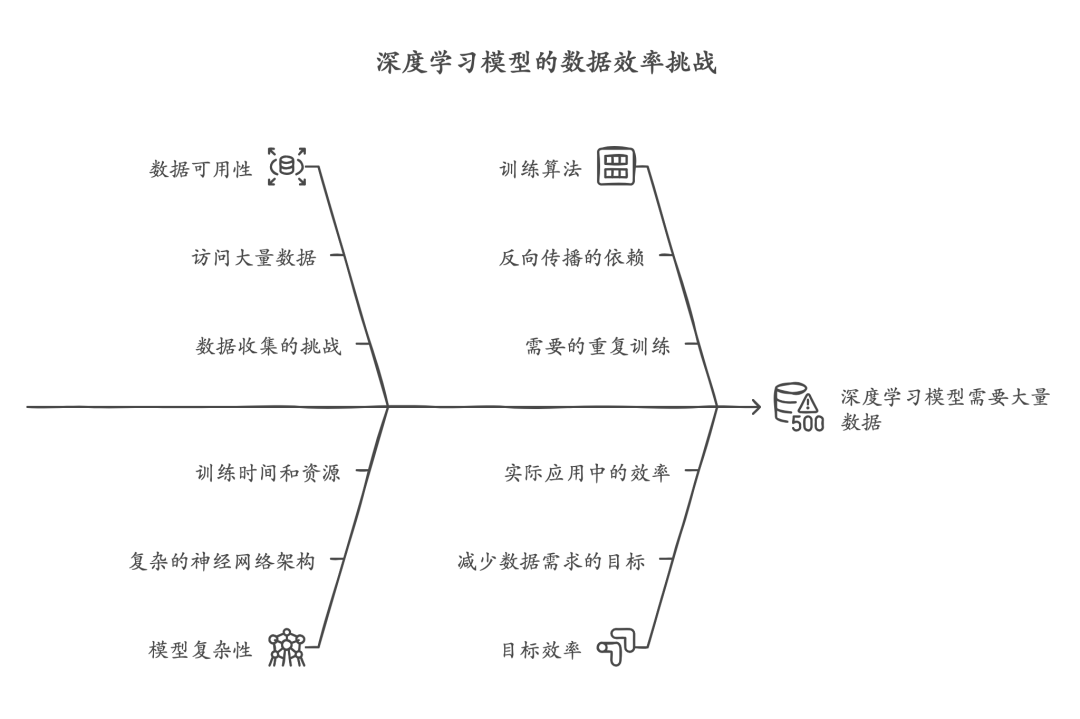

如今,学习>深度学习依赖海量的数据进行训练。神经网络需要大量的实例来区分不同的事物,例如区分狗和马。这种数据驱动的方式虽然与我们大脑的学习方式有所不同(比如小孩很少需要通过反复的提醒来区分狗和马),但随着技术的发展,学习>深度学习模型正在朝着需要更少数据的方向发展。

目前,虽然我们能够获取大量数据来训练学习>深度学习模型,但未来的目标是实现能够在较少数据下进行训练的学习>深度学习模型。这将使得学习>深度学习更加高效,也能更好地解决实际应用中的问题。

总结:学习>深度学习的辉煌历程

回顾学习>深度学习的发展历程,我们可以看到,从最初的神经网络模型到反向传播的引入,再到LSTM的突破,学习>深度学习经历了多次技术革命。如今,学习>深度学习不仅在语音识别、图像处理、自然语言处理等领域取得了巨大的成功,还在不断演化,朝着更智能、更高效的方向发展。

对初学者而言,了解学习>深度学习的历史不仅能够帮助我们更好地理解今天的技术进展,也能为未来的学习和应用打下坚实的基础。随着技术的不断进步,学习>深度学习将在更多的领域展现出巨大的潜力,未来充满了无限的可能。