困死了。。。

参考视频:56 门控循环单元(GRU)【动手学深度学习v2】

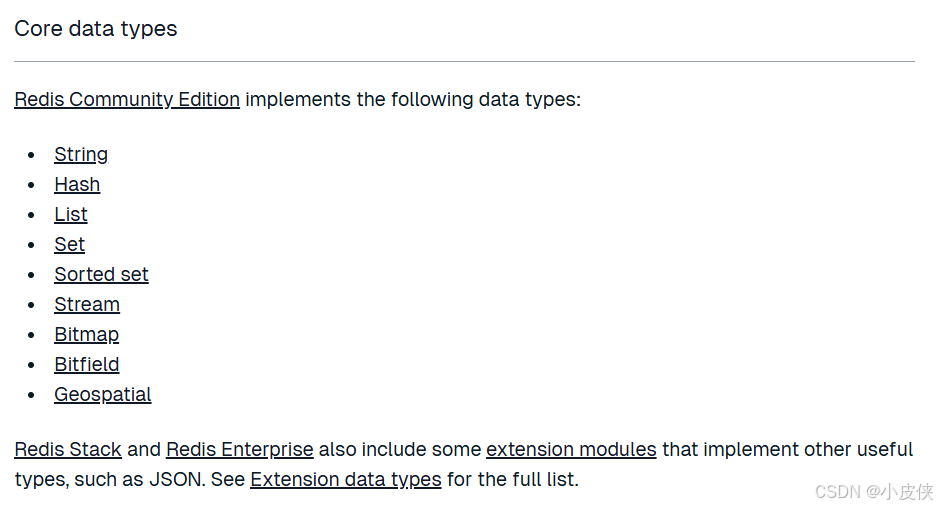

GRU:门控循环单元,与LSTM类似,解决RNN中不能长期记忆和反向传播中的梯度等问题。但结构比LSTM简单。

关注一个序列,不是每个观察值都是同等重要,想只记住相关的观察需要:

能关注的机制(更新门)

能遗忘的机制(遗忘门)

更新门与遗忘门

更新门帮助模型决定到底要将多少上一层的信息传递到现在,即前一时间步和当前时间步的信息有多少是需要继续传递的

上述公式中,更新门的操作为:

xt(当前时间步所输入向量)经过一个线性变换后与上一时间步保存的信息ht-1也经过一个线性变换后相加后再加一个常量后进入 Sigmoid 激活函数,输出的值为0-1之间。

重置门主要决定了到底有多少过去的信息需要遗忘。

上述公式中,遗忘门的操作:

与更新门类似,ht-1与xt各自进行了一个线性变换后 加上一个常量后进入Sigmoid 激活函数。

候选隐状态

简单来说,就是当前信息和对过去信息的筛选。

其中Rt与Ht-1的对应元素乘积:重置门的输出值均为0-1,代表了该信息的的相关程度,例如某个元素对应的门控值为 0,那么它就代表这个元素的信息完全被遗忘掉。

隐状态

最终记忆的计算过程中,需要使用更新门,它决定了当前记忆内容 ht和前一时间步 ht 中需要收集的信息。

Zt为更新门的激活结果,它同样以门控的形式控制了信息的流入。Zt与 ht 的对应元素乘积表示前一时间步保留到最终记忆的信息,该信息加上当前记忆保留至最终记忆的信息就等于最终门控循环单元输出的内容。