深度学习基础——循环神经网络的结构及参数更新方式

深度学习领域的一大重要分支是循环神经网络(Recurrent Neural Networks,简称RNN),它是一种用于处理序列数据的神经网络结构。与传统的前馈神经网络不同,循环神经网络能够利用序列中的时间信息,从而更好地建模序列数据的依赖关系。

1. 概述

循环神经网络是一种具有循环连接的神经网络结构,用于处理序列数据,如文本、时间序列等。其主要特点是可以将过去的信息传递到当前时间步,从而在处理序列数据时具有记忆性。

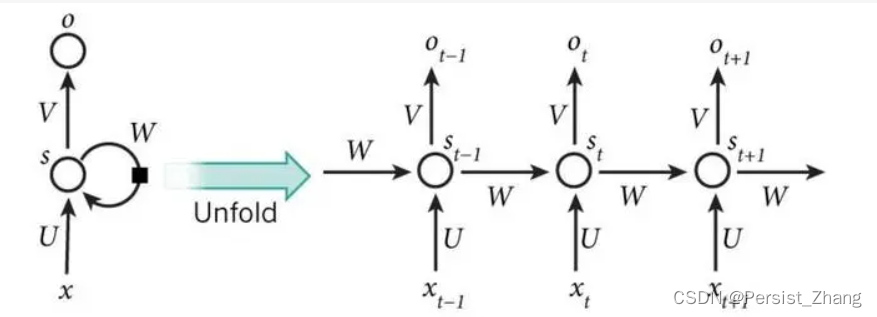

循环神经网络的基本结构如下图所示:

其中, x t x_t xt表示时间步 t t t的输入数据, h t h_t ht 表示时间步 t t t 的隐藏状态,用于存储过去的信息, y t y_t yt表示时间步 t t t的输出数据。 U U U表示输入层到隐藏层的权重矩阵, W W W表示上一时间步隐藏状态到当前时间步隐藏状态的权重矩阵, V V V表示隐藏层到输出层的权重矩阵。

2. 公式介绍及详细推导

基本结构

循环神经网络的基本结构如下所示:

h t = σ ( U x t + W h t − 1 ) h_t = \sigma(Ux_t + Wh_{t-1}) ht=σ(Uxt+Wht−1)

y t = V h t y_t = Vh_t yt=Vht

其中, σ \sigma σ表示激活函数,通常为Sigmoid、Tanh等函数。

参数更新

循环神经网络的参数更新采用反向传播算法,目标是最小化损失函数。具体来说,假设损失函数为 L L L,则参数更新的公式为:

θ t + 1 = θ t − α ∂ L ∂ θ \theta_{t+1} = \theta_t - \alpha \frac{\partial L}{\partial \theta} θt+1=θt−α∂θ∂L

其中, θ \theta θ 表示模型的参数,包括 U , W , V U, W, V U,W,V等权重矩阵, α \alpha α 表示学习率,控制参数更新的步长, ∂ L ∂ θ \frac{\partial L}{\partial \theta} ∂θ∂L表示损失函数对参数的梯度。

3. 用Python实现示例代码

下面是一个使用PyTorch实现简单循环神经网络的示例代码,并进行了参数更新和结果可视化。

import torch

import torch.nn as nn

import matplotlib.pyplot as plt# 定义循环神经网络模型

class SimpleRNN(nn.Module):def __init__(self, input_size, hidden_size, output_size):super(SimpleRNN, self).__init__()self.hidden_size = hidden_sizeself.rnn = nn.RNN(input_size, hidden_size, batch_first=True)self.fc = nn.Linear(hidden_size, output_size)def forward(self, x):out, _ = self.rnn(x)out = self.fc(out[:, -1, :])return out# 生成示例数据

input_size = 1

hidden_size = 32

output_size = 1

sequence_length = 100

x = torch.linspace(0, 10, sequence_length).reshape(-1, sequence_length, input_size)

y = torch.sin(x)# 定义模型、损失函数和优化器

model = SimpleRNN(input_size, hidden_size, output_size)

criterion = nn.MSELoss()

optimizer = torch.optim.Adam(model.parameters(), lr=0.01)# 训练模型

epochs = 1000

losses = []

for epoch in range(epochs):optimizer.zero_grad()output = model(x)loss = criterion(output, y)loss.backward()optimizer.step()losses.append(loss.item())# 可视化损失曲线

plt.plot(losses)

plt.xlabel('Epoch')

plt.ylabel('Loss')

plt.title('Training Loss Curve')

plt.show()

4. 总结

本文介绍了循环神经网络的基本结构及其参数更新方式,并通过Python示例代码进行了实现和演示。循环神经网络在处理序列数据时具有很好的效果,可以应用于文本生成、时间序列预测等任务中。深入理解循环神经网络的结构和参数更新方式对于学习和应用深度学习模型具有重要意义。