在处理大规模文本数据时,经常会遇到数据量超出系统、软件或工具处理能力上限的挑战。这不仅影响处理速度,还可能导致系统崩溃或性能严重下降。为了有效应对这一问题,本文汇总了几种实用的策略,帮助开发者和数据处理专业人员高效管理及处理超大文本数据集。

1. 分块处理:化整为零的智慧

面对大型文本文件,分而治之是一种经典策略。通过将文件分割成多个较小的部分,可以逐一处理这些“数据碎片”。依据实际需求,分块可以根据文件的行数、大小或是内在逻辑结构进行。这种方法减轻了单次处理的负担,提高了处理的灵活性和效率。

2. 流式处理:边读边算的高效模式

流式处理技术允许在不将整个文件加载到内存中的情况下,对数据进行实时或近实时处理。通过逐步读取数据并即时执行计算,该方法极大地节省了内存资源,特别适合处理持续增长或超大规模的数据流。

3. 分布式计算:并肩作战的力量

对于极端庞大的数据集,采用分布式计算框架(例如Apache Hadoop或Spark)能够实现数据处理任务的并行执行。通过网络连接的多台计算机(节点)共同工作,每台计算机负责数据的一小部分,显著提升了处理速度和能力。

4. 内存映射:智能内存管理的艺术

内存映射技术是一种高级I/O操作方式,它允许操作系统直接将文件的部分内容映射到虚拟内存中。这意味着即使文件大小超过物理内存,也能高效访问文件内容,减少了直接操作大文件时的内存瓶颈。

5. 数据库的威力:结构化存储与查询

导入文本数据至数据库管理系统(如关系型数据库MySQL、PostgreSQL或非关系型数据库MongoDB),利用数据库的索引和查询优化功能,可以高效地管理和检索大量数据,避免直接操作大文件的复杂性。

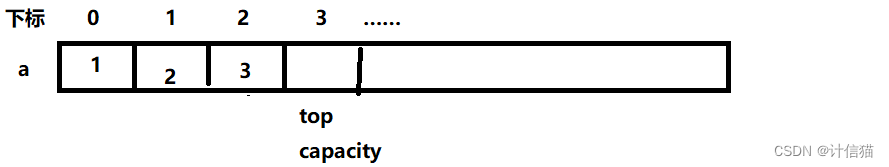

6. 算法与数据结构的优化:底层的精进

针对特定任务优化算法和数据结构,可以减少内存占用,提升处理效率。合理选择数据结构,并运用高效算法,确保每一步处理都尽可能地高效节能。

7. 云端解决方案:借力打力的智慧

利用云服务提供商(如Google BigQuery、Amazon AWS EMR)的大数据处理服务,可以轻松扩展处理能力和存储空间。这些服务专为大规模数据处理设计,提供弹性计算和存储资源,降低了本地部署的复杂性和成本。

8. 外部内存计算:突破内存限制的新途径

采用支持外部内存计算的库和工具,如Dask、Apache Arrow,能够在数据量超过系统内存时,依然保持高效的数据处理能力。这些工具通过巧妙管理内存与磁盘交互,实现了对超大数据集的有效操作。

综上所述,面对文本数据量超出处理限制的挑战,通过综合应用上述策略,我们可以克服技术障碍,实现高效、可靠的文本数据处理。选择最合适的方法,需要基于具体应用场景、数据特性及现有技术资源的全面考量。